Robots & I.A.

|

jueves, noviembre 17, 2011

|

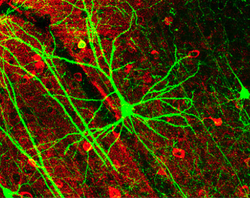

Investigadores del MIT (Instituto de Tecnología de Massachusetts) acaban de lograr uno de los grandes hitos de la Inteligencia Artificial de todos los tiempos, al poder modelar por primera vez de una forma altamente precisa, el funcionamiento de las interacciones de neuronas y sinapsis del cerebro humano, en un chip. Investigadores del MIT (Instituto de Tecnología de Massachusetts) acaban de lograr uno de los grandes hitos de la Inteligencia Artificial de todos los tiempos, al poder modelar por primera vez de una forma altamente precisa, el funcionamiento de las interacciones de neuronas y sinapsis del cerebro humano, en un chip.Para los que no sepan, las neuronas (tenemos unas 100 mil millones de ellas) son la células especializadas que junto con las sinapsis componen lo que es nuestro cerebro, y por ende, nuestra mente. Las sinapsis son las entidades que interconectan a las neuronas, y por cada neurona por lo general existen varias sinapsis conectándose a varias neuronas más. Sucede que existe toda una coreografía entre neuronas, sinapsis y efectos eléctricos, y son los patrones de toda esa actividad eléctrica lo que produce las sensaciones de pensar, memorizar, razonar, intuir, amar, odiar, desear, y de proveernos de esa extraña sensación reflexiva de un "yo" asociado a una identidad psicológica. Es por eso que es imperativo entender cómo funciona nuestro cerebro, pues al entender su funcionamiento nos estaremos entendiendo nosotros, literalmente. A la fecha, la mayoría de los intentos de imitar al cerebro se han basado en Redes Neuronales, una técnica que ha sido bastante efectiva en detectar y hasta aprender patrones, pero una se sus grandes limitantes ha sido que se basa por lo general en circuitos tradicionales digitales, en donde al final de cuentas todo se reduce a un 0 (cero) o 1 (uno), es decir, a un componente binario, pero siempre hemos sabido que nuestro cerebro es inherentemente analógico, es decir, que funciona en áreas grises de lógica en donde no todo es tan determinista. Y eso, es lo que este chip de MIT ha logrado imitar: Circuitos que no son digitales, sino que analógicos, comportándose según los primeros experimentos de una manera asombrosamente similar a la realidad. Estos son circuitos que imitan la plasticidad del cerebro de aprender y adaptarse a cosas nuevas que nunca había había sabido de antemano. El chip tiene apenas 400 componentes (a diferencia de por ejemplo los mil millones de componentes de un chip potente digital de hoy día), pero aun así, debido a su similitud con la naturaleza, un puñado de estos nuevos chips pueden ejecutar simulaciones a una velocidad en tiempo real que le tomaría a computadoras tradicionales varios días en replicar, y sin la misma precisión. Pero más asombroso, es el hecho de que este chip puede funcionar más rápido que el mismo cerebro humano, lo que indica que ya poseemos un ejemplo tangible de que el cerebro definitivamente puede ser emulado a una velocidad mayor que a la que funciona biológicamente. Este chip de incio ya está siendo útil, pues debido a su gran similitud con neuronas y sinapsis biólogas, se pudo similar un sistema que probó una teoría hasta ahora abierta sobre el funcionamiento del cerebro mismo. Así mismo, esto abrirá un nuevo capítulo en el diseño de componentes sintéticos externos que se comuniquen directamente con partes de nuestro ser biónico, así como permitirá la creación de mejores prótesis sintéticas (como retinas artificiales, hipocampos, etc), y al lado plazo, entidades sintéticas pensantes como nosotros... ¡Gracias al lector Kelvin Galvan por el enlace a la noticia! fuente autor: josé elías |

|

|

|

|

|

martes, noviembre 1, 2011

|

|

Desde hace años les he venido informando de los avances de la empresa de robótica Boston Dynamics (lo más reciente fue el video de AlphaDog), pero ahora la empresa se ha superado a sí misma de una forma alucinante con un nueva versión del robot bípedo PETMAN (del cual les hablé hace dos años).

Lo primero que me vino a la mente cuando vi el video del robot fue "Terminator" (y ya verán por qué), pues a diferencia de muchos otros robots humanoides este parece casi comportarse (desde el punto de vista de movimientos y balanceo) como un ser humano. Es importante que sepan que los cables que ven encima del robot no lo están sosteniendo, sino que están ahí por 3 motivos: (1) para proveerle de energía externa, (2) para proveerle de control externo, y (3) como medida de seguridad para sostener al robot si este se cayera u ocurriera algún mal funcionamiento. No dejen de ver el video, es asombroso. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, octubre 27, 2011

|

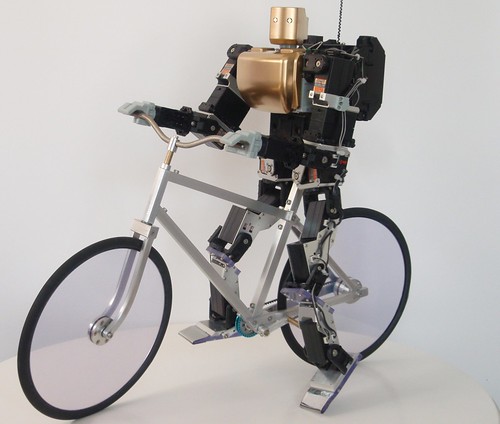

Hoy los dejo con este curioso video de un robot llamado PRIMER-V2, que tiene la particularidad de saber montar bicicleta. Hoy los dejo con este curioso video de un robot llamado PRIMER-V2, que tiene la particularidad de saber montar bicicleta.Aunque el robot es manejado a control remoto, los únicos comandos que se le envían son los de pedalear y doblar, pero más allá de eso, es el mismo robot el que mantiene el balance por su cuenta, y el que literalmente da pedales a la bicicleta. PRIMER-V2 es capaz de pedalear a hasta 10Kph (6.2Mph). Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, octubre 23, 2011

|

|

Hoy los dejo con una dosis de BREVES que incluye tanto noticias recientes como otras que dejé pasar en las últimas semanas sin ponerlas en eliax por falta de tiempo. Así que aquí vamos...

1. SSD de 2.5" y 1TB  La empresa OCZ ha sacado una nueva linea de dispositivos de almacenamiento en estado sólido (SSD) bajo el nombre Octane con capacidad de 1TB y en el formato de 2.5" (lo que significa que cabe en cualquier laptop). Este SSD soporta leer datos a 560 MB/s (560 MegaBytes por segundo, o 4480 Mbps), y escritura a 400 MB/s (3200 Mbps), a un precio de US$1100 dólares. nota de prensa oficial La empresa OCZ ha sacado una nueva linea de dispositivos de almacenamiento en estado sólido (SSD) bajo el nombre Octane con capacidad de 1TB y en el formato de 2.5" (lo que significa que cabe en cualquier laptop). Este SSD soporta leer datos a 560 MB/s (560 MegaBytes por segundo, o 4480 Mbps), y escritura a 400 MB/s (3200 Mbps), a un precio de US$1100 dólares. nota de prensa oficial2. Vacuna contra VIH posiblemente 90% efectiva, pero...  El mes pasado (y en una noticia que recibió mucha cobertura mundial) científicos españoles del Consejo Superior de Investigaciones Científicas (CSIC) anunciaron el desarrollo de una vacuna que resultó tener un 90% de efectividad cuando se le suministró a 30 pacientes. Sin embargo, aunque esta es una noticia espectacular de ser cierto, algunos han anunciado que seamos precavidos optimistas ya que todavía no se han hecho estudios a largo plazo. Es decir, ¿por cuánto tiempo duran los efectos de la vacuna? Mientras tanto, esa vacuna (llamada "MVA-B") aparenta ser a corto plazo nuestra más poderosa arma contra el virus causante del SIDA. El mes pasado (y en una noticia que recibió mucha cobertura mundial) científicos españoles del Consejo Superior de Investigaciones Científicas (CSIC) anunciaron el desarrollo de una vacuna que resultó tener un 90% de efectividad cuando se le suministró a 30 pacientes. Sin embargo, aunque esta es una noticia espectacular de ser cierto, algunos han anunciado que seamos precavidos optimistas ya que todavía no se han hecho estudios a largo plazo. Es decir, ¿por cuánto tiempo duran los efectos de la vacuna? Mientras tanto, esa vacuna (llamada "MVA-B") aparenta ser a corto plazo nuestra más poderosa arma contra el virus causante del SIDA.3. IBM Watson a luchar contra el Cáncer 4. Música de Star Wars con discos Floppy de 3.5" ¿Recuerdan los discos floppy de antaño? Hacían tanto ruido que despertaban personas si se colocaban cerca de la cama, y he aquí un hack en donde alguien tomó ventaja de las distintas notas musicales que hacían los discos para reproducir la banda sonora de Star Wars (La Guerra de las Galaxias), específicamente La Marcha Imperial (la música temática del villano Darth Vader). Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, octubre 11, 2011

|

El fin de semana pasado tuve el gran placer de ver Real Steel ("Gigantes de Acero"), una película que desde que supe de ella hace alrededor de un año no me llamó la atención, ya que la trama ("robots boxeadores") sencillamente no sonaba como algo que Hollywood fuera a hacer bien (y en particular dado el gran desastre que fue Transformers 3). El fin de semana pasado tuve el gran placer de ver Real Steel ("Gigantes de Acero"), una película que desde que supe de ella hace alrededor de un año no me llamó la atención, ya que la trama ("robots boxeadores") sencillamente no sonaba como algo que Hollywood fuera a hacer bien (y en particular dado el gran desastre que fue Transformers 3).Sin embargo los últimos avances en meses recientes se vieron buenos y decidí ir a verla, y tengo para decirles que esta película fue una verdadera sorpresa. La película ocurre en el 2020, en una época en donde peleas de boxeo ocurren con robots, en vez de humanos, y nuestro protagonista, el actor Hugh Jackman, vive del negocio de estas peleas. Pronto vemos como él y su hijo, el actor Dakota Goyo (a quien básicamente abandonó de niño) se unen en lo que será una saga similar a la película Rocky (de donde se puede reconocer mucha inspiración por todas partes). La película gozó de una guión bastante original, muy bien pulido, y de una dirección excelentísima y sobre todo, de excelentes actuaciones. La actuación del niño Dakota Goyo (quien vimos recientemente en el papel de Thor cuando era niño) fue tan extraordinaria, que no me sorprendería verle una nominación al Oscar. Sin duda alguna este joven será una de las grandes estrellas del cine en los próximos años. La ambientación de la película fue bastante buena, en particular ya que el 2020 está a apenas 8 años en el futuro, por lo que los realizadores no exageraron con cosas futuristas, y al contrario, proveyeron un ambiente más humano y mucho menos "robotizado" del que quizás muchos esperaban al ver la película. Y hablando de humanidad, esta película tiene y fue hecha con mucho corazón, incluso me recordó la excelente película anima "The Iron Giant" del genial Brad Bird (detrás de clásicos animados de PIXAR como Ratatouille y Los Increíbles). Acá los robots son utilizados como parte de la historia, y no de forma innecesaria en varias escenas como vimos con la última entrega de Transformers. Esta en mi opinión es una de las mejores películas de robots jamás filmadas, una que será amada por los amantes del boxeo, adorada por los amantes de la ciencia ficción, y apreciada por los amantes del buen drama. Es sin duda una de las películas que más he disfrutado este año. Le doy 9.3 de 10 Avance de la película continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, octubre 7, 2011

|

Hola amig@s, Hola amig@s,Quiero brevemente dar las gracias a todos los asistentes de mi charla de ayer en UTESA Puerto Plata sobre el tema de la Singularidad Tecnológica y su Futuro Impacto en la Sociedad. De verdad que me hicieron sentir bien con toda la energía demostrada en un auditorio totalmente lleno, y dado los comentarios durante la conferencia se hizo obvio que disfrutaron la charla tanto como yo. Una vez más, las gracias a Minerva Hernández por ser la primera en hacer las gestiones para mi asistencia a ese recinto, a Humberto Mercado por sacar parte de su valioso tiempo para ayudar con todo el asunto logístico, y a Victor Hernández de UTESA por aceptar la charla inmediatamente se le propuso y convertirse en un promotor entusiasta de esta. A los fans del blog y otros asistentes que se quedaron hasta bien pasado el evento, gracias por sus buenas impresiones, sus preguntas, su amabilidad y su amistad. Estoy seguro que quedaré en contacto personal con más de uno de ustedes. Actualización: Adjunto a continuación un video grabado por Abiezer Juma (¡gracias Abiezer!) justo después de la charla, en donde Juan José Ortiz demostró un robot fabricado con cartón, jeringas y mangueras de suero. Yo soy el asombrado vestido de chaqueta negra y camisa blanca, detrás del robot mientras Juan José lo operaba. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, octubre 5, 2011

|

Hace horas fue el esperado lanzamiento del "iPhone 5" (eventualmente fue el "iPhone 4S"), lo que de paso fue la primera presentación de Tim Cook, el reemplazado del legendario Steve Jobs de Apple, y si algo puedo predecir desde ahora es que de seguro muchas personas quedaron decepcionadas por los anuncios de hoy, pero creo que aquí hay mucho más de lo que muchos ven sobre la superficie... Hace horas fue el esperado lanzamiento del "iPhone 5" (eventualmente fue el "iPhone 4S"), lo que de paso fue la primera presentación de Tim Cook, el reemplazado del legendario Steve Jobs de Apple, y si algo puedo predecir desde ahora es que de seguro muchas personas quedaron decepcionadas por los anuncios de hoy, pero creo que aquí hay mucho más de lo que muchos ven sobre la superficie...Como dicen, síganme la corriente, despejemos un poco el humo, dejemos a un lado un poco las emociones, y veamos esto de forma racional. Lo primero que debo mencionar es que sea lo que sea que Apple mostrara hoy, iba a desilusionar a la gran mayoría de persona debido a las altas (y falsas) expectativas creadas por los medios (¿alguien vio el video ese en YouTube en donde el iPhone 5 desplegaba hologramas en 3D y proyectaba un teclado virtual en tu escritorio?). Lo segundo es, que muchos quedaron decepcionados porque no vieron "el iPhone 5", cosa que me encontré curiosa ya que como veremos en breve el iPhone 4S lo único que no tiene de "5" es el nombre, ya que en todos los sentidos es bastante superior no solo al iPhone 4, sino que posiblemente a todo otro celular en el mercado (y antes de que empiecen en los comentarios a hablar del Samsung Galaxy II u otros celulares similares, recomiendo sigan leyendo y después comenten). El problema es que la mayoría de las personas (y en particular los usuarios técnicos) solo leen especificaciones técnicas (aquí tienen las del iPhone 4S) y se olvida de "la experiencia del usuario". Un rápido ejemplo: El iPad. Existen decenas de tablets en el mercado, algunas con especificaciones técnicas igual o superiores al iPad 2, pero en el momento de uno darles uso se da cuenta de algo: no pueden hacer lo mismo con ellas que con el iPad, o sencillamente las cosas "no se sienten bien", o hay que dar todo tipo de maniobras para hacer cosas sencillas que ya vienen integradas en el iPad. Similarmente, quien compare (como ya lo han hecho literalmente cientos de fanboys en Internet hoy) al iPhone 4S con algo como el Samsung Galaxy II, no tiene ni la menor idea de lo que Apple anunció hoy. Y noten que esto fue exactamente lo que ocurrió con el iPad: Casi de forma unánime (salvo en este blog y unos muy pocos que se contaban con la mano) todo el mundo calificó al iPad como "un iPod gigante", sin ver más allá de sus narices e imaginarse el dispositivo en el uso cotidiano. Y hoy, quiero expresar que algo similar ha sucedido con el iPhone 4S, y veamos por qué. Para empezar (y para satisfacer las ansias de los fanáticos de especificaciones técnicas), este modelo es 100% más rápido que el iPhone 4 (es decir, el doble de rápido) en computación cruda, y además es 7 (siete) veces más rápido en gráficos que el mismo iPhone 4 (el cual, a propósito, ya tenía un chip gráfico bastante poderoso). Esto hace ahora mismo al iPhone 4S quizás el celular más potente del mercado en términos "crudos", y notemos que a diferencia de otras plataformas iOS toma ventaja de su integración íntima con el hardware para acelerar todo el sistema, combinando el CPU (procesador principal) y el GPU (chip de gráficos), los cuales a propósito están integrados en el mismo chip de doble núcleos para darle aun más poder.  Similarmente, muchos hablan hoy de que "ya existen otros celulares en el mercado desde hace meses con cámaras de 8 megapixeles como la del iPhone 4S", pero una vez más, se olvidan que la cámara del iPhone 4S para empezar inicia casi instantáneamente (en 1 segundo desde el celular apagado, y listo para la próxima foto en medio segundo) y está disponible sin siquiera entrar a la pantalla del celular, lo que aumenta su versatilidad (y a propósito, para el que no sepa, según el portal de fotografías más grande del mundo, Flickr, el iPhone es la cámara digital más popular del planeta - y no duden que parte de esa popularidad se debe a su fácil uso y acceso). Similarmente, muchos hablan hoy de que "ya existen otros celulares en el mercado desde hace meses con cámaras de 8 megapixeles como la del iPhone 4S", pero una vez más, se olvidan que la cámara del iPhone 4S para empezar inicia casi instantáneamente (en 1 segundo desde el celular apagado, y listo para la próxima foto en medio segundo) y está disponible sin siquiera entrar a la pantalla del celular, lo que aumenta su versatilidad (y a propósito, para el que no sepa, según el portal de fotografías más grande del mundo, Flickr, el iPhone es la cámara digital más popular del planeta - y no duden que parte de esa popularidad se debe a su fácil uso y acceso).Pero como si fuera poco, este sensor de 8MP no aparenta ser el sensor común de 8MP en otras cámaras, sino uno diseñado para funcionar bajo condiciones de luz pobre, y de paso Apple agregó un complejo sistema de 5 lentes (en vez de 1 o 2) con apertura de f2.4 que sin duda ofrecerá imágenes que se podrán comparar con algunas de las mejores cámaras digitales dedicadas del mercado (que posiblemente cuesten el mismo precio que el mismo iPhone 4S). Como suspiro al pastel Apple incluyó además video en calidad 1080p, pero una vez más, con algo inesperado: reducción de ruido temporal (es decir, entre cuadro y cuadro), algo que por lo general solo se ve en cámaras de televisión que cuestan decenas de miles de dólares, y que ahora nos llega a consumidores gracias al poder del procesador A5 de Apple. Noten que el poder del chip A5 de Apple se utiliza además en otros aspectos: El iPhone 4S puede detectar y dar seguimiento a hasta 10 caras simultáneas en una foto, para balancear la luz (exposición) dinámicamente para que todos salgan bien. Continuando con el hardware (espero que los que disfruten de numeritos y especificaciones se estén deleitando hasta ahora), el iPhone 4S además incluye un doble sistema de antenas que le permitirá mantener una calidad de señal superior a la mayoría de los celulares del mercado (aunque en este sentido, ver para creer cuando lo tenga en mis manos). Este nuevo sub-sistema de telecomunicaciones en el iPhone 4S de paso ofrece Internet a 14.4Mbps (en redes que soporten la tecnología HSPA+), lo que es comparable (y en muchos casos superior) a las redes "4G" que vemos naciendo en todos lados. Sin embargo, esos son solo "datos crudos", que cuando menos espero hayan transmitido el hecho de que vea como se vea, este es un super-potente dispositivo. Es básicamente tan poderoso como un iPad 2, pero 6 veces más pequeño (y asombrosamente, con una batería que ahora dura 8 horas de habla continua en redes 3G, y 14 horas en redes 2G, o 10 horas de video o 40 horas de música contínua). En resumen (hasta ahora): El iPhone 4S es un super-potente celular, con quizás la mejor cámara del mercado en la industria de celulares. Pero, eso es tan solo el inicio... Entra en escena Siri (anteriormente referido como "Assistant" en los medios y rutas de rumores en Internet).  Siri en realidad no es un desarrollo de Apple, sino que es una tecnología que Apple adquirió hace un tiempo atrás. En el momento que Apple adquirió la empresa, Siri era considerado el sistema más avanzado del mundo de su tipo, muy por encima de tecnologías de empresas como Nuance y productos como la serie Dragon, e incluso por cualquier cosa hecha por Google. Y hoy creo vimos por qué. A diferencia de otros sistema que responden a comandos pre-configurados, Siri entiende el lenguaje natural de los humanos gracias a sus algoritmos de Inteligencia Artificial. Según Apple, a diferencia de otros sistemas estáticos, Siri literalmente aprende más y se comporta mejor mientras más uso le des. En otras palabras, el asistente digital Siri de tu iPhone 4S se comportará ligeramente diferente al de otra persona. En esencia Siri será una extensión de ti mismo. Y para ver a lo que me refiero, y hacia donde va esto, recomiendo fuertemente que lean esta Reflexión que escribí hace dos años acá mismo en eliax: "Reflexiones 15: Un asistente personal artificial...". Como ejemplo, a Siri le puedes hacer preguntas y dar comandos como los siguientes (varias de estos demostradas por Apple en vivo y en videos): "Léeme el mensaje que acabo de recibir" "¿Cómo está el tráfico en mi ruta a casa?" "¿Crees que necesitaré un paraguas hoy?" "¿Cuántas onzas hay en 4.5 libras?" "El 10 de Diciembre recuérdame que es el cumpleaños de mi papá" "Agéndame una reunión con Leonardo el próximo martes a las 10am" "Recuérdame recoger mi ropa cuando salga del trabajo" "Recuérdame comprar leche cuando llegue al supermercado" "¿Hay algunos buenos restaurantes en el área?" "Dime si mi esposa llegará tarde a nuestra cita" "Llámame un Taxi" "Despiértame el lunes a las 5 de la mañana" "Infórmale a Paola que llegaré tarde" "¿Dónde está mi hijo?" Ahora, algunos dirán que esos ejemplos son imposibles, ya que ¿cómo sabría Siri por ejemplo en dónde está mi casa, o qué supermercado me refiero, o quien es mi esposa, o dónde está mi trabajo, o a cuál Taxi llamar, o incluso a cuál Paola informar y por qué? Y la respuesta es que es ahí en donde yace el poder de Siri: Con Inteligencia Artificial y deducción de patrones, más el uso del GPS del iPhone 4S (para determinar tus coordenadas actuales), y analizando el patrón de cosas que has hecho anteriormente, Siri puede deducir lo que quieres decir. Y si no puede deducirlo, te pregunta. Así que por ejemplo, la primera vez que le diga a Siri "Recuérdame comprar flores para mi esposa cuando salga del trabajo mañana" Siri posiblemente te pregunte "¿Cuál entre tus contactos es tu esposa?". Así mismo sabría de antemano por una pregunta que quizás te hizo hace un mes atrás en donde geográficamente está tu trabajo, y si te sales del radio del trabajo (digamos 300 metros o 2 kilómetros) este te alertará de comprar las flores. Noten que incluso la pregunta "¿Dónde está mi hijo?" te la puede responder, ya que ahora hay una nueva funcionalidad en el iOS 5 del iPhone 4S llamada "Find my Friends" ("Encuentra a mis amigos") que con el permiso de ellos puedes saber su localización geográfica, en un mapa. Así que por ejemplo si tienes amigos que vienen a tu casa por primera vez, puedes utilizar esta funcionalidad (ellos te pueden dar permiso para ver su localización por períodos determinados de su elección) para ver en un mapa por donde vienen y tú poder decirles en qué esquina doblar (y todo esto sin que tus amigos siquiera sepan utilizar un mapa o el sistema GPS). Pero la inteligencia de Siri va más allá. Después de la pregunta "¿Hay algunos buenos restaurantes en el área?" es posible que Siri te ofrezca algunas opciones, pero justo después que te de esas opciones tu simplemente puedes decir algo como "¿y qué tal pasta?", en cuyo caso Siri recordaría que la pregunta anterior trataba sobre restaurantes, y por tanto que ahora estás hablando de restaurantes italianos, y te devolverá resultados acorde. Es decir, Siri entiende el contexto de lo que hablas. Como una extra adicional, ahora todas las aplicaciones en el iPhone 4S que utilicen teclado obtendrán automáticamente un nuevo botón con un micrófono para Siri, lo que permitirá que dictes/hables en vez de escribir, lo que será una super utilidad para aquellos que estén manejando un auto, o dictando una novela, o simplemente escribiendo notas para la posteridad. Como ven, por más especificaciones técnicas que le busquen a algo como un Samsung Galaxy II hoy día, esto va muchísimo más allá que simple hardware, es el software lo que importa en gran medida. Pero como si fuera poco, cuando juntamos esto con los servicios de iCloud disponibles el día 12 de este mes con la actualización del sistema operativo iOS 5 (disponible para iPhone 3GS y iPhone 4, iPad, iPad 2, y las dos últimas generaciones del iPod Touch), que vale la pena decir será gratuito, el poder de todo esto aumenta aun más. Por ejemplo, ahora las aplicaciones que utilices en el iPhone, iPad o Macs (con OS X Lion) se sincronizarán automágicamente unas con otras. Así que por ejemplo puedes iniciar una conversación con el iMessage (un programa que básicamente clona la misma funcionalidad del BBM de los Blackberry, pero en dispositivos Apple) en un iPhone, y después continuar en tu iPad en casa la misma conversación. O puedes iniciar a crear una presentación de Keynote (el equivalente a Powerpoint por Apple) en tu Mac, y después cuando vayas a tu iPad encontrarás que mágicamente tendrás la presentación allá también, y si la modificas en tu iPad o iPhone y regresas a la Mac verás las modificaciones, lo que significa no más tener que hacer respaldos o preocuparse uno de tener la misma versión en distintos dispositivos o máquinas. De paso, Apple ahora hará respaldos diarios de los datos en nuestros iPhones, iPads y iPod Touches (no se si aplica a Macs aun), de modo que si por ejemplo pierdes o te roban tu iPhone, ahora simplemente obtienes uno nuevo, digitas tu usuario y clave, y todo vuelve exactamente como lo dejaste (desde aplicaciones con los documentos que estaba editando, hasta tus contactos y agenda). Noten que esto es algo que Google ya ofrece con Android, pero no con este nivel de sofisticación e integración entre múltiples dispositivos. Entonces, al final del día el mensaje creo es claro: Este dispositivo quizás no tenga un "5" en su nombre, pero cuando ponemos todo el paquete junto, es no solo un muy digno sucesor del iPhone 4, sino que además en mi opinión personal y profesional, el mejor celular inteligente del mercado, en donde "inteligente" ahora toma todo un nuevo significado gracias a Siri... Ahora algunas informaciones adicionales que serán de utilidad para los curiosos: 1. Con contrato de 2 años ahora el iPhone 3GS será gratis, el iPhone 4 actual de 8GB costará US$99, el iPhone 4S de 16GB costará US$199, el de 32GB US$299 y el de 64GB US$399. 2. El iOS 5 estará disponible el próximo día 12. 3. iCloud saldrá el mismo día que iOS 5. 4. Se podrá pre-ordenar el iPhone 4S desde este viernes 7, 5. El iPhone 4S sale a la venta al público el día 14 en los EEUU, Canadá, Australia, Francia, el Reino Unido, Alemania y Japón. 6. Sale en España y México a la venta el día 28 de este mes. 7. Sale a la venta en el resto del mundo para finales de año (posiblemente el 1ro de Diciembre). 8. Similar al iPad 2 con iOS 5, el iPhone 4S podrá replicar lo que ves en su pantalla a un Apple TV conectado a tu TV, de forma inalámbrica por medio de la tecnología AirPlay. 9. En los EEUU, el iPhone 4S estará disponible no solo en las redes de AT&T y Verizon, sino que también en la de Sprint. 10. El iPhone 4S (y tal cual se rumoreó) es un celular "global", con un chip que soporta tecnologías GSM (de "chips") y CDMA, por lo que un solo modelo funcionará en cualquier país y red celular del mundo. 11. Inicialmente Siri solo entenderá Inglés, Francés y Alemán, pero otros idiomas (como el españo) saldrán próximamente - según Apple Siri está aun "en beta", es decir, en período de pruebas. 12. Como rumoreado, Siri utiliza los servicios de Wolfram Alpha, pero además de otros como Yelp! para obtener información que le ayude a responderte. 13. Los precios del iPod Touch bajaron un poco. 8GB por US$199, 32GB por US$299 y 64GB por US$399. 14. Apple también anunció un modificado iPod Nano ahora con pantalla multi-táctil por US$129 para 8GB y US$149 para 16GB. autor: josé elías |

|

|

|

|

|

lunes, octubre 3, 2011

|

En algunas de mis charlas sobre la Singularidad Tecnológica uno de los videos que muestro es el de la "Mula Robótica" (video YouTube), un robot oficialmente conocido como BigDog ("Perro Grande") por sus creadores en la empresa Boston Dynamics, y ahora la empresa está demostrando el primer prototipo de su sucesor, al que llama AlphaDog. En algunas de mis charlas sobre la Singularidad Tecnológica uno de los videos que muestro es el de la "Mula Robótica" (video YouTube), un robot oficialmente conocido como BigDog ("Perro Grande") por sus creadores en la empresa Boston Dynamics, y ahora la empresa está demostrando el primer prototipo de su sucesor, al que llama AlphaDog.Este es un robot siendo desarrollado para DARPA (la misma gente que inventó el Internet, y encargados de investigaciones para la seguridad nacional de los EEUU), en donde el objetivo es que pueda funcionar como una mula de carga robótica que lleve todo tipo de carga por terrenos difícil para otros tipo de transporte. En su nueva encarnación (¿o "robotización"?) AlphaDog es capaz de cargar hasta 180Kg (400 libras) de peso a una distancia de 30Km (20 millas), durante 24 horas sin necesidad de reabastecerse de energía. Noten ahora algunas cosas sobre el video: 1. Los cables que ven sobre AlphaDog no son para sostenerlos, sino que son simplemente para abastecerlo de energía en el laboratorio, así como para conectarlo a unidades de control y de seguridad. Es una forma de probarlo más fácilmente que tenerlo de forma autónoma y tener que recargarlo y reposicionarlo constantemente en puntos de prueba. En la vida real el robot funciona por sí solo (como en el video de BigDog que puse en el primer párrafo de este artículo). 2. En una parte del video verán como AlphaDog aparenta colapsar. Esa es una medida de seguridad, ya que este llegó al final de la zona de pruebas dentro del laboratorio. 3. Noten como el robot se mantiene en equilibrio aun cuando camina por terreno dinámico (tierra, piedras que se mueven, etc), e incluso cuando una persona trata de tumbarlo tratando de hacerle perder el equilibrio mientras lo empuja con su pierna. 4. Este modelo, a diferencia de BigDog, ahora tiene la capacidad de pararse por sí mismo si de casualidad termina de acostado sobre el piso, como podrán apreciar en el video. ¡Gracias Jaume Pujol Romaguera por el enlace! fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, octubre 2, 2011

|

En años recientes se han dado importantes avances en tecnologías que permiten interactuar con cerebros biológicos desde el mundo sintético, y esta noticia de hoy es un paso importantísimo en esta área. En años recientes se han dado importantes avances en tecnologías que permiten interactuar con cerebros biológicos desde el mundo sintético, y esta noticia de hoy es un paso importantísimo en esta área.Científicos de la Universidad de Tel Aviv en Israel lograron crear un cerebelo digital externo que restauró funciones perdidas del cerebro biológico de una rata, demostrando de paso comunicación bi-direccional entre ambos cerebros en el proceso de una forma bastante transparente. El experimento en sí es bastante sencillo, y específicamente lo que se hizo fue tomar una rata que había perdido la capacidad del reflejo de cerrar los ojos ante un evento sorpresivo, y se le restauró esa función con el implante digital. Más detalladamente, de la manera que esto funcionó es que el cerebelo digital "escucha" al cerebro biológico por patrones que podrían generar el tener que cerrar el ojo (en el caso de la rata, por la generación de un sonido en particular), procesa la información, y en tiempo real se comunica en la otra dirección comandando al cerebro biológico que guiñe el ojo. Notemos que la rata sin el implante no podía guiñar el ojo. En otras palabras, el cerebelo digital externo funcionó como una reemplazo de la parte del cerebro biológico encargada de esa función. Este tipo de experimentos tienen profundas implicaciones en el área de salud, ya que significa que al menos en forma teórica sería posible reemplazar áreas dañadas del cerebro por equivalentes sintéticos. Sin embargo, tan interesante como eso, y especulando un poco más sobre el futuro, esto también significa que con esta comunicación bi-direccional podríamos proveer al cerebro biológico de otras funciones que nunca tuvo en primer lugar, como podrían ser una brújula digital, o calculadora de aritmética de cifras grandes, o amplificación de sonido, o incluso cosas que hoy día ni nos imaginamos. Notemos que hoy día ya existen prótesis sintéticas en forma de un Neurochip que pueden reemplazar áreas dañadas en el hipocampo, en esencia recreando un hipocampo artificial (para pacientes de Alzheimer's), y así mismo en un futuro podríamos quizás reemplazar otras funciones de alto nivel como la memoria o incluso la estimulación de sentimientos. ¡Gracias Manuel Grullón por el enlace! fuente autor: josé elías |

|

|

|

|

|

viernes, septiembre 23, 2011

|

Hace 6 años les informé de un asombroso adelanto en donde científicos de Harvard lograron decodificar en fotos lo que el cerebro de un gato veía a través de su ojos. Hace 6 años les informé de un asombroso adelanto en donde científicos de Harvard lograron decodificar en fotos lo que el cerebro de un gato veía a través de su ojos.Ese experimento dio otro gran paso 4 años después (y como también reportado en eliax) cuando se logró también "fotografiar" lo que un ser humano veía por su cerebro a través de sus ojos. Pues hoy hemos dado un nuevo y monumental avance con estas técnicas, pudiéndose ahora finalmente grabar video de lo que pasa en tu mente... Este increíble avance, sacado literalmente de la ciencia ficción, fue efectuado por científicos de la universidad UC Berkeley, y tal cual sugiere el título de esta noticia, permite que una computadora grabe video digital de lo que percibe tu mente, en este caso, a través de tus ojos. O en otras palabras, y para el que aun no haya entendido, hablamos de que te colocas dentro de una máquina que pueda decodificar directamente de tu cerebro lo que sea que estés viendo (o imaginando o soñando). Esto, sin duda que dejará a muchos atónitos (y más cuando vean el video que incluyo al final de este artículo), pues esto es algo que hasta hace poco (al menos que hubieran leído las noticias que referencio al inicio de este artículo) casi nadie hubiera creído posible, o ciertamente no posible tan rápidamente. De la manera que esto funciona es la siguiente: A un grupo de personas (en el experimento, 3 personas) se les pone dentro de un escaneador cerebral del tipo fMRI, en donde se les coloca frente a una pantalla por donde se pasan varios videos de pocos segundos de duración. Mientras las personas ven los videos, una computadora con un programa de Inteligencia Artificial, empieza a ver los patrones cerebrales que se generan en nuestros cerebros mientras vemos los videos, y empieza a hacer correlaciones de forma automatizada. Sucede que cada imagen y video visual, genera un patrón que puede distinguirse entre otros patrones cuando vemos distintas imágenes, por lo que se forman patrones que son diferenciados por el programa de Inteligencia Artificial, y relacionados a los videos a los que pertenecen. Y entonces, comienza la parte interesante... Armados con esa base de datos, ahora se pueden colocar en el aparato fRMI a cualquier persona y dejar que vean cualquier video, y ahora el proceso se aplica a la inversa: El software de Inteligencia Artificial observa y mide los patrones generados en el cerebro, y los compara con su base de datos. En base a esto, el software puede encontrar cual video es que corresponde a cual patrón, y por tanto puede predecir de forma aproximada el tipo de imagen que la persona está viendo (o imaginando o soñando) en ese instante. Actualmente la base de datos consiste de 18 millones de segundos de videos grabados, pero esto es solo un primer paso experimental. Conforme más muestras se tomen, en teoría no existe límite a la base de datos que se pueda crear, y conforme se mejoren las técnicas de medición del cerebro, se hace bastante factible decir que estamos muchísimo más cercano de un futuro en donde computadoras podrán literalmente representar nuestra imaginación en imágenes, de lo que muchos se imaginaban... Esto obviamente tendrá grandes, amplias y profundas implicaciones para la humanidad como la conocemos. Para empezar, esto significa que llegará un futuro en donde literalmente podremos "grabar" nuestros sueños para disfrutar de ellos posteriormente (o que sirvan de análisis para un psicólogo), o que podríamos crear un interfaz en donde un diseñador gráfico no utilizaría ni ratones de computadora, ni teclados ni lápices electrónicos ni superficies multi-táctiles, sino que literalmente con solo imaginarse las cosas que desea, estas se materializarían frente a él o ella de forma tridimensional. Y lo mismo podemos decir de arquitectos, escultores, pintores, compositores musicales, etc. Por otro lado, esto también trae a la luz un artículo que escribí hace un par de años titulado "Editorial eliax: Hackers pronto empezarán a controlar la mente humana" (recibido con cierto escepticismo en ese entonces), en donde yo argumentaba que la tecnología nos estaba alcanzando a un ritmo tal, que pronto se podría manipular (como vemos con esta noticia de hoy) la fragilidad de nuestros cerebros biológicos, cosa que tarde o temprano nos impulsará a buscar formas más robustas de proteger nuestras mentes, posiblemente migrando nuestras mentes a entornos sintéticos más resistentes a este tipo de indagación potencial involuntaria. El futuro como dicen, ya está tocándonos la puerta, y queramos o no esa puerta se abrirá, y dependerá de nosotros darle la bienvenida y hacer lo mejor que podamos con el invitado, o resistirnos y arriesgarnos a convertirnos en títeres o dinosaurios... Este es un excelente momento para leer sobre La Singularidad Tecnológica. Sobre el video: El video que verán a continuación les muestra varias cosas, y para que no se confundan les explico a continuación lo que están viendo... En el cuadro superior a la izquierda (el video que está solo) es el video que se le muestra a las tres personas, y cuyo video de alguna manera debe ser "extraído" del cerebro de estos. Abajo notarán 3 filas de videos. Cada fila pertenece a una persona. El cuadro verde (el primer cuadro a la izquierda) es lo que la computadora ha deducido que la persona está viendo, y los cuadros a su derecha son los videos utilizados para reconstruir la imagen. Como verán, el sistema aun dista de perfecto, pero para ser un primer intento esto es espectacularmente asombroso. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, septiembre 18, 2011

|

Hola amig@s lectores, Hola amig@s lectores,¿Qué hacer cuando uno está en un aeropuerto, cansado y aburrido, a altas horas de la noche, y con solo un iPad entre las manos? Pues en mi caso, empezar a escribir mi próximo libro... :) ¡En serio!, después de varios meses pensando en la idea, decidí iniciar por fin lo que sería no tanto una continuación de Máquinas en el Paraíso, sino más bien un re-enfoque en un solo tema: La Singularidad Tecnológica. Aun no tengo ni la menor idea de cómo se llamará el libro (por el momento llamémoslo "Máquinas en el Paraíso 2.0"), pero lo que sí les puedo adelantar es que el enfoque que pienso darle irá un poco más allá de los pocos libros actuales del tema. Desde ahora les doy las gracias a todos ustedes, pues en muchos casos fueron inspiración para varios de los miles de artículos que he escrito acá en el blog, y en efecto, el libro en muchos sentidos será una extensión organizada de muchos de los artículos en eliax relacionados con La Singularidad. ¿Cuándo lo finalizaré? Pues el objetivo es "en algún momento en el 2012", preferiblemente en la primera mitad del año, pero ya veremos. Siento que si tuviera tiempo libre lo podría escribir en un par de meses, pero tiempo es lo que menos tengo dada todas mis otras responsabilidades. Sin embargo, ya he iniciado un proceso en donde planeo liberar un poco de mi tiempo en los próximos meses para dedicarle más tiempo al escribir (¡lo que significa un poco de menos tiempo al blog!) Por el momento, ya el Prólogo está escrito, ahora a estructurar el esqueleto del libro antes de sentarme a escribir el Capítulo 1... :) Así que atentos al blog, pues trataré de mantenerlos al tanto de mi progreso (al inicio será todo muy2 lento), y si alguien conoce contactos dentro de una editora de reputación internacional que le pueda interesar publicar la versión impresa del libro (yo posiblemente me reserve la distribución digital), favor de contactarse conmigo por las vías tradicionales. autor: josé elías |

|

|

|

|

|

martes, agosto 30, 2011

|

|

El futuro se nos acerca más rápidamente de lo que muchos se imaginan o quieran admitir, y evidencia de ello es el Proyecto Eyeborg, en donde un tal Rob Spence se convirtió en el primer ser humano en implantarse una cámara dentro del espacio que normalmente se reserva para el ojo biológico (en este caso, después de una pérdida de su ojo derecho).

Es importante destacar que a diferencia de otros adelantos como la retina artificial, que esta cámara por el momento no se utilizará para mejorar la visión de Rob, sino que para servir como una extensión de su cuerpo. La idea es que esta diminuta cámara envía señales a un receptor inalámbrico que Rob carga siempre consigo, grabando todo a su antojo, en esencia funcionando este ojo como un grabador de memorias que Rob puede buscar posteriormente en su vida. Este tipo de tecnología biónica apenas está dando sus primeros pasos, pero no duden por un momento que los próximos pasos serán grandes y vendrán cada vez más rápidamente. Como escribí en el artículo de ayer, la inevitabilidad de la Humanidad 2.0 está cerca de nosotros... No dejen de ver el video sobre el Eyeborg, pues en este verán no solo otros tipos de prótesis biónicas, sino que además videos conceptuales que bastante bien reflejan las capacidades físicas que tendremos en un futuro no tan lejano. ¡Gracias al lector LiteSoul por el enlace! página oficial del Proyecto Eyeborg Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, agosto 23, 2011

|

Cuando imaginamos un futuro de la humanidad en donde convivimos (o somos parte) de Inteligencias Artificiales, por lo general el escenario que pintamos es color de rosas: Seres Sintéticos que nos ayudan a evolucionar a niveles más abstractos, y nada parecido a los escenarios distópicos presentados en películas como Terminator o The Matrix en donde los humanos somos destruídos y/o esclavizados. Cuando imaginamos un futuro de la humanidad en donde convivimos (o somos parte) de Inteligencias Artificiales, por lo general el escenario que pintamos es color de rosas: Seres Sintéticos que nos ayudan a evolucionar a niveles más abstractos, y nada parecido a los escenarios distópicos presentados en películas como Terminator o The Matrix en donde los humanos somos destruídos y/o esclavizados.Sin embargo, creo que también tiene mucho mérito pensar en el otro lado de la moneda: ¿Y qué tal si no todo es color de rosas? Y en ese sentido, en realidad creo que el tema principal se centrará en la psicología, o más específicamente en la psicología aplicada a Inteligencias Artificiales. En otras palabras, hablamos del hecho de que si algún día logramos confeccionar Inteligencias Artificiales a un nivel similar a un humano (y existe toda indicación de que lo lograremos en este mismo siglo, mucho antes de lo que muchos se imaginan), que estas irrefutablemente poseerán sentimientos. Y asumiendo que estos seres poseerán sentimientos, ¿qué tipo de sentimientos tendrán? Los sentimientos de los humanos de la actualidad se basan en dos criterios: Primeramente proveen de factores genéticos a gran escala, cambios que hemos acumulado paulatinamente por miles de millones de años mientras evolucionamos de ser microbios hasta peces, reptiles, mamíferos y primates. Y segundo, cambios en nuestro medio ambiente individual (es decir, experiencias de la vida). Ambos de estos criterios están intrínsecamente y profundamente relacionados entre sí. Como un simple ejemplo, si una madre tuvo dos hijos, en donde uno tenía tendencias suicidas en su genoma, y otro tenía tendencias de amor a la vida, existen más probabilidades de que el que se reproducirá será el segundo hijo, y por tanto el que pasará sus genes "amorosos" hacia futuras generaciones. En otras palabras, aparenta que el mismo hecho de que estamos vivos y viviendo todos de forma relativamente armoniosa (y sí, existen guerras contínuas en todo el mundo, pero por lo general no a nivel familiar sino que a niveles sociales más abstractos) es que los genes que han sobrevivido son los de aquellas personas que por lo general son más propensos "a lo bueno para la sociedad". Como contra-ejemplo, imaginen que de alguna forma mágica todos los genes (y la asociada mentalidad) de los casi 7 mil millones de seres humanos de hoy día se cambiaran de la noche a la mañana a ser genes que nos hagan propensos a matar personas. Es casi seguro que en pocos años abrían pocos de nosotros en el planeta, y muy posiblemente perderíamos todo lo que hoy llamamos tecnología en el proceso. Pero más allá de los genes, todo ser humano tiene también el componente emocional que desarrolla a través de los años de vida, un componente quizás tan importante como el genético, y que en el caso de los humanos, que somos seres conscientes de nuestra propia existencia, es un potente promotor de el querer mejorarnos. Es decir, el hecho de que uno pueda tener introspectiva dentro de nuestra propia mente nos da la asombrosa capacidad de poder detectar qué tenemos de malo, y buscar la forma de mejorarlo. Pero más interesante aun, es el hecho de que está comprobado que conforme aumenta el nivel de educación de las personas, así mismo aumenta no solo el nivel de percepción de uno mismo, sino que el nivel de percepción a nivel global (es decir, entender que no vivimos solos y que estamos todos juntos en esto que es la vida). Es esta la razón por la cual estudios estadísticos han demostrado que los países más pacíficos son por lo general los más educados (y curiosamente, los menos religiosos). Pero, ¿y qué tiene todo esto que ver con la posible existencia de Inteligencias Artificiales (IA)? Pues tiene mucho que ver... Para empezar, ¿cómo formarán estas IAs un código moral/ético si son creados "de la nada" en un laboratorio? Y si forman un código moral, ¿bajo cuáles principios e influencias? Y asumiendo que estas IAs crean que están haciendo "el bien", ¿podría significar ese bien el erradicarnos del planeta para asegurar sus propias existencias? Admito que soy un optimista y el instinto me dice que conforme aumenta el intelecto de cualquier ser (sea biológico o sintético) que este verá por sus propios "ojos" lo bello que es el Universo y que vale la pena conservar toda la vida que conozcamos, pero la realidad es que muchas veces nuestro instinto nos ha fallado antes (hace apenas 500 años el 99.999% de la población mundial estaba totalmente convencida de que la Tierra era plana). A tal fin, quizás lo prudente sea que nos conozcamos a nosotros mismo primero en la forma que somos hoy día. ¿Cómo se generan nuestros sentimientos en el cerebro? ¿Qué patrones neuronales rigen sentimientos como el amor, bondad, odio o envidia? El conocer esos datos nos podría preparar mejor para asegurarnos que las primeras y verdaderas IAs que creemos sean "amigables" no solo hacia nosotros los humanos, sino que hacia la vida misma en el Universo. O quizás lo que deberíamos hacer es evolucionar paulatinamente a estas IAs en un ambiente controlado, en donde le alimentamos de todo lo que somos y lo que hemos sido a través de toda nuestra historia, lo bueno y lo malo, lo bello y lo atroz, y que estas IAs entiendan que aunque ciertamente no hemos sido (ni somos) perfectos, que hemos llegado hasta donde hemos llegado gracias a que muchos de nosotros se esfuerzan en hacer este un mundo mejor para nosotros mismos, nuestros amigos y familiares, y nuestros descendientes. Este tema creo que amerita toda una discusión profunda a nivel internacional entre los profesionales de estos campos (científicos en computación, robótica, neurociencia, psicología, etc), aunque algo me dice que independientemente de estas discusiones (y si es que llegan a tener algún fruto útil), que estas Inteligencias Artificiales llegarán a existir de todas formas, con o sin un marco ético/moral, por lo que solo espero que al menos podamos educar a la próxima generación de estos científicos en estos temas para que tengan pendientes los peligros latentes en no entender bien nuestras propias creaciones... Nota a conspiracionistas y luditas: Tampoco se alarmen. Estos son temas vigentes entre la comunidad científica que trabaja en IAs. Mi punto es que pronto llegará la hora de sacar el tema a la luz a gran escala ante el público y quizás redactar normas y estándares sobre cómo crear estas IAs en ambientes controlados inicialmente (y solo inicialmente, pues eventualmente estos seres crearán a otros seres aun más avanzados, y de ahí en adelante todo estará totalmente fuera de nuestro control - no nos hagamos ilusiones de superioridad al estilo las películas de Hollywood). Nota a los que comentarán en el artículo: Este es un tema sumamente extenso, y tengo muchos otros pensamientos que por motivo de espacio y tiempo no puedo expresar en este solo artículo, pero hay algo que creo vale la pena hacer notar: Soy de la opinión que estos "Seres Sintéticos" que crearemos no solo serán nuestros sucesores evolutivos, sino que como expresé hace 10 años en Máquinas en el Paraíso, nosotros seremos ellos... O en otras palabras (y esto es algo que se que hoy día suena controversial, o incluso inaudito y/o imposible para la mayoría de las personas), los humanos de hoy día evolucionaremos para dejar atrás nuestros cuerpos biológicos y nos fusionaremos con nuestras creaciones, siendo seres superiores (o más bien dicho, mejores adaptados para sobrevivir en el Universo y entenderlo mejor) en todos los sentidos de la palabra a lo que somos hoy día. Solo espero poder vivir para ver (y quizás hasta ser parte) de esta transición, la cual ya ha iniciado ante las narices de la mayor parte de la población (vean un un ejemplo reciente). autor: josé elías |

|

|

|

|

|

sábado, agosto 20, 2011

|

Hace un par de años les hablé acá en eliax de un proyecto llamado SyNAPSE (Systems of Neuromorphic Adaptive Plastic Scalable Electronics) fundado por DARPA (la Agencia de Proyectos de Investigaciones Avanzadas de la Defensa de los EEUU - los mismos que inventaron el Internet), en donde el objetivo era crear Inteligencias Artificiales. Hace un par de años les hablé acá en eliax de un proyecto llamado SyNAPSE (Systems of Neuromorphic Adaptive Plastic Scalable Electronics) fundado por DARPA (la Agencia de Proyectos de Investigaciones Avanzadas de la Defensa de los EEUU - los mismos que inventaron el Internet), en donde el objetivo era crear Inteligencias Artificiales.Pues ese proyecto acaba de dar un gran paso gracias a un aporte de IBM que ha llevado el proyecto a su segunda fase, y de paso le ganó a IBM un premio de US$21 Millones de dólares por parte de DARPA para continuar con su investigación. Lo que IBM ha logrado es un sistema bajo el programa SyNAPSE compuesto de dos prototipos, un par de chips que a diferencia de los procesadores tradicionales no se programa con instrucciones específicas, sino que son chips que literalmente aprenden patrones de su entorno y utilizan experiencias pasadas para mejorar su rendimiento futuro, incluyendo cálculos y predicciones. El primero de tales chips tiene el equivalente a 65,536 synapsis artificiales, mientras que el segundo tiene 262,144, implementados en ambos casos en un chip con el equivalente a 256 núcleos (o sub-procesadores). Es importante notar que este proyecto tuvo dos faces previas llamadas "Fase 0" y "Fase 1", en donde sus objetivo (logrados) fueron el de simular el nivel de complejidad de la corteza cerebral de un gato (como reportado también en eliax hace un par de años), en ese momento con una máquina de IBM con 144TB (144 TeraBytes) de memoria. La idea en esta fase era demostrar la factibilidad de demostrar no solo que se puede crear algo de ese nivel de complejidad, sino que ahora que esta estructura se auto-programe y cambie dinámicamente. En futuras etapas la idea ahora es combinar todo en super-máquinas programables que vayan subiendo en complejidad, incrementando desde la complejidad de un gato hasta mamíferos de más alto nivel, hasta llegar (y seguro sobrepasar) el nivel de complejidad humano. En noticia relacionada, los refiero a que lean este documento que explica nuevos avances y caminos siendo explorados para lograr Inteligencias Artificiales por medio de la combinación de la neurociencia, supercomputación y nanotecnología (gracias al lector Abraham Jiménez por es enlace). fuente fuente secundaria autor: josé elías |

|

|

|

|

|

martes, agosto 16, 2011

|

|

Esta creo es la primera vez en eliax que utilizo el término "GRAN HITO" para una tecnología de visualización gráfica, pero cuando vean el siguiente video (y en particular si son usuarios técnicos que conocen de estos temas) ya sabrán por qué.

Solo les diré que durante gran parte del video mi mandíbula estuvo abierta de asombro y mi mente vuelta loca con solo pensar en todas las posibilidades que esta técnica nos traerá en los próximos años. Se trata de un proyecto llamado KinectFusion, en donde toman el sensor Kinect del Xbox 360 y lo convierten literalmente en un "digitalizador/escáner del mundo físico" y en tiempo real, permitiendo hacer cosas que antes eran dificilísimas (cosas que antes requerían de mucho procesamiento computacional y/o intervención manual de artistas digitales), así como permitiendo hacer un par de trucos nuevos. En esencia lo que esto hace es que te permite mover en el aire el sensor del Kinect y utilizarlo como una cámara virtual que capta en 3D todo lo que pasa por su frente, mientras el software genera un modelo tridimensional de toda la escena paulatinamente. Pero tan asombroso como todo esto, es que todo ocurre en tiempo real, creándose los modelos que pueden ser entonces recubiertos y pintados con otros patrones (y una vez, en tiempo real), permitiendo además reemplazar objetos del mundo virtual generado, o interactuar con efectos físicos del mundo virtual con el mundo deducido del mundo real. Tienen que ver el video para entenderlo mejor (no dejen de verlo, de verdad es extraordinario, aunque un poco repetitivo, pero aguante hasta verlo todo). En cuanto a aplicaciones, ya me puedo imaginar esto en al menos los siguientes escenarios (y algo me dice que veremos muchas cosas más en los próximos años que hoy día ni nos podemos imaginar): - Efectos especiales para el cine - Video-juegos - Simulaciones y visualizaciones físicas - Pre-visualización arquitectónica - Diseño industrial - Probadores virtuales de ropa - Previsualización corporal en gimnasios - Entrenamiento de fuerzas de ventas - Demostración de productos - Diseño de interiores - Reconstrucción de escenas de crimen - Efectos televisivos en noticias - Proyectos de expresión artística - Videos musicales - Visión robótica - etc ¡Gracias al lector Luis Manuel Hernandez por el enlace! Nota: Y una vez más, parece que acerté con esta predicción del año pasado... :) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, agosto 7, 2011

|

Hola ami@s lectores, Hola ami@s lectores,Hoy les tengo una sorpresa. Es una entrevista a Julio J. Santos-Munne, un pionero en robótica que entre otras cosas tuvo mucho que ver con hacer realidad el Brazo Robótico Luke que generalmente presento en video en mis conferencias así como acá mismo en el blog. Julio ha tenido una carrera y vida fascinante, y accedió a responderme una serie de preguntas cuyas respuestas traduzco del inglés y comparto con ustedes a continuación. Pero noten antes de iniciar que Julio es (para sorpresa de muchos) de origen dominicano (en la entrevista nos provee más detalles), y una de las razones que quise hacer esta entrevista es para que vean que con un empujoncito y determinación, y sin importar de donde provengan, todos podemos cambiar el mundo... --------- 1. Eliax: Julio, después de conocer tu biografía aparenta que desde una edad temprana te interesó la ciencia, las matemáticas y la robótica. ¿Fue este el caso? ¿Como te llegó el deseo de estudiar en estos campos?  Julio: Siempre fui uno de esos chicos que se la pasaba construyendo modelos de aviones, de autos, y tratando de arreglar todo lo que se dañaba en casa. Además tuve un interés temprano en programación de computadoras/ordenadores de modo que a eso de la edad de 10 años aprendí a programar en BASIC y mi padre me regaló una Tandi TRS80 a color con una casetera de almacenamiento, y yo la conectaba a mi TV ;-). Julio: Siempre fui uno de esos chicos que se la pasaba construyendo modelos de aviones, de autos, y tratando de arreglar todo lo que se dañaba en casa. Además tuve un interés temprano en programación de computadoras/ordenadores de modo que a eso de la edad de 10 años aprendí a programar en BASIC y mi padre me regaló una Tandi TRS80 a color con una casetera de almacenamiento, y yo la conectaba a mi TV ;-).Poco después, no recuerdo haber leído algo específicamente pero los robots empezaron a captar mi atención, pues sencillamente se veían tan futuristas y sin límites, llenos de posibilidades, algo muy fascinante para mi, así que decidí aprender más al respecto. Los robots combinaron mi intereses de crear/construir cosas, electrónica y programación de software de forma bastante bella. Y sí, ayudó mucho el hecho de que siempre me gustó y fui bueno en matemáticas y ciencias. 2. Eliax: ¿En dónde naciste y de dónde provienen tus padres?  Julio: Nací en Santo Domingo, República Dominicana y mis padres son Mercedes Munne-Taule, y Julio Santos-Cayado, ambos nacidos en Santo Domingo pero hijos de inmigrantes catalanes y asturianos respectivamente. Julio: Nací en Santo Domingo, República Dominicana y mis padres son Mercedes Munne-Taule, y Julio Santos-Cayado, ambos nacidos en Santo Domingo pero hijos de inmigrantes catalanes y asturianos respectivamente.En estos momentos los que tienen que soportar como soy son mi esposa Janet De Soto Molinari, y mis hijos, Julio Alejandro, Paola Marie, y José Fernando ;-) Leer el resto de este artículo... autor: josé elías |

|

|

|

|

"Segunda vez que te escribo, llevo prácticamente leyendo desde tus inicios más como feliz espectador que como activo comentarista y no podría aunque sea en la recta final quedarme sin agradecerte tus palabras opiniones, enseñanzas, visiones e incluso pasiones que gracias a ti he conseguido descubrir, no sólo yo sino amigos a los que he recomendado insistentemente tu blog. Para mañana cerraré todas las pestañas del navegador(me llevará un rato) y dedicaré una exclusiva a uno de los mejores blogueros e intuyo, personas que he conocido. Mis mejores deseos para ti y los tuyos, para todo lo que hagas y te propongas y si nos echas de menos y necesitas contar alguna nueva reflexión, ten por seguro que si lo avisas por eliax, yo lo veré. Grande"

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax

Julio: Absolutamente, ambos de mis padres son muy orientados académicamente. Si yo quería estudiar o aprender algo ellos me respaldaban y ayudaban a hacerlo realidad. Ellos no toleraban el "perder" tiempo. Así que o nosotros (mi hermana María Luisa, y hermano Pablo Antonio) encontrábamos algo que hacer, o ellos nos encontraban algo qué hacer para mantenernos ocupados, si entiendes lo que quiere decir ;-) Así que este ambiente hogareño nos motivó a encontrar las cosas que nos interesaban temprano en la vida.

Julio: Absolutamente, ambos de mis padres son muy orientados académicamente. Si yo quería estudiar o aprender algo ellos me respaldaban y ayudaban a hacerlo realidad. Ellos no toleraban el "perder" tiempo. Así que o nosotros (mi hermana María Luisa, y hermano Pablo Antonio) encontrábamos algo que hacer, o ellos nos encontraban algo qué hacer para mantenernos ocupados, si entiendes lo que quiere decir ;-) Así que este ambiente hogareño nos motivó a encontrar las cosas que nos interesaban temprano en la vida. Julio: No, ni siquiera me cruzó la mente. Yo entré incluso al post-grado pensando que encontraría un trabajo como consultor. Pero lo que terminó sucediendo fue que como estudiante de Maestría me encontré a mí mismo trabajando en una aplicación para cirugía por medios robóticos, en un proyecto en donde noté posibilidades comerciales bastante reales.

Julio: No, ni siquiera me cruzó la mente. Yo entré incluso al post-grado pensando que encontraría un trabajo como consultor. Pero lo que terminó sucediendo fue que como estudiante de Maestría me encontré a mí mismo trabajando en una aplicación para cirugía por medios robóticos, en un proyecto en donde noté posibilidades comerciales bastante reales. Julio: Pregunta difícil de responder, no se todavía si estoy de acuerdo al 100% con mi propia opinión al respecto.

Julio: Pregunta difícil de responder, no se todavía si estoy de acuerdo al 100% con mi propia opinión al respecto. Julio: Para el Brazo Biónico Luke con Dean Kamen, nosotros (mi empresa, Kinea Design), desarrollamos el llamado Prosthetic Haptic Interface. Este es el subsistema del brazo que le ofrece al paciente amputado el sentido del tacto.

Julio: Para el Brazo Biónico Luke con Dean Kamen, nosotros (mi empresa, Kinea Design), desarrollamos el llamado Prosthetic Haptic Interface. Este es el subsistema del brazo que le ofrece al paciente amputado el sentido del tacto. Julio: Para ser utilizado universalmente como es el objetivo, entre 10 y 20 años, aunque algunas de las tecnologías desarrolladas es posible que lleguen al mercado antes de eso.

Julio: Para ser utilizado universalmente como es el objetivo, entre 10 y 20 años, aunque algunas de las tecnologías desarrolladas es posible que lleguen al mercado antes de eso. Julio: Aparte de mis 3 hijos, e iniciar y participar en mis 3 empresas, puedo decir que toda mi vida profesional ha sido bastante gratificante, ya que nos hemos enfocado em desarrollar sistemas que ayudan a las personas.

Julio: Aparte de mis 3 hijos, e iniciar y participar en mis 3 empresas, puedo decir que toda mi vida profesional ha sido bastante gratificante, ya que nos hemos enfocado em desarrollar sistemas que ayudan a las personas. Julio: No se rindan y delen hacia adelante... háganlo, vale la pena y se divertirán. El campo de la robótica apenas inicia, todavía falta muchísimo por hacer.

Julio: No se rindan y delen hacia adelante... háganlo, vale la pena y se divertirán. El campo de la robótica apenas inicia, todavía falta muchísimo por hacer.