Futuro Digital

|

miércoles, enero 30, 2013

|

El descubrimiento del cual les hablo hoy, de ser confirmado como algo que se puede implementar en la práctica, sería uno de los más grandes hitos científicos de este siglo. El descubrimiento del cual les hablo hoy, de ser confirmado como algo que se puede implementar en la práctica, sería uno de los más grandes hitos científicos de este siglo.Se trata de un grupo de científicos de la Universidad de Buffalo en los EEUU que ha descubierto que es posible obtener hidrógeno puro directamente desde unas nano-partículas de silicio, con solo añadirles agua. En otras palabras, hablamos de una forma de generar combustible en donde lo único que se utilizaría sería literalmente agua. No se necesita ni electricidad, ni luz solar ni nada adicional, solo agua. Y lo mejor de todo, es que el silicio es quizás lo más abundante que tenemos en el planeta, pues es básicamente un tipo de arena, del cual a propósito también se fabrican los microprocesadores hoy día. Esto significa un futuro en donde automóviles funcionarían solo con agua, así como lo harían incluso aviones, motocicletas, barcos, e incluso naves espaciales que minen agua de la Luna y asteroides cercanos. Aparte de hidrógeno el proceso lo único que genera como producto residual es ácido de silicio, lo que es un producto no-tóxico y por tanto seguro para humanos. Otra buena noticia es que los investigadores que realizaron este descubrimiento ya lo han puesto en práctica, pudiendo ellos construir un prototipo que movió las hélices de un pequeño abanico. Sin embargo, una barrera aun por pasar (¡siempre hay una barrera!) es el alto costo de crear las nanopartículas esféricas necesarias para que esto funcione en primer lugar, pero ya veremos como avanza la ciencia en ese aspecto en los próximos años. Mientras tanto a esperar a que esto se torne algo factible para la práctica, y de serlo no duden que verán notificación al respecto en eliax con una "GRAN HITO" delante del titular... fuente oficial autor: josé elías |

|

|

|

|

|

martes, enero 29, 2013

|

Las impresoras tridimensionales, capaces de imprimir con diversas técnicas a diversos tipos de materiales, acaban de entrar en moda, literalmente, pues la diseñadora de modas Iris Van Herpen acaba de darle uso a estas impresoras para crear los primeros vestidos impresos en tales impresoras 3D. Las impresoras tridimensionales, capaces de imprimir con diversas técnicas a diversos tipos de materiales, acaban de entrar en moda, literalmente, pues la diseñadora de modas Iris Van Herpen acaba de darle uso a estas impresoras para crear los primeros vestidos impresos en tales impresoras 3D.Debido a que estos vestidos pueden ser diseñados digitalmente, eso libera al diseñador de muchas de las restricciones tradicionales de las telas, y puede diseñar complejos patrones como los que vemos en la foto que acompaña al artículo. Así mismo, esto es un primer paso hacia un futuro en donde por ejemplo una mujer podría ir a la página web de un diseñador, pagar por un vestido, bajar los planos, e imprimerlo en casa en cuestión de minutos para ponérselo ese misma noche. Así que como pueden ver, el futuro que les pinté hace unos años, ya no suena tan descabellado después de todo... fuente (con más imágenes) autor: josé elías |

|

|

|

|

|

miércoles, enero 23, 2013

|

Hace apenas menos de 1 año que se anunció la primera empresa creada exclusivamente para minar asteroides (muchos de los cuales están repletos de metales altamente cotizados acá en la Tierra), y ya tenemos el anuncio de una segunda empresa que competirá en el espacio... Hace apenas menos de 1 año que se anunció la primera empresa creada exclusivamente para minar asteroides (muchos de los cuales están repletos de metales altamente cotizados acá en la Tierra), y ya tenemos el anuncio de una segunda empresa que competirá en el espacio...La empresa, Deep Space Industries ("Industrias de Espacio Profundo") planea lanzar en apenas un par de años (2015) una flota de diminutos satélites que volarán como un enjambre para minar asteroides de tamaño considerable que estén pasando cerca de la Tierra, y (esperamos) poder minar materiales de su superficie. Pero estarán pensando "Muy bien, entre Marte y Júpiter sabemos que existe un cinturón de asteroides, ¿pero cuántos asteroides pasan cerca de nosotros anualmente?", y la respuesta es "muchos", en el orden de alrededor de 900 cada año (lo que cuando menos para mi, suena alarmante - suerte que son de tamaño relativamente pequeño). La idea de esta empresa es iniciar en el 2015 con una flota de satélites Fireflies de 25Kg (55 Lbs) que lo único que harán es explorar en búsqueda de posibles candidatos, y en el 2016 enviar una nueva flota de satélites que llaman DragonFly y pensando unos 32Kg (70 Lbs) con el objetivo de traer de regreso a la Tierra entre 27kg (60 Lbs) y 68kg (150 Lbs) de material valuable. La misión del 2015 se espera dure unos 6 meses, mientras que la del 2016 durará unos 4 años, completándose en el 2020. Sin embargo, lo que más me emociona de esta empresa es lo que planea hacer a largo plazo con esos metales en el espacio, pues la empresa está trabajando en una tecnología que llama The MicroGravity Foundry que se trata de una impresora 3D capaz de transformar en medio del espacio mismo los materiales minados de los meteoritos en otros metales y compuestos exóticos (como combustible por ejemplo), los cuales se podría utilizar para fabricar todo tipo de cosas en el espacio exterior, reduciendo enormemente su costo y complejidad, y potencialmente revolucionando la exploración espacial. página oficial de Deep Space Industries (DSI) fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, enero 18, 2013

|

Reflexiones es un espacio en donde se muestran conversaciones hipotéticas de la vida cotidiana en varias eras del futuro de la humanidad, basado en artículos de eliax. El objetivo es presentar la vida del futuro no tanto desde un punto de vista tecnológico, sino que más bien desde un punto de vista humano. Más información en este enlace. Reflexiones es un espacio en donde se muestran conversaciones hipotéticas de la vida cotidiana en varias eras del futuro de la humanidad, basado en artículos de eliax. El objetivo es presentar la vida del futuro no tanto desde un punto de vista tecnológico, sino que más bien desde un punto de vista humano. Más información en este enlace.Reflexiones 33: Más allá de las fronteras... En la primera mitad de este siglo 21... Sofía (con lágrimas en los ojos): No sabía... no me imaginaba... que era... tan... bello!... Ingrid (emocionada): Hija mía, desde la primera vez que subí a órbita terrestre, y miré por primera vez hacia abajo lo que ven tus ojos ahora mismo, no dudé un segundo en algún día traerte acá arriba. Así que feliz dieciséis años mi bella princesa... Sofía (abrazando a su madre y llena de emoción): ¡Gracias mami! ¿y papi qué dice? ¿cuándo lo vemos? Ingrid: Pronto mi amor, pronto. No te imaginas lo que debe estar sufriendo por no poder estar contigo hoy, pero desde que finalice los análisis de ese meteorito que estamos minando lo veremos otra vez. Así que cruza los dedos, porque si le va bien pronto nos iremos de vacaciones... a la Luna... Sofía (con ojos abiertos más grandes que los de un buo): ¿¡La Luna!? ¿hablas en serio? Ingrid (con una sonrisa de lado a lado): ja ja ja, si amor, la Luna, pero un paso a la vez, un paso a la vez. Ahora disfrutemos de esta vista, y esperemos de corazón que los otros miles que están subiendo constantemente acá arriba no solo puedan apreciar lo afortunados que somos de estar viviendo en estos tiempos, sino además que sientan lo importante que es que nos cuidemos y amemos los unos a los otros, así como te quiero yo a ti... Reflexión inspirada en este articulo y este otro previos en eliax. Lee las otras Reflexiones en eliax... autor: josé elías |

|

|

|

|

|

miércoles, enero 16, 2013

|

El rumor que les mencioné via Twitter se hizo cierto, y Facebook le acaba de declarar la guerra a Google oficialmente (pues extraoficialmente están en guerra desde hace tiempo, como he mencionado en varios artículos previos acá en eliax). El rumor que les mencioné via Twitter se hizo cierto, y Facebook le acaba de declarar la guerra a Google oficialmente (pues extraoficialmente están en guerra desde hace tiempo, como he mencionado en varios artículos previos acá en eliax).Facebook anunció hace horas un servicio al que llama "Graph Search", el cual puedes pensar de este como "un buscador para tu vida". Esencialmente, Graph Search mejora sustancialmente el anémico buscador de Facebook, el cual por años ha sido uno de los peores aspectos de esta red social. Hablamos de "la cajita de búsqueda" que aparece al tope de la pantalla de Facebook, o escondida bajo otros matices bajo el icono en forma de lupa magnificadora. Con esta nueva herramienta, toda nueva búsqueda que realices (tanto de búsquedas de amigos, lugares, eventos, fotos, etc) estará ligada a tu círculo de amigos, en esencia transformando la costumbre humana milenaria de pedir recomendaciones a amigos, en algo digital. Así que por ejemplo si buscas un restaurante italiano, Graph Search responderá con restaurantes italianos que han sido referenciados o recomendados o "gustado" (con "Like" o "Me gusta") por tu círculo de amigos de Facebook, ofreciendo potencialmente una mejor sugerencia que lo que sería una sugerencia genérica por parte de Google. En los resultados incluso obtienes de donde Facebook obtuvo la información que te presenta (por ejemplo, el nombre de un amigo o hermana que visitó tal restaurante). Y lo mismo aplica para películas, cines, música, libros, etc. Esto justifica bastante la iniciativa pasada de Facebook Verbs, del cual les hablé hace un par de años, pues en esencia liga las cosas que nos gustan y hacemos, con un sistema de sugerencia y búsqueda de información. O en otras palabras, esto es parte de un obvio Plan Maestrotm que Facebook ha venido cocinando paulatinamente y de lo cual estamos empezando a ver frutos hoy día... Eventualmente, y como escribí al principio, el objetivo final de Facebook con esta iniciativa es proveer un buscador para todo lo relacionado a tu vida, y por extensión, tus amigos y allegados, lo que vuelve a poner a Facebook un paso por delante de Google, en particular en relación a su red Google+. Y hablando de Google y su buscador, una cosa que quizás ya hayan pensado mientras leían todo esto es "¿pero de todas formas no es útil también ofrecer sugerencias más allá de las de mis amigos y familiares en los resultados de mis búsquedas?", y la respuesta es Bing. Facebook se ha alidado una vez más con Microsoft para utilizar su buscador Bing para proveer resultados adicionales más allá de los resultados dentro de Facebook, lo que es una buena movida y que una vez más perjudica directamente a Google. En cuanto a cuándo esto estará disponible, según Facebook ya está saliendo "en beta" (modo preliminar de pruebas) para un grupo reducido de usuarios, con miras a una salida oficial a toda la red en los próximos meses. Opinión Por si no se ha hecho evidente ya con lo que he dicho, esto es algo grande, que desde que los usuarios empiecen a descubrir y utilizar será altamente adictivo. Imaginen por ejemplo que quieran ver todas las fotos que un amigo se tomó en New York. Simplemente escriben "Fotos de José Carlos en New York". O si quieren saber las películas favoritas de los empleados de tu empresa, escribes "películas favoritas de Acme Inc.". O si llegas a vivir a una nueva ciudad y necesidad cambiar tus gafas pues escribir "Optometrista", lo que te devolverá los optometristas que recomiendan tus amigos cercanos en esa ciudad en donde escribiste la búsqueda. O que tal (y ya me imagino todos los usos que le darán a esto en todas sus formas) "amigas de más de 18 años que les guste la música rock y beber mojitos". No se ustedes, pero eso lo veo extremadamente poderoso (y hasta cierto punto, preocupante en términos de privacidad). Esto es esencialmente Google en esteroides. O en otras palabras, así como Amazon se ha convertido en un recurso para buscar información sobre productos, Wikipedia sobre temas educativos, e IMDB para temas de películas, así mismo Facebook se tornará en un buscador para temas sociales que hasta el momento no teníamos forma fácil de encontrar, salvo preguntando de forma proactiva y directamente a nuestros amigos. Esto de paso distanciará más a Facebook de Google+, haciéndolo aun más útil, y haciendo que dependamos aun más de Facebook. Esto por tanto no solo afectará a Google de forma notoria al mediano y largo plazo, sino además a todo servicio que dependa de búsquedas de personas para obtener cualquier cosa. Por ejemplo, esto podría afectar a Amazon, pues ahora en vez de buscar en Amazon es posible que los usuarios prefieran primero hacer algo como "cámaras digitales que utilizan mis amigos", o "cámaras más gustadas en el grupo de fotografía Focus", lo que le ofrece a Facebook una oportunidad de secuestrar el interés de los usuarios para incluso en un futuro empezar a vender (o al menos, gestionar la venta por comisiones) de todo tipo de productos y servicios. Y como si fuera poco, todo esto alertará al mundo empresarial a ser mucho más proactivo en promocionar su presencia en Facebook, lo que creará un círculo vicioso que sin duda moverá mucha publicidad que hoy día va a los bolsillos de otras empresas, hacia Facebook... Como ya dije, esto es algo grande. Sin duda alguna uno de los anuncios más importantes de Facebook en tiempos recientes. Ahora, recuerden mi predicción #1 para este año 2013... Video 1 a continuación (enlace YouTube)... Video 2 a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, enero 9, 2013

|

En nuestras vidas cuando dos personas se tienen que poner de acuerdo es un proceso más sencillo que si 4 o 5 personas tienen que ponerse de acuerdo, y muchísimo más sencillo en relación a 100 personas ponerse de acuerdo, y cuando hablamos de millones de personas tenemos que recurrir a todo tipo de complejos esquemas para ponernos de acuerdo (que lamentablemente usualmente involucran a políticos). En nuestras vidas cuando dos personas se tienen que poner de acuerdo es un proceso más sencillo que si 4 o 5 personas tienen que ponerse de acuerdo, y muchísimo más sencillo en relación a 100 personas ponerse de acuerdo, y cuando hablamos de millones de personas tenemos que recurrir a todo tipo de complejos esquemas para ponernos de acuerdo (que lamentablemente usualmente involucran a políticos).Pues un problema similar está empezando a afectar a las supercomputadoras más potentes del mundo… Sucede que estas supercomputadoras deben su poder al hecho de que son altamente paralelizadas. Es decir, decenas de miles (o incluso, cientos de miles) de procesadores trabajan en conjunto para realizar una tarea en particular. Pero eso representa un gran problema en confiabilidad, y para entender por qué, volvamos al ejemplo de las dos personas que tratan de ponerse de acuerdo: ¿Cuáles son las probabilidades de que una de esas dos personas se enferme el día de hoy y no puedan ponerse de acuerdo a tiempo para firmar un contrato? Pues bajas. Pero, ¿cuáles son las probabilidades que entre 100,000 personas que tengan que ponerse de acuerdo, al menos una de ellas se enferme? Pues muy altas, y ese es precisamente el problema al que se enfrentan estas máquinas… Sucede que las arquitecturas tradicionales de hoy día son bastante rígidas, en donde si un componente falla, todo el sistema falla. Noten que por décadas han existido estrategias y técnicas que ayudan a minimizar esos problemas, una de esas técnicas siendo la de crear redundancia (por ejemplo, duplicando la cantidad de procesadores, y teniendo discos duros que replican los datos de otros discos duros), pero eso de por sí es un problema, ya que así como tuvimos que recurrir a políticos y sistemas de votaciones complejos para que millones de personas se pongan de acuerdo, así mismo tenemos que recurrir a otros sistemas en estas máquinas que se encargan ahora de monitorear y arreglar los otros componentes. Pero eso solo funciona hasta cierto límite. Según estudios, cuando empecemos a crear sistemas con millones de procesadores, la resistencia (y correspondiente complejidad) de estos sistemas tendrá que aumentar unas 100 veces más por sobre los sistemas tradicionales para mantener el mismo tiempo promedio hasta el próximo fallo (lo que en la industria se denomina el MTBF por sus siglas en inglés de Mean Time Between Failures). En otras palabras, mientras más procesadores añadimos, más tenemos que invertir para mantener el sistema funcionando, llegando un punto en donde vamos a gastar más recursos en tan solo tratar de evitar fallos, que en hacer que el sistema funcione en sí. Por tanto, se está haciendo obvio que nuestros sistemas informáticos están llegando a un cierto límite en donde vamos a tener que sencillamente aceptar la posibilidad de que algunas cosas no van a funcionar bien. Y eso es precisamente lo que hace la naturaleza con nuestros cerebros. Estos no funcionan perfectamente, pero funcionan suficientemente bien. Es por eso que un cerebro humano consume menos que una bombilla de 10W, y puede hacer cosas que una supercomputadora no puede hacer consumiendo varios megavatios. La buena noticia es que ya se están haciendo investigaciones en varios laboratorios del mundo para lograr precisamente eso: Sistemas computacionales “probabilísticos” que son resistentes a fallos, y que asumen que algunos componentes van a fallar. Nota: Si les interesó este tema, recomiendo también leer este otro artículo clásico de eliax de hace 4 años atrás. autor: josé elías |

|

|

|

|

|

lunes, enero 7, 2013

|

Google recientemente hizo un anuncio un tanto curioso con Ingress, un videojuego que utiliza Realidad Aumentada para que (al menos en teoría) millones de usuarios entren y compartan juegos en un mundo que combina el físico con el virtual. Google recientemente hizo un anuncio un tanto curioso con Ingress, un videojuego que utiliza Realidad Aumentada para que (al menos en teoría) millones de usuarios entren y compartan juegos en un mundo que combina el físico con el virtual.La premisa de Ingres es bastante sencilla: Varios puntos geográficos de la vida real (por ejemplo, algún punto popular en tu localidad) son más que monumentos, pues son pistas de un rompecabezas muchísimo más grande, cuyo desenlace solo Google sabe, pero que sin duda nos hace recordar programas de TV como Lost (Perdidos). En estos puntos encontrarás portales, y tu misión es apoderarte de estos portales, a través de armas, y técnicas de hackers. Al conquistar portales obtienes también energía, lo cual te permite hacer otras cosas posteriores en el juego. Al inicio del juego sin embargo debes elegir si serás parte de los Enlightened (Iluminados) o del Resistance (La Resistencia), en donde los primeros quieren proteger y alentar el uso de una nueva fuente de energía, mientras que los segundos no desean contaminar la humanidad con semejante peligro. Lo que hace el juego divertido (y adictivo) sin embargo es el hecho de que tienes que salir físicamente a la calle con tu celular Android para jugar el juego. Sobre la pantalla de este verás un mapa con tu posición, así como la posición de los portales que debes conquistar en tu cercanía y otros datos de importancia para completar la misión a mano. Durante tus misiones, otros pueden atacarte, o incluso reconquistar un portal ya previamente conquistado por tu bando, lo que hace que el juego se torne bastante interesante. Sin embargo, como ya he explicado antes, Google es una empresa de publicidad, y esta medida debe verse como tal, y no como Google querer entrar en el negocio de los videojuegos… Así que tomando eso en consideración, ¿qué podemos deducir sobre Ingress? Pues en mi opinión lo puedo resumir en los siguientes tres puntos: 1. Ingress no es tanto un juego, sino una plataforma conceptual para Google experimentar con publicidad más allá de la tradicional en formato impreso en navegadores web o celulares móviles. 2. Ingress es una manera de ver cómo reaccionan las personas ante situaciones que induzcan a mover físicamente a estos. Con esto Google por ejemplo puede crear misiones que lleven a los consumidores a visitar anunciantes específicos en tiendas físicas, lo que es una potentísima arma publicitaria para cualquier empresa que pueda lograr tal cosa. Este es el corazón de Ingress. 3. Ingress es además una aplicación conceptual que en un futuro se adaptaría a las gafas inteligentes de Google (Google Glass), y por tanto sirve desde ahora como un campo de juego y experimentación para una futura generación de aplicaciones de Realidad Aumentada. Así que ahí lo tienen. En mi opinión, con este “tonto” juego de Google, lo que estamos presenciando es nada más ni nada menos que un vistazo al futuro de la publicidad… Página oficial de Ingress Más información sobre la historia detrás del juego Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, enero 6, 2013

|

Primero fue Google con sus gafas inteligentes a las que bautizó como Google Glass, y poco después Apple empezó a llenar patentes de sistemas similares al Google Glass, y ahora le ha tocado el turno a Microsoft de también llenar sus propias patentes… Primero fue Google con sus gafas inteligentes a las que bautizó como Google Glass, y poco después Apple empezó a llenar patentes de sistemas similares al Google Glass, y ahora le ha tocado el turno a Microsoft de también llenar sus propias patentes…En el caso de Microsoft y una nueva patente en específico, detallan un sistema bajo el cual será posible utilizar unas gafas inteligentes para sobre-imponer información de Realidad Aumentada sobre eventos en vivo (citan específicamente a eventos deportivos). Así que por ejemplo si estás en un estadio de baseball, podrías ver flotando sobre el cuerpo del lanzador un cuadro con todo su historial estadístico, o quizás la velocidad de la bola que acaba de lanzar. Similarmente, si estás en un juego de fútbol podrías ver las estadísticas del portero con solo mirar hacia este, e incluso quizás podrías ver la dirección más probable en que este saltará basado en datos anteriores. Sin embargo, lo importante de todo esto es que todos los grandes de la industria ya están pensando sobre lo que podría ser la próxima ola de innovación más allá de celulares inteligentes y tabletas, y aunque nadie sabe si las personas se interesarán en tener este tipo de gafas todo el día, yo pienso que tarde o temprano esa será la tendencia, y así como hubo en tiempo en donde muchos no se imaginaban andar con un celular todo el tiempo con nosotros, así mismo llegará el momento en donde no nos podremos imaginar haber vivido sin gafas o lentes de contacto biónicos para dotarnos de información constante sobre todo el mundo que nos rodea… autor: josé elías |

|

|

|

|

|

miércoles, enero 2, 2013

|

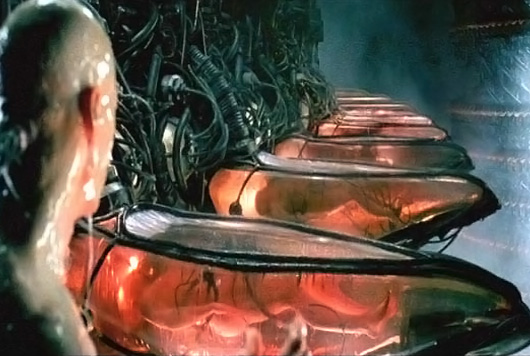

Científicos de la Universidad de Cornell en EEUU recientemente realizaron un experimento en donde lograron generar tejidos endometriales para que crecieran en un útero artificial, y al implantarle un embrión de ratón, este empezó a crecer saludablemente. Científicos de la Universidad de Cornell en EEUU recientemente realizaron un experimento en donde lograron generar tejidos endometriales para que crecieran en un útero artificial, y al implantarle un embrión de ratón, este empezó a crecer saludablemente.En otras palabras, este fue el prototipo del primer útero artificial, y según sus diseñadores, vamos a poder “cosechar” animales enteros desde cero dentro de estos úteros artificiales para finales de esta década, y humanos para finales de la siguiente.  No se ustedes, pero esto me recordó bastante esa escena de la película The Matrix en donde Neo despierta en medio de una cosecha de humanos en úteros artificiales… No se ustedes, pero esto me recordó bastante esa escena de la película The Matrix en donde Neo despierta en medio de una cosecha de humanos en úteros artificiales…Obviamente, esto traerá consigo un fuerte debate ético entre los que naturalmente se opondrán a la técnica (generalmente por motivos religiosos o morales, dependiendo de cómo y donde hayan sido criados), y los que la apoyarán (generalmente por motivos médicos, al menos inicialmente). Sin embargo, al menos yo pienso que independientemente de si estamos o no de acuerdo con esto, que esta tecnología la veremos tarde o temprano con humanos, pues son muchos los beneficios que esto traería, principalmente a parejas infértiles que estarían dispuestas a pagar cualquier precio para engendrar un hijo. Según los proponentes de estos métodos, un útero artificial, aun suene algo extraño (y para algunos, hasta “inhumano”), es en realidad un ambiente muchísimo más amigable, saludable, cómodo y controlable que un útero natural, el cual aun haciendo por lo general un buen trabajo, es también un ambiente que se puede tornar bastante hostil para un bebé, ya que este depende exclusivamente del bienestar de la madre para sobrevivir. Eso significa que una madre enferma (o en el peor caso, adicta a drogas), o que lleve una mala nutrición, o que sufra un accidente, puede ocasionar daños irreparables en estos bebés, en casos que vemos por miles a diario con niños que nacen con todo tipo de anomalías. Mientras (continúan diciendo los que apoyan esto), en un útero artificial se le podría dar el ambiente perfecto al bebé, desde una temperatura agradable, hasta una alimentación óptima. Incluso, no es de sorprendernos que muchas madres perfectamente saludables preferirán de todas maneras en un futuro tener un bebé en uno de estos ambientes sintéticos, pues de esa manera garantizan un bebé sano, pero sin todo lo que conlleva tener un bebé en el vientre por 9 meses, cosa que especialmente para mujeres en altos rangos del mundo empresarial puede ser algo bastante limitante para su vida profesional. Tampoco debemos perder de vista la posibilidad de nosotros incluso almacenar nuestros espermas y óvulos (o sencillamente, ADN) a temprana edad cuando estamos en condición física óptima, para posteriormente en una edad más madura tener hijos cómodamente. Neo. La Matrix te tiene… autor: josé elías |

|

|

|

|

|

lunes, diciembre 31, 2012

|

|

Ya que es el último día del año, me gusta ver con optimismo nuestro futuro, y algo que será parte intrínseca de nuestro futuro será la Realidad Aumentada, ¿y qué mejor manera de explicar el potencial de esta tecnología que con un video del mago-geek Marco Tempest?

Y lo asombroso (para los que no estén al tanto de esta tecnología) es que Marco realmente hizo todo lo que ven en el video, en vivo, por lo que la tecnología existe, solo que en etapa de prototipo y a precios todavía relativamente altos. Noten que esta es la idea detrás de tecnologías como Google Glass, y de mi fantaseado IrixPhone (o si quieren irse más lejos en el futuro, el NeuroPhone). Finalmente, si quieren ver un video de lo lejos que esto llegará al mediano plazo, no dejen de ver este otro... ¡Gracias al lector Marcelo Flix Diaz por el enlace! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

|

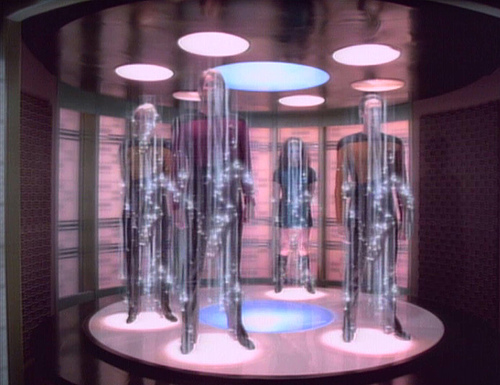

Todo aquel que haya aunque sea de modo casual visto la serie Star Trek (Viaje a las Estrellas) de seguro que ha visto esas escenas en donde humanos suben a una plataforma y son literalmente teletransportados a la superficie de planetas u otros lugares cercanos. Todo aquel que haya aunque sea de modo casual visto la serie Star Trek (Viaje a las Estrellas) de seguro que ha visto esas escenas en donde humanos suben a una plataforma y son literalmente teletransportados a la superficie de planetas u otros lugares cercanos.Pues eso está ahora un poquitito más cerca de hacerse realidad… Según reporta el MIT Technology Review, un grupo de científicos liderados por Xiao-Hui Bao, de la Universidad de Ciencia y Tecnología de China, en Hefei, acaban de demostrar por primera vez la teletransportación desde un objeto macroscópico a otro objeto macroscópico, y lo lograron a través de una distancia de 150 metros, sin pasar por el medio de los dos extremos. Notemos que la teletransportación en sí no es algo nuevo, pues IBM lo ha estado haciendo desde finales de la década de los 1990s, pero por lo general se teletransportaban objetos a nivel cuánticos (como un átomo, fotón o electrón a la vez), pero esta es la primera vez que todo un conjunto de ellos (formando un objeto macroscópico) han sido teletransportado juntos. Uno de los retos aun pendientes es el poder incrementar significativamente el tiempo que los átomos duran “entrelazados” entre sí en la fuente y el destino, para de esa manera teletransportar la información que los representa, pues por el momento el estado cuántico solo soporta operaciones de no más de 100 microsegundos. Sin embargo, los investigadores de este adelanto se muestran confiados en que no son retos que no se puedan lograr. Finalmente, noten que por el momento la idea no es arruinarles el negocio a American Airlines o FedEx, pues faltan muchos, muuuchos años, antes de que se pueda teletransportar incluso un mosquito, pero por ahora se tiene un objetivo muchísimo más modesto: El poder transportar datos cuánticos a la velocidad de la luz en una nueva generación de routers cuánticos que podrían revolucionar la forma en que nos comunicamos por Internet. fuente autor: josé elías |

|

|

|

|

|

domingo, diciembre 30, 2012

|

Hoy día estamos viviendo la transición desde discos duros tradicionales (es decir, esos que utilizan un disco que gira físicamente como si de un disco compacto se tratara), hacia los SSD (Almacenamiento en Estado Sólido, como lo utilizado dentro de un iPad), que en esencia son memorias “Flash” con tecnología NAND (el tipo de “celda” que almacena esos ceros y unos de nuestros datos binarios). Hoy día estamos viviendo la transición desde discos duros tradicionales (es decir, esos que utilizan un disco que gira físicamente como si de un disco compacto se tratara), hacia los SSD (Almacenamiento en Estado Sólido, como lo utilizado dentro de un iPad), que en esencia son memorias “Flash” con tecnología NAND (el tipo de “celda” que almacena esos ceros y unos de nuestros datos binarios).La transición se está dando paulatinamente debido a dos factores: Los SSD ya están bajando de precio (ya cuestan menos de US$1 dólar por GB), y son muchísimo más rápidos que discos duros tradicionales (hablamos en el orden de 10 a 30 veces más rápidos). Pero como siempre, los humanos nos adaptamos rápidamente a la tecnología, y cuando tenemos que copiar esos cientos de GigaBytes de canciones y películas Y ahí entra la empresa Everspin, que recientemente sacó al mercado el primer módulo de una nueva generación de memorias MRAM (“RAM Magnetoresistivo”), que ofrece una latencia tan baja, que en la práctica es literalmente 500 veces más rápido que la memoria Flash tradicional de los SSDs. Pero (siempre tiene que haber un pero), hay un par de ligeros grandes problemas… El primero es el costo, el cual es unas 50 veces más caro que las memorias Flash tradicionales, y el segundo es la densidad (unas mil veces menos densas que memorias actuales). Hoy día por ejemplo el módulo que sacaron al mercado (obviamente para mercados muy especializados, pues para consumidores aun faltan varios años) es un módulo de apenas 64Megabits (es decir, 8MB) y a un precio que ni sabemos (aunque si nos informan que es 50 veces más caro por GigaByte que Flash tradicional, podrán hacer el cálculo). Pero como soñar no cuesta nada, notemos que si esta tecnología se perfecciona en los próximos años, eso significaría que mi SSD que obtiene una velocidad de lectura de 512MB/s (y 256MB/s de escritura), podría obtener una velocidad de 250GB/s en lectura y 125GB/s en escritura. O en otras palabras, que podríamos copiar el equivalente a unos 50 discos compactos, en un solo segundo… autor: josé elías |

|

|

|

|

|

lunes, diciembre 17, 2012

|

Esta noticia es verdaderamente un regalo de navidad para toda la humanidad, y una pista del futuro que nos espera... Esta noticia es verdaderamente un regalo de navidad para toda la humanidad, y una pista del futuro que nos espera...Jan Scheuermann, una mujer de 52 años totalmente paralizada desde el cuello hacia abajo, acaba de recuperar parte de su independencia al poder controlar totalmente con su mente un brazo robótico El brazo robótico, de apariencia humana, lo puede mover de forma bastante natural (como podrán ver en el video acá abajo), y sin duda que representa un gran avance en este tipo de casos médicos. Noten que esta tecnología ha estado disponible por años (vean por ejemplo este asombroso video de un hombre que perdió ambos brazos y controla un brazo robótico), pero esta es quizás la primera vez que una persona totalmente paralítica puede controlar un brazo robótico con tanta naturalidad. Este adelanto ocurrió en la Universidad de Pittsburgh en los EEUU, y la paciente requirió de solo 13 semanas de entrenamiento para lograr controlar el brazo como si fuera el suyo. El brazo es controlado por un implante en la corteza motriz del cerebro humano, utilizando unos microelectrodos que proveen 96 canales de monitoreo de las señales del cerebro hasta un software especializado que descodifica las intensiones del cerebro para generar acciones motoras. publicación científica fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, diciembre 16, 2012

|

Hay unos cuantos robots que se han creado a través de los años, algunos bastante parecidos a humanos, pero solo en apariencia exterior. Pero este robot del cual les muestro un video tiene la particularidad que su interior está modelado literalmente en la fisionomía de un ser humano, tanto en la forma en que funcionan sus músculos como su esqueleto, y como verán en el video los resultados son bastante intrigantes, recordándonos esto mucho a los robots de Terminator... Hay unos cuantos robots que se han creado a través de los años, algunos bastante parecidos a humanos, pero solo en apariencia exterior. Pero este robot del cual les muestro un video tiene la particularidad que su interior está modelado literalmente en la fisionomía de un ser humano, tanto en la forma en que funcionan sus músculos como su esqueleto, y como verán en el video los resultados son bastante intrigantes, recordándonos esto mucho a los robots de Terminator...Y si este video los impresionó, no dejen de ver este otro del robot PETMAN que camina de forma casi idéntica a un ser humano. Y si continúan curiosos, tampoco dejen de ver este otro de un robot que maniobra entre escombros como los seres humanos. página oficial del proyecto fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, diciembre 15, 2012

|

|

Primero, empecemos notando algo: ¿Alguna vez se han acercado a ver realmente de cerca una pantalla de un televisor LCD/LED o Plasma? Notarán que la pantalla está compuesta de pequeños puntos a los cuales técnicamente se les llama "pixeles" (más específicamente, un pixel por lo general está compuesto de tres sub-elementos de color rojo, verde y azul, y entre los tres forman un pixel). Pues así como los televisores están compuestos de pixeles, así mismo son las fotos digitales que tomamos con nuestras cámaras, en donde millones de pixeles describen una imagen. Y si extendemos esto a video, podemos decir que video no es más que miles de fotografías digitales, una detrás de la otra, compuestas por pixeles. Así que podemos resumir diciendo que por lo general las imágenes digitales que almacenamos, transmitimos y vemos hoy día (y en particular, imágenes de video como nos interesa en este artículo de hoy), están esencialmente compuestas por millones y millones de pixeles. Sin embargo, esta no es quizás la mejor forma de describir imágenes, debido a que literalmente hay que procesar todos y cado uno de esos pixeles cada vez que tomamos una foto o grabamos o desplegamos un video. Pero, por décadas siempre ha existido una alternativa a los "gráficos pixelados" como es de lo que les he estado hablando hasta ahora, y esa alternativa se llama "gráficos vectoriales", que como indica el nombre, utiliza vectores en vez de pixeles para describir gráficos. Gráficos vectoriales han sido utilizados en sistemas electrónicos desde los mismos inicios de la computación, y quizás predatan las imágenes pixeladas, particularmente debido a que las gráficas vectoriales (por motivos que van más allá de este artículo) eran más amigables a entornos de computadoras analógicas de antaño que a computadoras modernas digitales. Incluso, el primer videojuego utilizó gráficos vectoriales y no pixelados. Pero, ¿qué son gráficos vectoriales? Pues es una técnica que en vez de especificar punto por punto (es decir, pixel por pixel) cómo se compone una imagen, lo que hace es especificar formas geométricas con lineas, curvas y polígonos (si utilizan programas como AutoCad y Adobe Illustrator en esencia ya trabajan con gráficos vectoriales). Es decir, en un sistema pixelado, si quiero dibujar un círculo, tengo que ir y especificar cada punto de la pantalla en donde se deben "pintar" pixeles para que entre todos den la impresión de un círculo, lo que implicaría posiblemente tener que especificar entre cientos a hasta miles o millones de puntos por separado. Pero en un sistema de gráficos vectoriales sería tan sencillo como simplemente almacenar todo eso en una ecuación o fórmula que especifique un círculo, algo así como la fórmula (x-a)2 + (y-b)2 = r2. En otras palabras, en vez de almacenar en un archivo millones de coordenadas de pixeles, lo único que tendríamos que hacer en un archivo vectorial es almacenar esa sencilla fórmula y listo. Eso implica unas cuantas cosas interesantes: La primera es que por lo general gráficos vectoriales ocupan mucho menos espacio de almacenamiento, lo que de paso implica que los archivos se pueden descargar mucho más rápidamente por Internet. De paso, esto también implica que es más eficiente procesar estos archivos para desplegarlos, lo que los hace ideal para ambientes móviles de baja potencia, lo que de paso también significa que el procesador móvil trabaja menos lo que implica adicionalmente un menor consumo en la batería. Y como si fuera poco, un sistema vectorial nos dota de independencia del tamaño y resolución de la pantalla final, lo que significa que podemos siempre tomar ventaja de la más alta resolución disponible para desplegar la mejor imagen posible. En nuestro ejemplo con el círculo por ejemplo, en un sistema pixelado hay que especificar necesariamente de antemano la resolución en pixeles bajo la cual se desea dibujar el círculo, y de ahí en adelante la resolución se mantiene fija, pero un círculo se puede dibujar en cualquier resolución, ya que los pixeles finales de la imagen son deducidos en base a la fórmula matemática de los vectores especificados en ecuaciones. Pero, si tenemos tantas ventajas con gráficos vectoriales, ¿por qué no son el formato preferido hoy día y seguimos utilizando pixeles? Pues la respuesta por un lado es que en realidad los gráficos vectoriales ya se utilizan en millones de ambientes que uno rara vez nota, particularmente en videojuegos y en programas de diseño gráfico, pero el problema es que en fotografías y videos hasta hora no era eficiente almacenar imágenes como vectores, por la sencilla razón de que una imagen cualquier no es muy uniforme visualmente entre un pixel y otro, y se requeriría o (1) de tener que almacenar un vector por pixel (que en realidad no ofrecería ninguna ventaja sobre sistemas pixelados, y al contrario, introduciría todo tipo de desventajas), o (2) de tener que hacer unos cálculos inmensamente complejos para deducir el patrón vectorial a partir de las imágenes originales. Así que habiendo dicho todo eso, llegamos a la noticia de hoy... Un grupo de científicos de la Universidad de Bath ha logrado crear una técnica que permite aplicar procesamiento vectorial de forma eficiente y práctica (pues antes se habían creado sistemas similares pero que no eran eficientes y/o prácticos) para video. Según sus inventores, su tecnología funciona tan bien que ya quieren incorporarla en todo tipo de programas profesionales a todo nivel de la cadena de producción de video. Esto es una tremenda noticia porque significa que gran parte de las ventajas que ya mencioné sobre vectores, nos llegarán a mediano plazo a consumidores, lo que de paso significará que podamos reproducir el mismo archivo de video de manera óptima y con la mejor calidad posible tanto en un celular de pequeña pantalla, como en televisores futuros con resoluciones de 8K para consumidores, sin necesidad de reprocesar o convertir el video original. Sería como comprar un DVD una sola vez, y después poder reproducir ese "DVD" tanto en un televisor de 1080p hoy día, como en uno de 4K o 8K mañana, y en todo momento con el más óptimo detalle de la imagen (asumiendo que la fuente de la imagen tenga el suficiente detalle, obviamente). Esta noticia a propósito llega justo días antes de un artículo que tenía planeado sobre la necesidad de definir un CODEC (codificador-descodificador) independiente de resolución de video, por lo que con esta noticia no solo me evité escribir ese artículo, sino alegrarme al ver que esto llegará a consumidores mucho antes de lo que muchos imaginábamos... :) enlace a un video de demostración (formato Quicktime - quizás quieran salvarlo antes de verlo, y noten que es un video pre-grabado en formato pixelado, ya que no existe un reproductor para ver el video original en formato vectorial) página oficial del proyecto fuente oficial Actualización: Video en formato YouTube a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, diciembre 13, 2012

|

Todas nuestras tecnologías inalámbricas, sin excepción, desde las que permiten que hablemos por celulares o nos conectemos al Internet por WiFi, y desde las ondas que penetran nuestro cuerpos, hasta los auriculares Bluetooth que se utilizan en los celulares de hoy día, utilizan de alguna forma u otra distintos tipos de ondas electromagnéticas. Todas nuestras tecnologías inalámbricas, sin excepción, desde las que permiten que hablemos por celulares o nos conectemos al Internet por WiFi, y desde las ondas que penetran nuestro cuerpos, hasta los auriculares Bluetooth que se utilizan en los celulares de hoy día, utilizan de alguna forma u otra distintos tipos de ondas electromagnéticas.Esas ondas, obviamente, son invisibles a ojos humanos, pero son una de las cosas más importantes de nuestra ciencia y tecnología. Estas ondas vienen en distintos "tamaños", desde "ondas cortas" hasta "ondas largas", y una forma de imaginarlo es una cuerda que hacemos ondular, en donde si hacemos que esta ondule con curvas pequeñas podríamos decir que son ondas cortas, y si hablamos de ondulaciones largas, pues ondas largas... Sin embargo, un tipo de ondas han sido notoriamente difíciles de domar, las llamadas ondas "TeraHertz", que son ondas ultra-cortas que vibran billones de ciclos por segundo, y si podemos domar ese tipo de ondas, toda una nueva generación de nuevas tecnologías serán posibles, y eso precisamente es lo que han logrado un grupo de investigadores del California Institute of Technology (CalTech). Estas ondas ya teníamos tiempos que las generábamos, pero con equipos bastante grandes, pesados y costosos, y lo que este equipo de CalTech ha logrado es miniaturizar la tecnología al tamaño de un microchip varias veces más pequeño que la uña de tu dedo meñique. Esto abre entonces la puerta a toda una nueva generación de posibles aplicaciones que van desde mejores equipos para ver mejor dentro del cuerpo humano en 3D y a muy bajo costo, hasta dispositivos del tamaño de celulares que nos permitirán ver cosas tras paredes de concreto armado. Así mismo esto haría posible nuevos equipos de revisión de seguridad en aeropuertos que nos harían el pasar por tales lugares una experiencia más placentera, así como podría significa el nacimiento de nuevas tecnologías para nosotros interactuar con dispositivos electrónicos por medio de gestos, e incluso quizás nuevas formas de comunicarnos en forma ultra-rápida y con gran ancho de banda en dispositivos móviles. Y esto, a propósito, es uno de los componentes claves del Sensorix. Nota: En la imagen que acompaña el artículo, lo microchips son los 4 pequeños cuadritos marrones entre el logo de CalTech y la moneda de un centavo de los EEUU. fuente autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2026 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax