Tecnología Visual

|

martes, noviembre 19, 2013

|

Según reportes (por confirmar), Apple acaba de comprar la empresa PrimeSense por US$345 Millones de dólares. Según reportes (por confirmar), Apple acaba de comprar la empresa PrimeSense por US$345 Millones de dólares.Si el nombre PrimeSense les suena familiar, es porque esta es la misma empresa que desarrolló la tecnología original del Kinect para el Xbox 360 de Microsoft, un área en donde PrimeSense no ha dejado de investigar y desarrollar, recientemente logrando miniaturizar su tecnología a tamaños amigables a tabletas o incluso celulares. Con esta empresa, Apple tiene acceso a tecnología que le permite interactuar con dispositivos electrónicos con simples gestos "en el aire", lo que complementaría bastante bien a Siri en futuros proyectos de Apple (como quizás, el rumoreado televisor, o al menos una versión futura de la cajita AppleTV). De paso, esto garantiza que Apple obtenga las patentes de PrimeSense sobre esta tecnología, esencialmente evitando que otros utilicen lo desarrollado por PrimeSense, forzándolos a inventar otros métodos (ojo, que esto no deberá afectar al Kinect de Microsoft, que de seguro ya tenía un buen acuerdo con PrimeSense antes de la empresa ser comprada). Y si quieren tener una buena idea de lo que es capaz esta tecnología, solo vean el video que les dejo más abajo acá mismo en eliax... página oficial de PrimeSense Video a continuación (enlace YouTube)... Actualización del 25 de Noviembre 2013: Apple confirmó la compra el día de hoy, por US$360 Millones de dólares. autor: josé elías |

|

|

|

|

|

miércoles, noviembre 13, 2013

|

Hoy los dejo con lo que les aseguro será una de las tecnologías que más asombrados los dejará en tiempos recientes... Hoy los dejo con lo que les aseguro será una de las tecnologías que más asombrados los dejará en tiempos recientes...Se trata de la tecnología inFORM del Tangible Media Group del MIT, una tecnología que utiliza una "mesa dinámica" que se transforma en todo tipo de formas, en tiempo real, logrando este efecto gracias a centenares de actuadores debajo de la mesa que suben o bajan pequeños rectángulos semi-cúbicos. Entre los usos que esto tiene: Telepresencia parcial (como demostrado con la demostración de las manos en el video), visualización de gráficos 3D en el mundo físico (como por ejemplo, "tirar" una gráfica de barras 3D a la mesa), video-juegos, mercadeo de productos, etc. Esta es una de esas cosas que por más que trate de explicarles, no podrán apreciar lo suficientemente bien hasta que vean el video por ustedes mismos. No dejen de ver el video, quedarán anonadados. ¡Gracias al lector Luiggi por el enlace al video! Nota: A través de los años acá mismo en eliax les he presentado algunas otras tecnologías igual de sorprendentes a estas. He colocado algunas al final de este artículo en la sección de "previamente en eliax". página oficial del proyecto inFORM página oficial del Tangible Media Group en MIT Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, noviembre 2, 2013

|

¿Alguna vez soñaron con capturar video con una calidad bastante similar a lo que ves en lo mejor del cine de Hollywood? Pues lo crean o no, si están dispuestos a hacer algunos sacrificios técnicos, hoy día ya es posible ensamblar un sistema por menos de US$3,000 que te permitirá captar imágenes que hace apenas 10 años atrás te hubiese costado cuando menos un cuarto de millón de dólares. ¿Alguna vez soñaron con capturar video con una calidad bastante similar a lo que ves en lo mejor del cine de Hollywood? Pues lo crean o no, si están dispuestos a hacer algunos sacrificios técnicos, hoy día ya es posible ensamblar un sistema por menos de US$3,000 que te permitirá captar imágenes que hace apenas 10 años atrás te hubiese costado cuando menos un cuarto de millón de dólares.La fórmula mágica es la siguiente (al día de hoy, inicios de noviembre 2013): Cámara: Blackmagic Pocket Cinema Camera (BPCC), US$995 Adaptador de lente: Speed Booster, Nikon mount, US$429 Lente: Sigma 18-35mm F1.8, Nikon mount, US$799 Micrófono: Rode Videomic, US$149 Todo eso hace un total de US$2,372 dólares (más impuestos), lo que les deja todavía US$628 dólares para que cubran el tema de impuestos, envío, y se compren unas cuantas baterías adicionales, tarjetas de almacenamiento de video tipo SDXC, un simple juego de luces LED, y otros accesorios, para terminar con un equipo muy por debajo de los US$3,000 dólares. Pero, ¿qué tiene de particular este "kit", y por qué no uno basado en las populares cámaras fotográficas DSLR? Pues tiene que ver con un par de cosas muy importantes, la más importante siendo el concepto de Dynamic Range (o "Rango Dinámico")... Si alguna vez trataron de capturar video con una DSLR, en un lugar dentro de una habitación un poco oscura, pero en donde también se ve algo fuera de la habitación (digamos, un patio bien alumbrado con el Sol), notarán que al grabar te tienes que decir si capturar detalle en los lados oscuros (lo que conlleva a que los lados claros sean totalmente blancos y sin detalles), o capturar detalle de los lugares claros (con el resultado de que pierdes todo el detalle de los lugares oscuros y terminas con todo negro). Eso se debe a que por lo general, las cámaras DSLR tienen un Rango Dinámico muy limitado, en el sentido de que solo pueden capturar a la misma vez un rango limitado de distintos tipos de "brillantés" en la imagen. Es decir, un rango limitado de valores intermedios entre un extremo claro y otro oscuro. El resultado de eso, para empezar, es el típico video que uno "sabe" no fue grabado con equipo profesional, pues uno nota "algo" que rara vez puede decir qué es, pero por lo general es esto, pues al grabar con un Rango Dinámico limitado, eso conlleva a imágenes que son por lo general asociadas más a "cámaras de video" que a "cámaras de cine". Noten que con algunos hacks, particularmente en cámaras Canon, como el increíble Magic Lantern, es posible capturar video en modo RAW ("crudo") que ofrece un rango dinámico muy superior al video nativo que viene de fábrica, pero aun así, el costo de una cámara que ofrezca lo mejor de Magic Lantern en resolución nativa 1080p, y con el más alto rango dinámico posible, es muy superior a la BPCC. Hoy día por ejemplo lo que más se acerca con Magic Lantern a la calidad de la Blackmagic Pocket Cinema Camera es una Canon 5D Mark III, pero esa es una cámara que por sí sola (sin lentes) cuesta sobre los US$3,400 dólares. Y eso nos lleva al otro tema: Costo. El kit que les recomiendo está optimizado tanto para calidad del video como para costo, evidente en lo que mencioné en el párrafo anterior... La otra cosa es que esta cámara BPCC fue hecha exclusivamente para capturar video cinemático, capturando nativamente video RAW que puede ser editado directamente en populares programas de edición de video directamente, así como viene con una versión "light" del poderosísimo programa de colorizar películas de cine, DaVinci Resolve, que es otro de los trucos que diferencian a un video con un look casero, a otro con un look "cinemático". Y noten que la BPCC está optimizada para capturar video a 24fps (24 cuadros por segundo) que es el formato capturado en cámaras de cine. Es importante también entender que el video que sale "por defecto" de la BPCC a primera vista aparenta peor que el incluso algunas cámaras de video baratas de un par de cientos de dólares, pero eso es solo una apariencia. El video de la BPCC no está hecho para ser tomado tal cual sale de cámara, pues lo que obtienes es un video con un amplio rango dinámico (hablamos de 13-stops, para los expertos), que posteriormente debes procesar en DaVinci Resolve para "colorizar" el video y verdaderamente hacerlo relucir (y es en este punto en donde estarás con una sonrisa de oreja a oreja). Y se sorprenderán de lo que podrán hacer con el video RAW de la BPCC, ya que incluso video que aparentaba estar sobreexpuesto o subexpuesto, podrán corregir sin problemas en la mayoría de casos, permitiéndoles "sacar" detalles que a primera vista aparentaban no estar ahí. Por otro lado, es bueno notar que el sensor de la BPCC es bastante menor que el de una Canon 5D Mark III, por lo que uno pensaría que sería difícil, o incluso imposible, lograr efectos de campo difuso, en donde por ejemplo en una escena fuera posible enfocar en dos personas hablando mientras el fondo se pone difuso y fuera de foco, pero es ahí en donde entra el Speed Booster de Metabones, un accesorio que permite adaptar lentes de mayor tamaño a sensores más pequeños, pero permitiendo utilizar toda la superficie del lente, en vez de solo la parte central del lente, en esencia trayendo la mayor parte de los beneficios de un sensor de gran tamaño (incluyendo fondos difuros), a sensores como el de la BPCC. Y noten que de paso, debido a que el Speed Booster concentra más luz en un lugar más reducido, que este por defecto incrementa la apertura efectiva del lente en cuestión por al menos 1 f-stop, significando eso que un lente f1.8 en realidad se convierte en uno f1.4, lo que es genial e increíble. Es importante notar que el Speed Booster por el momento (a la fecha de escribir este artículo) solo tiene adaptadores desde la montura Nikon hasta la MFT (Micro Four-Thirds) que utiliza la BPCC, razón por la cual están atados a lentes con montura Nikon, pero en el momento que Metabones saque una versión Canon, la idea es la misma: Utilizar un Speed Booster en montura Canon con el mismo lente Sigma mencionado en su versión Canon. Por último, la última pieza del rompecabezas es el lente Sigma 18-35mm F1.8, el cual por el precio ha demostrado ser toda una joya para el cine digital, ofreciendo una imagen bien clara y nítida, y con un útil rango de zoom. En cuanto al micrófono Rode, lo agregué simplemente para completar todo el tema de audio-video, pero existen otras opciones. Y si quieren ver un ejemplo de video grabado con exactamente este kit (menos el micrófono), no dejen de visitar el enlace a continuación... artículo sobre este kit con video de muestra página oficial de la BPCC (no dejen de ver la sección, a mediados de la página, que dice "Wide Dynamic Range") Actualización del 12 de Noviembre del 2013: La BlackMagic Pocket Cinema Camera desde hoy permite grabar en 12bit Cinema DNG 1080p RAW. Por US$999 nada mal (fuente). autor: josé elías |

|

|

|

|

|

miércoles, octubre 30, 2013

|

La película Gravity, sin duda que independientemente de qué tanto haya gustado o no, será recordada como un hito en efectos especiales en el cine, y al menos que llegue otra película tan revolucionaria como Gravity en los próximos meses, esta ya tiene un Oscar impreso a los mejores efectos visuales y cinematográficos del año en las próximas premiaciones de la academia. La película Gravity, sin duda que independientemente de qué tanto haya gustado o no, será recordada como un hito en efectos especiales en el cine, y al menos que llegue otra película tan revolucionaria como Gravity en los próximos meses, esta ya tiene un Oscar impreso a los mejores efectos visuales y cinematográficos del año en las próximas premiaciones de la academia.Pero, ¿cómo lograron tales impresionantes efectos? Pues con una mezcla de mucho ingenio, paciencia, y mucha (muuuuucha) tecnología digital. Aunque no lo crean, salvo las pocas escenas en donde vemos a los astronautas fuera de sus trajes espaciales, prácticamente el 99% de la película fue realizada de forma digital y renderizada puramente en programas de diseño 3D. Para empezar, todas las escenas de exteriores en el espacio, incluyendo los cuerpos de los astronautas, fueron realizadas con los más avanzados programas de renderización, y eso incluye incluso las caras de los actores dentro de los cascos de astronauta en varias de las tomas. Uno de los retos más grandes que tuvieron fue, ¿cómo iluminar la cara de los astronautas conforme estos son iluminados por eventos externos, como por ejemplo cuando Sandra Bullock sale dando vueltas y por medio segundo es iluminada por la Tierra y por otro medio segundo más por el Sol, y otro instante más por la reflexión de las explosiones? Pues para esto crearon una caja, dentro de la cual sentaban a Sandra Bullock o George Cloonie, quienes permanecían totalmente quietos. El interior de la caja mientras tanto estaba cubierta de arriba a abajo y de lado a lado de miles de LEDs (pequeñas luces multicolores), las cuales podían encenderse y apagarse en cualquier orden y secuencia, conforme deberían ser iluminadas las caras de los actores en el mundo virtual de Gravity. Así que por ejemplo si una ráfaga de luz pasaba en pantalla de lado a lado por frente de uno de los actores, los LEDs se encendían y apagaban en secuencia de lado a lado simulando la iluminación correspondiente en la cara del actor. Esto fue un proceso extremadamente tedioso que en muchos casos hacía que Sandra permaneciera literalmente todo un día dentro de la caja, mientras se hacían ajustes, pruebas, etc. Para escenas de Sandra sin el traje, a esta le hicieron un sostenedor de cuerpo que se pegaba alrededor de todo su abdomen, en forma idéntica a su cuerpo y piel, de modo que no se notara, mientras esta era suspendida por cables. Para otras escenas, Sandra fue filmada en un estanque gigante de agua con pantalla verde de fondo, para después reemplazar todo el fondo por escenas virtuales (como en la escena final). Y en otro adelanto, se utilizó un novedoso sistema de captura de movimientos faciales que les permitió capturar todo lo que los actores hacían, hasta el más mínimo detalle, para entonces reproducirlo digitalmente en el mundo virtual de Gravity (vean el video que incluyo abajo, en donde los primeros 25 segundos es lo que una cámara tradicional ve, y después verán como lo ve el sistema de captura digital en 3D). Pero quizás lo más asombroso de todo es que aunque no lo crean, todo el poder de generar a Gravity lo tendremos en un dispositivo móvil quizás en dentro de una década, lo que les debe dar una idea del tipo de cine que cualquier persona con buena imaginación y talento podrá crear dentro de unos años... Mientras tanto, si no han visto la película, acá pueden leer mis impresiones eliax, y para ver muchos detalles técnicos de la realización de la película, no dejen de visitar los enlaces a continuación. excelentísimo artículo en FXGuide sobre cómo crearon a Gravity (lectura obligatoria para todo fan o profesional de efectos especiales) página oficial del sistema de captura facial utilizado en Gravity Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, octubre 4, 2013

|

Uno de los lugares más fascinantes en la Tierra para todo científico o amante de la ciencia sin duda debe ser el lugar en donde se encuentra el LHC (Large Hadron Collider o "Gran Colisionador Hadrones"), el instrumento científico más avanzado construido por la humanidad a la fecha, y tan grande que este cubre la frontera de dos países, Francia y Suiza. Uno de los lugares más fascinantes en la Tierra para todo científico o amante de la ciencia sin duda debe ser el lugar en donde se encuentra el LHC (Large Hadron Collider o "Gran Colisionador Hadrones"), el instrumento científico más avanzado construido por la humanidad a la fecha, y tan grande que este cubre la frontera de dos países, Francia y Suiza.Este colosal instrumento científico mide unos asombrosos 27km (17 millas) a la redonda, y está construído bajo tierra a una profundidad de hasta unos increíbles 175 metros (574 pies). En el 2006 yo mismo acá en eliax escribí un artículo declarando al LHC la creación más sublime de la humanidad hasta el momento en términos de máquinas (la otra siendo, el Internet). ¿Y qué hace este titán de máquina? Pues algo sumamente sencillo en realidad: El LHC tiene forma de un anillo hueco (conformado por aros de imanes) por dentro del cual se mueven todo tipo de partículas a velocidades cercanas a la de la luz en direcciones opuestas, con la finalidad de que estas choquen entre sí, liberando asombrosas cantidades de energía, y en el proceso decayendo a partículas más elementales, mientras forman unos patrones de movimiento en formas de arcos, círculos, líneas y espirales. Todo eso es estudiado y comparado a teorías matemáticas para entender y afinar nuestro entendimiento del universo (si quieren ver más detalles de su funcionamiento, consulten este video). Gracias al LHC ya hemos simulado un mini Big Bang, así como descubierto partículas que contribuyen a dotar de masa a nuestro universo (el famoso Higgs, lean sus implicaciones en nuestras vidas acá mismo en eliax). El LHC está actualmente siendo mejorado para aumentar aun más su poder, pero mientras tanto (y eso nos lleva al enlace de hoy) pueden visitarlo de forma virtual gracias a la herramienta Google Street View de Google Maps. Con esta herramienta, no solo podrán entrar a diversos puntos del LHC, sino que además mirar a 360 grados a la redonda (y/o 360 grados de arriba hacia abajo), así como "caminar" de un lado al otro de este monumental lugar. Así que disfruten el siguiente enlace, que creo además sería de gran utilidad compartirlo con estudiantes a todo nivel de educación. Nota personal: El día que deje de escribir regularmente en eliax (los rumores dicen que me faltan 189 artículos para llegar a los 10,000 que me puse de meta), un bello recuerdo que me llevaré será el día que 5 minutos antes de que se activara el LHC en el 2008, espontáneamente nos reunimos acá mismo en el blog un pequeño grupo de fans de la ciencia, para verlo todo en vivo en video por Internet. Ese día fue inolvidable, y pueden ver más o menos lo que sucedió acá en eliax ese día en este artículo y sus asociados comentarios. enlace directo al LHC en Google Street View autor: josé elías |

|

|

|

|

|

lunes, septiembre 30, 2013

|

|

Hoy los dejo con este impresionante video de un sistema al que llaman el STEM System de la empresa Sixense, que se trata de un software especializado que instalas en tu móvil, y que te permite utilizar su pantalla como una ventana a un mundo virtual paralelo al nuestro, en esencia funcionando como una "cámara virtual" dentro del mundo imaginario.

Esto tiene muchísimas aplicaciones que van desde servir como una cámara virtual para efectos especiales en el cine, hasta una nueva generación de videojeugos, o incluso para aplicaciones de museos, o entrenamiento en labores militares, médicas e industriales. Noten que el concepto detrás de esto no es nuevo (vean por ejemplo este otro sistema del cual les hablé acá mismo en eliax hace 3 años), pero lo que esto ofrece de nuevo es un alto nivel de precisión y un precio lo suficientemente bajo como para poder masificarse. El proyecto ya está siendo financiado vía Kickstarter, y si quieren ser de los primeros en utilizar esta tecnología diríjanse al enlace a continuación, y no dejen de ver el video que incluyo acá abajo que les dejará bastante claro el concepto detrás del prototipo que demuestra (el producto final no dependerá de una PC remota como explican en el video). Y si quieren ver la parte interesante del video directamente, salten al minuto con 30 segundos del video. página oficial del proyecto en Kickstarter Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, septiembre 25, 2013

|

Hoy los dejo con este asombroso video del grupo Bot & Dolly que después que les explique cómo funciona quizás lo aprecien aun más. Hoy los dejo con este asombroso video del grupo Bot & Dolly que después que les explique cómo funciona quizás lo aprecien aun más.El video se llama Box ("Caja"), y es en mi opinión lo que se podría clasificar como casi toda una nueva forma de arte, que apenas 50 años atrás pocos pudieron imaginar iba a ser posible en un futuro no lejano. Noten que absolutamente todo lo que verán en el video fue captado tal cual por la cámara que grabó el video. No hubo edición post-producción para agregar efectos especiales, lo que significa que lo que ven en el video es tal cual la audiencia lo ve en persona. Esta forma de arte combina varios elementos para crear algo nuevo. Combina la técnica de Projection Mapping de la cual ya les he mostrado varios videos en eliax a través de los años (ejemplo), así como robots de gran escala, junto con software especializado. Lo asombroso de esto es la sincronización necesaria para proyectar las imágenes en las dos superficies rectangulares que verán, pues si no se dieron cuenta, ese es el truco: Esas dos superficies blancas no son pantallas, sino simples planchas de cartón, y el gran reto fue sincronizar y mover un par de proyectores de video en conjunto con los movimientos de las planchas por las manos robóticas. Aparte de eso, entra en todo esto un buen conocimiento de software 3D, junto con corrección de perspectiva, para dar la ilusión de que vemos cosas en 3D, cuando en realidad es solo eso, una ilusión. No dejen de ver el video entero, pues está lleno de sorpresas visuales hasta el final. Y en nota relacionada, quiero agregar que como digo con frecuencias en mis charlas sobre La Singularidad Tecnológica, hasta las mismas artes experimentarán un crecimiento exponencial, diversificándose hacia ramas que nunca imaginamos, y este video de hoy es un excelente ejemplo de hacia donde podrían dirigirse las cosas (y solo imaginen lo que se podrá hacer en mundos virtuales, y combinando esto con Realidad Aumentada). página oficial del proyecto Box Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, septiembre 24, 2013

|

Como recordarán, el año pasado Disney compró a LucasFilm, y con la compra Disney se adueñó de la franquicia de Star Wars, y uno de los proyectos que inmediatamente cancelaron fue un juego en desarrollo al que llamaban tentativamente Star Wars 1313, y el video que verán a continuación fue una demostración técnica presentada en una conferencia, en donde demuestra hacia donde iban con el juego. Como recordarán, el año pasado Disney compró a LucasFilm, y con la compra Disney se adueñó de la franquicia de Star Wars, y uno de los proyectos que inmediatamente cancelaron fue un juego en desarrollo al que llamaban tentativamente Star Wars 1313, y el video que verán a continuación fue una demostración técnica presentada en una conferencia, en donde demuestra hacia donde iban con el juego.Como podrán apreciar, es verdaderamente asombroso lo que estaban logrando en tiempo real, y este bien podría haber sido el juego más realista a la fecha de Star Wars. Noten que el 100% de lo que ven dentro del juego está siendo generado en tiempo real y manipulado en tiempo real, tanto por los actores como los programadores. Noten incluso la parte en donde toman una tableta para controlar los efectos del clima en el mundo virtual. Sin embargo, algo me dice que aunque ese juego haya sido cancelado, que no tardaremos mucho en ver un juego como este, principalmente dado el poder del PlayStation 4 y Xbox One que nos llegan en estas navidades próximas... fuente ¡Gracias al lector Christian Hernandez por compartir el video en la comunidad oficial de eliax en Google+! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, septiembre 15, 2013

|

|

Hoy los dejo con una increíble tecnología demostrada en el evento Siggraph 2013, llamada 3-Sweep, que permite crear objetos tridimensionales basado en imágenes fotográficas de dos dimensiones.

Como verán, el tipo de 3D que esto puede generar es relativamente limitado, pero lo que hace, lo hace de una manera totalmente asombrosa. A este software solo hay que darle pistas visuales de los bordes de los objetos, así como de su orientación, y este automágicamente extrae el objeto 3D y posteriormente te permite manipularlo. No dejen de ver el video que explica visualmente bastante bien todo el proceso. Ahora solo falta que Adobe contrate los desarrolladores de esta herramienta y la haga disponible como una extensión a Photoshop... :) ¡Gracias al lector Carlos D. Correa por compartir el video en el grupo oficial de eliax en Facebook! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, septiembre 13, 2013

|

En el artículo de ayer acá en eliax sobre los increíbles efectos 3D de Jurassic Park 3D, el lector Gabriel Peña preguntó ¿cómo se convierten estas películas de 2D, a 3D? Y hoy respondo por acá ya que esto creo es de interés a muchas personas... En el artículo de ayer acá en eliax sobre los increíbles efectos 3D de Jurassic Park 3D, el lector Gabriel Peña preguntó ¿cómo se convierten estas películas de 2D, a 3D? Y hoy respondo por acá ya que esto creo es de interés a muchas personas...El convertir una película de 2D a 3D es literalmente y en todo el sentido de la palabra, un arte, y dependiendo de quienes hagan la conversión, y cómo lo hagan, los resultados variarán desde mediocres, hasta virtualmente indistinguibles de 3D real (como sucedió con Jurassic Park 3D, que recomiendo sin reservas que la vean en 3D en el cine). Pero, ¿cómo sucede esa magia? Pues esto conlleva varios pasos, que detallo a continuación... Lo primero es hacer "rotoscopía", y este es quizás el trabajo más arduo (y aburrido) del proceso, y conlleva el tomar todas y cada uno de los cuadros de la película, y aislar todos y cada uno de los elementos que se ven en pantalla. Para que tengan una idea, si una película dura 90 minutos, se necesita procesar por esta técnica 24 cuadros por segundo, y como cada minuto contiene 60 segundos, hablamos de 90 x 60 x 24 = 129,600. Es decir, hay que ir y manualmente demarcar todos los objetos que salen en pantalla en 129,000 cuadros distintos. Como referencia, en Jurassic Park 3D, se asignaron unos 700 especialistas para este fin, por lo que cada uno de ellos procesó unos 180 cuadros. ¿Y a qué nos referimos con aislar los objetos? Pues a dos cosas: En el caso de objetos relativamente planos (digamos, un cuadro en una pared visto de frente, o montañas en el horizonte), se dibuja cuidadosamente alrededor de tales objetos, y se les asigna un identificador. Y para casos de objetos que están "en 3D" (como la superficie de una mesa, o una larga carretera), es necesario crear una figura geométrica en 3D y después superimponer esa imagen encima de la real, para darle una idea a los procesos que siguen de "la inclinación en 3D" de ese objeto en pantalla. Y cuando se trata de objetos más complejos, como la cara y cuerpo de una persona, eso conlleva más detalles aún. Así que por ejemplo en una conversión barata, los encargados de la conversión solo dibujarían alrededor del cuerpo de la persona, y esta aparentaría en "3D" como una cartulina en 2D flotando sobre un fondo en 3D, pero en una conversión de calidad se "mapearía" la forma geométrica de la persona, a un detalle tal que hasta la nariz, ojos, cabellos, pedazos de tela de la ropa, y todo detalle mínimo, es modelado como un "mapa 3D" encima de la persona, como lo hicieron con Jurassic Park 3D. Después de esto el próximo paso es tomar los cientos de miles de elementos demarcados, y asignarles "profundidad". En el producto final, la profundidad se expresa en la imagen como una diferencia (de izquierda a derecha) de la imagen repetida en pantalla (cuya separación desaparece al ponernos las gafas 3D, pues esta separa cada imagen para un ojo distinto). Mientras más separadas las imágenes, más pronunciado el efecto 3D dentro y fuera de pantalla. Esto es algo que requiere de mucho buen juicio visual, y de experimentación, y es un proceso iterativo. Y cabe aclarar que obviamente en este paso se utilizan programas informáticos dedicados para tal fin. Hasta ahora, tenemos ahora todos los elementos de la imagen separados, y ahora con efectos de profundidad, pero falta algo muy importante, y para explicarlo quiero que pongan el dedo índice de una de sus manos frente a sus ojos a la distancia más cercana que puedan aguantar con sus ojos enfocados, y que miren al dedo detenidamente. Ahora, cierren el ojo izquierdo y dejen el derecho abierto, y miren el dedo por un par de segundos. Y después, cierren el ojo derecho y abran el izquierdo, y noten la diferencia... Como notarán, el dedo se ve distinto desde cada ojo. El ojo izquierdo ve cosas que el derecho no ve, y viceversa, y eso se debe al ángulo de visión desde donde se ve el dedo desde cada ojo. Pues en una película 2D, obviamente solo se capturó uno de esos dos ángulos necesarios para completar una imagen 3D, por lo que en esta etapa del proceso de conversión, aunque todo aparenta en 3D, en realidad se notarán sombras oscuras alrededor de todos los objetos. Esas sombras representan espacios que deben ser rellenados por artistas digitales manualmente. En el caso de tu dedo, si ves la uña de tu dedo con uno de tus ojos, pero con el otro ojo solo ves parte de la uña, eso significa que en la conversión a 3D el próximo año es "inventarse" el pedazo de la uña que la cámara originalmente no capturó, y pintarla digitalmente. Y sí, eso hay que hacerlo unas 129,600 veces, por cada objeto en pantalla, y les recuerdo que pueden haber decenas, o incluso cientos de objetos en pantalla a la vez, como en el caso de lluvia y árboles, los cuales deben ser aislados uno por uno, manualmente (ya les dije que este es un proceso realmente laborioso). Al final de todo este proceso, cuando se aíslan los objetos, se les asigna profundidad, y se rellenan los espacios vacíos, terminamos con una conversión en 3D y solo nos cuesta comprar las palomitas y ponernos las gafas para disfrutar la película... autor: josé elías |

|

|

|

|

|

domingo, septiembre 8, 2013

|

|

El siguiente es un video que ya lleva varios días rondando por Internet (y que ha sido compartido varias veces en el grupo oficial de eliax en Facebook por varios lectores), y que no quería dejar pasar en el blog, pero como dicen, a veces más vale tarde que nunca... ;)

Se trata de un video demostrado por el visionario Elon Musk (el mismo de Tesla Motors y Space X), en donde demuestra un sistema (y como evoluciona) para diseñar partes mecánicas de forma virtual en 3D, y después imprimirlas en 3D, ofreciendo un rendimiento de productividad exponencial por sobre metodologías actuales. Notemos que cada elemento por separado de lo que demuestra Elon en el video no es nada nuevo, pero lo interesante es cuando se mezcla todo, dándonos un vistazo de lo que será el futuro... Y si les gustó este video, recomiendo vean este otro acá mismo en eliax. Noten además que esto es un paso más a esto de lo cual les hablé el año pasado... Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, septiembre 7, 2013

|

|

A continuación los dejo con un video realmente asombroso, y que aunque al corto plazo quizás solo tenga aplicaciones prácticas en salud (explico más abajo), al mediano y largo plazo esto podría tener muchos usos en aplicaciones de Realidad Aumentada.

Se trata de una tecnología desarrollada en la Universidad de Wakayama en Japón, que utiliza una combinación de una cámara de alta resolución, con un proyector de alta definición, que primero captura una imagen de lo que sea que esté frente a la cámara, y después permite proyectar en tiempo real una nueva imagen por encima que es casi idéntica a la original, pero con colores cambiados. Esto tiene como efecto que es posible mejorar, degradar, o alterar los colores, contraste, brillantez, o hasta textura, de los objetos frente a nosotros. Como algunos ya podrán imaginar, esto sería de gran ayuda a personas que sufren de daltonismo, una condición que impide que ciertas personas perciban ciertos colores. Con esta tecnología, esos colores que estas personas no pueden ver se podrían transformar en otros colores que sí pueden apreciar, y de esa forma ofrecer mucho más detalle visual. Pero no dejen de ver el video, aunque sencillo, es verdaderamente asombroso lo que se puede hacer con esto. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, septiembre 6, 2013

|

|

Hoy los dejo con este curioso video (que en realidad es una actualización de este otro acá mismo en eliax), en donde verán como "mágicamente" las caras de actores famosos se convierten en "monstruos".

Para que la ilusión óptica haga efecto, sencillamente fijen la mirada a la cruz justo en el medio del video, y prepárense a sorprenderse... Y si no creen lo que acaban de ver, simplemente vuelvan a ver el video desde el inicio pero esta vez solo mirando las caras directamente. Como podrán comprobar, las caras no son modificadas en lo absoluto, y es nuestro cerebro el que nos engaña haciéndonos ver algo bastante diferente a la realidad. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, septiembre 4, 2013

|

Samsung por fin reveló, como se rumoreaba (y les reporté por Twitter hace unas semanas en @eliax) y esperaba, su nuevo reloj de pulsera inteligente, el Samsung Galaxy Gear, y hoy los dejo con un video de c|net que les muestra un poco de este curioso dispositivo. Samsung por fin reveló, como se rumoreaba (y les reporté por Twitter hace unas semanas en @eliax) y esperaba, su nuevo reloj de pulsera inteligente, el Samsung Galaxy Gear, y hoy los dejo con un video de c|net que les muestra un poco de este curioso dispositivo.Este dispositivo es el primero por uno de los grandes en el mundo de la telefonía celular inteligente (si no contamos los esfuerzos previos de Sony), y basado en Android (a diferencia de los modelos propietarios como el Pebble, o modelos de incluso décadas atrás de empresas como Casio, que tuvieron un éxito limitado), por lo que captará la atención de unos cuantos. El Galaxy Gear tiene la ventaja de ser el primero entre los grandes (siendo estos Apple, Google, Samsung y Amazon, principalmente), ganándole al mercado particularmente a Apple, quien fue quien empezó todo el tema de los rumores con su rumoreado iWatch, del cual no se sabe si sabremos este año, o el próximo. Mientras tanto, Samsung ha decidido probar las aguas en el segmento de "ropa inteligente", un segmento que he esperado despegue pronto (fue mi predicción #10 para el año pasado que apenas se está empezando a hacer realidad). El Galaxy Gear viene con las siguientes especificaciones: - Android 4.3 - Pantalla AMOLED de 1.63" (3cm x 3cm) con resolución de 320×320 pixeles - Procesador Samsung Exynos a 800MHz - GPU (gráficos) ARM Mali-400 MP4 (de 210MHz a 500MHz - 512MB de memoria RAM - 4GB de almacenamiento interno (para Apps, fotos, videos, etc) - Cámara de 1.9 Megapixeles - Video a 720p - Bluetooth 4.0 - NFC - WiFi - Acelerómetro de 3 axis - US$299 dólares En cuanto a la batería, es de apenas 315mAh (aunque hay que entender, que hay poco espacio en este tipo de dispositivos para tener una buena batería, aunque me pregunto si ni pudiesen hacer que el mismo brazalete sea la batería en futuros modelos), pero según Samsung esto es suficiente para aproximadamente "un día entero de uso normal" (a comprobar). Noten que el Galaxy Gear necesita estar "pareado" con otro dispositivo de Samsung para uno poder darle uso (pues es desde ese otro dispositivo que se cargan aplicaciones, se configura el reloj, a través del cual se hacen llamadas, etc). Inicialmente el Galaxy Gear soportará el Galaxy Note II, Galaxy Note 3, Galaxy Note 10.1 (edición 2014), Galaxy SIII, y el Galaxy S4. Noten que para algunos de estos dispositivos tendrán que posiblemente esperar unas semanas después del debut del Gear a inicios de octubre. En cuanto a aplicaciones, el Gear vendrá con unas 17 aplicaciones instaladas, y tendrá acceso al inicio a unas 70 más, por lo que habrá mucho de donde elegir desde el inicio, apuntando a un buen ecosistema para arrancar. Opinión eliax No lo duden, este tipo de dispositivos marcan una tendencia futura, pues a diferencia de esfuerzos anteriores, esta nueva generación provee un verdadero valor añadido por encima de un celular, particularmente en conveniencia. Un reloj inteligente, como en este caso, nos sirve para alertarnos de mensajes sin tener que buscar el celular en un bolsillo o cartera (que es un problema recurrente en damas), así como nos hace fácil el darle seguimiento a algunos aspectos de nuestra salud (como cuánto caminamos al día, cuánto nos movemos, etc), así como nos hace fácil el captar nuestra vida social de una forma fácil (es muchísimo más fácil apuntar la pulsera de un reloj inteligente para captar una foto espontánea, que el tener que buscar un celular para después tomar la foto). Eso sin mencionar toda una nueva generación de aplicaciones, algunas de las cuales estoy seguro nos sorprenderán por su grado de ingenio. Y ahora la pregunta es, independientemente de que este mercado se vaya a poner caliente o no, ¿será el Galaxy Gear exitoso? Pues en mi opinión, este dispositivo se ve excelentísimo, pero padece de un tremendo Talón de Aquiles: El precio. US$299 es, en mi opinión, un tanto caro para un dispositivo que muchos tendrán la percepción de ser "menos potente" que un celular inteligente, pero costando esencialmente lo mismo, o cerca de lo mismo. Recordemos que a diferencia de un celular como el Galaxy S4 o el iPhone 5, estos dispositivos no se venden con subsidios, por lo que es altamente importante el poder fabricarlos a un costo que permita venderlos a un precio atractivo a consumidores. Si Samsung pudiese bajar el precio del Gear a US$149, creo que se venderían millones y millones, y notemos que a diferencia de Apple que tiene una cultura de ofrecer equipos de muy alta calidad a precios premium, lo único que Samsung tiene a favor para vender muchos de estos Gear es la marca Galaxy y el hecho de ser el primer reloj inteligente de un gran fabricante con Android, lo que le garantizará buenas ventas, pero quizás no como lo que podría haber sido a un precio mucho más razonable. Aun así, debo admitir que este es, en mi opinión, el primer celular inteligente que yo ponderaría compraría en mi vida, pues no solo tiene un diseño bastante atractivo, sino además funcionalidades y aplicaciones que son verdaderamente útiles. Así que aplausos a Samsung, pues ganó la carrera inicial ante nada menos que Apple, en un segmento que hasta hace apenas pocos meses todos tenían como dado sería Apple el primero en entrar al mercado. Así que, Apple, tu turno de mover tu pieza de ajedrez y ver si de alguna manera nos sorprendes (y algo me dice, que tendrán que sacar algo verdaderamente diferente, o mucho más barato, o con algunas funcionalidades y diseño innovador para poder sorprender después de esta joya de Samsung). Por otro lado, creo que esto amerita una comparación contra el Google Glass. Ciertamente ambos dispositivos son muy diferentes el uno del otro, por lo que es casi como comparar una naranja con una manzana, pero la comparación creo es válida ya que ambos segmentos (de relojes inteligentes y gafas inteligentes) apuntan a lo mismo: A hacer el interfaz con nuestra tecnología lo más invisible e intuitivo posible. A tal fin, mi opinión (como ya he respondido en varias de mis charlas desde que surgió el rumor del iWatch de Apple), es que a corto plazo estos relojes inteligentes tienen el potencial de un mejor futuro que gafas inteligentes, la razón siendo principalmente el interfaz de usuario y la practicalidad. Por más cierto que el futuro esté en gafas inteligentes, el salto conceptual de un celular inteligente a gafas inteligentes es mucho más dramático que de un celular inteligente a un reloj inteligente, lo que significa una forma mucho más fácil de adopción, ya que no es tan difícil manipular un reloj inteligente en relación a un celular, ya todos estamos acostumbrados a utilizar gestos con nuestros dedos. Con gafas inteligentes sin embargo, aun queda el reto de crear un interfaz lo suficientemente "fuera de nuestro camino" como sea posible. Interfaces de voz por el momento no son suficientemente efectivos como para evitar frustración en su uso (eso sin nombrar que no todos quieren estar hablando y dando comandos en público con su voz que todo el mundo pueda escuchar), y todavía no se ha resuelto bien el tema de interfaces gráficos, o incluso de proyección ocular (al ojo). Incluso, una cosa que me decepciona del Google Glass (y ojo, que me las encuentro geniales) es que solo proyectan en un solo ojo, por lo que no proveen tampoco de un interfaz tridimensional que ofrezca ventaja de profundidad de campo en sus interfaces (cosa que por ejemplo, sería muy útil en darnos direcciones guiadas visuales). Así que en resumen, por el momento creo que la nueva tendencia será el de ropa inteligente y accesorios inteligentes como estos relojes inteligentes, y ya será al mediano y más largo plazo que gafas inteligentes serán otra gran revolución en interfaces humanos-máquinas. Y en cuanto al Samsung Galaxy Gear en específico, he quedado sorprendido, pero su precio, y el hecho de que se requiera un celular o tableta de Samsung, y no un Android genérico, es posible que baje considerablemente su ritmo de adopción. Pero aparte de esas consideraciones, le doy dos grandes dedos hacia arriba al Galaxy Gear. Bien hecho Samsung, demostrando liderazgo en donde otros como Microsoft, Nokia o Blackberry que estuvieron en el mercado por muchos años más, no han podido... ¡Gracias el lector Federico Sosa por compartir el video en el grupo oficial de eliax en Facebook! fuente de los datos técnicos en c|net Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, septiembre 3, 2013

|

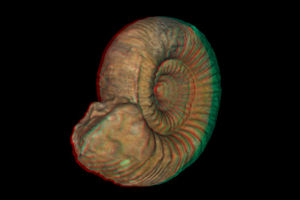

Los científicos del British Geological Survey acaban de hacer disponible en Internet un recurso que resultará invaluable no solo para arqueólogos, sino también para universidades, estudiantes, o simplemente curiosos como los lectores de eliax... ;) Los científicos del British Geological Survey acaban de hacer disponible en Internet un recurso que resultará invaluable no solo para arqueólogos, sino también para universidades, estudiantes, o simplemente curiosos como los lectores de eliax... ;)Se trata de una base de datos que contiene miles de imágenes tridimensionales de fósiles, las cuales pueden no solo ser estudiadas por la Web, sino además descargadas a tu localidad para que los imprimas en una impresora 3D. Esto tiene el potencial de aumentar exponencialmente el estudio y comprensión de estos fósiles, los cuales por lo general permanecen almacenados fuera de vista o del alcance geográfico de muchos profesionales. Para que tengan una idea, tan solo esta institución tiene muestras de unos 3 millones de ejemplares, los cuales como podrán deducir no es práctico exhibirlos todos en un museo, pero gracias ahora a la tecnología, estos fósiles podrán ser escaneados, subidos a Internet. y descargados para ser estudiados localmente en su forma física actual. Noten que por el momento solo unos cuantos miles de fósiles han sido escaneados y subidos (en formato .ply o .obj), pero la idea es subir varios diariamente, con el fin (esperemos) de eventualmente tener toda la colección en linea. Y a propósito, noten que esto es apenas el inicio de una tendencia, pues así como ya podemos crear copias casi exactas de pinturas famosas, así mismo vamos a poder en un futuro descargar todo tipo de objetos, desde copias de objetos coleccionables, hasta productos de todo tipo como accesorios para vestir, reemplazo de huesos para operaciones médicas, etc. Cada vez estamos más cerca de este escenario... enlace oficial autor: josé elías |

|

|

|

|

|

jueves, agosto 22, 2013

|

Hasta hace poco, la única forma de transmitir videos en vivo vía YouTube era si eras invitado por Google o si eras un magnate de los medios, pero hace un tiempo atrás la empresa permitió que cualquiera que tuviera un canal de YouTube con al menos 1000 subscriptores pudiese también transmitir en vivo. Y ahora, Google acaba de bajar la barra aun más, permitiendo que transmitas videos en vivo con tan solo tener al menos 100 subscriptores a tu canal. Hasta hace poco, la única forma de transmitir videos en vivo vía YouTube era si eras invitado por Google o si eras un magnate de los medios, pero hace un tiempo atrás la empresa permitió que cualquiera que tuviera un canal de YouTube con al menos 1000 subscriptores pudiese también transmitir en vivo. Y ahora, Google acaba de bajar la barra aun más, permitiendo que transmitas videos en vivo con tan solo tener al menos 100 subscriptores a tu canal.Ojo, que tu canal tiene que estar "en buen estado" (es decir, no haber sido reportado por contenido "inapropiado", entre otras cosas), pero aparte de eso no existe ninguna otra restricción. Google (los dueños de YouTube), incluso te permite ahora subir tu propia foto que represente el video, algo que también estaba disponible a solo nos pocos hasta recientemente. Noten que Google tiene además un recurso que les enseña sobre cómo tomar ventaja de todas estas cosas, en una herramienta que llama el Creator PlayBook. En cuanto a cómo activar videos en vivo, simplemente entren a su Video Manager, hagan clic en Channel Settings y ahí podrán activarlo (miren al final de la página, abajo, donde dice "Live Events" (Eventos en Vivo)). Opinión Con esto Google da otro golpe bajo a la TV tradicional (algo que inició hace unos años con la misma compra de YouTube), pues con esto lo que la empresa esencialmente ha hecho es permitir que prácticamente cualquier productor de TV puede transmitir en vivo a todo el mundo, sin necesidad de una estación de TV o Cable tradicional. Esto incluso abrirá las puertas a la experimentación a gran escala, particularmente de estudiantes y aficionados, lo que estadísticamente podría hacer que surjan unos cuantos muy buenos programas que poco a poco harán que más personas se muden del Cable al Internet, y gracias a que Google ahora vende el ChromeCast por apenas US$35 dólares, eso hará aun más fácil la transición para los que no la han hecho aun con sus televisores hogareños. Y esto de poder transmitir video en vivo a todo el mundo, por potencialmente decenas o cientos de miles de personas a la vez, se hace posible gracias al As bajo la manga de Google de lo cual les hablé acá mismo en eliax hace un par de años atrás... Así que no lo duden, todo esto es parte de un plan maestro de Google, para liberarnos de las ataduras que nos tienen la TV y Cable tradicional, sabiendo perfectamente Google que la única forma de liberarnos es con contenido original, así que qué esperan, obtengan al menos a 100 subscriptores en sus canales y pónganse a crear sus propias programas, desde entrevistas y farándula, hasta cubrir eventos deportivos en vivo. Nunca ha existido un mejor momento en toda la historia de la TV para llegar a ser grande con muy bajos recursos como ahora. introducción a YouTube Live (en español) introducción a YouTube Live (en inglés) autor: josé elías |

|

|

|

|

"Si, somos seres efímeros, pero en vez de amargarte por eso, concentrate en vivir la poca vida que tienes en lugar de sólo "aguantar" con la esperanza de que después de morirte quede algo, y que ese algo tal vez pueda tener una existencia más feliz."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax