Tecnología Visual

|

lunes, diciembre 31, 2012

|

|

Ya que es el último día del año, me gusta ver con optimismo nuestro futuro, y algo que será parte intrínseca de nuestro futuro será la Realidad Aumentada, ¿y qué mejor manera de explicar el potencial de esta tecnología que con un video del mago-geek Marco Tempest?

Y lo asombroso (para los que no estén al tanto de esta tecnología) es que Marco realmente hizo todo lo que ven en el video, en vivo, por lo que la tecnología existe, solo que en etapa de prototipo y a precios todavía relativamente altos. Noten que esta es la idea detrás de tecnologías como Google Glass, y de mi fantaseado IrixPhone (o si quieren irse más lejos en el futuro, el NeuroPhone). Finalmente, si quieren ver un video de lo lejos que esto llegará al mediano plazo, no dejen de ver este otro... ¡Gracias al lector Marcelo Flix Diaz por el enlace! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, diciembre 22, 2012

|

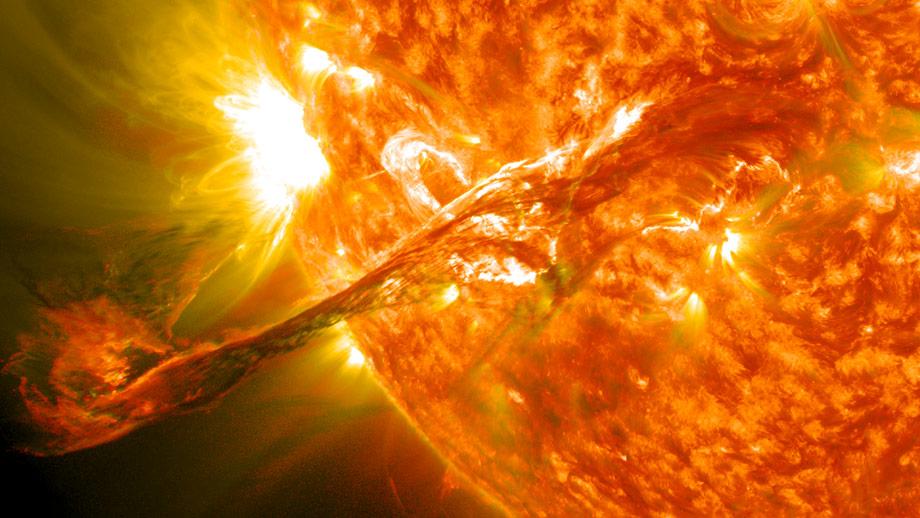

Mientras nos acercamos al fin de este año, comparto con ustedes estas alucinantes imágenes astronómicas, 21 de entre las más bellas e impactantes del año. Mientras nos acercamos al fin de este año, comparto con ustedes estas alucinantes imágenes astronómicas, 21 de entre las más bellas e impactantes del año.¡Gracias al lector gaston_pdu por compartir el enlace! enlace a las imágenes autor: josé elías |

|

|

|

|

|

viernes, diciembre 21, 2012

|

|

¿Qué sucede cuando juntas a unos foros unas personas con mucha imaginación y unos desarrolladores con mucho talento, y una buena idea? Pues lo que verán en el video a continuación...

Lo llaman Auxo, y es un reemplazo total para el sistema de manejo de aplicaciones de iOS en iPhone y iPad (incluyendo iPad mini y iPod Touch). Como verán, han superado a la misma Apple en funcionalidad y facilidad de uso, e incluso han logrado acercarse a utilidades en Android que logran un efecto similar pero de forma más complicada. La idea de los creadores de esto es que Apple los copie, o al menos se inspire en ellos (o diría yo, que los contrate) para implementar esto en la próxima versión de su sistema operativo móvil iOS 7. Pero lo mejor de todo es que todo lo que ven en el video es real y funcionando hoy día, y lo harán público para iPhones liberados con la técnica de jailbreak (no sancionado por Apple, obviamente). Así que si tienen un iPhone jailbroken, atentos a la tienda Cydia en los próximos días... Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, diciembre 18, 2012

|

.png)  Google acaba de lanzar un nuevo producto específicamente para iOS (iPhone, iPod Touch y iPad) que permite que de forma super sencilla subas videos a YouTube, y opcionalmente a otras redes sociales como Google+, Facebook y Twitter. Google acaba de lanzar un nuevo producto específicamente para iOS (iPhone, iPod Touch y iPad) que permite que de forma super sencilla subas videos a YouTube, y opcionalmente a otras redes sociales como Google+, Facebook y Twitter.La aplicación incluso incluye algunas funcionalidades bastante avanzadas pero simplificadas, como son corrección de color, estabilización (por si no tuviste un buen pulso cuando grabaste el video), entre otras cosas. Pero, ¿no encuentran extraño que Google haya sacado esta aplicación primero para iOS, y nos promete eventualmente en el futuro una versión para Android? Pues la verdad es que no me sorprende, y de eso les pienso hablar hoy...  Entre su Plan Maestrotm, una de las estrategias de Google no es aniquilar a iOS, sino tomar prestada una estrategia que hace un par de décadas atrás le funcionó bastante bien a Microsoft: Asimilación. Entre su Plan Maestrotm, una de las estrategias de Google no es aniquilar a iOS, sino tomar prestada una estrategia que hace un par de décadas atrás le funcionó bastante bien a Microsoft: Asimilación.En vez de tratar de derrocar del mercado a iOS, Google ve a esa plataforma como una oportunidad para expandir su imperio de servicios (los cuales están todos minuciosamente diseñados para traer tráfico de publicidad a la empresa), y la manera de hacerlo es tratando de reemplazar todas las aplicaciones básicas de iOS por equivalentes de Google. El mejor ejemplo del momento es Google Maps, el cual sin duda es preferido por la vasta mayoría de usuarios de iOS por sobre los defectuosos mapas de Apple. Pero lo mismo podemos decir de GMail (y su sistema de calendarios sincronizados), y Google ya tiene una versión de Google Drive/Docs en iOS, así como una de manipulación de fotos (recientemente compró mi programa favorito para manipular fotos, Snapseed, y la hizo gratis en iOS), así como ya tiene incluído su buscador, y hasta cierta medida el competidor de Siri con Google Now. Así que el ofrecer ahora un reemplazo para la cámara nativa de iOS con YouTube Capture es solo un paso lógico para apoderarse ahora no solo de fotos, sino de videos en iOS. Google en esencia a cambiado el viejo refrán que antes decía "Si no puedes vencerlos, únete a ellos" para que ahora diga "¿Por qué competir cuando puedes asimilarlos?"... página oficial de YouTube Capture anuncio oficial con más detalles de YouTube Capture Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, diciembre 15, 2012

|

|

Primero, empecemos notando algo: ¿Alguna vez se han acercado a ver realmente de cerca una pantalla de un televisor LCD/LED o Plasma? Notarán que la pantalla está compuesta de pequeños puntos a los cuales técnicamente se les llama "pixeles" (más específicamente, un pixel por lo general está compuesto de tres sub-elementos de color rojo, verde y azul, y entre los tres forman un pixel). Pues así como los televisores están compuestos de pixeles, así mismo son las fotos digitales que tomamos con nuestras cámaras, en donde millones de pixeles describen una imagen. Y si extendemos esto a video, podemos decir que video no es más que miles de fotografías digitales, una detrás de la otra, compuestas por pixeles. Así que podemos resumir diciendo que por lo general las imágenes digitales que almacenamos, transmitimos y vemos hoy día (y en particular, imágenes de video como nos interesa en este artículo de hoy), están esencialmente compuestas por millones y millones de pixeles. Sin embargo, esta no es quizás la mejor forma de describir imágenes, debido a que literalmente hay que procesar todos y cado uno de esos pixeles cada vez que tomamos una foto o grabamos o desplegamos un video. Pero, por décadas siempre ha existido una alternativa a los "gráficos pixelados" como es de lo que les he estado hablando hasta ahora, y esa alternativa se llama "gráficos vectoriales", que como indica el nombre, utiliza vectores en vez de pixeles para describir gráficos. Gráficos vectoriales han sido utilizados en sistemas electrónicos desde los mismos inicios de la computación, y quizás predatan las imágenes pixeladas, particularmente debido a que las gráficas vectoriales (por motivos que van más allá de este artículo) eran más amigables a entornos de computadoras analógicas de antaño que a computadoras modernas digitales. Incluso, el primer videojuego utilizó gráficos vectoriales y no pixelados. Pero, ¿qué son gráficos vectoriales? Pues es una técnica que en vez de especificar punto por punto (es decir, pixel por pixel) cómo se compone una imagen, lo que hace es especificar formas geométricas con lineas, curvas y polígonos (si utilizan programas como AutoCad y Adobe Illustrator en esencia ya trabajan con gráficos vectoriales). Es decir, en un sistema pixelado, si quiero dibujar un círculo, tengo que ir y especificar cada punto de la pantalla en donde se deben "pintar" pixeles para que entre todos den la impresión de un círculo, lo que implicaría posiblemente tener que especificar entre cientos a hasta miles o millones de puntos por separado. Pero en un sistema de gráficos vectoriales sería tan sencillo como simplemente almacenar todo eso en una ecuación o fórmula que especifique un círculo, algo así como la fórmula (x-a)2 + (y-b)2 = r2. En otras palabras, en vez de almacenar en un archivo millones de coordenadas de pixeles, lo único que tendríamos que hacer en un archivo vectorial es almacenar esa sencilla fórmula y listo. Eso implica unas cuantas cosas interesantes: La primera es que por lo general gráficos vectoriales ocupan mucho menos espacio de almacenamiento, lo que de paso implica que los archivos se pueden descargar mucho más rápidamente por Internet. De paso, esto también implica que es más eficiente procesar estos archivos para desplegarlos, lo que los hace ideal para ambientes móviles de baja potencia, lo que de paso también significa que el procesador móvil trabaja menos lo que implica adicionalmente un menor consumo en la batería. Y como si fuera poco, un sistema vectorial nos dota de independencia del tamaño y resolución de la pantalla final, lo que significa que podemos siempre tomar ventaja de la más alta resolución disponible para desplegar la mejor imagen posible. En nuestro ejemplo con el círculo por ejemplo, en un sistema pixelado hay que especificar necesariamente de antemano la resolución en pixeles bajo la cual se desea dibujar el círculo, y de ahí en adelante la resolución se mantiene fija, pero un círculo se puede dibujar en cualquier resolución, ya que los pixeles finales de la imagen son deducidos en base a la fórmula matemática de los vectores especificados en ecuaciones. Pero, si tenemos tantas ventajas con gráficos vectoriales, ¿por qué no son el formato preferido hoy día y seguimos utilizando pixeles? Pues la respuesta por un lado es que en realidad los gráficos vectoriales ya se utilizan en millones de ambientes que uno rara vez nota, particularmente en videojuegos y en programas de diseño gráfico, pero el problema es que en fotografías y videos hasta hora no era eficiente almacenar imágenes como vectores, por la sencilla razón de que una imagen cualquier no es muy uniforme visualmente entre un pixel y otro, y se requeriría o (1) de tener que almacenar un vector por pixel (que en realidad no ofrecería ninguna ventaja sobre sistemas pixelados, y al contrario, introduciría todo tipo de desventajas), o (2) de tener que hacer unos cálculos inmensamente complejos para deducir el patrón vectorial a partir de las imágenes originales. Así que habiendo dicho todo eso, llegamos a la noticia de hoy... Un grupo de científicos de la Universidad de Bath ha logrado crear una técnica que permite aplicar procesamiento vectorial de forma eficiente y práctica (pues antes se habían creado sistemas similares pero que no eran eficientes y/o prácticos) para video. Según sus inventores, su tecnología funciona tan bien que ya quieren incorporarla en todo tipo de programas profesionales a todo nivel de la cadena de producción de video. Esto es una tremenda noticia porque significa que gran parte de las ventajas que ya mencioné sobre vectores, nos llegarán a mediano plazo a consumidores, lo que de paso significará que podamos reproducir el mismo archivo de video de manera óptima y con la mejor calidad posible tanto en un celular de pequeña pantalla, como en televisores futuros con resoluciones de 8K para consumidores, sin necesidad de reprocesar o convertir el video original. Sería como comprar un DVD una sola vez, y después poder reproducir ese "DVD" tanto en un televisor de 1080p hoy día, como en uno de 4K o 8K mañana, y en todo momento con el más óptimo detalle de la imagen (asumiendo que la fuente de la imagen tenga el suficiente detalle, obviamente). Esta noticia a propósito llega justo días antes de un artículo que tenía planeado sobre la necesidad de definir un CODEC (codificador-descodificador) independiente de resolución de video, por lo que con esta noticia no solo me evité escribir ese artículo, sino alegrarme al ver que esto llegará a consumidores mucho antes de lo que muchos imaginábamos... :) enlace a un video de demostración (formato Quicktime - quizás quieran salvarlo antes de verlo, y noten que es un video pre-grabado en formato pixelado, ya que no existe un reproductor para ver el video original en formato vectorial) página oficial del proyecto fuente oficial Actualización: Video en formato YouTube a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, diciembre 12, 2012

|

Hoy quiero exhortarlos a que si tienen la oportunidad de hacerlo, que asistan a la exposición más cercana a su ciudad de Body Worlds, del anatomista Gunther von Hagens. Hoy quiero exhortarlos a que si tienen la oportunidad de hacerlo, que asistan a la exposición más cercana a su ciudad de Body Worlds, del anatomista Gunther von Hagens.Este es una exposición rodante que ocurre anualmente en varias ciudades del mundo, en donde podrán apreciar con sus propios ojos el interior de verdaderos cuerpos humanos (de personas que donaron su cuerpo a la ciencia), en distintas formas. La técnica que se utiliza para preservar los cuerpos en el estado que verán se llama plastinación, y fue inventada por el mismo Gunther von Hagens, y es algo verdaderamente asombroso. En la exposición verán justo frente a sus ojos los músculos, órganos, arterias, huesos, glándulas, nervios y células que componen el cuerpo humano (y por lo general, las exhibiciones también incluyen uno que otro animal). Así mismo podrán apreciar en detalle muchos órganos atrofiados por enfermedades, lo que les dará una mejor idea de qué es lo que sucede dentro de nuestro organismo cuando algo sale mal. Ojo, esta exhibición creo que no será apropiada para niños mejores que puedan ser fácilmente impresionados, pero para todo el resto, es algo que deberán ver al menos una vez en sus vidas, incluso es posible que cambien un poco la perspectiva sobre sus propios cuerpos. En mi caso en particular, vi la exhibición en un viaje reciente a Santo Domingo, en República Dominicana, en Agora Mall (la exposición ocurre todo el mes de Diciembre 2012, y más información aquí). Y para los que no puedan asistir, les recomiendo esta herramienta que les permite explorar el interior del cuerpo humano en 3D de forma interactiva y dentro de sus navegadores web. página oficial de Body Worlds lista de exhibiciones actuales en el mundo próximas exhibiciones Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, diciembre 11, 2012

|

Investigadores del Centre for Microsystems Technology acaban de acercarnos un paso más a un futuro en donde todos poseeremos lentes de contacto biónicos que desplegarán información directamente a la retina de nuestros ojos, en esencia creando tanto una Realidad Virtual como una Realidad Aumentada en cualquier momento que lo deseemos. Investigadores del Centre for Microsystems Technology acaban de acercarnos un paso más a un futuro en donde todos poseeremos lentes de contacto biónicos que desplegarán información directamente a la retina de nuestros ojos, en esencia creando tanto una Realidad Virtual como una Realidad Aumentada en cualquier momento que lo deseemos.A la fecha, los avances realizados han sido prototipos de tamaño bastante grandes, pero este es el primer prototipo experimental en donde el lente de contacto y la pantalla han sido creados en tamaño real. Por el momento, el prototipo tiene un patrón de pixeles pre-configurados con la imagen de un símbolo de dólar (¿quizás un mensaje subliminar a inversionistas de que hay mucho dinero por hacer en este espacio?), pero obviamente la idea es construir futuros prototipos con gráficos dinámicos que desplieguen cualquier imagen y a todo color. Paralelo a esto, la investigación además se está centrando en técnicas que nos permitirán enfocar la luz del lente de contacto de biónico de forma tal que la imagen que percibamos se fusionará (y enfocará) junto con las imágenes reales del mundo exterior, similar a esto. fuente fuente secundaria imagen de alta resolución del prototipo Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, diciembre 1, 2012

|

Durante más de medio siglo hemos sabido cual es la estructura de "doble hélice" de la molécula ADN (que contiene todos los genes que nos describen como seres humanos), pero hasta ahora su estructura había sido inferida indirectamente por medios matemáticos. Durante más de medio siglo hemos sabido cual es la estructura de "doble hélice" de la molécula ADN (que contiene todos los genes que nos describen como seres humanos), pero hasta ahora su estructura había sido inferida indirectamente por medios matemáticos.Pero ahora, un equipo de científicos de la Universidad de Genoa, en Italia, han logrado "fotografiar" directamente filamentos de ADN, demostrando visualmente que ciertamente el ADN tiene la estructura deducida matemáticamente a mediados del siglo pasado Esto se logró con un microscopio de barrido de electrones, después de utilizar una técnica que evaporaba todo tipo de líquido alrededor de la molécula, dejando la molécula sola para ser inspeccionada. En nota relacionada, es bueno aclarar que aunque el ADN es usualmente nombrada como "la molécula de la vida", que en realidad el ADN no es necesario para que surja la vida, pues tenemos evidencia de que los primeros organismos que poblaron la Tierra ni siquiera contenían ADN, sino que moléculas más sencillas que se auto-replicaban. El ADN fue sin embargo un punto clave en la evolución de la vida, ya que permitió toda una nueva generación de organismos mucho más complejos que eventualmente fueron los que dominaron toda la vida en el planeta. ¡Gracias Cristian Esquivel por el enlace! fuente autor: josé elías |

|

|

|

|

|

miércoles, noviembre 28, 2012

|

Hoy quiero compartir con ustedes algunos enlaces de fotografías hacia algunos de los más asombrosos escenarios que jamás hayan visto en sus vidas (y lo dice alguien que ama el teatro y ha visto lo mejor de lo mejor en Broadway, Las Vegas y otras ciudades famosas por sus eventos). Hoy quiero compartir con ustedes algunos enlaces de fotografías hacia algunos de los más asombrosos escenarios que jamás hayan visto en sus vidas (y lo dice alguien que ama el teatro y ha visto lo mejor de lo mejor en Broadway, Las Vegas y otras ciudades famosas por sus eventos).Se trata de los teatros flotantes del Festival Bregenz en Austria, en donde toda la costa de la ciudad es transformada literalmente en un escenario flotante con las más asombrosas esculturas, iluminación y puesta en escenario que se puedan imaginar. Este evento (u "Obra de Arte Vida", diría yo), fue fundado en el 1946, y desde entonces su popularidad aumenta constantemente. Recientemente más de 200,000 personas atendieron al festival en una sola temporada. El festival (que ocurre entre los meses de Julio y Agosto) pone en escena obras clásicas como Aida, La Bohème, Tosca, West Side Story, pero además es conocido por exhibir obras totalmente originales y de una exhuberancia visual sin precedentes. Definitivamente uno de los lugares a visitar en la vida... página oficial del evento ejemplo de una obra (Aida) fuente secundaria Leer el resto de este artículo... autor: josé elías |

|

|

|

|

|

martes, noviembre 27, 2012

|

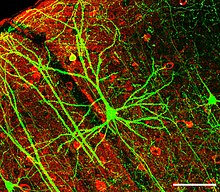

Científicos del San Diego Supercomputer Center (SDSC) en la University of California, San Diego, acaban de ejecutar una simulación en una super-computadora que a muchos a dejado atónitos, pues tal cual teorizaban los creadores de esta simulación, han descubierto una clara correlación entre la estructura de crecimiento del Universo, el cerebro humano (u otros cerebros similares) y el Internet, así como otros tipos de redes como son las redes sociales o redes de organismos biológicos. Científicos del San Diego Supercomputer Center (SDSC) en la University of California, San Diego, acaban de ejecutar una simulación en una super-computadora que a muchos a dejado atónitos, pues tal cual teorizaban los creadores de esta simulación, han descubierto una clara correlación entre la estructura de crecimiento del Universo, el cerebro humano (u otros cerebros similares) y el Internet, así como otros tipos de redes como son las redes sociales o redes de organismos biológicos.Según los realizadores de este estudio, todos estos sistemas, por diferentes que se vean sobre la superficie, en realidad siguen un mismo patrón de crecimiento, como si de alguna "fórmula maestra" se tratara. Estos advierten sin embargo que no están diciendo que el Universo en sí es un mega-cerebro pensante o una mega-computadora, pero el estudio ciertamente revela que la estructura a grandes escalas del Universo y la forma en que este evoluciona tiene un parecido increíble a nuestros cerebros. Esta noticia me ha fascinado pues esto es algo que yo mismo he teorizado por al menos dos décadas, y de lo cual escribí de forma indirecta en Máquinas en el Paraíso en el 2001, y de forma más específica hace casi 6 años en este artículo clásico acá mismo en eliax, y de forma aun más explícita en este otro de hace poco más de 4 años. Así mismo, todo aquel que haya asistido a mis charlas sobre La Singularidad Tecnológica ya sabe de lo que estoy hablando, pues este tema es específicamente con el cual termino mis charlas. Pero, más allá de una curiosidad, ¿tiene esto algún uso? Pues aunque hoy día quizás no sea aparente, es posible que al largo plazo sí, ya que si entendemos mejor el funcionamiento de cualquiera de estas redes (sea un red de galaxias, o una red neuronal, o incluso una red social), es posible que lo aprendido lo vamos poder aplicar a cualquier otro tipo de red. En otras palabras, por increíble que parezca, es posible que al tratar de conocernos mejor por medio de la neurociencia o el estudio psicológico de las redes sociales, estemos en realidad encaminándonos a entender mejor el universo en el gran orden de las cosas... fuente autor: josé elías |

|

|

|

|

|

martes, octubre 30, 2012

|

Una de las cosas curiosas que surgieron de los anuncios de ayer de Google concernientes a los Nexus 4, Nexus 10 y en particular a Android 4.2, es soporte para una tecnología llamada Miracast. Pero, ¿qué es Miracast? Una de las cosas curiosas que surgieron de los anuncios de ayer de Google concernientes a los Nexus 4, Nexus 10 y en particular a Android 4.2, es soporte para una tecnología llamada Miracast. Pero, ¿qué es Miracast?Miracast es algo bastante sencillo de entender, pero en mi opinión tan importante que merece su propio artículo. Pero antes de continuar, un poco de historia... Durante la última década se han tratado de estandarizar varios tipos de tecnologías que por fin nos liberen de los cables de audio y video con los cuales debemos conectar todo tipo de dispositivos, desde televisores y monitores, hasta proyectores, computadoras, celulares y tabletas. Empresas como Intel han tratado con tecnologías como WiDi, pero sin lograr ni una penetración masiva en el mercado, ni apoyo de fabricantes. Todo eso cambió cuando hace un par de años Apple introdujo AirPlay en iOS, una tecnología que permite que envíes audio, video, o cualquier otra aplicación, desde un iPhone o iPad hasta cualquier receptor compatible con la tecnología, como el Apple TV, o las decenas de componentes de sonido hogareño que ya son compatibles con AirPlay. El problema sin embargo, es que AirPlay es un protocolo propietario de Apple, el cual está dispuesto a licenciarlo terceros pero solo para crear equipos compatibles con desplegar audio y video, no generarlo. O en otras palabras, aun se creen televisores, equipos de sonido, y demás aparatos que funcionen con AirPlay, la única forma de enviar sonido y video a esos dispositivos es a partir de un iPhone, un iPod Touch, un iPad, o una Mac (hoy día el más popular receptor de estas señales inalámbricas es el Apple TV). Y créanme que es genial, el uno poder sencillamente elegir un Apple TV mientras ve fotos y videos en un iPhone, y que estos automágicamente aparezcan en pantalla de la manera más sencilla e intuitiva posible. Es algo que yo uso con regularidad. Pero recordemos una vez más, que por más exitoso que haya sido AirPlay, en esencia es solo para productos de Apple. Y es aquí en donde entra en escena Miracast... Miracast, en esencia es un clon de AirPlay, pero a diferencia de ser una tecnología propietaria, está abierta para que cualquiera le de uso. Y lo mejor de todo, es que no utiliza un protocolo o redes dedicadas para tal fin, sino que sencillamente requiere Wi-Fi Direct (la tecnología que permite que dos equipos con Wi-Fi se comuniquen entre sí sin necesidad de un router intermediario). Miracast ya es soportado por Samsung con su Galaxy S3 y sus televisores Echo P TV, y empresas como NVIDIA (con su Tegra 3), Qualcomm, Marvell Technologies y Texas Instruments ya están en el proceso de fabricación de chips compatibles con la tecnología para la nueva generación de dispositivos del 2013. Miracast en Wikipedia autor: josé elías |

|

|

|

|

|

lunes, octubre 29, 2012

|

Científicos del ATR Computational Neuroscience Laboratories en Kyoto, Japón, acaban de dar un tremendo avance en materia de descodificación de sueños, al inventar una técnica que permite dejarles saber en qué están soñando las personas. Científicos del ATR Computational Neuroscience Laboratories en Kyoto, Japón, acaban de dar un tremendo avance en materia de descodificación de sueños, al inventar una técnica que permite dejarles saber en qué están soñando las personas.La técnica en su forma sencilla de explicar es la siguiente: Se utilizan varias personas para el estudio, las cuales son despertadas varias veces durante una misma noche (cuando se sabe que están soñando) y se les pregunta que reporten con qué estaban soñando en ese preciso momento. Las respuestas de estas personas son grabadas junto con los patrones cerebrales de ellos en regiones del cerebro llamadas V1, V2 y V3, que son algunas de las primeras regiones de cerebro que procesan la visión en humanos. Esto produce patrones que por ejemplo pueden asociar algo como "soñando con una mujer" o "utilizando una computadora" con un patrón específico. Posteriormente a esa etapa de "entrenamiento", las personas vuelven a dormir, y estas ves los científicos los despiertan pero tratan de adivinar en qué estaban soñando las personas en forma cruda, basados en un sistema de reconocimiento de patrones. Asombrosamente, en algunos casos se logran entre un 75 a un 80% de certeza en adivinar en qué estaban soñando las personas, aunque aclaremos que esto está aun en una etapa primitiva, pues solo reconoce cosas bastante simples y no eventos complejos con lujo de detalles. El estudio de paso arrojó el conocimiento de que parece que nuestros sueños ligan tanto la parte visual de nuestro cerebro (cosa que muchos sospechábamos) como la memoria de corto plazo, lo que me hace pensar que a eso se deberá lo rápido que olvidamos por lo general nuestros sueños. Este adelanto me pone a pensar, ¿qué sucedería si combinamos esta nueva técnica, con esta otra reciente que graba directamente del cerebro lo que tu mente está viendo? El resultado sería el DreamCorder del cual les hablé el año pasado... fuente autor: josé elías |

|

|

|

|

|

sábado, octubre 27, 2012

|

Hola amig@s, hoy damos un paso más para la estandarización del video "4K" que ya está dando sus primeros pasos bebé en espera de reemplazar al mediano plazo al video HDTV de 1080p. Hola amig@s, hoy damos un paso más para la estandarización del video "4K" que ya está dando sus primeros pasos bebé en espera de reemplazar al mediano plazo al video HDTV de 1080p.La organización CEA (Consumer Electronics Association) recientemente votó para dotar de un nombre oficial estandarizado todo el tema del "video 4K" (el cual como les expliqué en este artículo pasado acá mismo en eliax, hay más de una forma de interpretarlo). Así que (preparen los tambores) el nuevo nombre será... video "Ultra HD". En otras palabras, de ahora en adelante cada vez que lean de "Ultra HD", ya saben que se refieren a una versión estandarizada de "video 4K". El nuevo estándar Ultra HD indica que cualquier monitor/televisor/proyector que quiera llamarse compatible con Ultra HD, debe soportar como mínimo una resolución nativa de 3840x2160 pixeles. Sin embargo, para agregar confusión al tema, Sony ha anunciado que prefiere utilizar su propio nombre para definir sus pantallas, el cual será "4K UHD". Y como si fuera poco, recuerden que hace poco se estandarizó el video "Ultra HDTV" para video 8K a 7680x4320 pixeles y 120fps (120 cuadros por segundo), y al menos en mi opinión "Ultra HD" se parece demasiado a "Ultra HDTV", por lo que esperen todo tipo de confusión al respecto tarde o temprano (lo que quizás requiera cambiar a largo plazo el nombre de "Ultra HDTV" a algo diferente, algo quizás como "Super-Ultra-HD-Xtreme-Plus"... :) En mi opinión, debieron dejar sencillamente el nombre de "4K" que ya es bastante conocido en círculos técnicos, y ya se estaba empezando a filtrar en círculos de consumidores (por eso me gusta más la propuesta de Sony, con "4K UHD", la cual en un futuro podríamos cambiar a "8K UHD" cuando lleguen pantallas 8K). Y para los curiosos y menos técnicos, una pantalla 4K en esencia tiene la resolución equivalente a 4 televisores HDTV, lo que también significa pixeles en pantalla 4 veces más pequeños que los pixeles de los televisores de alta definición en la actualidad. Similarmente, el video 8K será 16 veces más denso que los televisores HDTV actuales. fuente autor: josé elías |

|

|

|

|

|

domingo, octubre 21, 2012

|

El mes pasado les respondí sobre lo que es el cine "XD", y hoy les respondo a la pregunta sobre lo que es el cine "4DX". El mes pasado les respondí sobre lo que es el cine "XD", y hoy les respondo a la pregunta sobre lo que es el cine "4DX".La pregunta viene debido a que una empresa local ha lanzado la primera sala "4DX" en el país y algunos amigos me han estado preguntando lo que es. 4DX (creado por una empresa Coreana del mismo nombre), a diferencia de XD, no es una tecnología visual, sino que para los otros sentidos. 4DX es una tecnología que conlleva crear efectos de movimientos con las sillas del cine, así como otros efectos atmosféricos. De ahí el "4D" en donde la "cuarta dimensión" sería la de sentir vibraciones y otros efectos. Entre los efectos que se podrán sentir en una sala 4DX están: 1. Vibraciones y movimientos en los asientos (para explosiones, etc). 2. Olores. 3. Truenos y rayos (con luces especiales como las de discotecas). 4. Lluvia (aunque leve, no vas a salir mojado, solo algunas gotas). 5. Burbujas (me imagino que para películas infantiles). 6. Ráfagas de aire (como en tormentas, carreras de autos, etc). Así que en teoría, salas de cine 4DX podría combinarse con salas XD, aunque quizás no veamos esa modalidad ya que por lo general en varios mercados los competidores de cines asumen una u otra de estas tecnologías. Noten que si han viajado a lugares como Disney World o Universal Studios, o parques de atracciones similares, que es en esencia lo mismo que experimentan en esos lugares, sin embargo para las audiencias que nunca hayan experimentado este tipo de cosas podría ser algo novedoso. Obviamente esto no está diseñado para todo tipo de películas, pero podemos imaginarnos que esto sería bastante interesante en películas de acción, terror, o animadas. página oficial de 4DX Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, octubre 20, 2012

|

Hace un par de años les hablé de un proyecto de Google llamado el Google Body Browser, pero desde entonces este se convirtió en un proyecto independiente de la empresa Zygote Media (asumo que Google le vendió los derechos) y el proyecto ahora se llama Zygote Body. Hace un par de años les hablé de un proyecto de Google llamado el Google Body Browser, pero desde entonces este se convirtió en un proyecto independiente de la empresa Zygote Media (asumo que Google le vendió los derechos) y el proyecto ahora se llama Zygote Body.Zygote Body en esencia es un visualizador del cuerpo humano en 3D y de forma interactiva, en donde puedes ver a un ser humano desde adentro hacia afuera en cualquier nivel que desees, desde una persona totalmente vestida, hasta un esqueleto o el sistema nervioso. Lo más asombroso es que esto funciona dentro de cualquier navegador web moderno que sporte WebGL (lo acabo de probar en Chrome y Firefox). Después que se carguen los modelos 3D pueden interactuar con ellos con el ratón. Notarán también que en el control que aparece a la izquierda pueden deslizar una barra que verán desde arriba hacia abajo, y mientras lo hacen notarán como se adentran al interior del cuerpo. Esta es una herramienta que yo diría debería ser casi obligatoria en escuelas, universidades y todo centro de enseñanza. Les aseguro que quedarán asombrados... enlace a Zygote Body (paciencia pues los datos tardan un poco en cargar) autor: josé elías |

|

|

|

|

|

lunes, octubre 8, 2012

|

En el 2006 les informé de un comentario hecho por Eric Schmidt, quien en ese entonces era el CEO (Gerente General) de Google, y cuyo comentario no fue notado por la mayoría de medios. En el 2006 les informé de un comentario hecho por Eric Schmidt, quien en ese entonces era el CEO (Gerente General) de Google, y cuyo comentario no fue notado por la mayoría de medios.Según Google en ese entonces, su próximo reto era nada más ni nada menos que la Inteligencia Artificial, y hoy día, 6 años después, Google lanza su primera gran iniciativa utilizando todo lo aprendido en los últimos años en esa área de la informática... Pero primero, una breve nota: Hace un par de meses Google anunció que su sistema de inteligencia artificial, su "Cerebro Virtual", había avanzado a un grado tal, que ya podía reconocer la imagen de un gato independientemente del tipo de gato, o incluso de si el gato estaba de frente, de perfil, o incluso si este aparecía en un video o una foto. Es decir, en esencia había aprendido a entender el concepto de un gato de forma similar a como lo hacemos los humanos. Ese fue apenas un primer experimento para demostrar las capacidades de este nuevo cerebro sintético, el cual en su ingeniería más intrínseca emula las interconexiones neuronales del cerebro humano. En esencia, es una forma de una Red Neuronal que se ha estado estudiando por décadas en círculos científicos. Pues ahora, la empresa ha puesto en producción su cerebro virtual, y ya le está siendo tremendamente útil a la empresa. Para empezar, el cerebro virtual ya ha podido mejorar en un impresionante 20 a 25% los algoritmos de reconocimientos de voz que Google utiliza en sus búsquedas y comandos por voz (como los que se utilizan en celulares Android o en el buscador Chrome en otras plataformas). Se espera que Google ahora aplique esta tecnología para mejorar sustancialmente la búsqueda visual de imágenes en su buscador, el cual ahora en vez de encontrar imágenes basadas en el nombre de estas, o en crudos patrones visuales, podrá literalmente entender qué es lo que quieres buscar y encontrarlo de forma visual como lo encontraría un ser humano. Similarmente, esto podría mejorar de forma notable tecnologías como los Google Cars, autos que se manejan solos, y que si entienden mejor el contexto del mundo exterior pueden hacer un mejor trabajo del que ya hacen para no solo moverse mejor, sino que informarse mejor e informar mejor al usuario del medio ambiente en donde se mueve el vehículo. Esto de paso sería tremendo para el proyecto Google Glass (las gafas inteligentes de Google, similar al concepto del IrixPhone del cual les hablé hace un par de años), puer permitiría no solo que estas te entiendan mejor, sino que incluso entiendan el mundo en el cual te desenvuelves (relacionado) Google agrega que este sistema aparte de mejorar su interpretación del mundo en contextos específicos, puede además incluso inferir con datos erróneos o faltantes ciertas cosas, lo que le permite deducir palabras en oraciones de preguntas que se le hacen, aun con datos insuficientes. Así que por ejemplo, si dices la frase "Me comí un buen pan con anterriquirrrlla", el sistema correctamente entendería que quisiste decir "Me comí un buen pan con mantequilla" debido a que entiende el contexto de comida bajo el cual estás hablando. Finalmente, Google aclara que esto no significa que en términos generales este Cerebro Virtual sea más inteligente que un ser humano, pues no puede razonar ni hacer cosas básicas fuera del contexto bajo el cual fue entrenado, pero sin embargo en los contextos en los cuáles sí ha sido programado (como el reconocer imágenes) el sistema ha demostrado ser más eficiente que humanos... fuente autor: josé elías |

|

|

|

|

"[...] Gracias por todo lo que compartes y en mi persona has dejado un legado, "la lectura"."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax