Tecnología Visual

|

viernes, agosto 28, 2009

|

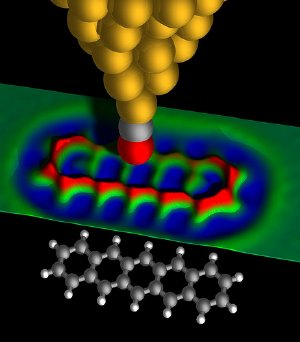

IBM acaba de agregar otro gran hito a su extraordinario historial de avances científicos, esta vez habiendo logrado algo que hace apenas dos décadas atrás se consideraba prácticamente imposible: "Fotografiar" en 3D los enlaces de un grupo de átomos. Es decir, captar visualmente la manera en que se percibirían un grupo de átomos y los enlaces entre ellos, o lo que llamamos su estructura química en este caso. IBM acaba de agregar otro gran hito a su extraordinario historial de avances científicos, esta vez habiendo logrado algo que hace apenas dos décadas atrás se consideraba prácticamente imposible: "Fotografiar" en 3D los enlaces de un grupo de átomos. Es decir, captar visualmente la manera en que se percibirían un grupo de átomos y los enlaces entre ellos, o lo que llamamos su estructura química en este caso.En este caso lo que se captó fue una molécula de pentaceno, la cual mide 1.4 nanómetros de largo (es decir, un 1.4 mil-millonésima de un metro). Para tomar esta asombrosa primera imagen, IBM utilizó una aguja voladiza de silicio rebestida de dióxido de carbono, así como se tuvo que mantener la temperatura a 5 grados Kelvin (-268.15 Celcius, o -450.67 Fahrenheit), durante 20 horas continuas, y en un ambiente totalmente libre de vibraciones, pues el mas mínimo temblor molecular arruinaría el experimento. El objetivo de este experimento es la creación de nuevas tecnologías que permitan investigar mas de cerca los fenómenos que ocurren a nivel cuántico, pues al menos en el caso de IBM eso significa poder en un futuro no solo entender mejor las fuerzas que gobiernan el mundo cuántico, sino que desarrollar toda una nueva generación de Chips Cuánticos con un poder hoy día inimaginable. Este adelanto es sumamente importante, pues esto tiene grandes repercusiones en nano-tecnología, en particular en la creación de nano-fábricas, las cuales se utilizarían para crear nanobots, los cuales tienen una infinidad de uso, desde guardianes médicos dentro de nuestros cuerpos, hasta reconstructores del medio ambiente. Un dato curioso es que fue IBM quien por primera vez pudo manipular átomos directamente, en el 1990. Lo primero que hizo con ese adelanto fue escribir las siglas IBM, un átomo a la vez (ver imagen). Un par de notas sobre la foto: Notarán que se ve "borrosa", eso se debe a que a este nivel cuántico es imposible saber el lugar exacto de los componentes del átomo, ya que los electrones que giran alrededor del núcleo (que tampoco tiene un lugar determinado) viven en realidad en una "nube de posibilidades" en varios lugares simultáneos a la vez. Así que por mas que esto vaya en contra de nuestra intuición, lo que IBM fotografió fue "las posibilidades de que los átomos estén en donde esperamos que estén". Los puntos mas brillantes de la foto son los lugares en donde mas probable es posible que encontremos el objeto, y los puntos oscuros los menos probables. Esto concuerda con la teoría, pues mientras mas lejano del núcleo, menos las probabilidades de que un electrón se encuentre ahí. Por otro lado algo curioso es que la foto aparenta ser en blanco y negro y no a color, pero como expliqué hace un par de años, los colores que percibimos en realidad no existen, sino que son tan solo un recurso de nuestras mentes para sacarle sentido al mundo (específicamente, para clasificar las ondas electromagnéticas que llegan a nuestra retina). Abstracto del documento científico que documenta este avance Una fuente de la noticia Otra fuente de la noticia autor: josé elías |

|

|

|

|

|

miércoles, agosto 26, 2009

|

He aquí un dispositivo que sin duda encontrará un nicho en el mercado, especialmente en el sector educacional y de puntos de venta (POS). He aquí un dispositivo que sin duda encontrará un nicho en el mercado, especialmente en el sector educacional y de puntos de venta (POS).Es el DUO, un pequeño aparato que viene en dos partes, una pequeña que montas encima de la pantalla, y la otra es un lápiz electrónico. El pequeño dispositivo de arriba envía unas ondas que se reflejan en la punta del lápiz y que son captadas de regreso, información que es procesada en tiempo real para deducir las coordenadas en la pantalla sobre la cual estás escribiendo o señalando con el lápiz. El lápiz también funciona como ratón, conteniendo dos botones de fácil acceso. El DUO funciona con pantallas de hasta 17" (es una pena que no funcione con pantalla mas grandes), lo que lo hace ideal para laptops. Lo mejor de todo es el precio, el cual por menos de US$120 dólares está bastante razonable, en particular dado los precios de laptops con pantallas sensibles al tacto. Algo a notar es que no estoy seguro que esto capte información sobre qué tan fuerte presionas el lápiz en la pantalla, lo cual sería muy útil para artistas digitales. Sin embargo, aun así ya me imagino utilizando esto en clases, o en presentaciones, o en sesiones de diseños de cualquier cosa, reemplazando el papel en buena medida. Y sí, existen muchos dispositivos que hacen la misma función, e incluso con pantalla muchísimo mas grandes, pero lo que el DUO tiene a favor es el precio relativamente bajo. ¡Gracias a la lectora Claudia Rodriguez por el enlace! Página del producto Video del DUO en acción autor: josé elías |

|

|

|

|

|

viernes, agosto 21, 2009

|

La revista Esquire captará mucha atención en el próximo mes de Septiembre con el ejemplar impreso de su revista, ya que será la primera vez que debutará una tecnología que permitirá ver videos dentro de las hojas de esta. La revista Esquire captará mucha atención en el próximo mes de Septiembre con el ejemplar impreso de su revista, ya que será la primera vez que debutará una tecnología que permitirá ver videos dentro de las hojas de esta.El experimento se hará con los clientes ya suscritos en los mercados de New York y Los Angeles, y por el momento no hay planes que conozcamos de que repetirán el intento, o de si otra revista probará la misma idea. La revista contará con 5 videos, de la empresa de televisión estadounidense CBS, y de la gigante Pepsi. El usuario podrá elegir cual de los 5 videos ver presionando una parte de la página, la cual obviamente no será de papel, sino que tendrá un grosor de un pedazo de cartón, en dentro del cual habrá una pantalla de muy bajo costo (y asumo de relativa baja calidad), junto con una batería integrada, y un chip integrado capaz de almacenar hasta 40 minutos de video. Opinión: Esto no es mas que una acrobacia publicitaria (aunque muy creativa hay que admitir), y dudo muchísimo que veamos esta tecnología adoptada en gran escala, ya que es bastante costosa, y ya se puede hacer lo mismo y mucho mejor en otros dispositivos como la nueva generación de lectores de libros electrónicos, o incluso en algo como el iPhone (y eso sin hablar de netbooks y las ubicuas páginas web). De la manera que interpreto esto es de la misma manera que interpreto el "pataleo" de un pez que acaba de ser pescado y tirado dentro del barco pesquero: Por mas que patalee y se mueva, morirá. La industria simplemente debe empezar a dejar atrás los medios impresos (en la medida de lo posible, pues en algunos mercados todavía es factible por unos pocos años mas) y dedicarse mas de lleno a adoptar el mundo digital, y no solo con copias de sus medios impresos en un entorno web, sino innovando con novedosas maneras interactivas. En un artículo anterior acá en eliax ya expliqué mi opinión en mas profundidad, pero si quieren ver un ejemplo excelente de una empresa (en este caso, una empresa de medios televisivos) innovar con las nuevas tecnologias, simplemente descarguen la aplicación "Discovery" de Discovery Channel/Networks desde el App Store de Apple para el iPhone, verán como incluso conceptos muy simples le dan a los usuarios toda una nueva manera de interactuar con contenido. Fuente de la noticia Página oficial de Esquire autor: josé elías |

|

|

|

|

|

jueves, agosto 20, 2009

|

|

En Febrero del año pasado les informé la nostálgica noticia de que Polaroid, la empresa que masificó el uso de cámaras de fotos instantáneas por varias décadas, había anunciado que dejaría ese negocio para concentrarse en cámaras digitales, y que a tal fin cerraría sus fábricas de estos productos.

Pues hoy Viernes 21 de Agosto del 2009, ya cerradas las fábricas, y virtualmente agotada toda existencia, se hará un acto simbólico en donde se venderá la última cámara y el último cartucho de papel de fotos instantáneas. La venta se efectuará en la cadena de tiendas Urban Outfitters, en donde se venderán de manera conmemorativa 700 juegos de cámaras Polaroid ONE600 Classic, cada uno numerado a mano artesanalmente, y viniendo con un cartucho de película instantánea Type 779. También se venderán aparte 779 paquetes del Type 799, para los que deseen impresiones adicionales (aunque dudo estos los utilicen, mas bien los veremos en eBay como artículos codiciados por coleccionistas). O en otras palabras, hoy podríamos marcar simbólicamente el día que las cámaras analógicas (o al menos las del tipo de película instantánea) dejaron de existir, para abrir paso a las digitales, como este modelo muy similar a las de Polaroid. Así que de parte de eliax, ¡¡¡gracias Polaroid por todas las bellas (y no tan bellas) memorias captadas de manera instantánea en estas cámaras!!! Fuente de la noticia autor: josé elías |

|

|

|

|

|

domingo, agosto 16, 2009

|

Neurocientíficos de Wicab Inc, en los EEUU acaban de anunciar un dispositivos para ciegos al que llaman el BrainPort ("Puerto Cerebral"), que permite hacer algo que para muchos sería imposible: ver con la lengua. Neurocientíficos de Wicab Inc, en los EEUU acaban de anunciar un dispositivos para ciegos al que llaman el BrainPort ("Puerto Cerebral"), que permite hacer algo que para muchos sería imposible: ver con la lengua.Para entender esto hay que estar conscientes de algo que he descrito en varios artículos previos en eliax, y es que (como también aclaran en el artículo fuente de esta noticia), nosotros no vemos con los ojos, sino que con nuestros cerebros. Nuestros ojos lo único que hacen es captar luz, pero es el cerebro el que interpreta estos patrones y crea una simulación del mundo exterior en nuestras mentes que aproxima a este. Esto es similar al aprender ecolocalización (como expliqué en este otro artículo en eliax), una técnica que permite que ciegos formen imágenes tridimensionales de su entorno por medio de sonidos. En este caso en particular, el paciente se pone una tableta flexible en su lengua que contiene una matriz de estimuladores. Este matriz tiene la forma de una pantalla de TV, pero con la diferencia de que los puntos de la pantalla no se iluminan, sino que estimulan la lengua.  El paciente también tiene que utilizar unas gafas especiales que contienen una cámara de video. Después lo que ocurre es que un software (programa) analiza las imágenes en tiempo real, las convierte a blanco y negro, y por cada punto de la imagen captada presiona o de-presiona un punto en la matriz colocada sobre la lengua. El paciente también tiene que utilizar unas gafas especiales que contienen una cámara de video. Después lo que ocurre es que un software (programa) analiza las imágenes en tiempo real, las convierte a blanco y negro, y por cada punto de la imagen captada presiona o de-presiona un punto en la matriz colocada sobre la lengua.Lo que ocurre después es que el cerebro, siendo un hardware elástico (programable y moldeable) empieza a notar estos patrones en relación a las interacciones al mundo exterior, y empieza a darse cuenta de que esos puntos sobre la lengua representan las imágenes del mundo exterior, y en la mente del paciente poco a poco empiezan a formarse imágenes que corresponden al mundo exterior, esencialmente convirtiendo la lengua en un ojo. Lo mas asombroso es que según la empresa, en apenas los primeros 15 minutos de una persona ciega utilizar el dispositivo, esta empieza a interpretar datos espaciales del mundo exterior. Es importante entender que esto no reemplaza un ojo normal, pero que sí provee imágenes de baja resolución, suficientes como para el paciente ser mucho mas independiente. La resolución es lo suficientemente buena como para incluso poder leer letras bien grandes. El dispositivo está pendiente de aprobación este año por la FDA (Food and Drug Administration, la entidad encargada de aprobar la venta y uso de comidas y medicinas en los EEUU), y se espera que este salga a la venta al final de este año 2009 o inicios del próximo por unos US$10,000 dólares. Y como siempre, pueden leer mas noticias de ciencia avanzada en la medicina leyendo la sección de Salud en eliax. Fuente de la noticia Video del dispositivo a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, agosto 15, 2009

|

He aquí algo que inicialmente la reacción de quien escuche dirá "¡imposible, no puede ser!", pero cuando lean la explicación ya verán la verdadera razón... He aquí algo que inicialmente la reacción de quien escuche dirá "¡imposible, no puede ser!", pero cuando lean la explicación ya verán la verdadera razón...Científicos de la Universidad de Tokyo en Japón decidieron investigar cómo nos afecta el pestañar en nuestra vida diaria, específicamente durante el tiempo que vemos una película, y los resultados fueron bastante sorpresivos... Según los resultados, en una película de 150 minutos nosotros nos perdemos hasta 15 minutos de esta con solo parpadear, o mas específicamente, por cada minuto de información visual nos perdemos unos 6 segundos. Uno dirá que eso es imposible ya que el parpadear es algo que ocurre tan rápidamente que es casi imperceptible, sin embargo (y he aquí "el truco"): Cada vez que pestañamos, el cerebro detiene el flujo de información visual por unos 450 milisegundos (es decir, casi medio segundo). Otro resultado curioso del estudio es que entre el 23 y 31% de los parpadeos de un grupo de personas viendo una película están sincronizados (es decir, que parpadean a la misma vez), lo que explica que como humanos sacados del mismo molde respondemos de una manera similar a los mismos estímulos visuales (y algo me dice que este también debería ser el caso con cualquier tipo de patrón, como los musicales). Y si quieren ver mas cosas curiosas, no dejen de visitar la sección de Curiosidades en eliax. Fuente de la noticia Crédito de la imagen autor: josé elías |

|

|

|

|

|

lunes, agosto 10, 2009

|

Una de las cosas que todos odiamos hacer es tener que ir físicamente a un banco para depositar un cheque. Ahora, al menos un banco en los EEUU (el USAA Bank) te evita tener que ir y hacerlo todo desde donde sea que estés, siempre y cuando tengas un iPhone. Una de las cosas que todos odiamos hacer es tener que ir físicamente a un banco para depositar un cheque. Ahora, al menos un banco en los EEUU (el USAA Bank) te evita tener que ir y hacerlo todo desde donde sea que estés, siempre y cuando tengas un iPhone.Lo que la empresa ha hecho es agregar una funcionalidad a su aplicación que descargas desde el App Store (la Tienda de Aplicaciones) del iPhone, que permite que tomes una foto de ambos lados del cheque, y listo. Eso lo puedes hacer desde tu casa, desde la calle, desde la playa, sin dar un paso. Ahora mi pregunta: ¿Qué esperan los otros bancos para implementar esta trivial funcionalidad? Fuente de la noticia autor: josé elías |

|

|

|

|

|

|

|

Investigadores de la Universidad de Tokyo recientemente demostraron una tecnología en el evento SIGGRAPH 2009 que sin duda es el primer paso hacia un futuro que hasta ahora solo hemos visto en películas de ciencia ficción: Hologramas que podemos sentir físicamente.

Es decir, hablamos primero de una proyección tridimensional de un objeto que aparenta flotar en el aire. Y segundo, hablamos poder "sentir" ese objeto en el aire. El truco detrás de esta implementación específica es una matriz de proyectores de ultra-sonido, los cuales tienen la particularidad de poder "enfocar" la energía del ultrasonido en un punto (o varios puntos) en específico, para crear una presión en el aire similar a como si un objeto físico tuviera presionando contra otro. El efecto final es que aparenta que algo nos está "tocando la piel". En el video será mas evidente la manera en como funciona este tecnología. Y hablando del video, es importante notar que cuando lo vean, lo estarán haciendo en una pantalla en 2D, pero si tuvieran en persona frente al dispositivo, los objetos que ven flotando se verían en 3D como la vida real, y sin necesidad de gafas, gracias a unos trucos de lentes que proyectan una imagen diferente cada cierto ángulo de visión, lo que hace que cada ojo vea una cosa diferente y se cree la ilusión holográfica. Fuente oficial de la noticia Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

|

Antes de hablar de una noticia reciente de AMD con respecto a OpenCL, y su profundo significado, veamos primero un poco de historia... Antes de hablar de una noticia reciente de AMD con respecto a OpenCL, y su profundo significado, veamos primero un poco de historia...En el 1993, un video-juego captó la imaginación de toda una nueva generación de jugadores en la PC, el juego era Doom, de ID Software. Lo fenomenal de ese juego, aparte de su ingeniosa mecánica, eran los gráficos. Estos fueron programados de tal manera que el juego exprimía hasta la última gota de poder de tu PC en aquel entonces, para convertir a Doom en uno de los primeros juegos con gráficos 3D mas o menos realistas en la PC. Sin embargo, se hizo obvio que el CPU ("Central Processing Unit", es decir, el procesador principal de tu PC, su cerebro, hoy día ejemplificado por modelos como el Intel Pentium, el Intel Core 2 Duo, el AMD Athlon, etc) no era suficiente para el tipo de cálculos necesarios para seguir progresando la industria y generar gráficos cada vez mas convincentes. En otras palabras, las demandas en mejores gráficos estaban sobrepasando el creciente poder del CPU. Es por eso que en esos días la industria de la PC empezó a tomar una idea prestada de la industria de la visualización científica en estaciones de trabajo poderosas, en esos días ejemplificadas por las máquinas de Silicon Graphics (o "SGI"), y los trabajos de pioneros como Evans & Sutherland con sus simuladores de vuelo para las fuerzas armadas. La idea era crear un co-procesador que ayudara al CPU a hacer cálculos específicos a 3D, para así dejar que el CPU se encargara solo de cálculos genéricos (como por ejemplo, la inteligencia de la simulación), y que el co-procesador se encargara de puramente la parte de visualización. O en términos mas simples, el CPU coordina y le dice a co-procesador lo que tiene que dibujar, y el co-procesador toma esos datos y los dibuja en 3D. A este co-procesador es lo que modernamente se le llama un GPU (Graphics Processing Unit). Sin embargo, los ingenieros y programadores responsables de estos GPUs se dieron cuenta de algo: El tipo de cálculos que se ejecutan en un GPU (Transformaciones Fourier, Procesamiento Stream, Transformaciones Matriciales, etc) tienen una aplicación muchísimo mas extensa que solo gráficos en 3D, ya que muchos de estos cálculos son utilizados con frecuencia en editores de sonido, en codificadores/descodificadores de video, en filtros de gráficos en 2D (como Photoshop), y otros. Así que surgió la idea del GPGPU (General-Purpose computing on Graphics Processing Units), es decir, computación genérica en GPUs, en donde la idea es agregarle a los GPUs algunas instrucciones faltantes provenientes del mundo del CPU, para hacer de los GPUs unos super-potentes CPUs adaptados al tipo de operaciones que procesa un GPU, pero casi sin ya necesitar de un CPU. Sin embargo lo que sucedió después es que empresas como NVIDIA y ATI (ahora parte de AMD) sacaron sus propios GPUs con sus propios lenguajes propietarios para programarlos, lo que dividió al industria y frenó el crecimiento de esta tecnología. Pero recientemente ocurrió algo extremadamente positivo que sacudió la industria y puso a todos a caminar al mismo compás: OpenCL. OpenCL es un lenguaje genérico de bajo nivel que estandariza el poder programar para GPUs de una manera independiente del proveedor. Pueden pensar de OpenCL como el equivalente a programar en bajo nivel de Assembly para la arquitectura x86, en donde programas para la x86 funcionan en chips de Intel y AMD, aun estos sean diferentes. Sin embargo, el impulso mas grande para OpenCL lo obtuvo cuando el año pasado Apple anunció que su próxima gran versión de OS X (la versión Snow Leopard que sale próximamente) vendrá con soporte nativo para OpenCL, lo que hará de OS X una super-potente plataforma para todo tipo de cálculos multimedia y científicos cuando este esté instalado en un equipo que contenga un GPU moderno (o CPU multi-núcleos como hablaremos en un momento). Y con eso llegamos al día de hoy, y la noticia que les quería comentar hoy: AMD recientemente anunció que tiene un SDK (kit de desarrollo para programadores) que permitirá que compiles tu código de OpenCL, y hacer que este no solo funcione en un GPU, sino que además en un CPU de multi-núcleos, y sin recompilar la aplicación, con un binario universal. Esta es una noticia importantísima porque significa que: 1. Las PCs que no contengan un GPU (como ocurre con muchas laptops) podrán tomar ventaja de programas que requieran un GPU, aun funcionen un poco mas lento. 2. Será posible tomar ventaja de la nueva generación de CPUs que vendrán con 6, 8, e incluso 32 o mas núcleos para combinar todo ese poder con el poder del GPU (el cual por sí mismo viene con varios núcleos) para efectivamente optimizar al máximo todo el hardware tu PC. Es decir, esto devuelve otra vez la importancia al CPU, lo que significa que pondrá mas presión a los fabricantes como AMD e Intel en fabricar CPUs con mas funcionalidad prestada del GPU en sus diseños de CPU. O en otras palabras, nos acercamos a un futuro en donde no habrá mucha diferencia entre ambos, y en donde podremos mezclar CPUs y GPUs a nuestro antojo según nuestras necesidades. Y sobre la nota de OpenCL en OS X, sucede que Apple implementó OpenCL de tal manera en Snow Leopard, que este ya hará esto que promete AMD hoy. Es decir, OS X automáticamente asignará tantos núcleos del CPU y GPU pueda a cualquier programa de OpenCL, lo que será genial poder ver en persona en un equipo potente cuando este salga al mercado en Septiembre. La buena noticia de hoy sin embargo es que ahora gracias a AMD los usuarios de Windows también podrán disfrutar de esta funcionalidad, la cual funcionará igual de bien tanto en CPUs de AMD como de los de Intel. Y como siempre, pueden leer mas de mis opiniones y análisis en la sección bajo ese nombre a la derecha de la página principal de eliax. Página oficial de esta tecnología en AMD Nota de Prensa Oficial de AMD sobre este avance Fuente de la noticia sobre AMD y OpenCL en CPU y GPU Video de AMD a continuación demostrando esto en un 4 procesadores Opteron de 6 núcleos cada uno (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, agosto 9, 2009

|

Hace apenas unos días que Google demostró su tecnología 03D para crear gráficos acelerados en 3D para la web, y ya tenemos información de otra tecnología similar, WebGL, del Khronos Group, la misma gente de OpenGL, el lenguaje 3D que compite directamente contra DirectX/3D de Microsoft, y que es soportado hoy día de una manera u otra en Windows, OS X y Linux, así como en dispositivos como el iPhone (con OpenGL ES). Hace apenas unos días que Google demostró su tecnología 03D para crear gráficos acelerados en 3D para la web, y ya tenemos información de otra tecnología similar, WebGL, del Khronos Group, la misma gente de OpenGL, el lenguaje 3D que compite directamente contra DirectX/3D de Microsoft, y que es soportado hoy día de una manera u otra en Windows, OS X y Linux, así como en dispositivos como el iPhone (con OpenGL ES).Lo que WebGL plantea es exactamente lo mismo que O3D: Acceso directo a gráficos en 3D acelerados por tu tarjeta de video, desde un API (interfaz de programación) de Javascript. Es tanto así que recomiendo lean el artículo de estos días pasados en donde hablo del Google O3D, pues muchas de las cosas que expliqué en ese artículo aplican a este. WebGL planea ser un interfaz directo al API de OpenGL ES 2.0 (el utilizado en dispositivos como el iPhone, y considerado una versión mas ligera que OpenGL estándar), lo que significa que a los programadores familiarizados con OpenGL / OpenGL ES se les hará relativamente fácil adoptar el nuevo estándar bajo Javascript (y Javascript por su cuenta es relativamente similar a C y Java, lo que hace la adaptación aun mas fácil). La gran diferencia sin embargo entre O3D y WebGL es que O3D es muchísimo mas simplificado, permitiendo generar gráficos en 3D con muchas menos lineas de código, y con mucha menos complejidad, razón por la cual Google dice que su visión es que O3D y WebGL coexistan, en donde cada uno sea utilizado para propósitos diferentes. Algo interesante de WebGL es que el Khronos Group planea hacer esta tecnología gratuita, por lo que espera sea adoptada rápidamente por la industria. Y hablando de adopción, entre las empresas que ya han expresado su apoyo se encuentran el mismo Google, NVIDIA, AMD (ATI), Ericsson, Mozilla y Opera. Las primeras implementaciones estarán disponibles a mediados del 2010 para Google Chrome y Firefox. Noten que a diferencia de plugins (extensiones) como Flash, que todo navegador que venga con soporte para WebGL (y O3D) podrá utilizar esa tecnología directamente desde Javascript, sin complicaciones adicionales. Así mismo noten que con el incremento en rendimiento de Javascript (que pronto obtendrá velocidad casi como aplicaciones nativas), y con todo el auge que HTML 5 está teniendo, que este es otro paso mas a la inevitabilidad de que en un futuro no lejano casi todas nuestras aplicaciones, sin importar su tipo, funcionarán dentro de un navegador web, lo que solo puede significar una cosa para los consumidores: Un gran avance, pues nos libera de plataformas propietarias de una vez por todas... Fuente de la noticia Página oficial del Khronos Group autor: josé elías |

|

|

|

|

|

miércoles, julio 29, 2009

|

Uno de los problemas de tomar fotos nocturnas con un cámara y un flash es el resplandor que este emana para poder iluminar la escena que se quiere fotografiar. Uno de los problemas de tomar fotos nocturnas con un cámara y un flash es el resplandor que este emana para poder iluminar la escena que se quiere fotografiar.Ahora, gracias a las últimas tecnologías digitales, un equipo de New York University acaba de crear un novedoso nuevo sistema de flash que cuando se dispara no emite ninguna luz visible. Es decir, el efecto es como si alguien te tomara una fotografía de noche sin disparar el flash, y aun así tu saldrías como si alguien disparó un flash. Para que esta tecnología funcione, tuvieron que hacer un par de modificaciones a la unidad de flash, y a la cámara. Al flash el cambio que se le hizo fue ponerle una lámpara que emita luz en frecuencias mucho mas amplias que las normales (es decir, mas allá de la luz visible que percibimos los humanos) y después filtraron toda la luz visible. En otras palabras, este flash solo emite luz no visible por humanos. En cuanto a la cámara, simplemente removieron un filtro común en todas las cámaras digitales que se asienta entre el sensor que capta la imagen y el lente, y que por lo general está diseñado para filtrar luz infrarroja y ultravioleta. Después de esas dos modificaciones, inicia la magia: El primer paso es tomar una fotografía con estas modificaciones, sin embargo aunque las imágenes salen claras y detalladas, estas salen muy similar a esas imágenes de "luz nocturna" que vemos en las películas, en donde todo aparenta salir monocromático y los ojos de las personas se ven extraños. Ver un ejemplo de este primer paso aquí. Sin embargo, en el segundo paso, justo después de haber disparado el flash invisible, se toma otra fotografía de alta sensibilidad y sin flash. Esta segunda fotografía se ve como cualquier fotografía que uno tome de noche sin flash, bien oscura, con los pixeles "de mala calidad", pero (y esta es la segunda parte primordial del truco) al menos esta segunda fotografía contiene información de color del sujeto fotografiado. Ver un ejemplo de este segundo paso aquí. Lo que sucede entonces en un tercer y último paso, es que un software de alta velocidad procesa ambas imágenes, y combina la claridad de la primera fotografía casi monocromática, con la información de color de la segunda. Es decir, el sistema literalmente utiliza la segunda fotografía para "pintar" la primera. El resultado es una fotografía a color, pero tomada en oscuridad y sin flash visible. Ver el resultado final aquí, y comparen con esta otra fotografía tomada de la manera tradicional. Obviamente el resultado no es tan bueno como con un flash real, pero dado las ventajas, esto puede ser bastante útil en muchos escenarios en donde un flash visible no es apropiado. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, julio 28, 2009

|

Hasta ahora solo han existido lásers de color rojo y azul, pero debido a razones técnicas que van mas allá de este artículo ha tomado unos 15 años el poder desarrollar un láser de color verde, pero ese hito por fin lo alcanzó un equipo de investigadores japoneses, y las implicaciones en al menos sistemas de proyección son enormes. Hasta ahora solo han existido lásers de color rojo y azul, pero debido a razones técnicas que van mas allá de este artículo ha tomado unos 15 años el poder desarrollar un láser de color verde, pero ese hito por fin lo alcanzó un equipo de investigadores japoneses, y las implicaciones en al menos sistemas de proyección son enormes.Pero antes que todo, algunos dirán "¡pero he visto con mis propios ojos lásers de color verde, los venden baratos en cualquier tienda de hacer bromas!". Pues sucede que esos no son verdaderos rayos láser, sino que un truco en donde se duplica la frecuencia de un rayo infrarrojo para obtener algo parecido a un láser verde. Con este nuevo descubrimiento ya es posible crear un verdadero láser verde en un solo diodo. Los lectores mas técnicos notarán que ya que tenemos verde, que hemos completado el "trío sagrado" de tecnologías de despliegue visual, el famoso "RGB" (que por sus siglas en inglés significa Rojo, Verde y Azul). Esto efectivamente significa que ahora se podrán crear proyectores de todo tamaño y gran calidad a muy bajo costo. Hoy día por ejemplo los prototipos de televisores láser utilizan todo tipo de filtros para crear la luz verde, pero con esto ya no es necesario ese paso, y además se hace todo muchísimo mas eficiente energéticamente hablando. Inclusive, ya podemos imaginarnos desde hoy proyectores que caben en una caja de fósforo y que desplieguen una imagen igual o superior a los mejores proyectores de la actualidad, y a un precio en un futuro de quizás menos de US$100 dólares. Esto significa toda una revolución en el mundo de tecnologías visuales. A los curiosos que se pregunten como funcionaría un proyector de este tipo, pues la respuesta es similar a como funcionan los televisores "de tubo de electrones" tradicionales (es decir, los que no son planos y hemos tenido por décadas). En esos televisores la imagen se forma gracias a una pistola de electrones que dispara simultáneamente tres haces de electrones al mismo punto de la pantalla. Esos tres haces de electrones como se pueden imaginar producen diferentes niveles de intensidad de color Rojo, Verde y Azul, produciendo un punto en la pantalla de un color determinado. Ese primer punto se muestra en la esquina superior izquierda de la TV. Después, el siguiente punto se pone al lado de ese, a su derecha, y cuando se termina una fila de puntos se continúa con la siguiente (ignoremos un efecto de "interlazado" por ahora, pues no es necesaria para esta explicación), hasta llegar al último punto en la esquina inferior derecha de tu TV, formando una imagen. Ese proceso sin embargo se hace bastante rápido, unas 25 a 60 veces por segundo dependiendo de la tecnología utilizada, pero el efecto es el mismo: Se dibuja cada punto tan rápidamente, que durante ese breve período de tiempo nosotros lo que notamos es toda una imagen completa en movimiento. Similarmente, con estos lásers, se haría algo similar, nada mas que en vez de utilizar electrones, se utilizarían lásers, proveyendo una imagen muchísimo mas nítida, con un contraste y gama de colores muchísimo mayor. Otra técnica que es la que se utiliza hoy día con proyectores láser es disparar varios haces de láser de distintos colores a diminutos espejos en un chip que son los que reflejan los distintos puntos en la pantalla. Esto es similar a la tecnología DLP de Texas Instruments. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, julio 21, 2009

|

Como parte de las celebraciones mundiales para celebrar el 40 aniversario de la llegada del ser humano a la Luna, Google acaba de lanzar "Moon" (Luna) dentro de Google Earth ("Moon in Google Earth"), un módulo que no solo te permite explorar la superficie lunar, sino que además revivir parte de la experiencia de ser un astronauta... Como parte de las celebraciones mundiales para celebrar el 40 aniversario de la llegada del ser humano a la Luna, Google acaba de lanzar "Moon" (Luna) dentro de Google Earth ("Moon in Google Earth"), un módulo que no solo te permite explorar la superficie lunar, sino que además revivir parte de la experiencia de ser un astronauta...Moon es un módulo de la última version 5.0 de Google Earth. Página oficial de Moon in Google Earth Video de Moon for Google Earth (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, julio 20, 2009

|

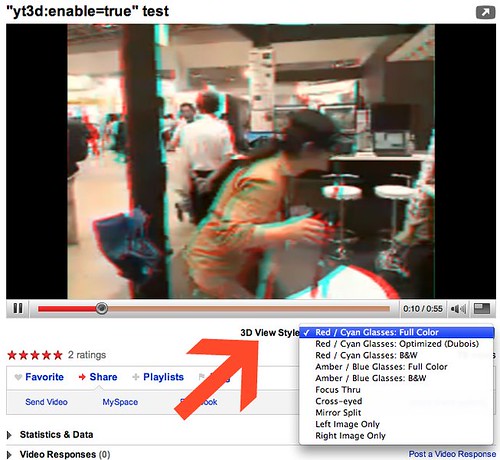

Google está en estos momentos experimentando con algunas personas con videos tridimensionales en YouTube, y haciéndole en grande, soportando varias maneras alternativas de ver el efecto 3D, desde los icónicos lentes rojo y azul de los 1960s, hasta los enloquecedores métodos de "cruzar los ojos". Esperemos ahora que soporten técnicas mas avanzadas como gafas LCD (eso requerirá de que tu PC y tu navegador lo soporten), así como la nueva ola de pantallas LCD 3D. Google está en estos momentos experimentando con algunas personas con videos tridimensionales en YouTube, y haciéndole en grande, soportando varias maneras alternativas de ver el efecto 3D, desde los icónicos lentes rojo y azul de los 1960s, hasta los enloquecedores métodos de "cruzar los ojos". Esperemos ahora que soporten técnicas mas avanzadas como gafas LCD (eso requerirá de que tu PC y tu navegador lo soporten), así como la nueva ola de pantallas LCD 3D.Fuente de la noticia autor: josé elías |

|

|

|

|

|

|

Científicos acaban de revelar en la publicación científica Nature Materials que han desarrollado el primer retroreflector onmidireccional, o como prefieren llamarlo un "espejo universal", que literalmente refleja absolutamente todo directo y siempre a su fuente. Científicos acaban de revelar en la publicación científica Nature Materials que han desarrollado el primer retroreflector onmidireccional, o como prefieren llamarlo un "espejo universal", que literalmente refleja absolutamente todo directo y siempre a su fuente.Esto es algo que conceptualmente es difícil de entender, pero he aquí una manera de entenderlo: Si nos paramos directamente frente a un espejo, es obvio que nos vemos a nosotros mismos, pero si nos desplazamos hacia la izquierda o hacia la derecha, nosotros nos "saldremos" del marco del espejo y lo que veremos serán los objetos detrás de nosotros que se encuentren al mismo ángulo, pero opuesto, de donde estamos parados ahora. Sin embargo, con este Espejo Universal, no importa en donde nos paramos, el espejo siempre nos mostrará de frente a nosotros mismos. Esto es algo que va contra toda intuición humana, y con mucha razón, ya que este tipo de efecto no ocurre naturalmente, sino que debió ser sintetizado en el laboratorio con meta-materiales. Es decir, con materiales compuestos de otros materiales, creados artificialmente siguiendo teorías matemáticas que indicaban que debería ser posible crear este tipo de efectos. Esto es justo lo contrario de crear una capa de invisibilidad como hemos reportado antes en eliax, nada mas que en vez de "esquivar" toda la luz que le llega al metamaterial, este hace todo lo contrario que es concentrarla de regreso a su fuente. Es importante hacer notar que esta tecnología apenas se está desarrollando y que apenas se ha construido el primer prototipo, el cual por el momento no utiliza ondas electromagnéticas en el rango de luz visible (es decir, el tipo de luz que los humanos detectamos a simple vista), sino que por ahora solo funciona con ondas de microondas e infrarrojas (que no son mas que otros tipos de "luz" pero que no podemos ver con los ojos). La idea obviamente es desarrollar la tecnología aun mas para hacer posible que esta funcione también en el espectro electromagnético de la visión humana. Algunos usos prácticos de esta tecnología serían los siguientes: - Como aluden en la fuente de la noticia, con esta tecnología sería muchísimo mas seguro rastrear aviones comerciales y privados (en particular aviones y helicópteros pequeños), pues hoy día de la manera que un radar funciona es disparando ondas en todas direcciones, y algunas de esas ondas rebotan desde un objeto (como puede ser un lado del avión), y algunas de esas ondas que rebotan regresan al radar, el cual detecta "el eco" producido. Con esta tecnología sería posible revestir un avión con este material, y hacer que todas las ondas reboten de regreso al radar, haciendo la señal varias órdenes de magnitud mas fuertes y por tanto fácilmente detectables. - Otro ejemplo citado es el de utilizar esto como protección a las armas tipo láser (y me imagino que también de pulsos electromagnéticos) siendo creadas en años recientes. Con esta tecnología, si un avión le disparará un potente rayo láser a un tanque cubierto con este material bajo tierra, el laser se devolvería con su original intensidad directamente al mismo avión, destruyendo el láser que disparó. -También me imagino que una persona que estuviera explorando una montaña de nieve y tuviera un accidente, pero cuyo abrigo estuviera recubierto con este material, podría ser fácilmente encontrado, ya que con solo enviar un láser al piso y mover el láser a gran velocidad escaneando toda la superficie de una montaña en segundos se podría localizar a la persona. - Otra cosa que me imagino es una tienda de ropa con un solo espejo en una pared, pero que "mágicamente" todas las personas que miren en su dirección siempre se verán a ellos mismos. Es decir, un solo espejo que podrá ser utilizado a la vez por tantas personas estén en linea de visión con el espejo, sin tener que estar uno solo justo frente al espejo. Esto terminaría con el problema de tener que esperar por alguien para utilizar un espejo de una vez por todas. También sería genial poner estos espejos encima de esos "probadores de lentes/gafas/espejuelos" que vemos en la tiendas. Como ven con este adelanto, la ciencia está yendo cada vez incluso mas allá de nuestros sueños mas descabellados de la ciencia ficción, y ofreciéndonos cosas que poco tiempo atrás pocos se abrían siquiera imaginado fuera posible... Abstracto oficial del documento científico Fuente de la noticia autor: josé elías |

|

|

|

|

|

jueves, julio 2, 2009

|

Los responsables de MacRummors acaban de descubrir unas patentes de Apple que apuntan a un futuro bastante emocionante para el iPhone y su linea de iPod Touch y MacBooks, así como para futuros productos. Los responsables de MacRummors acaban de descubrir unas patentes de Apple que apuntan a un futuro bastante emocionante para el iPhone y su linea de iPod Touch y MacBooks, así como para futuros productos.Para empezar, Apple aparenta estar desarrollando tecnología que permitirá uno de los sueños mas deseados por todo geek por años: Una pantalla que se transforma al nivel de pixeles, en formas que salen de la pantalla y con las cuales puedes interacturar (similar a esto, pero muchísimo mas avanzado). Es decir, que si queremos un teclado telefónico, que la pantalla misma no solo dibujará el teclado como lo hace hoy día, sino que un teclado literalmente surgirá como una protuberancia desde la misma pantalla, de modo que tendrás teclas reales para presionar. Lo mejor de esto es que no solo aplica a botones o formas cuadradas. Por ejemplo, la patente menciona el poder implementar un rueda circular virtual similar a la que vemos en casi todos los modelos de iPhones actuales. Combinen esto con la capacidad de estas formas poder sentir el tacto como hoy día, y las posibilidades son infinitas y emocionantes. Un uso práctico que sin duda me puedo imaginar es en video juegos, en donde el programador del juego puede "dibujar" cualquier tipo de control que se pueda imaginar, y hacer que ese control surja de verdad desde la pantalla, para que uno pueda literalmente sentir los controles, haciendo de la experiencia algo mucho mas natural. Otro uso de esto es en una computadora que sea solo una pantalla, o quizás dos pantallas, en donde una de ellas se pueda utilizar como pantalla o como teclado a la misma vez, creando de esa manera un dispositivo extremadamente elegante, sencillo y práctico (similar a este concepto). Recuerden que esto es solo una patente, por lo que si Apple decide implementar esto en serio es posible que tengamos que esperar unos años antes de ver esto en una forma práctica y un producto real. Otra patente interesante es la de un lector RFID. Un dispositivo RFID no es nada mas que un micro chip super barato (la idea es que cuesten mucho menos de un centavo de dólar) que tienen un número serial único y que se puede meter dentro de cualquier cosa, como ropa, dispositivos electrónicos, cajas, etc, lo que entre muchos usos prácticos es algo que haría realidad el sueño de que empresas tengan un inventario automatizado y fácil de seguir. Por último, en otra patente hablan de un reconocedor de huellas digitales, pero que va mas allá de lo que se ve a simple vista. Por ejemplo, a primera vista uno diría que esto es simplemente para autenticar un usuario con un iPhone (o MacBook), de modo que solo tu (o personas autorizadas) puedan utilizarlo. Sin embargo, Apple va mas allá, permitiendo poder reconocer en tiempo real las huellas de todos tus dedos, de modo que cada dedo de tu mano pueda significar una acción diferente, lo que también se le puede sacar provecho en todo tipo de aplicaciones. Por ejemplo, como citan en la patente, de esta manera podrías manipular tu iPhone o iPod sin necesidad de ver la pantalla para ciertas acciones, ya que (por ejemplo) con solo presionar la pantalla en cualquier lugar con tu dedo índica eso podría activar el tocar o pausar una canción, pero con otro dedo la podría adelantar, y con otro saltar, etc. En otras palabras, Apple continúa dando señales de que no detendrá su tren de innovación, al cual todo los competidores tratan continuamente de seguir... Fuente de la noticia autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax