Tecnología Visual

|

martes, abril 7, 2009

|

|

He aquí un software que podrá ser disfrutado por muchos. Es la versión 1.0 de Ultimate Papercraft 3D, un programa que te permite tomar modelos en 3D generados en computador, y poder imprimirlos en hojas de papel normales, con instrucciones para que los recortes los modelos con tijeras, y los dobles de tal manera que termines con un objeto "sólido" similar al que ves en 3D en la pantalla de tu ordenador. ¿Genial no? :)

Puedes importar modelos 3D en estos formatos: Collada DAE, Autodesk FBX/3DS, Autocad DXF, Lightwave LWO, WaveFront OBJ, DirectX, Stereo Lithography STL, Metasequoia MQO, y Ultimate Unwrap3D U3D. Los creadores de este software ofrecen una versión comercial por casi US$40, pero también ofrecen una versión "demo" gratuita. ¡Gracias Emmanuel Bretón por el excelente enlace! Página oficial de Ultimate Papercraft 3D Fuente de la noticia autor: josé elías |

|

|

|

|

|

sábado, abril 4, 2009

|

|

Un Agujero Negro es uno de los objetos mas fascinantes y extremos del Universo. Este no es nada mas que una estrella que colapsó sobre sí misma debido a sus propios efectos gravitacionales (es como si el suelo debajo de nuestros pies empezara a "caer" hacia el centro de la Tierra debido a la atracción de su centro), creando una masa tan compacta y masiva, que esta termina "doblando" el espacio-tiempo a su alrededor.

Lo curioso de estos objetos sin embargo es que tienen unos campos gravitacionales tan intensos, que nada que se les acerque escapa a su "horizonte de eventos" (o para decirlo en términos mas entendibles, a su "atmósfera"). Esto incluye inclusive la luz, la cual es desviada a su interior sin poder salir, lo que hace que estos objetos no emitan luz y por tanto se les denomine "agujeros negros", ya que a simple vista aparentan invisibles. Así que hoy los dejo con este asombroso video que se creó en base a una simulación de las ecuaciones de Einstein, que muestra qué vería un ser humano mientras este es "tragado" por un Agujero Negro. Obviamente un ser humano fallecería (sería estirado como una tira de hule) antes de ver todo lo que vemos en el video, pero eso es lo bueno de la simulación, que nos permite ver cosas que de otra manera no pudiésemos ver. El video fue creado por Andrew Hamilton y Gavin Polhemus de la Universidad de Colorado en Boulder, EEUU. Este es un video tan interesante como otro que les puse aquí en eliax hace 4 años que les muestra lo que veríamos al viajar a la velocidad de la luz. Nota sobre lo que ven en el video: Notarán que en el video las imágenes aparecen como si fueran "curvadas", similar a lo que vemos por un "ojo de pescado" en una puerta de seguridad. Esa distorsión no es un error o una forma de "conceptualizar" lo que veríamos, sino que es verdaderamente la manera en como veríamos el Universo, ya que el campo gravitacional del Agujero Negro distorsiona el espacio (y el tiempo) a su alrededor. Esto es similar a que si pusiéramos una pesada bola de boliche en el medio de tu cama, y esta creara un curvatura (o agujero) en el medio de la sábana. No dejen de visitar mañana para un artículo que tiene que ver mucho con este, en donde contestaré en detalle la pregunta "¿Qué es la Gravedad?". Video a continuación... autor: josé elías |

|

|

|

|

|

sábado, marzo 28, 2009

|

|

Desde que se finalizó la especificación 1.0 de OpenCL todos hemos esperados con ansias ver los primeros frutos de esa tecnología.

Como les informamos ya varias veces en eliax, OpenCL es un nuevo tipo de lenguaje de programación universal para tomar ventaja de los procesadores altamente paralelizados de las mas recientes generaciones de las tarjetas de video de NVIDIA y AMD/ATI. Apple es la empresa a la cabeza de OpenCL, razón por la cual la próxima versión del Mac OS X que sale este año estará optimizada para esta tecnología. Pues en el video que verán a continuación, la empresa Havok (creadora de herramientas de programación para la industria de los video-juegos) acaba de presentar una demostración que muestra el poder de esta tecnología. En el video verán como se calcula en tiempo real y de manera realista la tela de la ropa que tiene puesto la modelo virtual. Mas asombroso aun sin embargo, es que conforme avanza el video verán que estos cálculos son replicados decenas de veces con mas modelos, todo en tiempo real y a 60 cuadros por segundo. Esto que verán sin duda es una simple muestra del tipo de gráficos que podremos esperar en la próxima generación de video-juegos y otro tipo de aplicaciones (como editores de gráficos y animaciones 3D). ¡Gracias Emmanuel Bretón por el enlace! Video a continuación (enlace YouTube)... Previamente en eliax: Detalles de la nueva versión de Mac OS X, "Snow Leopard" (Junio 2008) Finalizada la especificación OpenCL 1.0 en tiempo récord (Diciembre 2008) CausticRT promete raytracing 3D en tiempo real en una PC (Marzo 2009) autor: josé elías |

|

|

|

|

|

martes, marzo 24, 2009

|

El año pasado les hablé de una tecnología que prometía en un futuro cercano el poder renderizar ("dibujar") gráficos en 3D por Internet hasta tu casa mientras interactuabas con ellos, y ahora una empresa de nombre OnLive acaba de anunciar una solución basada en este concepto que podría revolucionar la manera que pensamos de una consola de video-juegos. El año pasado les hablé de una tecnología que prometía en un futuro cercano el poder renderizar ("dibujar") gráficos en 3D por Internet hasta tu casa mientras interactuabas con ellos, y ahora una empresa de nombre OnLive acaba de anunciar una solución basada en este concepto que podría revolucionar la manera que pensamos de una consola de video-juegos.El sistema de OnLive se puede resumir en lo siguiente: Un sistema que ejecuta todo el código de un video-juego de manera remota en una nube de servidores potentes, generando estos servidores en tiempo real los gráficos del video-juego, y después enviando en tiempo real por Internet estos gráficos hasta tu casa por medio de una conexión de banda ancha, y (esto es lo importante) permitiéndote a ti interactuar con un control de video-juegos en tu casa con los gráficos que ves en tiempo real. Y lo mejor de todo, localmente no necesitarías un gran poder de computación, por lo que hasta una computadora viejita que tenga suficiente poder para conectarse al Internet y renderizar el video interactivo de OnLive sería suficiente. Es decir, conceptualmente esto es el equivalente a que alguien ponga un PlayStation 3 (o Xbox 360 o Wii o PC) al otro lado del mundo, y que estos conecten un cable de mil kilómetros de video hasta tu TV, y otros cables de mil kilómetros cada uno desde tus controles hasta la consola remota. Obviamente, cualquier persona técnica con pocos conocimientos de redes sabe que en esto juega un papel muy importante el tema de latencia en la red (es decir, cuánto tiempo le toma a un paquete de datos llegar desde tu casa a los servidores de OnLive, y de vuelta), así como el ancho de banda de tu conexión a Internet (es decir, cuantos datos puedes enviar y recibir de manera simultánea). Sin embargo, según la empresa, esta ha inventado una manera bastante eficiente de comprimir los datos visuales para hacer esto posible inclusive con una conexión de 1.5Mbps para contenido en "definición estádar" (es decir, calidad de Wii), y unos 5Mbps para Alta Definición (PS3, Xbox 360). Entre los ejecutivos que conforman la empresa están ex-empleados de Netscape, MySQL, NBC y Eidos, por lo que aparenta que esta empresa está no solo bien estructurada, sino que bien financiada. Esto además se hace evidente cuando vemos la lista de pasarela de las empresas que están apoyando esta aventura: Electronic Arts, Ubisoft, Take-Two Interactive, Warner Bros. Interactive Entertainment, THQ, Epic Games, Eidos, Atari Interactive y Codemasters. Opinión: Esta es una tecnología que posiblemente esté un poco adelantada a su tiempo, ya que depende muchísimo de una buena conexión a Internet, así como competiría contra consolas establecidas y que ya están frente a los TVs de nuestros hogares, y que si duda (al menos por ahora) ofrecen una mejor experiencia que OnLive. Sin embargo, creo que un mercado podría existir para OnLive, y es para un futuro en donde el concepto de una consola de video-juegos desaparezca detrás de software, y que ya no dependa de un hardware específico de Sony, Microsoft o Nintendo. Así mismo esto podría ser útil para generar gráficos en dispositivos móviles como el iPhone sin necesidad de generarlos localmente, lo que funcionaría bien para entornos virtuales similares a Second Life (aunque manteniendo en la balanza qué consume mas batería, una conexión de red o un chip potente de gráficos local). Pero no lo duden, esta es una batalla "cuesta arriba", pues aun si la famosa Ley de Moore (que dice que el poder de computación se duplica cada 12 a 18 meses) ayudara a OnLive a ofrecer mas poder en renderización 3D, así como mejor ancho de banda, y desde servidores de mas bajo costo, hay que tener en cuenta además que la Ley de Moore también aplicará a las consolas de la próxima generación de Sony, Nintendo y Microsoft, las cuales obtendrán un poder muy superior a las de hoy día a un precio equivalente, y por tanto mantendrán al margen la calidad de OnLive con gráficos potentes generados localmente. Pero, aun con todas estas barreras, creo que existe uso para esta tecnología al largo plazo, inclusive en otros entornos como permitir que una persona desde una PC de bajo poder rente espacio en OnLive para utilizar un programa como AutoCad o Maya 3D y poder trabajar creando modelos en 3D en tiempo real por Internet. Por ahora al corto plazo creo que OnLive será solo un nicho que quizás llegue a unos pocos millones de usuarios en el mejor de los casos. Fuente de la noticia Otra fuente Actualización: Video a continuación desde Gamespot (gracias Anónimo en los comentarios por el enlace)... |

|

|

|

|

|

lunes, marzo 23, 2009

|

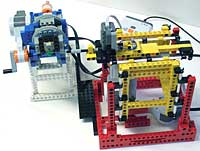

Ya saben la fascinación que tengo con los bloques de LEGO, y este hack de hoy es sencillamente genial. Ya saben la fascinación que tengo con los bloques de LEGO, y este hack de hoy es sencillamente genial.Se trata de un proyecto creado por Philo Hurbain, el mismo creador de LDraw conocido por muchos aficionados a los LEGOs, en el cual decidió crear, con tan solo los bloques de LEGO del tipo LEGO MindStorm NXT y una aguja de coser, un escaneador en 3D. Por escaneador en 3D hablamos de que si pones un objeto dentro del escaneador, este "escaneará" el objeto y lo recreará como una imagen en 3D que puedes utilizar en programas de modelaje y renderización 3D en tu PC. De la manera que esto funciona es que una aguja se utiliza para medir los puntos sobre el objeto. Es decir, la aguja se mueve de arriba hacia abajo, y cuando toca un punto en el objeto se detiene, mide las coordenadas de la aguja en tres dimensiones, y después continúa a otro punto. Esto tiene la obvia limitación de que hay que escanear una "cara" del objeto a la vez, pero como un hack, y un proyecto geek, es uno de los mejores que he visto en mucho tiempo. Página oficial del proyecto Fuente en MAKE Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, marzo 18, 2009

|

He aquí algo que hemos visto anteriormente en eliax, pero que ahora vemos en dos formas distintas, la primera siendo un modelo avanzado que puedes comprar, y otro que puedes construir tú mismo. He aquí algo que hemos visto anteriormente en eliax, pero que ahora vemos en dos formas distintas, la primera siendo un modelo avanzado que puedes comprar, y otro que puedes construir tú mismo.Hablamos de unos accesorios que pones en tus ruedas y cuando estas giran forman imágenes gracias al efecto de persistencia visual que poseemos todos los humanos. El dispositivo es bastante sencillo, consistiendo de una fila de luces LEDs (32 LEDs en el modelo comercial de Monkeylectric) que colocas en una de las varillas de la rueda de la bicicleta, lo que hace que cuando gire la rueda los LEDs se prendan y apaguen en intervalos específicos para formar todo tipo de imágenes. El aparato comercial viene con miles de patrones de imágenes, lo que hace esto genial para andar en grupo e identificar de lejos a cada uno de noche. La empresa vende el dispositivo por unos US$65 dólares. Algo que no me gusta del modelo comercial sin embargo es que aunque viene con miles de patrones visuales, que no puedes crear tu propio, sin embargo si eres una persona técnica que le gusta mojarse las manos con este tipo de proyectos, en este enlace puedes encontrar una guía para que construyas uno como este de Monkeylectric, y por tanto que lo puedas programar tú mismo. Enlace oficial a Monkeylectric Galería de fotos y videos de este dispositivo en Monkeylectric Lo puedes comprar en este enlace O construye tu propio "Spoke POV" con esta guía Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, marzo 15, 2009

|

|

En este caso el experimento consistió en hacer que varias personas "caminaran" por un entorno virtual (similar a los video-juegos en 3D), que contenía pasillos y objetos de referencia (puertas, relojes, mesas, etc), con el objetivo de que llegaran a algún punto en específico que ellos quisieran. Después se les mostraba una imagen totalmente oscura, y solo entonces se escaneaban sus cerebros, específicamente el hipotálamo, para ver quá patrones se podían identificar. El hipotálamo se eligió ya que se sabe desde hace mucho tiempo que una de las funciones de ese órgano en el cerebro es la de proveernos de información espacial (es decir, de nuestro lugar en el espacio en donde nos movemos). Lo interesante del experimento es que después de repetir esto unas cuantas veces, el programa que analizada a las personas empezó a poder predecir con mucha precisión exactamente en donde habían estado las personas dentro del entorno virtual, aun sin saber esa información de antemano. Es decir, es como si yo saliera de mi casa, llegara un par de horas mas tarde y me conectara a una máquina que me dijera con mucha exactitud en donde yo estuve, sin yo haber dicho una palabra... Por ahora la tecnología no representa un riesgo de privacidad, pues requiere de entrenamiento antes de que funcione correctamente, pero como todo sabemos, la tecnología avanza tan rápidamente que en unos años es posible que no haya nadie que nos garantice que esto no sea utilizado para fines dudosos (en particular por fuerzas militares y de inteligencia). Fuente de la noticia autor: josé elías |

|

|

|

|

|

|

La empresa Caustic Graphics recienteme reveló que ha desarrollado una nueva solución de aceleración en hardware que permitirá renderizar datos tridimensionales en tiempo real con la técnica de raytracing (para aprender mas sobre rayrtacing, escribí una explicación al respecto como parte de este artículo anterior en eliax). La empresa Caustic Graphics recienteme reveló que ha desarrollado una nueva solución de aceleración en hardware que permitirá renderizar datos tridimensionales en tiempo real con la técnica de raytracing (para aprender mas sobre rayrtacing, escribí una explicación al respecto como parte de este artículo anterior en eliax).Brevemente, hay dos maneras básicas fundamentales (aunque no son las únicas, existe también algo llamado Volumetric 3D, así como otras técnicas) de crear datos tridimensionales en una superficie plana como el monitor de tu PC. Una se llama Scanline Rendering y es la manera en que funciona el 99.99% de todos los gráficos en 3D que ves en video-juegos, desde una PC o Mac hasta el Wii o el Playstation 3, y la otra técnica se llama Raytracing. La diferencia fundamental es que con Raytracing es posible crear gráficos muchísimo mas realistas que con Scanline, razón por la cual raytracing es por lo general lo que utilizan las empresas de diseño de efectos especiales en Hollywood. El problema es que raytracing requiere de muchísimo poder de computación. Para que tengan una idea, aunque un Playstation 3 te renderiza gráficos 3D a un ritmo de 30 cuadros por segundo en alta definición, para una película como El Señor de los Anillos cada cuadro de imagen de la película posiblemente tomó varias horas. Sin embargo, debido al incesante incremento en el poder de computación, está llegando la hora en que renderizar con raytracing en tiempo real se está haciendo factible (como lo ha demostrado Intel y NVIDIA), y aunque esto aun no se puede con el poder genérico de una PC, la empresa Caustic Graphics dice haber desarrollado una solución de hardware específicamente para raytracing que lo hace en tiempo real hoy día, a una velocidad 20 veces mayor que todo lo existente actualmente, y promete para el 2010 un un sistema 200 veces mas rápido. El sistema vendrá como una tarjeta llamada la CausticOne que insertarás en tu PC o estación de trabajo. Así mismo, la empresa ha anunciado CausticCL, un lenguaje de programación y API (interfaz de programación) que extiende a OpenGL para que terceros puedan crear aplicaciones que toman ventaja de este hardware, al cual la empresa ha llamado CausticRT (que me imagino significa Caustic Real Time o "Tiempo Real"). Algo interesante es que los inventores de este sistema son ex-ingenieros de Apple, uno de ellos habiendo sido el arquitecto principal de OpenGL en el Mac OS X, y el otro el arquitecto principal de los algoritmos de renderización del iPhone, por lo que podemos deducir que estos dos deben saber muy bien lo que están haciendo... Página oficial de CausticRT Fuente de la noticia autor: josé elías |

|

|

|

|

|

sábado, marzo 14, 2009

|

|

Desde hace tiempo les he venido hablando en eliax de las asombrosas cámaras de la empresa RED, y desde el año pasado hemos estado todos esperando la salida de la cámara de bajo costo de esa empresa, la RED SCARLET, que en una de sus configuraciones vendrá a un costo de menos de US$3,000 dólares, y en un paquete "todo incluido" por menos de US$4,000.

La RED SCARLET podrá grabar video en un sensor de 2/3" a una resolución de "3k" (es decir, unas 3,000 lineas de resolución), y con un dinamic range mucho mas alto que muchas cámaras costando varias veces mas. La noticia de hoy es que la empresa ha logrado sacar el primer prototipo de la cámara del proceso de fabricación, y ya ha logrado grabar el primer video con el sensor de la cámara, el cual creo les sorprenderá. El video se grabó con el cuerpo de la SCARLET y con un lente RED PRO PRIME de 100mm. El video es en flash, y es posible que tarde entre 1 y 10 minutos en descargar (dependiendo de tu conexión a Internet) y solo dura unos 10 segundos, pero créanme que vale la pena verlo. Para los que no quieran esperar ver el video, pueden ver una imagen captada del video en este enlace. Y a propósito, según RED, esta es una imagen con mucha compresión de datos y todo tipo de artefactos, por lo que el producto final será aun mejor. Ahora disculpénme que tengo que limpiarme la baba de la boca... :) Enlace al video Fuente de la noticia Página oficial de la RED SCARLET autor: josé elías |

|

|

|

|

|

miércoles, marzo 11, 2009

|

|

En el siguiente video podrán admirar un trabajo en progreso en el MIT (Instituto de Tecnologías de Massachussetts) en donde investigadores de esa institución están creando lo que llaman un "sexto sentido" para humanos, basado en dispositivos electrónicos externos.

La idea es un dispositivo que cuelgas de tu cuello y que contiene principalmente una cámara y un proyecto. La cámara se utiliza no solo para tomar fotos y/o grabar videos, sino que primordialmente para reconocer gestos que haces con la mano y utilizarlos para que interactues directamente con el sistema, o a través de imágenes proyectadas por el mini-proyector. Como ejemplo, si quieres calcular una suma, simplemente abres tu mano, y el proyector de proyecta una calculadora en la palma de la mano, y después con los dedos de tu otra mano simplemente "punchas" los botones proyectados en tu otra mano, y ves el resultado ahí mismo en la mano. Otro ejemplo es que estés leyendo un periódico, y que al ver algo interesante hagas un "clic" en el aire con un dedo y eso haga que veas un video sobre la noticia que lees proyectado sobre el mismo papel de periódico. En otro ejemplo, si tomas un libro en la mano, el sistema se conecta a Internet y te despliega flotando sobre el libro la calificación de los lectores de ese libro en Amazon, y si abres una página del libro y vez una foto o anotación el sistema se conecta a Internet y te proyecta información adicional sobre el mismo libro (como podría ser información proveniente de Wikipedia). No dejen de ver el video que explica mucho mejor de manera visual el concepto. Si no quieren ver todo el video, simplemente adelántenlo a los 5 minutos con 15 segundos que es en donde empiezan todos los demos interesantes. Video a continuación... autor: josé elías |

|

|

|

|

|

lunes, febrero 23, 2009

|

He aquí ahora un truco que tiene poco de práctico pero mucho de geek. Es una manera de que puedes ver un video (cualquier video) totalmente en modo de texto (es decir, al estilo animaciones ASCII). He aquí ahora un truco que tiene poco de práctico pero mucho de geek. Es una manera de que puedes ver un video (cualquier video) totalmente en modo de texto (es decir, al estilo animaciones ASCII).Es decir, que los pixeles (o mas bien, grupos de pixeles en este caso) se transforman en letras, números y símbolos de colores, logrando un efecto bastante surreal, y que sin duda cuando menos alguien encontrará un uso (ya me imagino por ejemplo un Video DJ utilizando esta técnica en un concierto o discoteca). Para hacer que esto funcione simplemente requiere de dos pasos. Paso 1, instalar el mplayer con esta linea de comando: sudo apt-get install mplayer Paso 2, lanzar el mplayer en modo ASCII (aquí asumimos que vez matrix.avi) mplayer -vo caca matrix.avi ¿Fácil no? Fuente del truco autor: josé elías |

|

|

|

|

|

lunes, febrero 9, 2009

|

En eliax hemos cubiertos varios micro-proyectores, del tipo que están empezando a integrarse en celulares y otros dispositivos móviles, pero casi todos tienen la limitante de que no pueden proyectar imágenes grandes (por la falta de luminosidad) y que la resolución que ofrecen es bastante baja. En eliax hemos cubiertos varios micro-proyectores, del tipo que están empezando a integrarse en celulares y otros dispositivos móviles, pero casi todos tienen la limitante de que no pueden proyectar imágenes grandes (por la falta de luminosidad) y que la resolución que ofrecen es bastante baja.Pues ahora la empresa Explay (de la cual ya habíamos hablado en eliax hace 3 años) acaba de anunciar el Colibri, un módulo micro-proyector que tiene la suficiente potencia como para proyectar una imagen de 70" (casi el doble del tamaño de los televisores Plasma típicos de hoy día) con resolución SVGA (es decir, 1024 × 768, lo que es una aproximación razonable para ver videos de HDTV en 720p). El Colibri mide apenas 24 x 28.6 x 7mm y consume solo 1.3W de energía, y las imágenes que proyecta pueden medir de 7" a 70", a una distancia de 20 a 200cm. Así que ya saben, un día de estos veremos celulares que nos proyectan una imagen de alta definición en la casa de nuestras amistades, y que de paso enviarán sonido inalámbrico por medio de Bluetooth para tener un verdadero cine en la palma de la mano :) Otro uso para esto es para dar presentaciones estilo Powerpoint. ¿Se imaginan un vendedor de Bienes Raices andando con uno de estos en la mano? El trabajo no solo se le facilitaría sino que de paso dejaría impresionado a los clientes... Fuente de la noticia autor: josé elías |

|

|

|

|

|

miércoles, febrero 4, 2009

|

|

Google recién lanzó un nuevo servicio que todos esperábamos, en donde a través de Google Maps tu puedes visualizar dónde están tus amigos/familiares, o mas interesante aun, dónde están los amigos/familiares que mas cerca se encuentran en relación a donde tu estas en ese momento.

La idea obviamente es de tomar las coordenadas satelitales del GPS de tu unidad móvil, enviárselas a Google, y de esa manera Google poder saber dónde está todo el mundo que utilice (voluntariamente, valga la pena decir) el servicio. Según Google, esto ya está disponible en la última actualización del Android G1 de T-Mobile, en la mayoría de los dispositivos de BlackBerry, en la mayoría de los dispositivos con Windows Mobile versión 5 en adelante, en varios celulares con tecnología J2ME (como los de Sony Ericsson), y próximamente en una actualización para el iPhone. Noten además que hoy existe tecnología de triangulación celular que hace esto práctico aun sin GPS, por lo que es posible que esto se popularice rápidamente... Opinión: Esto, aparte de su obvia utilidad para uno juntarse con amigos cuando viaja (o estos viajen), o de los padres saber en dónde están sus hijos, también tiene otro lado mas interesante en el mundo de la publicidad. Es decir, con este sistema, llamado Google Latitude, si Google sabe en donde estás, y donde están tus amigos, hay muchísima información que se puede obtener automáticamente sobre ti, que Google mas adelante puede utiliza para enviarte los anuncios mas relevantes cuando hagas búsquedas en otras aplicaciones de Google. Por ejemplo, si Google nota que estás en Las Vegas, y que tus amigos andan contigo, Google podría enviarte un anuncio con un cupón de descuento para que tu "y 5 acompañantes" visiten la atracción X del hotel X de Las Vegas, generando mas dinero para Google, mas dinero para el anunciante, y posiblemente ahorrándote dinero a ti (o al menos llamando tu atención sobre algo que te gustaría). Ya me imagino esto también siendo utilizado en un futuro no lejano como evidencia en una corte: "Su señoría, tengo pruebas a través de Google Latitude de que yo y 5 de mis amigos estuvimos en Las Vegas tal día a tal hora, y aquí están las fotos para probarlo que subimos a Google ese mismo día"... :) Otra cosa que me viene a la mente es que si Google empuja la frontera un poco mas con esta tecnología, que esto podría ser un competidor viable para Twitter, ya que no solo te diría lo que hacen tus amigos/familiares/socios, sino que además en donde lo hacen. Es decir, combinar esto con un sistema de mensajería basado en Google Chat, pero al estilo Twitter, sin las restricciones de 140 caracteres, y quien sabe, hasta te de ganas de llamar por VoIP y/o Video con Google Talk. En nota final, a los que llevan cuenta, esto es parte de mi predicción #39 para este año. Página oficial de Google Latitude Aprende mas sobre Google Latitude en este enlace Video sobre Google Latitude a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, enero 31, 2009

|

Como podrán leer en el articulo a donde enlazamos con esta noticia, muchos creen que Galileo Galilei fue el primero en utilizar el telescopio para hacer mapas de los cielos y los planetas, pero en realidad hubo un inglés que se le adelantó por algunos meses en hacer el primer mapa de la Luna, después que este compró uno de los primeros telescopios jamás fabricados en el mundo. Como podrán leer en el articulo a donde enlazamos con esta noticia, muchos creen que Galileo Galilei fue el primero en utilizar el telescopio para hacer mapas de los cielos y los planetas, pero en realidad hubo un inglés que se le adelantó por algunos meses en hacer el primer mapa de la Luna, después que este compró uno de los primeros telescopios jamás fabricados en el mundo.Su nombre fue Thomas Harriot, y los mapas que verán los realizó en Julio del 1609. Sin duda alguna, un tesoro de la humanidad... Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, enero 30, 2009

|

|

El problema sin embargo es que hasta ahora para lograr eso se necesitaba de equipos especializados, y al menos de dos cámaras distintas para transmitir la imagen estereoscópica. Ahora sin embargo, un muy creativo científico de nombre Chris Harrison ha creado una manera de crear video-conferencia en "semi-3D", sin ningún tipo de hardware adicional salvo la única cámara web que ya poseas, ya que todo se hace en software (es decir, en programación). De la manera que esto funciona es en varias etapas: 1. Un algoritmo remueve el fondo detrás de ti y lo separa de ti, de modo que ahora tu imagen y la imagen de lo que está detrás de ti son independientes. 2. Lo que se envía al otro extremo ahora es una imagen estática del fondo, y un video en tiempo real de solo tu. 3. En el otro extremo lo que ocurre ahora es que la camara web te observa, y con un algoritmo de reconocimiento facial esta te sigue la cabeza para saber en donde están tus ojos en relación a la pantalla de tu PC o Laptop. 4. Esta información de saber en donde están tus ojos es ahora utilizada en tu PC/Laptop para que según tu muevas la cabeza, la imagen que recibes de la otra persona se coloque en 3D en relación al fondo de esa persona, dando la ilusión de que acorde tu mueves tu cabeza, estás viendo "detrás" de la persona con la cual estás hablando. En otras palabras, esto es muy parecido a la técnica utiliza por Johnny Chung Lee en esta noticia previa en eliax del 2007, y similar a como yo les he demostrado con mi demo de la "linterna del tiempo" en algunas de mis charlas en persona. Es importante entender que este método no produce una imagen en 3D de la persona del otro lado, sino que da una ilusión aproximada debido a que tu cerebro es engañado a creer que hay una separación real entre la persona que vez y el fondo detrás de esa persona. En el video que acompaña esta noticia se hará claro lo que sucede de manera visual. Esperemos ahora que los grandes proveedores de chat con video (como Skype, Apple iChat, Yahoo Messenger, MSN Live Messenger, etc) ofrezcan una opción similar a esto en futuras versiones de sus programas. Página oficial del proyecto Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, enero 29, 2009

|

Hoy pienso responder a algunas incógnitas que algunos de ustedes tienen sobre la relación y diferencia entre los parámetros de ISO, Apertura y Velocidad en cámaras digitales. Aunque este artículo es en especial para aquellos que quieran aprender mas sobre los modos manuales de sus cámaras, en particular las del tipo SLR/D-SLR (es decir, las que por lo general son de lentes intercambiables), lo cierto es que todo aquel que tenga una cámara digital, por mas sencilla que esta sea, es posible que aprenda algo de este "mini curso en un artículo". Hoy pienso responder a algunas incógnitas que algunos de ustedes tienen sobre la relación y diferencia entre los parámetros de ISO, Apertura y Velocidad en cámaras digitales. Aunque este artículo es en especial para aquellos que quieran aprender mas sobre los modos manuales de sus cámaras, en particular las del tipo SLR/D-SLR (es decir, las que por lo general son de lentes intercambiables), lo cierto es que todo aquel que tenga una cámara digital, por mas sencilla que esta sea, es posible que aprenda algo de este "mini curso en un artículo".Empezaré contándoles que en los días que me compré mi primera cámara (no era digital), también me compré un libro de fotografía ya que justamente quería aprender sobre los temas que comparto hoy con ustedes, y la verdad es que aunque aprendí lo que cada uno de los distintos elementos de la fotografía significaban (ISO, Apertura, Velocidad, f-stop, exposición, etc), aun me quedé con esa sensación en ese entonces de que todavía no entendía la relación entre todos ellos, y en este artículo espero poder enseñarles en unos párrafos lo que he aprendido en el tiempo con la experiencia. Hablaremos de cada uno de los conceptos importantes, no desde el punto de vista de un fotógrafo, sino desde el punto de vista de alguien que no sabe absolutamente nada al respecto y quiere aprender. Antes de empezar notemos que las cámaras analógicas (de "royos" o "de película") y las digitales son bastante similares entre sí. La única gran diferencia es que en una cámara digital la foto es captada por un sensor electrónico, mientras que en una cámara clásica la foto es captada sobre una cinta de película por un proceso químico. Aparte de eso casi todos los controles electrónicos de hoy día en las cámaras digitales modernas se venían utilizando por años (sino décadas) en cámaras analógicas, como enfoque automático, exposición automática, etc. Por tanto, casi todo lo que hablaremos hoy aplicará a cualquier tipo de cámara, salvo las excepciones que citaré. VELOCIDAD El primero concepto del cual vamos a hablar es Velocidad. En la fotografía, la Velocidad no es nada mas que por cuanto tiempo la cámara permitirá que pase luz por el lente de la cámara hasta su sensor. Para permitir que pase luz, la cámara tiene un sistema de "compuerta circular" que se cierra y abre. Cuanto mas tiempo esta compuerta esté abierta, mas tiempo durará la cámara "captando la foto", y cuanto más tiempo dure la cámara captando la foto, mas luz llegará al sensor. ¿Qué significa eso? Que si estás en un lugar oscuro, y quieres captar mejor la imagen, puedes decirle a tu cámara que dure mas tiempo captando la foto. En casi todas las cámaras puedes decirle que capte la imagen desde centésimas o milésimas de segundo, hasta varios segundos, y en algunas cámaras hasta varios minutos o indefinidamente. Así que por ejemplo, si quieres tomar una fotografía de las estrellas de noche, dile a tu cámara que dure varios segundos tomando la foto, y verás lo brillante que salen las estrellas. Inclusive es posible que tu cámara capte estrellas que no disciernes con tus propios ojos. Es importante notar que si utilizas una velocidad lenta para que entre luz por mucho tiempo a tu cámara (a esto se le llama "larga exposición", ya que la cámara está expuesta por mucho tiempo a la luz), que debes colocar la cámara en un trípode o en un lugar en donde esta no se mueva, ya que si mueves la cámara durante el proceso de tomar la foto, los movimientos de la cámara serán reflejados en la fotografía (aunque nota que para "efectos especiales", es interesante experimentar moviendo la cámara). Si haz visto fotografías en donde se ven automóviles en una autopista, con las luces de ellos "flotando" hacia el horizonte como si de un cometa se tratara, esa fue una foto de larga exposición. Inversamente, si tomas la foto bien rápido, es decir, con una rápida velocidad o "corta exposición" (ya que el sensor de la cámara está expuesto por corto tiempo a la luz), solo captarás una pequeñísima parte del tiempo, lo que es ideal para captar personas "congeladas" en el tiempo. Así que si por ejemplo quieres captar una gota de agua en el momento que esta hace contacto con el agua, lo que harías sería poner la cámara a que tome la fotografía a la velocidad más rápida que pueda la cámara. Ahora, aparte de la velocidad, ¿hay diferencia visual entre los dos modos? Pues ciertamente. Cuanto más rápido tomes la foto (es decir, mientras por menos tiempo esté la cámara captando luz), menos luz entrará al sensor, por lo que la escena que estés fotografiando es mejor que esté bien iluminada. Similarmente, en tomas de larga exposición, si la escena ya está bien iluminada antes de empezar a tomar la foto, entrará tanta luz al sensor (debido a que el sensor estará abierto por tanto tiempo captando luz) que es posible que la imagen se torne totalmente blanca. Así mismo, aun captes una imagen de larga exposición en un lugar que no esté muy iluminado, otro problema al que te enfrentarás es que cuanto más larga es la exposición, menos se puede mover lo que estás fotografiando. Un ejemplo clásico de este es tratar de fotografiar a un bebé en constante movimiento, el cual si tratas de fotografiar con esta técnica obtendrás una imagen borrosa del bebé, ya que durante toda la toma este se estuvo moviendo frente a la cámara conforme esta estuvo captando su imagen. APERTURA El segundo parámetro del cual vamos a hablar hoy es Apertura. ¿Recuerdan que les hablé de que la cámara tiene una "compuerta circular" que es la que se abre y cierra para permitir pasar o bloquear la luz a la cámara? Pues la razón que es circular es para que esta pueda cambiar de tamaño, creando o un "agujero grande" o un "agujero pequeño", mas todos los otros posibles tamaños de agujeros intermedios. En otras palabras, la cámara no simplemente abre y cierra esta compuerta, sino que además también la puede abrir a cualquier tamaño específico. Eso significa que hasta ahora hay dos parámetros a los cuales prestarle atención, la Velocidad (o cuanto tiempo mantener la compuerta abierta), y Apertura, que indica que tan abierta estará esta compuerta. Pero, ¿y por qué cambiarle el tamaño a esta compuerta? Es decir, ¿qué ganamos con poder cambiar el diámetro de la apertura entre el lente y el sensor? Hay mas de una respuesta a esta pregunta. Para empezar, ahora tenemos una nueva manera de restringir cuánta luz entra a la cámara (o lo equivalente, cuanta luz permitir entrar). Es decir, si por alguna razón nuestra cámara tiene una velocidad bien rápida y que capta poca luz, pero necesitamos que se capte menos luz aun, lo que podemos hacer es que aparte de poner la cámara en un modo de corta exposición, podemos también hacer que el agujero de la apertura sea lo mas pequeño posible, para que pase la menos cantidad de luz posible. Sin embargo, la Apertura en su uso del día a día tiene un uso mas útil, y es que nos permite controlar la "profundidad de campo" de la cámara. Esto significa, el poder hacer que una parte de la fotografía esté "enfocada claramente", y el resto que quede "fuera de enfoque". Esto es muy útil cuando por ejemplo queremos tomar una fotografía a una persona en un parque, y queremos que esa persona quede bastante bien definida, pero además queremos hacer que el fondo del parque se vea totalmente "borroso" para que así la atención se centre en la persona y no en el fondo de la imagen. La regla para lograr este efecto es esta: Cuanto más abierta está la Apertura, mas grande el "efecto borroso" será. Así que por ejemplo, si quieres lograr el efecto contrario, es decir, de que nada esté borroso y todo desde lo mas cercano a la cámara hasta lo mas lejano en el horizonte aparezca enfocado, en ese caso lo que harías sería cerrar la Apertura lo mas posible. Noten que por motivos que no voy a explicar aquí, los valores de Apertura vienen similar a estos (dependiendo de tu cámara): f1.4, f1.8, f2.4, ...... f8, f16, etc. Esto lo menciono ya que estos números no son intuitivos en el sentido de que cuanto mas grande es el número, menor es la Apertura, y similarmente, mientras mas pequeño el número, mayor la Apertura, por lo que el efecto mas "borroso" lo conseguirás (en este ejemplo) con una f1.4. Una nota final sobre Apertura y "efectos borrosos". El tamaño del sensor en sí también juega un papel importante para lograr el "efecto borroso" que a veces uno tanto busca. Mientras mas grande es el sensor, más fácil es lograr este efecto. Es por eso que se le dificulta a una cámara compacta lograr un efecto borroso, aun en una configuración de f1.8, mientras que una cámara DSLR con un gran sensor puede lograr un efecto borroso fácilmente hasta con 2.4 o superior. Esta es también la razón de por qué con cámaras de celulares por lo general todo está bien enfocado, ya que el sensor es tan pequeño que no permite desenfocar la imagen (que es lo que en realidad logra el efecto borroso). ISO El tercer concepto a entender es el de ISO. Esta no es nada mas que una manera sofisticada de decir "Sensibilidad". Cuando decimos Sensibilidad nos referimos a cuán sensible programamos el sensor para que capte la imagen, o mas bien dicho, cuánta luz puede captar el sensor en determinado tiempo. Cuanto más alta es la sensibilidad, mas sensible a la luz es el sensor. Una diferencia fundamental entre una cámara digital y una analógica, es que en la cámara digital el sensor está fijo en la cámara, y cuando cambias la sensibilidad lo que estás haciendo es "programando" al sensor para que pueda captar mas o menos luz. En el caso de una cámara analógica, no existe un sensor, sino que la imagen es plasmada en una película, por lo que es la película que compras con un valor de sensibilidad determinada. Así por ejemplo es posible que te acuerdes de los viejos tiempos en donde comprabas un royo de película con "ISO 200" (o 400, 800 o 1,600). También se le decía "ASA", como en "ASA 100" o "ASA 200". Pero, ¿y cómo se refleja en una fotografía distintos valores de ISO? Pues cuanto más alta programes la sensibilidad, mejor será el sensor captando luz, y cuanto más baja la sensibilidad, menos luz será captada. Y ahora a la próxima pregunta, ¿por qué cambiaría yo esta sensibilidad? Por dos razones fundamentales. Digamos por ejemplo que quieres captar una imagen en un ambiente oscuro, pero la Velocidad de la cámara llega solo a cierto límite para captar luz, y la Apertura solo abre hasta cierto límite para captar luz, y necesitas mas luz. La solución en este caso es incrementar el ISO de tu cámara para que esta sea mas "sensible" a la luz. Algunos ahora mismo se estarán preguntando, pero si esto de cambiar el ISO es tan fenomenal, y en la mayoría de los casos lo que quiero es captar mucha luz, ¿por qué cambiaría yo el valor de ISO? Y la respuesta es que al aumentar la Sensibilidad/ISO de la cámara, al mismo tiempo incrementas el "ruido visual" que se introduce en la fotografía. Este "ruido visual" se manifiesta como un efecto "arenoso" con muchos puntos que distraen un poco de la imagen, pero que conforme aumenta el ISO, deteriora la calidad de la imagen (aunque hay veces que uno intencionalmente ocasiona este ruido visual por motivos estéticos). Similarmente, un bajo ISO tiene el efecto adverso de producir imágenes bien "limpias" y perfectas, las cuales si les hace "zoom" en tu PC parecen mantener su fidelidad de colores sólidos y bien definidos. Una cosa a tener en cuenta es que similar a lo que puedes lograr con la Velocidad y Apertura para tomar fotos de objetos congelados en el aire a alta velocidad, que con el ISO también puedes hacer algo similar. Por ejemplo, si quieres una foto de un deportista pateando un balón, pero está oscuro por el atardecer, y por tanto no puedes incrementar la velocidad de la cámara ya que de lo contrario entraría muy poca luz, lo que puedes hacer es incrementar el ISO, para que el sensor sea mas sensible a la poca luz del lugar, y de esa manera puedes o (1) tomar la foto como antes y esta saldrá mas clara, o (2) aumentar la Velocidad ya que el ISO te acaba de dar un poco mas de luz que no tenías antes. En el día a día, el uso típico que uno le da al sensor es precisamente ese: Cuando necesitamos mas luz para lograr lo que queremos hacer con la foto, y ya no podemos obtener mas luz cambiando la Velocidad o la Apertura sin afectar la foto, lo que hacemos es incrementar el ISO, siendo el precio a pagar que la calidad de la imagen en sí es posible que se vea afectada un poco por ruido visual o "ruido digital". F-STOP ¿Ahora se preguntarán, y cómo cambio yo esos valores de Velocidad, Apertura e ISO? Pues por lo general si utilizas la cámara siempre en modo automático esta decide todos los valores por ti de manera automática, produciendo las tradicionales fotos familiares que todos poseemos. Sin embargo, si deseas tomar ventaja de lo que puede hacer tu cámara, y tomar fotos con efectos como fondos borrosos, personas congeladas en el aire, luces que se mueven en la foto, etc, entonces tendrás que dejar el modo automático y empezar a experimentar con los modos semi-manuales o puramente manuales. Los modos semi-manuales son los que por lo general se denominan "Aperture Priority" (AP) o "Speed Priority" (SP). No importa como lo llamen en tu cámara, lo que esto significa es que dependiendo del modo, la cámara te permite a ti ajustar un valor manualmente, y la cámara ajustará el otro de manera automática para que to foto salga "bien expuesta". Por ejemplo, en el modo de prioridad de velocidad, lo que haces es decirle a la cámara qué tan rápido o lento debe tomar la foto (es decir, la Velocidad), y la cámara se encarga de programar la Apertura (es decir, que tanto abrir o cerrar la compuerta circular de luz). Dependiendo de tu cámara, es estos modos semi-manuales también puedes ajustar un valor de ISO antes de tomar la foto, o dejar que la cámara elija el valor de ISO que crea apropiado, o una combinación de ambas, en donde la cámara elije un valor, pero sin pasarse de un valor máximo y/o mínimo predeterminado por ti. Cada vez que cambias uno de estos valores, lo que haces en el lenguaje de los fotógrafos profesionales es cambiando a lo que llaman el f-stop, por lo que si oyes hablar de f-stops ya saben a lo que se refieren. Noten que aunque el término de f-stop se utilizó originalmente para el valor de la Apertura de un lente, que actualmente tiene la connotación mas global que les doy acá. Lo interesante del concepto del f-stop es que es una medida útil para comparar cámaras y lentes en términos relativos. Por ejemplo, las cámaras baratas tienen mucho menos f-stops (o al menos f-stop utilizables que produzcan buenas fotografías) en comparación con cámaras de mucho mayor precio. Una cámara profesional te permite específicamente un mucho mayor rango de posibilidades de Velocidades, un mucho mayor rango de posibles Aperturas, y un mucho mejor rango de posibles valores de ISO que una cámara barata. Es preciso mencionar que aunque una cámara barata te diga que soporta un ISO de hasta 3200, que muy posiblemente una foto tomada con esa cámara sea de una calidad muy inferior que una tomada con ISO 800 en una cámara con un buen sensor. Para referencia, por lo general las cámaras toman buenas fotografías entre ISO 100 (o menor) hasta ISO 400 u 800. Las cámaras profesionales pueden tomar fotos decentes aun con ISO 1600 o incluso mayor. Pero volviendo a los f-stops, esto es algo que juega un papel fundamental en el momento de elegir equipos, y de prepararse uno a tomar una fotografía. Por lo general, lo que uno desea es poder poseer la mayor cantidad de f-stops posible (y de buena calidad), ya que esto te ofrece mas versatilidad a la hora de tomar fotografías. Por ejemplo, si con una cámara barata quieres fotografiar a un artista en un concierto de rock, es posible que con las combinaciones posibles de Velocidad, Apertura e ISO de tu cámara no puedas captar al artista claramente sin que este se vea "movido" o la calidad de la imagen sufra mucho, pero con otra cámara es posible que tengas uno o dos f-stop mas de Velocidad, lo que significa que puedes aumentar la velocidad de la cámara sin sacrificar la cantidad de luz que entra al sensor en relación a la otra cámara. Similarmente es posible que con otra cámara "ganes un f-stop" en Apertura (es decir, que el lente abra mas que la otra cámara en relación al sensor de cada cámara), lo que logra el mismo efecto de permitir mas luz con la misma velocidad. Este tema del f-stop es extremadamente importante a la hora de uno elegir un lente. Cuanto más caro es el lente por lo general es porque soporta mas f-stops, o mas bien dicho, que su Apertura es mas grande, y que el tipo de cristal utilizado es de una calidad tal que permite pasar mucho mas luz que un lente ordinario. Así que cuando alguien te dice que con tal lente ganas un f-stop en relación a otro lente, ya sabes de qué están hablando. Una nota sobre lentes: No importa que tan potente sea tu cámara, si no tienes un buen lente, estarás desperdiciando el potencial de tu cámara. Esto es fácil notar al tomar una fotografía con un lente de una cámara barata de esas portátiles y una de las profesionales con uno de esos lentes grandes. Aunque ambos tengan valores similares de acercamiento, a la hora de uno ver la calidad de las fotos la diferencia se hará bastante obvia. Cuanto mejor es el lente, mejor la calidad de la imagen ya que mejor se capta la luz, y al fin y al cabo todos los controles de una cámara lo único que hacen es manipular luz, por lo que cuanto mejor manipules la luz con buenos lentes, mejor la definición, claridad y distorsión de las fotos. Noten que existen lentes que son mucho mas caros que las cámaras mismas en donde se montan, esto debido a lo caro y preciso que es el proceso de fabricación de tales lentes (aunque honestamente, a veces me parecen abusivos los precios). Finalmente, sobre lentes es importante que sepan lo que los profesionales quieren decir cuando dice que un lente es "rápido" (o un "fast lens" en inglés). Con eso quieren decir que capta mucha luz, lo que permite que estos lentes sean óptimos no solo para una excelente calidad de imagen, sino que para captar movimientos "rápidos" como en eventos deportivos. De ahí el término. EXPOSICIÓN Por lo general en los libros y cursos de fotografías, empiezan con este concepto, pero he decidido dejarlo de último, ya que ahora con todo lo que han visto entenderán más rápidamente a lo que esto se refiere. Exposición no es nada mas que los valores de f-stop que hemos elegido para una foto en particular. Es decir, con qué Velocidad, Apertura e ISO captaremos la imagen. Cuando lean que alguien dice que tiene una "buena exposición" se refiere a que ha elegido los parámetros de f-stop adecuados para que la imagen se vea como uno desea que se vea (que no necesariamente tiene que ser una imagen clara, porque es posible que por motivos estéticos uno decida oscurecer o aclarar una imagen). Noten además que por "buena exposición" también uno se refiere por lo general a una foto en donde todos los posibles valores (desde el mas oscuro hasta el mas claro) de una imagen se representan adecuadamente. Es decir, es posible que si le tomas una foto a la cara de una mujer en medio de una playa que el sol le de tan fuertemente de un lado de la cara que en la foto el lado que recibió la luz del sol aparezca todo totalmente blanco, en vez de diferentes tonalidades de piel. En esto caso se dice que uno obtuvo una "mala exposición". Similarmente en el lado que no le da el sol es posible que la cara muestre la piel de color negro puro en todos lados, en vez de notarse los diferentes matices de la piel. En este ejemplo en particular uno puede compensar (hacer correcciones) subiendo o bajando la velocidad de la cámara, o abriendo o cerrando la apertura, o cambiando el ISO, pero mas comúnmente es este caso específico lo que se hace es que del lado oscuro de la cara uno coloca un reflector para que le de un poco de luz a esa parte oscura, y por otro lado poner una malla que cubra un poco el sol. Estos pequeños trucos son la diferencia entre una foto "casera" y una profesional, y aunque la persona común no capta inmediatamente la diferencia específica entre los dos casos, sí puede decir fácilmente cual fue tomada por un principiante y cual fue tomada por un experto. Un par de términos mas a saber cuando se hable de exposición son "overexposed" y "underexposed" (en español creo que son "sobre-exposición" y "sub-exposición", aunque alguien me corrija en los comentarios si estoy equivocado). Sea como sea que se llamen, lo importante es que estos son dos conceptos fáciles de entender. En el caso del ejemplo que dí en donde el sol hacía que toda la cara de la persona aparentara de un solo color blanco, a eso se le llama sobre-exposición, ya que "nos pasamos de exposición". En el caso de que las sombras aparentan todas con una tonalidad totalmente negra, eso es una "sub-exposición" ya que "no nos dio la exposición". Habiendo dicho todo esto, hay un par de trucos que los "Pro" utilizan que son muy útiles saber, y que tienen que ver con exposición. Por ejemplo, ¿han visto esas imágenes en donde alguien toma una foto de una cascada/catarata, o de un río, y el agua parece angelical como si fuera un "flujo de nube contínua"? Lo primero que viene a la mente es que esa fotografía debió haberse tomado con una larga exposición, ya que de esa manera se capta todo el movimiento del agua durante una exposición al sensor que dure algunos segundos. El problema es que en el momento que llevas tu equipo al río para fotografiar tu obra de arte, y pones la velocidad lenta, te das cuenta que lo que obtienes es una imagen totalmente en blanco, ya que hay demasiada luz en el ambiente, por lo que no puedes utilizar una velocidad lenta para lograr el efecto. En este caso hay dos soluciones. La mas obvia es tomar la fotografía cuando haya poca luz, sea al amanecer o atardecer, lo que te permitirá mantener el lente abierto por mas tiempo. Pero la otra manera de lograr este efecto, inclusive en un día altamente soleado, es comprar un filtro oscuro que se coloca frente al lente. Esto tiene como efecto que la imagen cuando la vez por el visor de la cámara se vea bastante oscura, pero en el momento que tomes una larga exposición la acumulación de luz en el tiempo recreará una vez mas la luz perdida por el filtro, mientras que a la misma vez logras el efecto que buscabas. En cuanto a si quieres hacer lo contrario, es decir, tomar una foto de poca duración, pero de algo que se mueve mucho y quieres congelarlo en el tiempo, la primera opción es aumentar considerablemente el ISO para que captes mas luz, pero la otra opción (y bastante cara) es comprar un "lente rápido" como descrito anteriormente. Por lo general esos lentes tienen la denomicación de "f2", "f1.8" o mejor aun "f1.4". Cuanto menor el número, mas la cantidad de luz que acepta, y mayor el precio del lente. Así que ahí lo tienen, un curso de los conceptos técnicos básicos de la fotografía condensado todo en un solo artículo. Un consejo final que les digo es que tomen sus cámaras y empiecen a tomar fotos, pues con la práctica continua es cuando se aprende mas sobre fotografía... Actualización de Mayo 2011: Dos años y medio después de escribir este artículo, alguien se ingenió una página en donde puedes simular dentro de tu navegador web el efecto de cambiar estos valores en una cámara. Pueden visitar la página en este enlace (requiere Adobe Flash para verse - esperemos que alguien se anime y cree una versión en HTML5 en un futuro) autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax