Tecnología Visual

|

viernes, marzo 28, 2014

|

Hace 3 años les informé acá en eliax de una asombrosa tecnología que ya permite grabar un video de lo que ves en tu mente, en esencia permitiendo que en un futuro tengamos tecnología para grabar sueños, o comunicar a otros seres humanos y máquinas las cosas que nos imaginamos en la mente (como describí en una Reflexión sobre lo que llamo "El Imaginatrón"), y hoy día los actualizo con otro adelanto al respecto... Hace 3 años les informé acá en eliax de una asombrosa tecnología que ya permite grabar un video de lo que ves en tu mente, en esencia permitiendo que en un futuro tengamos tecnología para grabar sueños, o comunicar a otros seres humanos y máquinas las cosas que nos imaginamos en la mente (como describí en una Reflexión sobre lo que llamo "El Imaginatrón"), y hoy día los actualizo con otro adelanto al respecto...Utilizando y refinando las mismas técnicas en el adelanto de hace 3 años (que recomiendo lean, pues contiene un sorprendente video más una explicación de cómo funciona esta tecnología), científicos de la Universidad de Yale ahora pueden no solo detectar las caras que te imaginas en tu mente, sino que reproducirlas con un grado asombroso de semejanza a la persona en la que estás pensando. Es decir, si ahora mismo te imaginas una persona que te agrada muchísimo, y te colocan este dispositivo en tu cabeza, el sistema puede imprimir en pantalla una imagen de esa persona. Esto, más allá de usos fantasiosos, tendrá también utilidades prácticas, como por ejemplo me puedo imaginar utilizar un sistema como este para extraer de la mente de criminales las caras de sus colaboradores mientras estos son interrogados. Y lo mismo podría utilizarse para obtener pistas sobre violadores, ladrones, etc. Este tipo de avances nos sirve para ponderar profundamente varias cosas, de las cuales rápidamente se me ocurren las siguientes: 1. Nos indica lo rápido que se mueve la tecnología. Hace apenas 5 años la mayoría de personas hubiese dicho que esto nunca iba a ser posible, o que si iba a ser posible que lo veríamos en cientos o miles de años. 2. Nos habla de los tiempos turbulentos que se nos avecinan en relación a temas de privacidad y seguridad personal. 3. Nos recuerda lo frágil que son nuestros cerebros biológicos, y de la necesidad de en un futuro proteger nuestras mentes ante ataques externos, o incluso la necesidad de traspasar nuestras mentes a entornos sintéticos más resistentes a este tipo de ataques (como vaticiné hace 5 años algún día ocurrirá). ¡Gracias al lector Alberto Cano por alertarme en el grupo oficial de eliax en Facebook! documento científico oficial de este adelanto Nota: Los dejo también con un video ilustrativo de la tecnología anterior de hace 3 años (que es similar a esta de las caras), que les muestra la imagen que se le presenta a una persona, y la que se extrae directamente de su cerebro, para que vean el increíble alto grado de similitud. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, marzo 25, 2014

|

Facebook hoy anunció sorpresivamente que va a comprar la empresa de realidad virtual Oculus VR (creadores de las gafas de realidad virtual "Oculus Rift") por la cifra de US2 Mil Millones de dólares. Facebook hoy anunció sorpresivamente que va a comprar la empresa de realidad virtual Oculus VR (creadores de las gafas de realidad virtual "Oculus Rift") por la cifra de US2 Mil Millones de dólares.Esto viene exactamente una semana después de Sony anunciar sus gafas de realidad virtual Morpheus, y creo que este es un excelente momento para leer mi opinión de ese anuncio, ya que esto que acaba de suceder hoy es precisamente lo que predije ocurriría con la empresa Oculus. Como dije en ese artículo anterior acá mismo en eliax, el hecho que Sony haya sacado sus gafas de VR le cerraba las puertas al Oculus Rift al mercado del PlayStation, por lo que su mejor opción sería ser adquirida por algún gigante que le pudiera abrir nuevas puertas a la empresa, y ese gigante resultó ser Facebook. ¿Facebook? Estoy seguro que muchos encontrarán extraña la selección de empresa, pues lo más probable hubiese sido una empresa de videojuegos (como Nintendo o Microsoft), u otra empresa con miras al mercado de consumidores (como Amazon o Samsung), por lo que esto hay que analizarlo... En mi opinión, esta es una jugada al largo plazo de Facebook, y una muy buena jugada, aunque en esta etapa del juego Facebook está más interesada en patentes, tecnología, y recursos humanos especializados en el área al largo plazo, que en las implicaciones prácticas al corto plazo, ya que la empresa muy bien pudo haber creado su propia plataforma, pero con esta compra adquiere no solo recursos humanos y técnicos, sino además tiempo. Pero, la gran pregunta continúa siendo ¿qué planea Facebook hacer con esto? Pues en su nota de prensa oficial, Mark Zuckerberg (el CEO y co-fundador de Facebook) nos dice que más allá de juegos, ve un futuro en donde personas puedan asistir a tomar clases de forma virtual, o asistir a un partido deportivo virtualmente, o incluso sentarse frente a un doctor cara-a-cara de forma virtual, pero esto en realidad es más grande que eso... Recordemos los inicios del Internet: Al inicio, la primera aplicación que realmente cautivó a todos fue Email. En ese entonces, "estar en Internet" significa tener una cuenta de email y poder enviar y recibir mensajes. El próximo gran paso a eso fue la Web, en donde gracias a navegadores de Internet podíamos acceder a millones de portales y ser parte de todo tipo de comunidades (como esta de eliax por ejemplo), por lo que "estar en Internet" significó ahora "navegar la web". Pero posterior a eso dos cosas en paralelo sucedieron: Entornos Virtuales, y Redes Sociales. Entornos Virtuales como SecondLife fueron (y son) populares, pero de forma limitada y entre un nicho de personas, y no ofrecen una experiencia "inmersiva" como en películas como The Matrix, y estas experiencias se experimentan desde una tercera persona (es decir, tu ves al personaje que te representa a ti en una pantalla plana en tu PC) en vez de primera persona (con gafas de VR como las del Oculus Rift, en donde tu estás "adentro" del personaje virtual en el mundo virtual). En paralelo a eso, se desarrollaron las Redes Sociales como Twitter y Facebook, en donde esta última terminó dominando a todo el mundo, en la actualidad con más de 1,200 millones de usuarios activos mensualmente, esto debido a su simplicidad y funcionalidad social que permite que cualquiera se conecte y comparta fácilmente con cualquier otra persona en el planeta. Hoy día entonces, para muchos el "estar en Internet" significa en gran medida tener una personalidad social en una red social, particularmente Facebook. Pero cualquier persona con visión del futuro sabe que tarde o temprano, los entornos virtuales son una oferta más llamativa que los entornos planos clásicos de tercera persona e impersonales a cuales estamos acostumbrados. El problema ha sido que la tecnología no ha estado a la par, ni en funcionalidad ni en precio para consumidores, pero eso empezó a cambiar con la salida del Oculus Rift, y gracias a la potencia de los más recientes GPUs (chips de procesamiento gráfico) del mercado, permitiendo por primera vez no solo mundos altamente detallados, sino además componentes ópticos que nos permiten sentir "adentro" de esos mundos. Por lo que visto desde ese punto de vista, Facebook sencillamente se está comprando un boleto preventivo para ser quien se monte en ese tren de la Realidad Virtual, cuando sea que esta despegue, pues tarde o temprano las redes sociales se transformarán en entornos de VR. Esto tendrá interesantes implicaciones con otras plataformas, pero de eso ya hablaremos en artículos futuros en eliax. Mientras tanto, a disfrutar de esta aventura, pues ciertamente estamos viviendo los momentos más emocionantes de la humanidad, y esto es tan solo el inicio... Nota: Este es un excelente momento para leer un editorial que escribí hace 7 años acá en eliax titulado "Mundos Virtuales a reemplazar el Internet WWW". autor: josé elías |

|

|

|

|

|

martes, marzo 18, 2014

|

El rumor que les informé hace unas semanas por el perfil oficial de @eliax en Twitter se hizo realidad, y hoy Sony reveló que oficialmente entrará al negocio de la Realidad Virtual con unas gafas avanzadas a las que por el momento llama "Morpheus" (Morfeo), lo que debería recordarnos al personaje del mismo nombre de The Matrix que introduce a Neo a un mundo virtual más allá de sus sentidos... El rumor que les informé hace unas semanas por el perfil oficial de @eliax en Twitter se hizo realidad, y hoy Sony reveló que oficialmente entrará al negocio de la Realidad Virtual con unas gafas avanzadas a las que por el momento llama "Morpheus" (Morfeo), lo que debería recordarnos al personaje del mismo nombre de The Matrix que introduce a Neo a un mundo virtual más allá de sus sentidos...Sony planea demostrar a Morpheus públicamente mañana miércoles en el evento GDC 2014 (Game Developers Conference 2014), en donde mostrará un prototipo de las gafas con los siguientes juegos: - The Deep, de London Studio (una simulación de buceo) - The Castle Demo, de PlayStation R&D, (juego de espadas) - Eve Valkyrie, de CCP - Thief, de Square Enix (un juego creado específicamente para Realidad Virtual) En cuanto a las especificaciones técnicas, Sony proveyó las siguientes: - Pantalla con resolución 1080p - Campo de visión de 90 grados - Seguimiento de movimiento a 1000Hz (mil lecturas por segundo) - Permite que te muevas hasta 3 metros de distancia frente al PS4 - Puedes rotar tu cabeza 360 grados completos - Coexiste con el DualShock 4 y el PS Move - Sonido verdaderamente espacial, sintetizado al simular el sonido humano - Altamente ajustable a todo tipo de cabezas - Cómodo para uso prolongado - Permite replicar lo que ves en tus gafas en la TV del PS4 - No crea puntos de peso ni en la nariz ni en los cachetes Así que como pueden ver, Sony aparenta estar muy en serio con esta entrada al mundo de la VR, y lo único que queda por ver es si han logrado obtener un tiempo de respuesta a los movimientos del usuario similar a lo que ha logrado la gente del Oculus Rift... Y hablando del Oculus Rift, sin duda que el Morpheus será comparado hasta más no poder con el Oculus Rift, y con mucha razón, pues ahora mismo son los dos únicos equipos de VR que realmente capturarán atención en el mercado este año. En mi opinión, esto le pone las cosas un tanto difícil a la gente de Oculus, pues a diferencia de Sony que ya tiene una audiencia muy específica y amplia a la cual vender su Morpheus, Oculus es por el momento es una empresa boutique moviéndose en un nicho muy específico en el mundo de la PC (mayoritariamente en el mundo de Windows). De paso esto nos dice claramente que Oculus ya no podrá vender sus gafas de VR a la comunidad de PlayStation, pues es bastante difícil que Sony apruebe juegos para el PS4 que funcionen con gafas VR de la competencia. Esto sin embargo no significa que Oculus está acabado, sino que ahora se le cierran una de las más importantes puertas para distribuir su producto. Por otro lado, el hecho que Sony haya sacado a Morpheus hace ahora a Oculus más atractiva como empresa para que alguien como Microsoft, Nintendo, o incluso Amazon adquiera. En cuanto a lo que podemos decir sobre el hecho de que la Realidad Virtual esté renaciendo, mi opinión es que sencillamente ya era hora, pues como escribí hace un par de años en un editorial, ya es hora de hacer la Realidad Virtual, real.... Finalmente, para los que llevan cuenta, esta es otra de mis predicciones para este año que se cumplen, específicamente la #15... autor: josé elías |

|

|

|

|

|

lunes, marzo 10, 2014

|

En un momento en donde todo el mundo tiene acceso al formato DVD, y Blu-ray por fin está siendo adoptado masivamente, y UHD 4k (Ultra HD) apenas está empezando a ser parte del vocabulario de los consumidores, Sony y Panasonic ahora nos presentan un nuevo formato al que llaman "Archival Disc" (en español sería como "Disco de Archivo")... En un momento en donde todo el mundo tiene acceso al formato DVD, y Blu-ray por fin está siendo adoptado masivamente, y UHD 4k (Ultra HD) apenas está empezando a ser parte del vocabulario de los consumidores, Sony y Panasonic ahora nos presentan un nuevo formato al que llaman "Archival Disc" (en español sería como "Disco de Archivo")...Este nuevo formato, inicialmente orientado "para uso profesional", promete ir mucho más allá de la capacidad de almacenamiento de los discos Blu-ray, los cuales llegan a un máximo de 50GB (en doble capa y doble lados). El nuevo formato "AD" promete en su primera encarnación almacenar 300GB (el equivalente a 6 discos Blu-ray) en un formato de doble lado con tres capas por lado, con una versión de 500GB a seguirle posteriormente, y otra de 1000GB (aproximadamente 1TB) más adelante. Ahora bien, es importante entender algo importante sobre estos discos AD que he notado muchos otros portales no han entendido: Estos discos están específicamente orientados al sector profesional, por lo que no esperen ver sus películas favoritas en resolución 4K en este formato, o cuando menos no al inicio de su lanzamiento... Estos discos, como alude su nombre, están diseñados para archivar grandes cantidades de datos en un formato óptico, por lo que serán de posible utilidad para la industria del cine, y para el sector empresarial que prefiera hacer respaldos en estos discos en vez de formatos más caros (como los discos duros) o que no ofrezcan acceso aleatorios a los datos (como las cintas magnéticas lineales). Sin embargo, el éxito de estos discos dependerá de su confiabilidad, durabilidad, disponibilidad, y precio (particularmente de los discos en sí), y no está de mal que el formato sea adoptado por varios terceros para traer equipos a precios competitivos al mercado. Sony y Panasonic planean lanzar los primeros discos y equipos grabadores y reproductores a mediados del 2015, a un precio aun no especificado. Y noten que si lo que desean es algo un poco más extremo, para almacenar datos por, digamos, mil millones de años, que entonces necesitarán otro tipo de tecnología, como esta o esta otra... :) nota de prensa oficial de Sony sobre el formato AD autor: josé elías |

|

|

|

|

|

sábado, enero 18, 2014

|

Google no deja de sorprendernos, expandiéndose a todas las áreas de la sociedad, no solo en buscadores, celulares, televisores, robots, internet y automóviles (entre otros), sino también en el renglón de la salud, y su más reciente proyecto verdaderamente será útil para cientos de millones de personas en todo el mundo. Google no deja de sorprendernos, expandiéndose a todas las áreas de la sociedad, no solo en buscadores, celulares, televisores, robots, internet y automóviles (entre otros), sino también en el renglón de la salud, y su más reciente proyecto verdaderamente será útil para cientos de millones de personas en todo el mundo.Se trata de un lente de contacto biónico que consiste en un microchip (tan pequeño que cabe en el lente de forma invisible a quien utilice el dispositivo), y un aro alrededor del lente (fuera del campo de visión ocular del paciente), que actúa como antena (asumo, para recibir ondas electromagnéticas que lo dotan de la energía necesaria para operar, así como para transmitir información de forma inalámbrica sobre sus mediciones). Este dispositivo lo que hace es medir en el ojo mismo el nivel de glucosa del paciente, para así mantener alertados y bajo control a pacientes de diabetes. Como podrán imaginar, esto es muchísimo mejor que las técnicas invasivas tradicionales para medir los niveles de glucosa de los que sufren de esta anomalía. Estos lentes de contacto biónicos ya están siendo probados para la aprobación de la FDA de los EEUU, y son parte de uno de los innumerables proyectos de los laboratorios GoogleX, en donde se desarrollan cosas "con gran potencial aunque no necesariamente con un gran retorno a inversión al corto plazo". Google no tiene planeado comercializar estos lentes, sino asociarse a empresas interesadas en el sector médico que quisieran traerlos al mercado. Ahora bien, es bueno notar que aunque esto definitivamente nos será útil, que esto de paso ayuda a Google a acercarse más a las tecnologías que necesita para ir un paso más allá de sus gafas inteligentes Google Glass, y acercarse más a la visión del IrixPhone que por años les he comentado en eliax. Esto por ejemplo serviría de base para una futura generación de lentes de contacto biónicos que incorporarán pantallas, sensores, y potentes sistemas computacionales para crear una experiencia inmersiva de toda la información a nuestro alrededor, combinando lo mejor de la Realidad Virtual con la Realidad Aumentada, y de paso fusionando aun más los productos y servicios de Google en nuestras vidas... ¡Gracias al lector Marcos Méndez por el enlace a la fuente! fuente autor: josé elías |

|

|

|

|

|

viernes, enero 10, 2014

|

En la industria de videojuegos, más allá de todo el habla de las nuevas consolas de Sony y Microsoft (el PlayStation 4 y el Xbox One), quizás lo más emocionante del mercado esté ocurriendo en otro lugar, o más propiamente dicho, en dos lugares, por un lado con el concepto de Steam Machines de Valve, y por el otro el visor de realidad virtual Oculus Rift. En la industria de videojuegos, más allá de todo el habla de las nuevas consolas de Sony y Microsoft (el PlayStation 4 y el Xbox One), quizás lo más emocionante del mercado esté ocurriendo en otro lugar, o más propiamente dicho, en dos lugares, por un lado con el concepto de Steam Machines de Valve, y por el otro el visor de realidad virtual Oculus Rift.Y es mi opinión que estas dos tecnologías y empresas están hechas el uno para el otro, pero como a veces sucede en la vida, eso no significa que las circunstancias permitan que terminen juntos, y lo más triste es que ambos se necesitan el uno al otro para ser exitosos, ya que por separado son mucho más débiles... En eliax recientemente les hablé y expliqué recientemente del concepto de las Steam Machines, que utilizan el Valve OS, que no son más que PCs genéricas, con una distribución personalizada de Linux, y la tienda de videojuegos por Internet de Valve. O en esencia, este sería el equivalente a Android para consolas de videojuegos, en donde cualquier fabricante puede crear una PC en cualquier forma, tamaño, color y potencia que desee, mientras Valve provee el sistema operativo, su tienda de juegos, y el mecanismo estandarizado para definir controles de juego, formas de pago, etc. Sin embargo, como expliqué en ese artículo reciente, veo un poco cuesta arriba el camino al éxito para Valve con estas máquinas, debido a que salen justo cuando el nuevo PS4 y Xbox One se lanzan, siendo esas nuevas consolas de Sony y Microsoft extremadamente potentes en términos computacionales y visuales, y con una mucho mejor variedad de juegos triple-A de las mayores franquicias del mercado, y a un precio muy inferior a una caja Steam Machine con potencia equivalente. Por su lado, el Oculus Rift (del cual también les he hablado desde hace un tiempo en eliax en artículos como este), es un revolucionario visor de realidad virtual, que te enganchas frente a tus ojos, y que te llena gran parte de tu visión con una imagen tridimensional estereoscópica, y que responde casi instantáneamente a los movimientos de tu cabeza para actualizar el mundo virtual que experimentas frente a tu ojos, en esencia dándote la ilusión de estar inmerso en un mundo imaginario. Sin embargo, aunque creo que el Oculus Rift será algo exitoso, este se encuentra restringido a tener un éxito más masivo ya que no está soportado oficialmente ni por Sony o Microsoft (o incluso Nintendo), por lo que su popularidad nunca llegará a su potencial en el verdadero mercado masivo de las consolas de videojuegos que mueven cientos de millones de unidades cada ciertos años. Pero, ¿qué sucedería si el Oculus Rift fuera parte fundamental de Steam Machines? Notemos que un problema que tiene Steam Machines es que tiene que convencer actualmente a millones de jugadores de que compren una máquina a un mayor precio que las consolas dedicadas, y con una menor selección de juegos clase 1, lo que no es una propuesta apetecible para consumidores. Por lo que Valve necesita para sus Steam Machines es un elemento diferenciador, y ese elemento diferenciador es redireccionar a Steam Machines como la nueva generación de consolas de videojuegos que no juegan juegos tradicionales, sino juegos inmersivos de realidad virtual. Y noten que no creo que Valve necesite gastar miles de millones de dólares en publicidad para hacer que esta unión sea exitosa, pues estoy seguro que cualquiera que pruebe la versión final que se espera del Oculus Rift, quedará tan asombrado como para relegar a las consolas dedicadas que acaban de salir como algo casi del pasado. Pero para que esto tenga éxito, también será necesario obtener el apoyo de al menos dos o tres de las grandes franquicias, como son Gran Theft Auto, Call of Duty y otros, que serían geniales en este nuevo formato, y lo mejor de todo es que no creo que tome mucho esfuerzo convencer a empresas como EA de portar al menos uno de sus grandes éxitos como una plataforma de prueba. Así mismo, ¿no sería genial si Nintendo comprara a Oculus Rift y de paso barre bajo la alfombra el fiasco del Wii U, y regresa los jugadores a lo novedoso que fueron los WiiMotes con el original Wii, junto al Oculus Rift? Pase lo que pase, la verdad es que le deseo a estas empresas éxito, pero realmente si quieren realizar su máximo potencial, lo mejor es que unan esfuerzos y no como una simple asociación mercadológica, sino como una solución integrada oficialmente de fábrica. Finalmente, noten que no debemos obviar el tema de precio... Una Steam Machine con un poder más o menos potente fácilmente costará entre unos US$400 a US$500 dólares, y el Oculus Rift de por sí costará unos US$300 dólares, por lo que pedir US$800 dólares no es algo trivial en cualquier industria. Sin embargo, el factor de novedad es tan grande con el Oculus Rift, que es posible que si estos fabricantes crean una solución integrada en donde todo el paquete cueste unos US$500 dólares, es posible que le puedan dar competencia real al PS4 y Xbox One. Pero jugando al abogado del diablo, no olvidemos que ni Sony, ni Microsoft ni Nintendo se sentarán con los brazos cruzados, por lo que esperen a estas empresas eventualmente sacar sus propias soluciones de Realidad Virtual, o de simplemente adquirir o declarar compatibilidad oficial con el Oculus Rift... Nota: Recién terminé de escribir este artículo (y antes de publicarlo) me enteré que en el evento CES 2014 actualmente en curso, Valve anunció que creará especificaciones de Realidad Virtual estandarizadas para los juegos en su plataforma, por lo que ya hemos dado un paso a mi sugerencia... autor: josé elías |

|

|

|

|

|

lunes, enero 6, 2014

|

¿Recuerdan mi predicción #7 para este año 2014? Pues parece que se hará realidad antes de lo previsto, pues una empresa de nombre Innovega revelará la versión final de su tecnología llamada iOptik, que competirá directamente con las gafas inteligentes Glass de Google... ¿Recuerdan mi predicción #7 para este año 2014? Pues parece que se hará realidad antes de lo previsto, pues una empresa de nombre Innovega revelará la versión final de su tecnología llamada iOptik, que competirá directamente con las gafas inteligentes Glass de Google...Pero, ¿qué ofrece el iOptik más allá de lo que ya hace Glass? Pues según la empresa, esta promete un sistema que combina un lente de contacto, junto a unas gafas, para crear un sistema de pantallas tridimensionales que son proyectadas directamente a la retina de tu ojos. Para lograrlo, el lente de contacto funciona como una enfocador de la imagen, mientras que la imagen en si es generada por las gafas y enviadas directamente a los lentes de contacto. Más allá de esto no sabemos más detalles, pero la empresa supuestamente presentará su invento en evento CES 2014 a inicios de año (fuente). Mientras tanto, los dejo con este video del año pasado de la empresa que consiste de dos partes. En la primera, muestran casos hipotéticos de como será esta tecnología en el futuro, y en la segunda parte muestran video real grabado desde el mismo iOptik Sea como sea, creo que al final de cuentas más allá de la calidad de imagen que estos proyecten en nuestros ojos, el gran diferenciador y variable de éxito de este tipo de dispositivos será el interfaz de usuario que estos nos den (como expliqué en este artículo anterior acá mismo en eliax), y a tal fin, estoy curioso e intrigado a ver que aporta Innovega en este joven sector... Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, enero 5, 2014

|

Después de 9956 artículos en eliax (contando este), creo que ya saben bastante bien que soy un aficionado empedernido de todo lo concerniente a fotografía y cinematografía, y después de unos años jugando con todo tipo de cámaras (desde celulares hasta mi actual Canon 5D Mark III), he aprendido unas cuantas cosas, pero quizás una de las cosas que más he aprendido es a saber lo que deseo y no tengo en todas las cámaras que he utilizado. Y algo me dice, que cualquier aficionado (como yo) o "Pro", posiblemente desee varias de esas cosas que yo también deseo. Después de 9956 artículos en eliax (contando este), creo que ya saben bastante bien que soy un aficionado empedernido de todo lo concerniente a fotografía y cinematografía, y después de unos años jugando con todo tipo de cámaras (desde celulares hasta mi actual Canon 5D Mark III), he aprendido unas cuantas cosas, pero quizás una de las cosas que más he aprendido es a saber lo que deseo y no tengo en todas las cámaras que he utilizado. Y algo me dice, que cualquier aficionado (como yo) o "Pro", posiblemente desee varias de esas cosas que yo también deseo.Así que hoy les comparto mi lista de las cosas que me gustaría tener en una futura generación de cámaras digitales del tipo "semi-pro" o "pro", y los invito a que en los comentarios añadan sus propios deseos. Y quien sabe, quizás alguien de Canon, Nikon, Sony, BlackMagic u otras empresas lea esto y las pase al departamento correspondiente dentro de sus instituciones. O quizás, uno de ustedes se anime en darle al mercado lo que estos no nos dan... Así que sin más que decir, he aquí mi lista de deseos... 1. Un mucho más amplio Rango Dinámico Rango Dinámico (o Dynamic Range en inglés), es un tema del cual me gustaría escribir todo un articulo en eliax pues es un tema muy interesante y útil conocer, pero por ahora digamos que es la capacidad de una cámara de resolver detalle entre las partes claras y oscuras de una imagen de forma simultánea. Hoy día incluso las mejores cámaras del mercado por lo general solo resuelven unas 9 a 11 stops de rango dinámico, pero sabemos que es posible obtener mucho más (como se nota en los archivos RAW/crudos de la última generación de cámaras digitales). Hoy día las cámaras más caras de RED pueden resolver hasta 18 stops de rango dinámico, y la nueva BlackMagic Pocket Cinema Camera provee de 13 stops, por lo que sabemos que es posible darnos al menos 15 stops con un poco de esfuerzo... Ah, y ya que estamos hablando de High Dynamic Range, ¿qué tal sensores que sean más sensibles a entornos de poca luz (como este)? 2. Botones configurables Una de las ventajas de interfaces táctiles como las de celulares inteligentes es que estos se pueden configurar por completo, pudiéndose dibujar botones en donde uno lo desee. Pero una de las desventajas de tales interfaces es que no ofrecen una manera de uno "sentir" los botones con los dedos. Ya existe tecnología en laboratorios (como esta o esta) para permitir que desde una pantalla surjan "botones" que uno pueda sentir, lo que sería ideal para uno configurar la cámara con el interfaz que uno desea y no el que el fabricante desea (como es posible por ejemplo hacerlo al uno bajar una aplicación de cámara para un iPhone o Android, en esencia reemplazando la aplicación original). Sin embargo, mientras tanto me conformaría con que nos dieran una manera de uno tener varios botones físicos (quizás en un módulo deslizable y reemplazable) en lugares estratégicos de la cámara que nos permitan asignar funciones que deseemos a tales botones y rueditas. Hoy día varias cámaras pro (como mi 5D Mark III) ofrecen cierto grado de configuración, pero con muchas restricciones. Por ejemplo, a mi me gusta magnificar la pantalla para enfocar, y eso en mi antiguas Canon T3i, Canon 60D o Canon 6D era mucho más fácil que en mi "superior" 5D Mark III, cosa que hubiese resuelto si pudiese configurar el 100% de los botones y controles a mi gusto (para los curiosos usuarios de la 5D Mark III: Reasigné el botón de SET a magnificar, y eso más o menos aminora y casi resuelve el problema). 3. Enfoque automático por seguimiento ocular Los sistema de autoenfoque de las cámaras SLR/DSLR son muy pobres en comparación con los de cámaras tipo rangefinder (un tipo de cámara totalmente diferente a la mayoría de cámaras actuales, y que no tengo tiempo de explicar en este artículo de hoy), pero imaginen esto: ¿No sería genial si la cámara pudiese observar nuestro ojo por el visor, notar hacia donde ponemos atención, y enfocar automáticamente en ese punto? ¿Suena a ciencia ficción? Pues les informo que justo eso es lo que hacía la Canon EOS 3, una cámara fabricada por Canon desde el 1998 al 2007, y cuyo ultra-avanzado sistema de enfoque ocular aparentaba que literalmente te leía la mente, pues literalmente enfocaba en donde tu ponías atención (consciente o inconscientemente). Sin embargo, curiosamente ese tremendo adelanto la empresa no lo trajo a sus cámaras digitales, y quizás lo tenga bajo la manga para dentro de un par de años hacernos cambiar a un nuevo modelo... 4. Pantallas desplegables en los modelos Pro En el mundo profesional, existen unos cuantos que opinan que la manera "real" de un "pro" enfocar, es viendo por el visor de la cámara, y que las pantallas LCD detrás son solo una distracción. Yo no comparto esa opinión, e incluso creo es bastante ingenua y nada "profesional". En mi opinión, uno debe tomar ventaja de las opciones y ventajas que nos ofrece la tecnología para permitirnos hacer un trabajo mejor, y el tema de enfocar por medio del LCD, es en mi opinión, uno de ellos... Enfocar "a puro ojo", particularmente con la última generación de cámaras full-frame con más de 20 megapixeles, y con lentes rápidos en aperturas de 2.8 o superiores, es un juego ya no tanto de experiencia, sino de mucha suerte, en donde en muchos casos aciertas, y en otros sencillamente obtienes imágenes que se ven aceptables en la pantalla de la cámara o impresas en pequeñas postales, pero que al ser inspeccionadas (particularmente en partes de la cara humana, como en los ojos) se desnudan como muy mal enfocadas. Y una manera de enfocar casi siempre perfectamente, es utilizando la pantalla LCD detrás en modo "en vivo", junto con la funcionalidad de uno poder hacer zoom a nivel de los pixeles, de modo que si estás enfocando a una persona, y presionas en la pantalla en vivo el botón de zoom, puedes magnificar en toda la pantalla solo el ojo de la persona, y enfocarlo con precisión milimétrica. Y cuando te acostumbras, puedes hacerlo super rápidamente. Sin embargo, esto irónicamente se hace más fácil en cámaras de menor precio (como las Rebel de Canon) que en las Pro, debido a que las cámaras de menor costo permiten que la pantalla se extienda y salga de la cámara, para uno colocarla en cualquier ángulo que uno lo necesite. Y a propósito, ese es uno de los puntos en donde opino que dí un paso hacia atrás al comprar las Canon 6D y 5D Mark III, por sobre mis anteriores Rebel. Así que espero que Canon obvie un poco las quejas de muchos Pro que van en contra de esto, y preste un poco más de atención al sentido común... Y ojo, que esto venga por defecto en todas las cámaras no significa que tengas que utilizarlo. Nadie te obligará a punto de pistola a enfocar de esa manera. Si quieres seguir de la forma tradicional de adivinar el enfoque por el visor, amén, pero por favor no creen una campaña ante los grandes fabricantes (como realmente la hay hoy día) para que no incluyan estas super-útiles funcionalidades en sus cámaras semi-pro y pro. 5. PNG-24 junto a RAW Virtualmente el 100% de todas las cámaras digitales producen imágenes en el formato JPG, pero los que muchos no saben es que sus cámaras pueden generar imágenes de calidad visiblemente muy superior si capturan las fotos en el formato RAW (que muchas cámaras semi-pro en adelante soportan, como las Rebel y la mayoría de Nikons, Sonys y otras marcas). Sin embargo, RAW (o "crudo", y que pueden considerar el equivalente a los "rollos negativos" del mundo digital) viene con la complejidad de que los archivos ocupan mucho más espacio (unas 4 a 8 veces más), y que para obtener lo mejor de ellos debes procesarlos en un programa que te permite abrir el archivo RAW y manipular sus parámetros. En un archivo RAW por ejemplo, si has tomado una foto en donde un cielo en la playa aparenta estar totalmente sobreexpuesto (de color totalmente blanco), es bastante posible que puedas recuperar no solo el color del cielo azulado, sino incluso nubes que ni siquiera sabías estaban ahí, y lo mismo puedes hacer con las partes oscuras de la imagen. Así que al menos para los que les importa obtener la mejor calidad posible, RAW debería venir por defecto en todas las cámaras. Así mismo, en vez de JPG, que introduce imperfecciones visuales en la imagen debido a compresión visual de datos, ¿por qué mejor no adoptar el formato PNG de 24 bits, que aunque produce archivos más grandes que JPG, no tienen compresión visual, y son mucho menores que los archivos RAW? Y noten que hoy día ya todos los sistemas operativos y programas de edición de imágenes soportan PNG, por lo que hay poca excusa para no soportarlo. Noten sin embargo que un archivo PNG no te va a permitir recuperar detalle de las partes claras u oscuras de la imagen, pero sí te permitirá tener imágenes más limpias y libres de imperfecciones como ocurre con las JPGs... 6. Video RAW Similar a RAW y PNG, ¿por qué no incluir la capacidad de generar video en formatos RAW, en vez de los tradicionales MPG y sus derivados? Hoy día por ejemplo, gracias al hack (no autorizado por Canon) Magic Lantern, es posible transformar varios modelos de cámaras digitales Canon en increíbles herramientas para crear cine con video RAW, ofreciendo las mismas ventajas de un rango dinámico mucho más amplio (de lo cual hablé en el punto anterior con respecto a recuperar detalle en las áreas claras y oscuras de la imagen), y sin imperfecciones de compresión, a cambio de archivos mucho más grandes y un flujo de trabajo un tanto más complejo. Noten además que ya existen CODECs (codificadores) de video RAW que pueden comprimir video RAW puro a un formato mucho más comprimido sin comprimir la información visual en lo absoluto (es decir, comprimen los datos, no la información visual que estos representan), como el CineForm que produce archivos 10 veces más pequeños que el RAW crudo de algo como la 5D Mark III, por lo que no hay excusa para no proveer esto (salvo quizás, que tendrán que crear circuitos especializados para comprimir a CineForm en tiempo real, lo que podría incrementar el costo de estas cámaras en unos US$10 a US$20 dólares por unidad, que honestamente, no es nada para el público a donde esto apuntaría). Pero una una vez, ofrezcan ambas opciones: Video comprimido al estilo MPEG, y video RAW para quienes entiendan lo que hacen y deseen la mejor calidad posible... 7. Menor peso ¿Por qué mi 5D Mark III pesa el doble que mi antigua 3Ti? Canon diría que por los materiales que utiliza, pero honestamente, BlackMagic ha demostrado que es posible crear cámaras increíbles en tamaños increíbles (y a precios increíbles). Justamente anteayer por ejemplo (en una boda de un familiar) me lastimé mi muñeca de tanto cargar con una mano la 5D Mark III junto a un lente bastante pesado. Y honestamente, hay otras maneras de hacer esto, y solo se necesita voluntad y liderazgo de parte de estas empresas para hacerlo... 8. Mejores lentes y más baratos ¿Sabían que ya existe investigación (de la cual les hablé en el 2012 acá mismo en eliax) sobre formas de crear lentes sin cristal, totalmente planos, del fino de una hoja de papel, y con una calidad posiblemente muy superior a los mejores lentes del mercado? Ah, y posiblemente a un costo de unos pocos dólares... Así que ¿qué tal un poco de innovación en este campo por favor? Hoy día un lente como el Canon 24-70 f2.8 II fácilmente te costará alrededor de US$2,000 dólares, mientras que un excelente prime de la misma Canon como el excelente 50mm f1.8 se consigue por unos US$150, y todo se reduce a lo complejo que es fabricar estos lentes, y a los altos márgenes que estas empresas quieren cobrarle al sector "Pro". Así que si uno de ustedes lectores quiere hacerse multi-millonario (y hablo de miles de millones de dólares), ya saben a qué campo y tecnología caerle atrás para hacer sus sueños realidad... 9. Mejores baterías Las cámaras digitales sufren del mismo síndrome que sufren los celulares y tabletas: Justo en el momento que más los necesitas, obtienes el aterrador icono pestañeando que muestra una batería de color rojo, señal de que pronto te quedarás sin energía... Así que vamos a ver si arreglamos ese tema, para evitar que personas como yo anden con literalmente 3 baterías adicionales junto con la cámara, por si acaso... 10. Tienda de aplicaciones Una de las mejores cosas que han ocurrido en años recientes en el mundo de las cámaras digitales es el hack Magic Lantern que ya mencioné anteriormente. Pero Magic Lantern no es solo para ofrerte video en formato RAW (aunque ese fue su fin inicial). Magic Lantern te transforma tu cámara a una super cámara, con capacidades que usualmente obtendrías en cámaras que cuestan varios miles de dólares, e incluso funcionalidades que no obtendrías a ningún precio en ninguna otra cámara. Y no solo para video, sino para fotos, incluyendo intervalómetros, asombrosas capacidades para fotografía HDR (Alto Rango Dinámico), mejora del sonido (permitiendo suprimir el Auto-Gain Control, mejoras en enfoque (con patrones zebra, peaking, etc) y mucho más. Así que me sorprende que Canon, en vez de apoyar este tipo de cosas, y formalizar la creación de este tipo de programas, simplemente esté callada al respecto... La empresa debería tomar prestada una página del libro de Apple, quien pocos meses después de salir una tienda de aplicaciones "piratas" para el original iPhone, la empresa sacó su propia tienda, y legalizó el concepto del "App Store", permitiendo una forma organizada, segura y sencilla para que todos pudieran desarrollar aplicaciones para sus celulares (y posteriormente tabletas y laptops), y de paso hacer mucho dinero en el proceso (Apple cobra un 30% de comisión por cada venta en sus tiendas). Así mismo, Canon y Nikon principalmente debería seguir esos pasos, y permitir acceso total a sus cámaras. Yo mismo por ejemplo personalmente pagaría fácilmente US$99 dólares por Magic Lantern, particularmente si este funcionara en la última versión del firmware (sistema operativo de bajo nivel) de la 5D Mark III (actualmente, debido a que es un hack que depende de un agujero de seguridad de Canon, este solo funciona para una versión vieja, que trae consigo un sinnúmero de problemas que no voy a describir aquí hoy). Así mismo eso permitiría incluso la creación de accesorios externos (como nuevos botones y rueditas) que mejorarían la funcionalidad de las cámaras en su manejo físico. Noten que Samsung ya experimentó con esto, con un par de cámaras basadas en Android, pero la inconsistencia de su implementación no ha permitido que ese modelo sea exitoso en su plataforma. Así que esa es mi lista. ¿Qué otras cosas querrían ustedes? ¿Mejores conectores al estilo Thunderbolt? ¿Monitoreo de sonido estándar? ¿Mejores entradas para micrófono y sonido profesional? ¿Enfoque a-posteriori al estilo Lytro? ¿"cámara lenta" con al menos 120fps? ¿¿¿Qué más se les ocurre??? autor: josé elías |

|

|

|

|

|

jueves, diciembre 19, 2013

|

|

Hace unos 41 años, Ed Catmull, con su amigo Frd Parke (ambos en ese entonces en la Universidad de UTAH en EEUU), crearon historia al crear la primera película renderizada completamente en 3D.

Hablamos de 1972, cuando todavía computadoras como la IBM PC, Apple II o Commodore 64 no habían sido ni siquiera soñadas, y en donde el término "Computadora Personal" aun no se había inventado, y lo que lograron estos dos es verdaderamente asombroso para la época (aunque noten esta otra noticia acá mismo en eliax, sobre la demostración técnica más asombrosa de todos los tiempos). Como apreciarán en el video, la primera animación que hicieron estos dos fue una versión digital de la mano izquierda de Ed Catmull, quien vale la pena mencionar, eventualmente fundaría PIXAR (que sería propiedad de Steve Jobs, y luego vendida a Disney), y hoy día es el Presidente de Disney, y de Disney Animation Studios. Esto de paso debe darnos una idea de lo asombrosamente rápido que evoluciona la tecnología, pues si a estos dos les hubiesen preguntado que si en el 2013 tendríamos dispositivos que caben en nuestras manos y que renderizarían en tiempo real escenarios casi fotorealistas, no lo hubiesen creído... ¡Gracias al lector Carlos David Correa por el video! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, diciembre 18, 2013

|

|

Hoy los dejo con una breve dosis de BREVES en eliax...

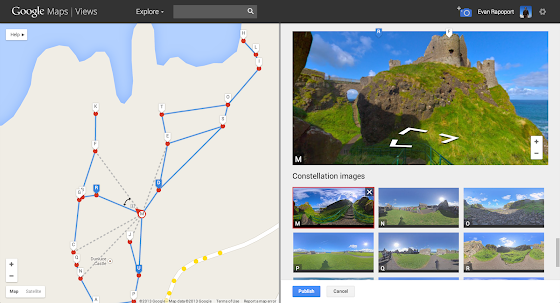

1. Inteligencia Artificial en Facebook  En la inminente guerra de servicios basados en Inteligencia Artificial, Facebook no quiere quedarse atrás ante los esfuerzos de empresas como Google, Apple, Microsoft o IBM, por lo que recientemente contrató a Yann LeCun, un profesor de New York University. En la inminente guerra de servicios basados en Inteligencia Artificial, Facebook no quiere quedarse atrás ante los esfuerzos de empresas como Google, Apple, Microsoft o IBM, por lo que recientemente contrató a Yann LeCun, un profesor de New York University.LeCun será ahora el encargado de todos los esfuerzos de IA por parte de Facebook, lo que significa crear sistemas que aprendan mejor de nuestros hábitos sociales, que puedan predecir nuestros movimientos y deseos (por ejemplo, para vendernos cosas), y en general mejorar la experiencia de Facebook para todos. anuncio oficial por parte de LeCun 2. Google Street View personalizado  Una de las mejores (y menos conocidas) funcionalidades de Google Maps es Google Street View, que es la funcionalidad que te permite "caminar" por las calles, montañas, montes, monumentos, y otros lugares, de forma virtual. Una de las mejores (y menos conocidas) funcionalidades de Google Maps es Google Street View, que es la funcionalidad que te permite "caminar" por las calles, montañas, montes, monumentos, y otros lugares, de forma virtual.Sin embargo, a la fecha, esas "caminatas virtuales" eran posible debido a que Google envía constantemente a todas partes del mundo personas con equipos especializados (tanto en vehículos como a pie) que capturan imágenes de 360 grados en varios puntos de la travesía virtual, lo que como pueden imaginar es un trabajo arduo, y lento... Pero ahora, Google ha decidido permitir utilizar la funcionalidad de Photo Sphere ("Esfera Fotográfica") de recientes versiones de Android para que tú mismo tomes fotos de 360 grados de tus puntos favoritos, y los subas a Google, en donde gracias a las coordenadas GPS de tu móvil, estas imágenes son ensambladas con más imágenes de otras personas para crear una caminata virtual. Así que si tienen un lugar favorito, que podría ser un bar, un museo, monumento, o lugar turístico local que quieras compartir con el resto del mundo, esta es la oportunidad de empezar a aportar... detalles oficiales de parte de Google 3. El estabilizar de video Wiggly para móviles  ¿Recuerdan el asombroso estabilizador de video MōVI del cual les hablé hace un tiempo acá en eliax? Ese dispositivo cuesta unos US$15 Mil dólares, pero ¿qué tal si pudieran tener algo similar por entre US$300 y US$600 dólares (dependiendo de capacidades) para el uso de cámaras móviles? ¿Recuerdan el asombroso estabilizador de video MōVI del cual les hablé hace un tiempo acá en eliax? Ese dispositivo cuesta unos US$15 Mil dólares, pero ¿qué tal si pudieran tener algo similar por entre US$300 y US$600 dólares (dependiendo de capacidades) para el uso de cámaras móviles?Pues eso es precisamente lo que ofrece Wiggly, un proyecto en Kickstarter que espera en las próximas 2 semanas recaudar US$100 mil dólares para fabricar tal dispositivo. Lo mejor es que su creador ya tiene el producto listo (su creador lleva 7 años diseñando este tipo de sistemas), por lo que es solo cuestión de obtener los fondos necesarios para fabricarlos. El Wiggly viene en varias versiones que van desde estabilización en un axis, hasta 2 y 3 (igual que el MōVI). No dejen de ver los videos que acompañan la página del proyecto, el producto se ve verdaderamente bueno, y no solo es para iPhones (como muestran en los videos), sino además para cualquier tipo de cámara pequeña (puedes obtener un adaptador para la GoPro por ejemplo), y me pregunto que tan bien funcionaría esto con la BlackMagic Pocket Cinema Camera... Wiggly en Kickstarter autor: josé elías |

|

|

|

|

|

sábado, diciembre 14, 2013

|

Si quieren un excelente ejemplo de lo rápido que avanza la tecnología, y de la curiosa observación que toda tecnología con el pasar del tiempo tiende a aproximarse a un costo cero, solo noten esta noticia de hoy... Si quieren un excelente ejemplo de lo rápido que avanza la tecnología, y de la curiosa observación que toda tecnología con el pasar del tiempo tiende a aproximarse a un costo cero, solo noten esta noticia de hoy...Hasta hace apenas una década, tener un canal de TV en vivo significaba literalmente una inversión millonaria (en dólares), involucrando no solo costo en equipos, sino en frecuencias de espectro o en acuerdos con empresas de TV por cable. Pero ahora, gracias al Internet y a YouTube (una empresa de Google, para los pocos que aun no lo sepan), el costo acaba de bajar a prácticamente cero. Iniciando desde esta semana, YouTube anunció que todo usuario de YouTube que tenga una cuenta verificada (solo toma unos minutos), y que esté sana (es decir, que no haya sido reportada por contenido inapropiado o robado), tendrá acceso a enviar video en vivo por medio de su canal de YouTube. Totalmente gratis. Esto es algo que como les informé anteriormente en eliax, estaba disponible solo para usuarios que tuviesen al menos 1000 subscriptores (YouTube eventualmente lo bajo a 100), pero ahora lo abre a todo el mundo. Esto sin duda que hará posible toda una nueva generación de aplicaciones, ideas, productos y servicios que nos impulsarán en una nueva era, en donde dependeremos cada vez menos de los canales tradicionales de distribución, y dependeremos más de la creatividad de los individuos, y de la capacidad de empresas productoras de crear contenido interesante y diverso. Así que si alguna vez tuviste un sueño de tener tu propio canal de TV, ya no tienes excusa. Busca una cámara, obtén una conexión a Internet decente (con 1.5Mbps de subida/upload es suficiente para empezar), y empieza a escribir buenas ideas y a ejecutarlas. En estos tiempos que estamos viviendo, tu imaginación es el límite... Y finalmente, este es un buen momento para leer este editorial de abril del 2011, en donde hago nota del As bajo la manga de Google que le permite hacer este tipo de proyectos a un costo prohibitivo para otras empresas. anuncio oficial de YouTube autor: josé elías |

|

|

|

|

|

sábado, diciembre 7, 2013

|

Hoy los dejo en eliax con un video (y enlace interesante asociado) de una de las populares charlas TED Talks, esta vez con Robert Lang, un científico que se especializa en el arte y las matemáticas del origami (el arte de doblar papel para formar figuras usualmente tridimensionales). Hoy los dejo en eliax con un video (y enlace interesante asociado) de una de las populares charlas TED Talks, esta vez con Robert Lang, un científico que se especializa en el arte y las matemáticas del origami (el arte de doblar papel para formar figuras usualmente tridimensionales).Lo interesante de la charla de Robert es que no solo nos cuenta brevemente sobre los orígenes y la historia del arte de origami, sino que además hace la conexión que este arte tiene con las matemáticas, mostrándonos que es posible utilizar reglas matemáticas para crear prácticamente cualquier figura que desees, desde animales complejos con miles de escamas, hasta escenas completas de personas tocando un piano, y todo iniciando con una sola hoja de papel y sin cortar tal hoja, solo doblándola... Pero más sorprendente aun, nos muestra como estos avances que combinan el arte y las matemáticas del Origami están teniendo aplicaciones prácticas en temas como la medicina, el diseño de equipos de seguridad en automóviles, y la ingeniería espacial, y nos demuestra esto con interesantísimos ejemplos. Aparte de eso, si les interesa el origami, Robert escribió un programa llamado TreeMaker, que en esencia te permite generar los "planos" para doblar cualquier figura que le digas al programa. El programa está disponible para Mac, Windows, y Linux. Pueden descargar a TreeMaker en su página oficial. Para ver el video con subtítulos en español, prosigan a este enlace oficial en TED y elijan la opción de subtítulos en español (dentro del video, abajo a la derecha). Y los que sepan inglés pueden ver el video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, noviembre 27, 2013

|

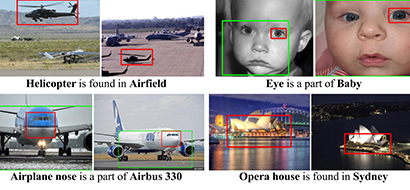

La Universidad de Carnegie Mellon en los EEUU acaba de dar un gran paso en el campo de la Inteligencia Artificial (IA) al haber desarrollado un sistema al que llama el Never Ending Image Learner (NEIL, que en español sería algo como el "Aprendiz Interminable de Imágenes"), que según sus investigadores ha aprendido por sí mismo el concepto del "sentido común", cuando menos en lo que a reconocer imágenes se refiere por ahora... La Universidad de Carnegie Mellon en los EEUU acaba de dar un gran paso en el campo de la Inteligencia Artificial (IA) al haber desarrollado un sistema al que llama el Never Ending Image Learner (NEIL, que en español sería algo como el "Aprendiz Interminable de Imágenes"), que según sus investigadores ha aprendido por sí mismo el concepto del "sentido común", cuando menos en lo que a reconocer imágenes se refiere por ahora...Lo que NEIL ha logrado aprender por sí solo es el entender las conexiones que hacemos los humanos para asociar distintos tipos de imágenes diferentes dentro de un mismo grupo, en esencia buscando el sentido común que varias imágenes comparten. NEIL es un sistema de IA con 200 núcleos que funciona 24 horas al día, los 365 días del año, y lo único que hace es navegar el Internet por su cuenta, buscar imágenes, y tratar de hacer todo tipo de conexiones entre ellas. Entre las cosas que NEIL ha aprendido por su cuenta (y que son cosas que los humanos clasificamos como "sentido común") están que los edificios son por lo general altos, o que los patos son animales parecidos a los gansos. Pero tan asombroso como eso, es que uno puede visitar la página web del proyecto NEIL, y ver en tiempo real las últimas cosas que NEIL está aprendiendo por su cuenta, y debo decirles que es verdaderamente asombroso lo que he visto en esa página, ya que aunque son cosas que incluso para un niño son "obvias", no son cosas que uno esperaría de "una máquina". Me refiero a que literalmente está aprendiendo el concepto del sentido común en las cosas, y más asombroso aun, que ha expandido su dominio de las cosas a temas que no son estrictamente visuales (aunque sí las aprendió visualmente), como el hecho de haber aprendido por sí sola que los autos tienen ruedas (una vez más, algo obvio para nosotros, pero que nadie le enseño previamente a NEIL). Noten que aparte de ver lo que NEIL está aprendiendo en determinado momento, que puedan además entrenar a NEIL en cosas nuevas si lo desean, así como ver "el interior de su mente", que los desarrolladores de NEIL llaman "escenas", viendo ustedes las asociaciones que NEIL ha hecho previamente para descubrir nuevos conceptos. Noten que esta noticia se las traigo apenas días después de hablarles de la IA de Google acá mismo en eliax, testamento a lo rápido que estamos avanzando en el área de la Inteligencia Artificial en estos días... página oficial de NEIL nota de prensa oficial autor: josé elías |

|

|

|

|

|

lunes, noviembre 25, 2013

|

Hoy los dejo con este increíble video, creado por científicos de Disney, en donde nos muestran sus avances en crear nieve 100% digital para ser utilizada en la próxima película animada de Disney, Frozen ("Congelado"). Hoy los dejo con este increíble video, creado por científicos de Disney, en donde nos muestran sus avances en crear nieve 100% digital para ser utilizada en la próxima película animada de Disney, Frozen ("Congelado").Noten que al inicio del video verán uno segundos de explicaciones matemáticas, y les imploro que resistan la tentación de dejar de ver el video si no les gustan esas cosas, pues lo que viene segundos después es verdaderamente asombroso. Esto a propósito debe darnos una pista de lo que serán los entornos sintéticos en donde habitaremos los Humanos 2.0 en un futuro no tan lejano, en donde nuestros mundos simulados (a la Matrix) serán tan reales (sino más) que la realidad física misma que experimentamos. ¡Gracias al lector Marcelo Flix Diaz por compartir el video en el grupo Developers.X para desarrolladores de software! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, noviembre 23, 2013

|

¿Recuerdan el Sensorix que imaginé el año pasado acá en eliax? Pues una pieza más del rompecabezas acaba de caer en su lugar, ya podemos hacer parte de sus capacidades hoy día con las gafas de las cuales les hablo hoy, las gafas Evena Eyes-On. ¿Recuerdan el Sensorix que imaginé el año pasado acá en eliax? Pues una pieza más del rompecabezas acaba de caer en su lugar, ya podemos hacer parte de sus capacidades hoy día con las gafas de las cuales les hablo hoy, las gafas Evena Eyes-On.Estas son unas gafas que permiten que enfermeras visualicen, en tiempo real, las arterias y venas de un paciente como si estas estuviesen encima de la piel, en vez de debajo de la piel, lo que hace ahora el buscar el punto de inserción de una jeringuilla algo totalmente trivial. Según la empresa, estudios revelan que es necesario "punchar" al paciente más de una vez en el 40% de los casos, algo que al menos yo puedo atestiguar al llevar a mis bebitos al doctor, y si ese problema se puede resolver con gafas como esta, tendrán no solo uno, sino que muchos clientes satisfechos. Las gafas funcionan con unas cámaras hiper-sensibles que pueden literalmente atravesar la piel y ver las arterias y venas, y en tiempo real un software analiza esas imágenes, resalta solo las arterias y venas (y no otras partes de la piel) y superimpone la imagen en tiempo real sobre la imagen de la piel de la persona, en esencia proveyendo de una forma de "visión de Rayos X" a quienes utilizan estas gafas. No dejen de ver el video que les muestra bastante bien el funcionando en vivo de las gafas. página oficial del producto Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, noviembre 19, 2013

|

Hoy les muestro una tecnología que es muy importante que entiendan que no funciona como mostrado en el video, que fue realizado sin duda alguna con fines mercadológicos y que no representa el producto real, sin embargo, continúen leyendo pues esto de todas formas es asombroso y sí les proveeré de un enlace que sí les muestras videos reales de uso. Hoy les muestro una tecnología que es muy importante que entiendan que no funciona como mostrado en el video, que fue realizado sin duda alguna con fines mercadológicos y que no representa el producto real, sin embargo, continúen leyendo pues esto de todas formas es asombroso y sí les proveeré de un enlace que sí les muestras videos reales de uso.Se trata de una tecnología de holografía médica llamada "RealView" ("Vista Real") por la empresa de mismo nombre, que tiene como fin el permitirle ver al médico en tiempo real una representación "holográfica" de los órganos internos del paciente (o de partes específicas del paciente), lo que como se pueden imaginar será una tecnología extremadamente útil para médicos. La idea es que con un escáner de alta resolución y tiempo real se pueda capturar el interior del cuerpo en 3D, y después utilizar esos datos 3D para desplegarlos también en tiempo real en un formato "holográfico". El video que acompaña este artículo acá abajo les da una idea del concepto detrás de la tecnología, pero es importante entender que ese video que ven no fue grabado de una sesión real, sino que fue creado con efectos especiales en post-producción. O en otras palabras, una cámara no puede grabar lo que ven en el video, y el doctor en ese video no está ni viendo ni interactuando con lo que el departamento de mercado nos quiere presentar. Lo que sí hace este sistema sin embargo (y esto lo deduje ya que he visto y trabajado con sistemas de este tipo de espejos en el pasado) es que el dispositivo curvo que vean detrás crea una imagen que da la ilusión de uno ver una imagen 3D flotando frente a uno, pero esa imagen solo se puede ver en el campo de visión de ese espejo curvo detrás. Así mismo la imagen desplegada no es realmente "3D" en el sentido de ser volumétrica, sino que es realmente una capa 2D que aparenta flotar en un espacio 3D, pero que al permitir rotar el objeto y manipularlo (una vez más, no con las manos, sino con un instrumento aparte) este da una ilusión bastante convincente de ser "en 3D". La mejor manera de imaginar esto en la vida real es imaginando lo siguiente: Imaginen que toman un iPad, y le quitan todo su marco y dejan solo la pantalla. Ahora hagan la pantalla transparente (de modo que uno pueda ver a través de ella), y ahora imaginen que en la pantalla 2D del iPad sale un corazón. Ese corazón es un corazón 3D pero dibujado en una pantalla 2D (de forma exacta como un juego de carros de carrera 3D lo vemos realmente en un televisor 2D). Ahora imaginen que ese iPad "flota" frente a ti y un espejo, y finalmente imagina que tienes un instrumento que te permite rotar y agrandar el corazón en la pantalla del iPad. Ese es más o menos el efecto final, con la diferencia de que no existe una pantalla de iPad transparente (ni ninguna otra pantalla), ya que la imagen se dibuja en una pantalla acostada detrás del espejo curveado, y es la curvatura del espejo lo que hace creer que lo que refleja el espejo "flota" ante nuestros ojos. Aun así, esto es espectacular, y abajo en los enlaces les dejo un segundo enlace en donde pueden ver videos de uso real del sistema. Finalmente, noten que esta tecnología es un primer paso hacia algo aun más avanzado que denomino el Sensorix, como imaginé en esta Reflexión acá mismo en eliax. ¡Gracias al lector Raimundo Hernandez Senegal por compartir el video en el grupo oficial de eliax en Facebook! página oficial de RealView casos de uso real de RealView Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"Usted amigo mio ... es un ser maravilloso lleno de belleza en sus palabras, sus ideas, sus pensamientos, lo que escribe, es sencillamente hermoso.

Gracias por este articulo tan inspirador. Un fuerte abrazo y saludos desde Colombia. Ojala algún día tenga la dicha de conocerlo personalmente."

Gracias por este articulo tan inspirador. Un fuerte abrazo y saludos desde Colombia. Ojala algún día tenga la dicha de conocerlo personalmente."

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax