Tecnología Visual

|

miércoles, septiembre 2, 2015

|

Hoy día una cámara de 10 Megapixeles (10MP) es bastante aceptable, y las cámaras profesionales con la mayor resolución del mercado rondan los 50MP, pero esta semana se acaba de aprobar la construcción de una cámara con unos colosales 3200 Megapixeles (3200MP), o unos 3.2 Gigapixeles (3.2GP). Hoy día una cámara de 10 Megapixeles (10MP) es bastante aceptable, y las cámaras profesionales con la mayor resolución del mercado rondan los 50MP, pero esta semana se acaba de aprobar la construcción de una cámara con unos colosales 3200 Megapixeles (3200MP), o unos 3.2 Gigapixeles (3.2GP).¿Qué tanta resolución es esa? Pues suficiente como para necesitarse el equivalente de 1500 pantallas de televisión Full HD para poder mostrar todos esos pixeles entre todas... Sin embargo que no se les haga agua la boca imaginando tomando sus fotos familiares con esta bestia, ya que esta cámara estará destinada a un uso muy particular en astronomía: Tomar las fotos más detallas del cielo nocturno, con la mayor cantidad de objetos cósmicos posibles. Y para que tengan una idea de la cobertura de esta cámara, una sola foto de esta cámara podrá capturar una imagen equivalente al espacio que ocuparían 40 lunas llenas en el cielo. Con esta cámara será posible en menos de 10 años catalogar miles de millones de objetos, así como podrá crear videos espectaculares en pocos días de la mayor parte del cielo del hemisferio sur de la Tierra. Y hablando de hemisferio sur, la cámara estará montada dentro de lo que será llamado el telescopio LSST (por sus siglas en inglés de "Large Synoptic Survey Telecscope") y estará instalado en un lugar llamado Cerro Pachón en Chile. Si todo sale acorde al plan, estaremos deleitándonos con las primera imágenes de esta cámara en el 2022... nota de prensa oficial autor: josé elías |

|

|

|

|

|

jueves, agosto 6, 2015

|

¿Recuerdan las fotos capturadas con los primeros celulares semi-modernos, por allá hace una década atrás? Las imágenes eran desastrosas, oscuras, y pocos hubiesen imaginado que llegaríamos a la calidad de imágenes que podemos obtener hoy día con un iPhone 6 o Galaxy S6. Sin embargo, esto es solo el principio... ¿Recuerdan las fotos capturadas con los primeros celulares semi-modernos, por allá hace una década atrás? Las imágenes eran desastrosas, oscuras, y pocos hubiesen imaginado que llegaríamos a la calidad de imágenes que podemos obtener hoy día con un iPhone 6 o Galaxy S6. Sin embargo, esto es solo el principio...Si observamos bien las cifras y las tendencias, en los próximos 1 a 3 años tendremos celulares con no solo una calidad similar o superior a la mayoría de cámaras DSLR de hoy día de rango medio (y quizás hasta alto, eventualmente), sino incluso con los mismos efectos ópticos (como fondos difusos logrados con grandes aperturas de lente) que caracterizan a estas. Pero antes de continuar, un breve párrafo para los que no tienen conocimientos técnicos de estos temas: Un cámara "DSLR" no es más que una de esas cámaras grandes cuyos lentes son intercambiables. Eso es todo... Existe una tecnicalidad con un tipo de cámara que se llaman "mirror-less" ("sin espejos"), pero para nuestra discusión de hoy también podemos considerar esas cámaras de lentes intercambiables como DSLR. Ahora continuemos... Ahora bien, los de conocimientos más técnicos deben estar bastante escépticos con mi afirmación de hace par de párrafos atrás, particularmente con el tema ese de fondos difusos, ya que técnicamente eso solo se puede lograr con lentes de gran apertura y sensores más grandes, pero sin embargo eso no es enteeeeramente cierto... Si recuerdan, hace un par de años escribí un artículo en donde les enseñaba como lograr el efecto "bokeh" (el término técnico para un fondo difuso) de tres formas distintas, pero eso era un artículo práctico para ser útil a todo el que tuviese una cámara, pero realmente existe otra forma alternativa de lograr ese efecto bokeh, o incluso de uno poder enfocar y desenfocar al antojo cualquier plano de la imagen, y esa forma es con computación. Por "computación" hablamos de que de alguna forma la cámara obtiene información adicional sobre la imagen en frente de esta, información más allá de los simples rayos de luz que entran el lente tradicional de una cámara y que caen en un sensor tradicional. Más específicamente lo que deseamos es obtener información de profundidad, es decir, qué tan lejos o cerca de la cámara están los objetos que aparecen en la foto. Y existen al menos dos formas distintas de obtener esa información adicional. Una es con un nuevo tipo de sensor que permite capturar no solo la magnitud de los rayos de luz (es decir, que tan claros o oscuros son), sino además su dirección (es decir, el ángulo con el cual llegan esos rayos al sensor). Esta primera forma fue minada por la empresa Lytro quien con sus cámaras del tipo "Light Field" ("Campo de luz") permite que tomes una fotografía, y posteriormente puedas enfocar en donde desees. Esto se logra debido a que si es posible computar las propiedades de la luz en términos de sus ángulos de incidencia en relación al sensor, uno puede determinar también el nivel de profundidad (distancia desde el objeto hasta la cámara) de cada pixel (punto de imagen) y por tanto puede tener calculado a qué distancia están todos los objetos de la foto entre sí, lo que permite que por medio de algoritmos de difusión de imagen, uno pueda selectivamente poner "borroso" o "nítido" cualquier punto de la imagen. Pero existen una segunda forma de lograr el mismo efecto, y es utilizando sensores tradicionales, pero con múltiples lentes, o más bien dicho, múltiples cámaras a la vez. La idea es que si puedes capturar la misma fotografía desde varios ángulos o puntos de vista diferentes, que entonces puedes estimar la distancia entre los objetos de la imagen, y es precisamente así que funciona la visión humana, en donde debido a que tenemos dos ojos, podemos estimar la profundidad del mundo que nos rodea de forma tridimensional, calculando la diferencia de imagen entre los dos ojos. Pues bien, dos empresas actualmente están desarrollando productos que toman ventaja de este efecto, utilizando entre 2 y hasta 11 micro-cámaras simultáneamente, y lo mejor del caso es que esas cámaras no tienen que tener una alta resolución, ni utilizar lentes de ultra alta calidad, ya que es la combinación de todos los pixeles de esos sensores, y de las distintas perspectivas de cada uno de los lentes del sistema, que son unificados en una sola imagen por medio de computación, en esencia calculando una imagen superior a cada una de sus partes inferiores (lo que contribuye a que este sistema pueda hacerse con relativo bajo costo). Las dos empresas que están desarrollando esta tecnología son LinX, y Light. De las dos empresas, LinX aparenta tener el mayor potencial y la tecnología más avanzada y madura, y curiosamente en abril de este año Apple adquirió la empresa y ya existen rumores de que el iPhone 7 del próximo año podría incluir su tecnología. Mientras tanto Light está en su segudo round de financiamiento y ya tiene de socio a Foxcom (la misma empresa que fabrica iPhones para Apple) para crear sus primeros prototipos a finales de este año 2015 (o en el 2016), por lo que pueden estar seguros que el campamento Android tendrá eventualmente una respuesta a la posible futura cámara del iPhone. Noten sin embargo que por el momento estos cálculos que se ejecutan para crear una imagen compuesta de entre varias, requiere de muchísimo poder de procesamiento, tanto así que Light ya ha dicho que la primera generación de estas cámaras solo podrán capturar imágenes fijas y no videos en esta modalidad, hasta que la empresa cree procesadores dedicados para ensamblar tales imágenes en videos en tiempo real. Por su parte sin embargo es mucho más probable que la primera generación de dispositivos de Apple con esta tecnología permitan también grabar videos, debido a que Apple controla totalmente todo su ecosistema, diseñando la empresa sus propios procesadores, y es de esperarse que ya tenga internamente incluso prototipos de co-procesadores o circuitos listos para integrarse en futuras generaciones de sus chips A9 o A10. Y noten que si agregamos a esto el hecho de que Sony (que provee los sensores a Apple) tiene un nuevo diseño de sensor de 12 Megapixeles estilo RGBW (un término de cómo están organizados los fotosensores en el sensor) que promete una mejora notable en el nivel de luz capturada, y el hecho que dos o más de estos sensores en paralelo pueden incrementar su nivel de sensibilidad a la luz así como su resolución computacionalmente, que esto nos indica que estamos en el umbral de equipos fotográficos en celulares que no solo podrán tener una densidad efectiva de pixeles en el orden de la decenas de millones de pixeles, sino además que poseerán los mismos efectos de campo difuso y enfoque selectivo que disfrutan las cámaras DSLR, así como una alta sensibilidad a la luz (para ambientes de baja iluminación), y todo eso en un futuro muy cercano... Nota a puristas tecnológicos: Antes de que lo mencionen en los comentarios, Sí, ya se, otras empresas han experimentando con esto, incluyendo un par de fabricantes chinos y coreanos con sus cámaras en celulares Android, en donde permiten de forma limitada hacer fondos difusos. Sin embargo, esos no son más que "hacks" visuales, y no son tan sofisticados como las soluciones que plantean sacar al mercado estas dos empresas en donde pueden lograr una mucha mayor resolución, mucho menor ruido, y mucho mayor control de los planos difusos o enfocados de las fotos y videos. autor: josé elías |

|

|

|

|

|

miércoles, abril 8, 2015

|

La serie Rápido y Furioso ha tenido tantas altas y bajas como lo han tenido los autos y minifaldas de las mujeres en su guión, empezando con una primera parte que fue aceptable (pero que tocó el nervio correcto entre una audiencia nicho), después continuando con 3 películas más que variaron entre lo mediocre a lo aceptable, y después casi mágicamente resucitando de forma inesperadamente buena con la quinta parte ("Fast 5" o "Fast Five"), procediendo a una excelentísima película en todos los niveles con Fast & Furious 6, y ahora volviéndonos a sorprender con Fast & Furious 7. La serie Rápido y Furioso ha tenido tantas altas y bajas como lo han tenido los autos y minifaldas de las mujeres en su guión, empezando con una primera parte que fue aceptable (pero que tocó el nervio correcto entre una audiencia nicho), después continuando con 3 películas más que variaron entre lo mediocre a lo aceptable, y después casi mágicamente resucitando de forma inesperadamente buena con la quinta parte ("Fast 5" o "Fast Five"), procediendo a una excelentísima película en todos los niveles con Fast & Furious 6, y ahora volviéndonos a sorprender con Fast & Furious 7.Sin embargo nada había preparado a todo el equipo de producción y elenco para la muerte súbita (irónicamente en un accidente automovilístico) de Paul Walker, justo en medio de rodar esta más reciente secuela de la serie. Tan pronto se hizo evidente que la muerte de Walker era real y no un chiste cruel más de Internet, los estudios Universal Pictures pusieron freno inmediato a la producción, hasta que se decidiera qué hacer con la película. Por respeto a los familiares, los estudios detuvieron también cualquier posible discusión sobre si continuar o no, y de hacerlo, cómo, hasta ya sepultado Walker. Pero días después el director James Wan (por primera vez dirigiendo un episodio de la franquicia) se reunió con todo el equipo ligado a la película (incluyendo los actores y familiares), y decidieron proceder a finalizar la película, pero con obvios cambios... Entre los cambios que se decidieron estaban el de dar más protagonismo a Walker en las escenas ya grabadas, y de cambiar el final de la película (como un homenaje a este). Sin embargo la gran pregunta que rondaba en la habitación en donde se decidió proceder era sin duda "¿cómo proceder con la película sin Walker para actuar sus escenas?", y es aquí en donde entra la tecnología de efectos visuales de punta, y donde entramos en materia en el artículo de hoy en eliax. Sin embargo, antes de continuar (y como les informé vía twitter tan pronto salí de ver la película en IMAX 3D), debo decir que me gustó bastanteFast & Furious 7, llenando mis expectativas, aunque no superando a la excelentísima Fast & Furious 6 (pero sí llegando bien cerca). Mi calificación fue de 9.45 de 10. De paso noten que en tan solo su primer fin de semana mundial la película recaudó US$384 millones de dólares, y eso sin aun haberse estrenado en grandes mercados como China o Rusia... Y si se preguntan si se notó la ausencia de Walker, o si se notaron los efectos especiales que lo trajeron de regreso a la vida de actor, la respuesta es un rotundo no. Yo soy un fanático de los efectos especiales y ya he desarrollado un ojo para notar lo que es real y lo ficticio, pero debo admitir que salvo una sola toma al final de la película, que no noté nada "extraño". Es como si Walker realmente hubiese filmado la película, y como si el guión siempre hubiese sido el que terminamos viendo en pantalla. Aplausos y me quito el sombrero ante el director, los guionistas, y los encargados de los efectos especiales, porque hicieron un trabajo que será recordado y tomado como referencia por mucho tiempo para casos similares. Pero, ¿cómo lo lograron? Pues lo lograron con mucha imaginación y talento. Y después de yo mismo investigar (por curioso) por toda la red buscando todo tipo de información al respecto, a continuación les explico cómo lo hicieron... Lo primero a entender es que se utilizó toda una mezcla de técnicas para "revivir" a Walker en pantalla, la más simple de todas siendo el de reutilizar tomas ya capturadas de él (en escenas descartadas) de las últimas tres películas, para ver cuáles escenas, poses, líneas habladas, tomas, o imágenes se podrían utilizar para encajar con la nueva película. En esencia se creó toda una biblioteca de recursos audio-visuales de Walker, meticulosamente catalogados, y hechos disponibles a los guionistas, para ver como incorporar eso en lo que sería el nuevo guión. En segundo nivel, lo que se hizo fue utilizar a dos hermanos de Walker como dobles, en donde sus cuerpos eran utilizados en tomas de distintos ángulos, y después sus caras eran reemplazadas por la de Walker. Para lograr esto, se tenía escaneada en una base de datos la cara en 3D de Walker (algo que se hace comúnmente hoy día con muchos actores, particularmente en películas de alto presupuesto), la cual fue digitalmente manipulada para encajar a la perfección con la cara de sus hermanos. Esto se hace usualmente poniendo unos puntitos lumínicos en la cara de los dobles, los cuales son seguidos en tiempo real y en 3D por un software conectado a cámaras de alta resolución. El software después es capaz de utilizar esos puntos de referencia en 3D para saber la posición y dirección de la cara de los dobles, y saber exactamente en qué posición y dirección poner la cara digital de Walker. Vale la pena decir que este es un proceso extremadamente lento, tedioso, laborioso, y que requiere de mucho talento y todo un personal de expertos visuales (por eso que no les sorprenda que el traer a Walker a la vida otra vez le costó a los estudios unos US$50 Millones de dólares adicionales), pues hay que manipular cada cuadro de película uno a uno para asegurarse de que no existan imperfecciones de tamaño, iluminación, color, expresión, etc. A otro nivel, otra cosa que tuvieron que hacer fue crear nuevas lineas habladas, las cuales eran pronunciadas por uno de los hermanos, y posteriormente manipuladas sonoramente para aproximar o igualar el sonido a la voz de Walker, y todo esto sincronizarlo con movimientos digitales de una boca digital de Walker que pronunciaba las palabras. Y créanme que el resultado fue espectacular, y fue espectacular precisamente por el hecho de que los efectos especiales no se notaron en lo absoluto en el 99% de los casos, lo que realmente es un gran logro para esta o cualquier película. Ahora solo esperemos que cuando la película salga en DVD y Blu-ray, que los realizadores incluyan material adicional detallado sobre el proceso que conllevó esto en el día a día. Mientras tanto, no dejen de ir al cine a ver esta película en una buena pantalla con buen sonido, esta es una de esas que es mejor verla en grande... Y si se preguntan si veremos Rápido y Furioso 8, pueden estar casi seguros de ello, particularmente dado el gran éxito en taquillas que este capítulo está teniendo (que de por sí solo hoy día casi garantiza otra secuela), y el buen trabajo de los actores nuevos en la película (Jason Statham como "el malo"), y el cameo de Kurt Russell que prácticamente nos da una pista sobre lo que veremos en la 8, la cual continuaría evolucionado la serie hacia nuevos horizontes... Avance/trailer a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, marzo 6, 2015

|

A veces me asombra como empresas se ciegan ante tremendas oportunidades que para muchos fuera de sus oficinas son sencillamente obvias... A veces me asombra como empresas se ciegan ante tremendas oportunidades que para muchos fuera de sus oficinas son sencillamente obvias...Tomemos el ejemplo de hoy: La empresa Lytro acaba de anunciar que despedirá a muchos empleados con miras a reenfocarse en otro mercado, el mercado de video (y a menor medida, también el mercado de la Realidad Virtual). Para los que desconocen a Lytro, esta es una empresa que inventó y mercadeó una cámara revolucionaria del mismo nombre, que tiene la asombrosa particularidad de poder enfocar la imagen después de uno haber capturado la foto. En otras palabras, simplemente apuntas tu cámara a lo que desees capturar, y posteriormente en tu casa u oficina tu puedes elegir (por medio de un software especializado en tu PC) cuáles elementos de la fotografía deben permanecer enfocados y cuáles no. Incluso la empresa ofrece un componente web que incrustas en páginas y redes sociales que permite que las audiencias de tus fotos jueguen después con la imagen enfocándola en varios puntos (vean algunos ejemplos aquí). Sin embargo, y como mencioné par de veces previamente, aunque eso está genial desde el punto de vista que se ve como algo "chévere", no iba a acabar con el mercado actual, debido a (entre otras razones) (1) su alto costo, (2) falta de un ecosistema de lentes y otros accesorios (es decir, el sector profesional), y (3) el hecho de que realmente aunque es algo chévere poder hacer esto en fotos, no es que sea una gran necesidad per-se para la mayoría de personas, particularmente en un mundo en donde celulares ofrecen ya fotos asombrosas con buen enfoque en la mayoría de casos. Y eso nos lleva al tema de hoy... Hace 4 años le sugerí a la empresa (en este artículo acá mismo en eliax, y por email a ellos) que el mercado de ellos no era la fotografía, sino más bien la cinematografía (es decir, el cine). ¿Por qué? Pues porque uno de los elementos más difíciles del cine (y para lo que usualmente se paga a un empleado aparte a tiempo completo, y se necesitan todo tipo de tecnologías para ayudar) es lo que se llama "focus pulling", o el acto de enfocar correctamente una imagen en movimiento. Para consumidores esto no aparenta ser gran cosa, ya que aparenta que la mayoría de cámaras de video enfoca apropiadamente, pero en cine, con sensores más grandes, y con resoluciones mayores, el tema se multiplica exponencialmente y es bastante difícil mantener una imagen enfocada, razón por la cual un buen focus-puller en Hollywood es altamente cotizado con su salario. Y estos focus-pullers justifican su salario ya que si una toma está fuera de enfoque casi perfecto, esa toma se descarta, arruinando la toma, perdiéndose oportunidades creativas, y extendiendo el tiempo y presupuesto de los proyectos. O en otras palabras, malos enfoques se traducen en pérdidas en dinero. ¿Pero qué tal (y esto es lo que no concibo en mi mente que le haya tomado 4 años para darse cuenta a la gente de Lytro), si las cámaras de cine estuviesen dotadas de un sistema de Lytro en donde no importa el enfoque en lo absoluto, sino que eso ya sea una labor en post-producción? Eso sería sencillamente fenomenal. Y no solo fenomenal en el sentido de que resuelva el tema de no tener que enfocar, sino que además abre nuevas oportunidades que antes no existían para uno poder tratar el tema de enfoque como un elemento más desde el punto de vista creativo en las producciones. De modo que por ejemplo se puedan elegir varios puntos de enfoque a la vez, o reducir o expandir el efecto de fondo difuso al antojo. Eso, es lo que Lytro debió hacer desde el inicio, y esperemos que lo que sea que estén planeando ahora, lo implementen bien... Yo personalmente no sacaría toda una cámara o sensor con esta tecnología, sino que licenciara la tecnología a los mayores fabricantes de sensores y cámaras del mercado, como son Alexa, RED, Sony, Canon, BlackMagic, y otros... autor: josé elías |

|

|

|

|

|

jueves, enero 22, 2015

|

Microsoft. Esa sola palabra en la era de Bill Gates era sinónimo de Google o Apple hoy día, pero desde que Steve Ballmer tomó el reinado la empresa entró en un tremendo estado de complacencia, pensando solo en ordeñar sus franquicias de Windows, Office y productos empresariales existentes, ofreciendo algunas mejoras en tales productos, pero olvidándose por completo en innovar cosas nuevas... Microsoft. Esa sola palabra en la era de Bill Gates era sinónimo de Google o Apple hoy día, pero desde que Steve Ballmer tomó el reinado la empresa entró en un tremendo estado de complacencia, pensando solo en ordeñar sus franquicias de Windows, Office y productos empresariales existentes, ofreciendo algunas mejoras en tales productos, pero olvidándose por completo en innovar cosas nuevas...Y el tema de innovación es precisamente lo que dejó atrás a Microsoft ante titanes de hoy día, lo que es una verdadera lástima ya que como he dicho por años, Microsoft posee uno de los departamentos de Investigación y Desarrollo más avanzados del mundo, pero bajo Ballmer ese departamento simplemente investigaba pero no desarrollaba nada tangible para el mercado. Y si quieren tener una idea de a qué me refiero cuando digo que en esos laboratorio de Microsoft están algunos de los más grandes genios sin reconocimiento del mercado, solo miren lo que hace 5 años Microsoft ya tenía funcionando tras bastidores. Pero para suerte de Microsoft, su nuevo CEO (Gerente General) Satya Nadella parece que realmente tiene una estrategia en mente para sacar a Microsoft de la tumba que ha cavado para sí misma, pues ha estado tomando unas excelentes decisiones en tiempos recientes, que van desde despidos masivos de burócratas y liquidar centenares de proyectos inservibles, hasta unificar a Windows (bajo el código “10”) y revivir su inapreciado departamento de I+D, y uno de estos grandes frutos fue el anuncio que acaba de hacer de su tecnología HoloLens (bajo la plataforma "Windows Holographic" que será parte de Windows 10). HoloLens en su forma más desnuda no es más que unas gafas de Realidad Aumentada, que Microsoft está mercadeando como unas gafas que crean “hologramas”, pero realmente no son hologramas, sino que proyecciones tridimensionales en los ojos que se mezclan con el mundo real, tal cual describí una vez con mi IrixPhone, solo que en vez de estas gafas desplegar imágenes directamente a la retina, lo hace con un par de pantallas translúcidas que se despliegan en el visor. O en otras palabras, estas gafas no proyectan nada en el mundo real, sino que en nuestros ojos dando la ilusión de que vemos imágenes tridimensionales mezcladas con el mundo real. Sin embargo, sería un crimen llamar al HoloLens unas simples gafas más de Realidad Aumentada, pues a diferencia de lo que hasta ahora hemos visto en el mercado (y eso incluye al Google Glass), estas van mucho más allá a todo un nuevo nivel (al menos si nos llevamos de lo que promete Microsoft técnicamente). Las gafas HoloLens, que más bien son un semi-casco en vez de gafas, contienen toda una computadora integrada dentro de las gafas mismas, sin necesidad en lo absoluto de necesitar dispositivos externos para operar, ni cables para conectarse a nada. No se necesita ni de una PC externa (como las gafas de Realidad Virtual del Oculus Rift que ahora posee Facebook), ni de un celular móvil (como las gafas de realidad virtual de Samsung). El HoloLens posee todo lo que necesita en su interior, desde las pantallas y baterías, hasta los sensores y procesadores. Y hablando de procesadores, Microsoft desarrolló no solo un CPU (procesador genérico) y GPU (procesador de gráficos y de computación altamente paralelizable), sino además lo que llama un “Holographic Processing Unit” o HPU, que esencialmente es un circuito integrado con computación masiva creada específicamente para manejar el gran flujo de datos necesarios para que el HoloLens pueda entender el mundo a su alrededor, y por “entender el mundo a su alrededor” me refiero precisamente a eso… El HoloLens debe tener la capacidad de utilizar sensores similares a los de celulares inteligentes modernos (como giroscopios, brújulas, etc), para saber con exactitud la dirección y ángulo de inclinación de tu cabeza en relación al mundo exterior, así como poder deducir en base a las imágenes que ve (pueden estar seguros que el HoloLens debe tener al menos 2 cámaras especializadas para tal fin, y quizás más) el espacio tridimensional a tu alrededor. Es decir, el HoloLens posee la capacidad de poder crear internamente en su memoria una representación tridimensional virtual cruda del espacio real en donde te encuentras (sin duda utilizando muchos trucos aprendidos del proyecto Kinect del departamento Xbox), lo que le permite entonces poder superimponer imágenes sobre el mundo real de forma tal que estas imágenes aparenten que están realmente en nuestro mundo físico. Así que por ejemplo, el HoloLens puede (por medio de sus dos pantallas, una para cada uno de tus ojos), proyectar una imagen 3D que concuerde con el mundo exterior, de modo que si tienes una mesa en frente de ti, el HoloLens pueda “proyectar” sobre la mesa un objeto 3D virtual, como por ejemplo un florero, o un juego, o una escultura, o un libro, o hasta una tableta virtual. La idea final siendo que aparente que lo que ves en tus gafas sea parte de tu propio mundo. Esto, en mi opinión, es totalmente genial, y aunque de seguro no proveerá un mundo tan inmersivo como las gafas Oculus Rift (que te bloquean el mundo externo por completo y los reemplazan por uno virtual), el HoloLens abre toda una gama de posibles usos que van desde entrenamientos a distancia hasta aprendizaje virtuales, y desde video-juegos hasta herramientas de diseño para arquitectos. Es importante también notar que Microsoft no no está planeando crear gafas de Realidad Virtual con el HoloLens, sino que tratando de crear una nueva experiencia de computación personal con Realidad Aumentada. Sin embargo, hay muchos retos que veo para que estas gafas sean masivamente exitosas, y varios de esos retos veremos si Microsoft logró conquistarlos cuando estas gafas entren al mercado posiblemente antes de finalizar el año. Entre esos retos están el de “lag”, o el retraso que podría existir entre el tiempo que una persona mueve su cabeza y el tiempo que las imágenes virtuales se proyectan sobre el mundo físico. Si este tiempo es notablemente perceptible, se romperá el efecto de Realidad Aumentada y muchas personas tendrán problemas en aceptar la realidad que dicho dispositivo plantea desplegarle al cerebro. Otros retos son el de la resolución de las pantallas (que creo no será un problema, dado las resoluciones de pantallas en celulares hoy día que ya en varios casos incluso sobrepasan con creces la calidad de imagen HD de televisores hoy día), el de la duración de la batería, el costo, el de convencer a muchos desarrolladores para que hagan aplicaciones que verdaderamente muestren el potencial de esta tecnología (que de paso es bueno aclarar viene con sonido tridimensional para hacer más convincente el efecto “holográfico”), el peso (que puede ser un factor negativo a la hora de utilizar el dispositivo por largo períodos de tiempo), y el tamaño (que lo restringiría mayoritariamente a uso en interiores). Pero al final del día, independientemente de si HoloLens será exitoso o no, esto es un buen ejemplo de un producto que por sí solo puede hacer ver a Microsoft como una empresa capaz de innovar una vez más, y de competir con lo mejor de los titanes de hoy día. Yo personalmente les deseo mucha suerte con este proyecto, y ya estoy en cola para probar estas gafas desde que salgan al mercado… Nota: Para los que llevan cuenta, esta fue mi predicción #34 para este año 2015. página oficial del Microsoft HoloLens Video del anuncio del HoloLens a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, enero 19, 2015

|

|

Hoy los dejo con un video de una increíble tecnología desarrollada en Carnegie Mellon University en los EEUU en donde es posible tomar una fotografía normal en 2D, elegir un objeto tridimensional de esta, y manipularlo al antojo en su entorno fotográfico.

Esta es una de esas cosas que hay que ver para entender (y creer). De la manera que esta tecnología funciona es consultando primero una base de datos de objetos tridimensionales (de los cuales ya posee información de la forma volumétrica del objeto), y después utilizar esa información para reconocer objetos similares en la fotografía. Cuando reconoce el objeto, el software reemplaza el objeto de la foto por el objeto 3D, pero manteniendo las propiedades de color, textura y sombras del original, para aparentar que uno lo está manipulando directamente. Noten que esto está relacionado a otra tecnología que inserta objetos virtuales 3D en fotografías 2D, y de la cual les hablé acá mismo en eliax hace unos años. Y también está relacionado a esta otra tecnología que extrae imágenes 3D de fotografías 2D. página oficial del proyecto Y si quieren hacer que esta herramienta se haga realidad para el público en general, contribuyan con la campaña crowdsource en este enlace. ¡Gracias al lector Erik Roy por compartir el video en el grupo oficial de #eliax en Facebook! Video a continuación (enlace YouTube)... Video expandido a continuación, con más detalles (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, octubre 11, 2014

|

Por cerca de una década les he estado informado acá en eliax de tecnologías que permiten de forma limitada restaurar la visión de personas de forma artificial, y este video de hoy resume bastante bien la parte humana de todo esto... Por cerca de una década les he estado informado acá en eliax de tecnologías que permiten de forma limitada restaurar la visión de personas de forma artificial, y este video de hoy resume bastante bien la parte humana de todo esto...En este caso se trata de Larry Hester, un hombre que había pasado alrededor de la mitad de su vida (exactamente, unos 33 años) ciego debido a la condición de retinitis pigmentosa, y que ahora gracias a tecnología desarrollada en Duke University puede experimentar la sensación cruda de ver nuevamente. El dispositivo que ven en el video consiste de una cámara incrustada justo entre los dos lados de la gafa, que envía imágenes a una computadora portátil, la cual a su vez genera imágenes en forma de estímulos eléctricos que van directamente al área del cerebro responsable de procesar imágenes. Es importante entender que Hester no ve como vemos todos nosotros, a todo color y alta definición, sino más bien de forma bastante pixelada, de baja resolución, y a blanco y negro. Sin embargo, como bien dice Hester, aunque para una persona con visión normal eso no sería motivo de siquiera llamar la atención, para él esto significa un cambio del cielo a la tierra, pues por primera vez en tantos años le da cierta independencia visual en su vida. Noten que una de las cosas que más me gustó del video fue la reacción de su esposa, quien demuestra uno de los gestos de amor más bellos que he visto en video en mucho tiempo, sintiéndose ella extremadamente feliz por la felicidad de su pareja... ¡Gracias Carlos Bello por compartir el enlace en el grupo oficial de eliax en Facebook! fuente Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

jueves, septiembre 25, 2014

|

|

Las gafas de Realidad Virtual, Oculus Rift, ciertamente están disparando la imaginación de muchos, y hoy los dejo con este video de un avance del programa TiltBrush.

Este es un programa para pintar literalmente en tres dimensiones, como si tus manos fueran brochas que pintan en el aire a todo tu alrededor, en vez de estar limitado a una superficie plana tridimensional. Obviamente tendrás que tener puesto el Oculus Rift para poder ver y disfrutar lo que estás haciendo, pero después que termines tu obra maestra la aplicación te dará la opción de generar una imagen GIF animada que puedas compartir con tus amigos. El video a continuación dice más que mil palabras... página oficial de Tilt Brush Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, agosto 19, 2014

|

|

Hoy los dejo con este increíble video de una tecnología de la cual ya habíamos visto unos cuantos avances en el pasado (ver por ejemplo esto acá mismo en eliax de hace 3 años), pero llevado ahora a todo un nuevo nivel en este proyecto de Omote...

Noten primeramente que el video que verán es totalmente real y no realizado digitalmente con efectos especiales. Lo que verán es como se proyecta un video generado en tiempo real (con lo que asumo es un proyector láser a color) sobre la cara de una modelo, mientras esta se mueve, pudiendo el sistema darle seguimiento a la cara de la modelo en tiempo real de modo que es posible proyectar una imagen que compagina con la posición y forma de su cara. El resultado final es la ilusión de que su cara cambia, o se maquilla dinámicamente como por arte de magia, y todo en tiempo real. Esta es una de esas cosas que hay que ver en vez de leer las explicaciones... Noten que esos puntitos blancos que ven en su cara están obviamente ahí para darle pistas al software de visión artificial sobre en qué posición y dirección se encuentra la cara. Así mismo noten que este sistema debe ser super optimizado para poder no solo hacer el tracking de la cara sino la generación en 3D de la imagen y proyección en tiempo real. Y noten que si notan con cuidado se fijarán que la modelo se mueve con relativa lentitud, ya que de mover la cabeza muy rápidamente eso haría que la proyección (debido a los cálculos necesarios) no llegan a tiempo y se pierda la ilusión al no proyectarse la imagen en el lugar correcto (algo que se nota levemente al comienzo del video cuando la modelo tiene los labios negros). ¡Gracias al lector Andrés Felipe Giraldo por compartir el video en el grupo oficial de eliax en Facebook! fuente oficial Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, julio 1, 2014

|

Hola amig@s lectores, Hola amig@s lectores,Como ya saben, soy un fanático del cine, y siendo un fanático siempre trato de buscar la mejor experiencia posible, y si algunos de ustedes buscan algo similar, no busquen más y diríjanse al cine IMAX más cercano que encuentren… Este artículo me lo inspiró el hecho de que por estos rumbos (República Dominicana) se abre el primer cine IMAX del país (en Santo Domingo, Blue Mall) el próximo jueves 3 de julio (con la Película Transformers 4, en 3D), y tuve el tremendo privilegio de ser invitado por Rafael Suarez, el Gerente de Mercadeo de Palacio del Cine (la cadena de cines que trajo la franquicia al país) durante el proceso de izar la colosal pantalla. Incluso tuve el privilegio (ya que el representante de IMAX no sabía español) de ser el que dirigió el proceso de la subida de la pantalla. Ya saben, uno de esos sueños mojados geek hecho realidad… :) Y desde entonces varios amigos me han preguntado qué es IMAX y qué lo hace tan especial y/o diferente a los cines tradicionales, y es mi objetivo de hoy responder a esas incógnitas… Lo primero es, que es importante entender que 3D y IMAX son dos cosas diferentes (pues noto que muchos confunden una cosa con otra). El 3D es un elemento opcional tanto del cine tradicional (tanto en celuloide como digital), así como lo es en IMAX, por lo que no confundan una cosa con la otra. IMAX es en realidad un formato “tamaño grande” del cine, en donde las imágenes (en el IMAX clásico) se capturaban en cintas analógicas de celuloide que ofrecían 10 veces el detalle de las cintas estándares de 35mm de la mayoría de las películas, y lograban eso con unas cintas inmensas (y con cámaras inmensas y difíciles de maniobrar). Hoy día, las imágenes de IMAX se capturan con cámaras especializadas diseñadas por IMAX, y con inmensos sensores que proveen una resolución y detalle de imagen incomparables con las cámaras y cines digitales tradicionales por su gran detalle, rango de colores, y contraste.  Aunque noten que en sus inicios, IMAX en realidad hizo su nombre como un sistema de proyección especializado mayoritariamente en museos y parques de atracciones, por lo que en sus inicios casi todo el material disponible en IMAX eran documentales. Así mismo, el IMAX clásico venía en un formato estilo “cúpula”, consistiendo en una descomunalmente grande pantalla (hablamos de varios pisos de alto) totalmente curva, en donde el público se sienta en literalmente frente a una media-esfera que cubre casi 180 grados de lado izquierdo a lado derecho, y unos 90 grados de abajo hacia arriba, cubriendo esencialmente la mayor parte del campo de visión. Aunque noten que en sus inicios, IMAX en realidad hizo su nombre como un sistema de proyección especializado mayoritariamente en museos y parques de atracciones, por lo que en sus inicios casi todo el material disponible en IMAX eran documentales. Así mismo, el IMAX clásico venía en un formato estilo “cúpula”, consistiendo en una descomunalmente grande pantalla (hablamos de varios pisos de alto) totalmente curva, en donde el público se sienta en literalmente frente a una media-esfera que cubre casi 180 grados de lado izquierdo a lado derecho, y unos 90 grados de abajo hacia arriba, cubriendo esencialmente la mayor parte del campo de visión.Noten además que estos descomunales cines son por lo general edificios especialmente construidos para alojar estas cúpulas IMAX, razón por la cual son bastante costosos y existen muy pocos de ellos, aunque son una experiencia sin igual (en una de ellas fue que vi Hubble 3D del cual les hablé hace varios años atrás acá en eliax) que recomiendo todo el mundo experimente aunque sea una vez en la vida. Sin embargo, conforme el nombre IMAX cobraba popularidad, la empresa decidió expandirse agresivamente por todo el mundo con pantallas más modestas, pero mucho más grandes que las pantallas de los cines tradicionales, y proyectando películas populares, particularmente películas “de espectáculo” como la trilogía de Batman, Iron-Man, Avengers, etc. Estas son por lo general (y hablo del 98% de los casos) las salas a las que todo el mundo se refiere cuando dice que va a ver una película en IMAX, y es el tipo de sala que recientemente llegó por estos rumbos (y el resto de América Latina). Pero antes de continuar, es importante entender algo importante: Lo que diferencia a IMAX de otros formatos es que similar a lo que hace Apple con su ecosistema en donde lo controla todo para ofrecer un alto control de calidad, IMAX controla por completo toda la experiencia de inicio a fin. Eso significa que IMAX es quien provee no solo las cámaras y el sistema de almacenamiento y procesamiento de las películas, sino que supervisa su parámetros de imagen (colorización, brillantes, contraste, etc), así como controla el diseño de las salas (incluyendo un estricto diseño de las butacas y colocación de los altavoces y pantalla, así como insulación contra ecos internos y ruidos externos), y provee los proyectores, altavoces, y la inmensa pantalla especializada en sí. Eso significa que IMAX controla la experiencia de inicio a fin, y debido a eso puede optimizar de una forma tal que los cines tradicionales “abiertos” (que combinan distintos proyectores con distintos diseños de salas y sistemas de sonido y pantalla) sencillamente no puedan igualar. Debido a este estricto control, la empresa incluso a optimizado tanto su sistema IMAX que la labor de proyeccionista es casi inexistente, ya que el sistema IMAX se auto-calibra diariamente con un sistema de sensores acústicos y visuales, que garantizan exactamente la misma experiencia IMAX, en cualquier parte del mundo, en cualquiera de sus salas, y a cualquier hora del día y con cualquier película. Este es un cine en donde nunca verán una imagen mal "cuadrada" o descentralizada, o con altavoces que se escuchan mal. Este es real y literalmente el mejor cine disponible, y IMAX se asegura de ello, ya que todos los cines IMAX del mundo son monitoreados constantemente por Internet por un sistema centralizado de IMAX, por lo que si una sala deja de cumplir con los estándares de la empresa de imagen y sonido, esta deja de operar. Para los curiosos locales, en el caso del IMAX en el Palacio del Cine de Blue Mall, la pantalla mide 15.54 metros x 8.53 metros (o unos 51 pies de ancho por 28 pies de alto) en formato semi-curvo, así como incluye un super-potente sistema de sonido que no solo es envolvente y de sonido super nítido, sino tridimensional, pudiendo el sistema de sonido IMAX poder colocar cualquier sonido en cualquier punto de la sala para crear efectos aun más realistas acorde con lo que vemos en pantalla. IMAX además, como mencioné anteriormente, provee un formato 3D (que lo ha proveído casi desde sus inicios), y la empresa recientemente desarrolló todo un nuevo proceso digital para 3D que estrena en masa por primera vez con la película Transformers 4, por lo que si pueden, no dejen de asistir a este evento, pues sin duda será una experiencia sin igual para los amantes del cine. Nos vemos en el estreno este jueves… ;) autor: josé elías |

|

|

|

|

|

lunes, mayo 19, 2014

|

Maquillaje facial, un compañero de las mujeres (y algunos hombres) a todo lo largo de la historia humana, y después de milenios por fin se aproxima el primer gran cambio en cómo se fabrican estos productos con fines estéticos... Maquillaje facial, un compañero de las mujeres (y algunos hombres) a todo lo largo de la historia humana, y después de milenios por fin se aproxima el primer gran cambio en cómo se fabrican estos productos con fines estéticos...Una empresa de nombre Mink, fundada por Grace Choi, pronto lanzará una impresora con el mismo nombre de Mink que permitirá que imprimas tus propios colores de maquillaje en tu propia casa. Y a diferencia de los limitados colores que puedes comprar en una tienda, con la impresora Mink puedes imprimir cualquier color que desees, lo que te permitirá la experimentación sin tener que invertir fuertes sumas de dinero o dar viajes a las tiendas de cosméticos, o esperar a que lleguen tus productos después de ordenarlos por Internet. Como explica la misma Grace en algunas de sus entrevistas, el gran secreto de la industria de cosméticos faciales es que virtualmente el mismo cosmético que compras de una marca es el que utiliza otra, ya que casi todas ellas compran de los mismos fabricantes los pigmentos y bases necesarias para crear el maquillaje, y el precio usualmente no lo determina la calidad, sino cosas tan tontas como la marca. Pero Grace planea ponerle fin a todo eso con la Mink. La idea es que compres una sola vez la impresora (se estima que el primer modelo costará unos US$300 dólares), pero de ahí en adelante solo tendrás que comprar los pigmentos (el equivalente a las tintas líquidas en impresoras tradicionales), pero con la gran diferencia de que los costos de estos pigmentos serán muchísimo más baratos que comprar el maquillaje en una tienda, y de paso te ofrecerán la capacidad de poder crear cualquier color, en la cantidad que desees, y cuando lo desees, sin tener que salir de casa. Y asombrosamente, la impresora puede imprimir una gran variedad de maquillajes, incluyendo sombras, pinta-labios, esmalte de uñas, etc, por lo que realmente reemplazaría todo un estuche carísimo de cosméticos. Si esto es implementado tan bien como aparenta en los videos, podríamos estar ante una verdadera revolución en esa industria... página oficial de la Mink Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, mayo 18, 2014

|

Si recuerdan, en Marzo pasado de este 2014 Facebook anunció la compra de Oculus Rift por la suma de US$2 Mil Millones de dólares, y para muchos esta fue una compra extraña, y otros tantos no entendían la razón de esta compra... Si recuerdan, en Marzo pasado de este 2014 Facebook anunció la compra de Oculus Rift por la suma de US$2 Mil Millones de dólares, y para muchos esta fue una compra extraña, y otros tantos no entendían la razón de esta compra...Pero parece que mi análisis y predicción del suceso dieron directamente en el clavo, pues Facebook acaba de anunciar precisamente lo que predije ellos harían con esta tecnología: Una nueva generación de mundos virtuales, una especie de Facebook en un mundo tangiblemente virtual. Por ahora no tenemos muchos detalles sobre la forma que tomará este mundo al estilo MMO (un mundo masivo en escala para múltiples personas en tiempo real, por sus siglas en inglés), pero si nos llevamos de las palabras que emitió justo anoche el CEO de Oculus, Brendan Iribe, el objetivo es ingresar a al menos "mil millones de personas" a este nuevo mundo virtual. ¿Tendrá éxito Facebook con esto? Pues ciertamente Facebook es una de las empresas mejor posesionadas para hacer esto realidad, junto a empresas como Google, Apple, Amazon, y empresas de video-juegos como Sony, Microsoft y Nintendo. Y hablando de esos otros jugadores del mercado, es bueno notar (como también publiqué y opiné en Marzo acá en eliax) que Sony ya se está armando para entrar con ambos pies a la batalla de los mundos virtuales inmersivos. No solo ya ha anunciado y demostrado a la prensa su "Project Morpheus", sino además reveló que el motivo de existir la extraña luz detrás de los nuevos controles del PlayStation 4, fue para soportar su tecnología de VR (Realidad Virtual) de Morfeo cuando esta estuviera lista para el mercado, lo que nos indica que la empresa ha estado planeando bien su jugada en el espacio. Eso de paso hará que las millones de personas que han estado utilizando por años el mundo virtual de Second Life, tomen nota del esfuerzo de Facebook y posiblemente se conviertan en sus primeros grandes adoptantes. Facebook (y Sony) mientras tanto, tendrán que superar un par de obstáculos antes de que esta tecnología se masifique... El primero de esos obstáculos es el precio de estos dispositivos. En teoría Facebook debería poder bajar el precio del Oculus Rift por debajo de los US$300 dólares, y si la empresa o Sony llegaran por debajo de los US$200, eso quizás sería suficiente para crear una masa crítica de "adoptantes primerizos" lo suficientemente grande como para que la tecnología se masifique viralmente a cientos de millones de usuarios, o quizás a los miles de millones que aspira Facebook (y es mi opinión personal que tarde o temprano eso sucederá, sea con o sin Facebook. No es cuestión de si sucederá o no, sino más bien de cuando)... El otro obstáculo es el tema de comodidad de las gafas (pues podrían pesar lo suficiente como para ser incómodas por largos períodos de tiempo) y el tema del lag (retraso entre uno expresar la acción a sus músculos de querer mover la cabeza y el cuerpo, y el tiempo que toma en uno percibir el movimiento dentro del mundo virtual). Sin embargo, en ambos casos aparenta que estas empresas están avanzando muchísimo, y además es importante notar que una de las grandes ventajas del Oculus Rift (y posiblemente de PS Morpheus) es que son una de esas tecnologías que cuando uno las prueba por primera vez uno queda anonadado. Similar al efecto que tuvo el novedoso control WiiMote del original Nintendo Wii, por lo que cuando menos el factor "¡uao!" está a favor de ellos, y no duden que más allá de Facebook y Sony que tarde o temprano veremos a los demás jugadores entrar también al mercado... Y a propósito, parece que esta otra predicción mía de hace un par de años también se está haciendo realidad... autor: josé elías |

|

|

|

|

|

jueves, mayo 15, 2014

|

Hoy los dejo con este interesantísimo video de lo que ocurre cuando combinas las gafas de Realidad Virtual Oculus Rift (ahora propiedad de Facebook), y los sensores tridimensionales Kinect del Xbox/Windows. Hoy los dejo con este interesantísimo video de lo que ocurre cuando combinas las gafas de Realidad Virtual Oculus Rift (ahora propiedad de Facebook), y los sensores tridimensionales Kinect del Xbox/Windows.Para los que no saben lo que ocurre, la persona (Oliver Kreylos) que tiene el visor puesto puede ahora verse a él mismo en el video tal cual es en la realidad (o al menos, de forma aproximada) ya que 3 sensores Kinect conectados en varios puntos de su habitación capturan su imagen en tiempo real y proveen una imagen virtual de su cuerpo (y silla) al mundo virtual desplegado antes sus ojos con las gafas virtuales. Noten que la mesa que ven justo frente a él, no existe, y es totalmente virtual, pero la experiencia se siente tan realista que él dice que sus piernas tratan de evitar las patas de la mesa virtual para evitar chocar contra ellas, aun en el mundo "real" no exista tal mesa. Algo a notar es algo que menciona el mismo investigador, y es el hecho de que aunque la imagen que se forma de su propio cuerpo en el mundo virtual no es perfecta, el hecho de que sus movimientos y apariencia sea tan parecida a su cuerpo real hace que él se sienta que literalmente está viendo su cuerpo, lo que aumenta considerablemente la experiencia de "estoy aquí adentro". Noten además que de vez en cuando él utiliza un punto de vista diferente al de él mismo para mostrar su cuerpo desde el punto de vista de un tercero, lo que debe ser una sensación extraña ya que es como salirte de tu cuerpo y verte a ti mismo. Y no duden por un segundo que en un futuro este tipo de cosas será órdenes de magnitud más realista que lo que vemos acá, incluso pudiéndose reemplazar el visor virtual que vemos dentro del mundo virtual, por la cara real de la persona, para así completar aun más la ilusión de que estamos en un Holodeck de Star Trek (particularmente cuando combinemos esto con más de una persona a la vez). ¡Gracias a todos los lectores que me alertaron de este video! fuente oficial con más detalles Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

viernes, mayo 9, 2014

|

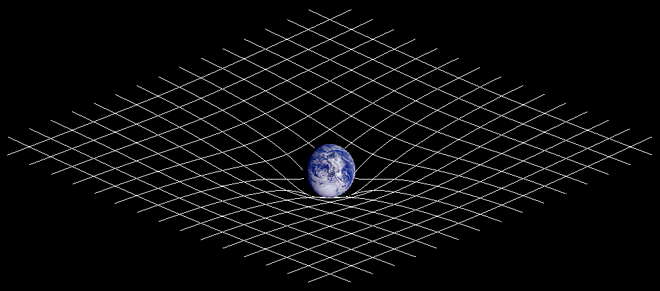

Por sorprendente que sea, sobre el 99.99% de todas las representaciones gráficas de la fuerza universal de la gravedad que han visto en sus vidas, están ilustradas incorrectamente. En serio. Por sorprendente que sea, sobre el 99.99% de todas las representaciones gráficas de la fuerza universal de la gravedad que han visto en sus vidas, están ilustradas incorrectamente. En serio.Pero, ¿a qué se debe ese error y cuál debería ser la representación visual correcta, o al menos la mejor representación posible? Pues de esto se trata este artículo de hoy en eliax... Para empezar, veamos la forma "clásica" (e incorrecta) de mostrarse visualmente el concepto de la Gravedad, como podemos ver en la siguiente imagen proveniente de la página sobre Gravedad en Wikipedia.  En esta representación clásica, se utiliza el ejemplo de un espacio cuadriculado parecido al de una cama de dormir sobre la cual se coloca una esfera pesada (en este caso, una esfera representando la Tierra), y vemos como el espacio se curva alrededor de la esfera. Pero esa representación es errónea, o cuando menos puede llevar a uno no entender realmente lo que sucede aquí. El problema es que en esa imagen lo que se muestra inadvertidamente es lo contrario a la gravedad, en donde el espacio se empuja hacia afuera de la Tierra en vez de halarse hacia adentro en tres dimensiones. ¿Pero cómo es que todo el mundo siempre utiliza ese mismo ejemplo? Pues por varias razones, y entre ellas están: 1. Por motivos didácticos esa es quizás la forma más simple de explicar el concepto, aun sea erróneo y aun sea posible explicarlo mucho mejor de otras formas. 2. Vagancia por parte de los científicos a la hora de demandar más de los artistas que hacen estas ilustraciones. 3. Relacionado al punto anterior, la ignorancia inocente de los artistas de no saber exactamente qué es lo que deben mostrar visualmente, ya que estos no son físicos sino artistas. 4. Asombrosamente, existen muchos físicos que entienden las matemáticas, pero no entienden lo que estas significan realmente "en la vida real", e ilustran erróneamente el concepto. Afortunadamente, hay algunas personas que viven entre ambos mundos (de las artes y las ciencias) y hacen un esfuerzo de ilustrar esto lo más fiel a la realidad posible, que fue precisamente lo que en mi caso hice cuando escribí e ilustré mi libro Máquinas en el Paraíso en el 2001, en donde ilustré correctamente el concepto de la gravedad y que es exactamente la misma ilustración que utilizo a continuación en este artículo de hoy en eliax...  Como pueden observar en esta imagen animada, les presento un "pedazo de universo" en forma de cubo, en donde para fines didácticos he fijado todos sus bordes (los cuales en la realidad también se estuviesen expandiendo o contrayendo), y en donde se puede apreciar claramente el efecto que tiene una esfera (que podemos imaginar como la Tierra, o un Agujero Negro) en el momento que esta se acerca a ese cubo de espacio. Como pueden ver, el espacio es atraído hacia la esfera, y mientras más lejano está el objeto, menos la elasticidad, y mientras más cercano el objeto, más la elasticidad y compresión del espacio alrededor del objeto (ojo, debido a que fijé los bordes, esto no se hace tan evidente en el momento que la esfera está justo pasando la pared del cubo, pero eso ya será algo que ilustraré mejor en una futura versión de esto, por ahora simplemente decidí reutilizar lo que hice en el 2001). Eso de paso nos permite entender mejor un concepto que para muchos se hace contra-intuitivo: La gravedad, como expliqué hace 5 años acá mismo en eliax, no solo es una distorsión en el espacio-tiempo, sino además que si la visualizamos correctamente nos puede explicar por qué los objetos giran en torno a otros. Por ejemplo, la Luna gira en torno a la Tierra, la Tierra en torno al Sol, y el Sol en torno a un super-masivo Agujero Negro en el corazón de nuestra galaxia La Vía Láctea. Pero, ¿por qué giran y qué es lo que los mantiene atados? Pues si notan en mi versión ilustrada de la gravedad (y asumiendo que la esfera es el planeta Tierra), cuando la Tierra está justo en el centro del cubo, el espacio a su alrededor es distorsionado en forma de un embudo tridimensional, en donde en todas direcciones lo que sea que esté cerca de la Tierra tiene que "caer" hacia el centro. Sin embargo, debido a que la Luna está continuamente moviéndose alrededor de la Tierra a una velocidad que proviene desde los mismos inicios violentos del Sistema Solar, esta velocidad equilibra a la Luna para que esta no caiga y se estrelle contra la Tierra. Es esencialmente el mismo concepto de una ruleta en un casino, en donde tiramos la bolita blanca alrededor de la ruleta, y mientras esta tenga suficiente velocidad esta no caerá al centro de la ruleta. Noten además que si la ruleta no tuviera las paredes externas que impiden que la bolita blanca se salga de esta, que al momento de uno tirar la bolita en la ruleta esta en vez de caer al centro (después de perder velocidad) podría muy bien salirse de la ruleta si la velocidad inicial con la que tiramos la bolita es demasiado rápida... Pues similar a esa bolita en la ruleta, la Luna tiene una velocidad determinada que va acorde con su masa, y sucede que en el caso de nuestra luna, esta tiene más velocidad del equilibrio, por lo que asombrosamente (para los que no sabían este dato) esta se aleja de la Tierra cerca de 4 centímetros por año, lo que significa que eventualmente (en un futuro muy lejano) la Luna escapará a la fuerza gravitacional de la Tierra y será un ser errante del Sistema Solar, que quizás sea capturada por otro planeta, como el gigante Jùpiter. Así que ahí lo tienen, la forma más sencilla que me puedo imaginar de explicar el concepto de los efectos gravitacionales en los objetos, lo cual espero sirva de comida intelectual para todas las mentes curiosas que visitan este espacio... autor: josé elías |

|

|

|

|

|

viernes, mayo 2, 2014

|

Hoy los dejo con un recurso extraordinario... Hoy los dejo con un recurso extraordinario...El pasado 18 de abril de este 2014 la nave SpaceX Dragon llevó a la Estación Espacial Internacional un módulo que contiene 4 cámaras experimentales, con el propósito de estas capturar y enviar video en tiempo real de la Tierra, continuamente y en HD (Alta Definición), y las cámaras ya están operando y el video ya se puede ver desde el portal uStream (o incrustado acá abajo en eliax). Al experimento lo han denominado el High Definition Earth Viewing (HDEV), o "Vista de la Tierra en Alta Definición". Noten que incluyo acá abajo dos cuadros de video. El primero tiene una resolución más baja (480 x 302 pixeles) para acomodar a la mayoría de personas que no tengan una conexión de Internet muy rápida, y el segundo es con resolución de 720 x 438 pixeles, pero si desean ver el video en aun una mayor resolución HD, los refiero a la página oficial del experimento en uStream. ¡Gracias a todos los que me enviaron esta noticia, principalmente en Universe Today! Video 1 a continuación (en resolución baja)... Video 2 a continuación (en mayor resolución)... autor: josé elías |

|

|

|

|

|

viernes, abril 11, 2014

|

¿Alguna vez te has preguntado como te verás dentro de X cantidad de años? Pues eso mismo se preguntaron unos investigadores de la Universidad de Washington en los EEUU, y crearon un increíble software que permite predecir con asombrosa precisión cómo te verás dentro de una cantidad específica de años. ¿Alguna vez te has preguntado como te verás dentro de X cantidad de años? Pues eso mismo se preguntaron unos investigadores de la Universidad de Washington en los EEUU, y crearon un increíble software que permite predecir con asombrosa precisión cómo te verás dentro de una cantidad específica de años.El software incluso puede tomar una foto tuya de cuando tenías apenas 2 o 4 años, y decirte como te verás a los 60 o incluso 80 años. Pero, ¿cómo sabemos que funciona? Pues comprobando los resultados con fotografías de personas ancianas de quienes también tenemos fotografías de cuando eran jóvenes, para ver si el programa puede predecir la apariencia de hoy día basado en la fotografía de hace varias décadas atrás. Y lo asombroso es que los resultados son muy cercanos a la realidad. Esto, más allá de su potencial como una herramienta curiosa, tiene usos prácticos que nos podemos imaginar, como por ejemplo para predecir cómo se verían personas hoy día que de niños fueron raptados o perdidos, así como podría también utilizarse para encontrar terroristas de quienes solo poseemos fotografías en edades mucho más jóvenes. Otro uso que me imagino que se le puede dar a esto es utilizar el software al revés, empezando con una cara reciente y tratando de predecir cómo te verías de niño. Esto por ejemplo podría ser utilizado por empresas de redes sociales como Facebook u otra red social para automáticamente etiquetar fotos de nosotros de cuando éramos mucho más jóvenes. Pero más allá de esos usos, yo por el momento lo que desearía es que liberaran este software como una aplicación web o móvil, para que cada uno de nosotros podamos ver como nos veríamos nosotros mismos, así como nuestros familiares, amigos y conocidos, dentro de unos años... :) página oficial del estudio autor: josé elías |

|

|

|

|

"Estos tiempos son los mejores de la humanidad, ojalá y tengamos la oportunidad de saber sobre vida en otro planeta y aun mejor que esta sea inteligente y podamos comprender más sobre lo que realmente es la vida."

en camino a la singularidad...

©2005-2026 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax