Almacenamiento

|

jueves, noviembre 18, 2010

|

Parece que fue hace apenas un año en donde un disco duro de 1TB parecía algo exclusivo de unos cuantos, y hoy día Hitachi ya ha anunciado un nuevo disco duro de 3TB (el Deskstar 7K3000 ), con una rotación de 7200RPM, 64MB de cache, y un interfaz SATA de 6Gbps. Se rumorea un precio alrededor de los US$300 dólares cuando salga al mercado en cualquier momento... Parece que fue hace apenas un año en donde un disco duro de 1TB parecía algo exclusivo de unos cuantos, y hoy día Hitachi ya ha anunciado un nuevo disco duro de 3TB (el Deskstar 7K3000 ), con una rotación de 7200RPM, 64MB de cache, y un interfaz SATA de 6Gbps. Se rumorea un precio alrededor de los US$300 dólares cuando salga al mercado en cualquier momento...Página oficial del producto autor: josé elías |

|

|

|

|

|

lunes, noviembre 8, 2010

|

Este artículo de hoy es para ingenieros y científicos en computación, y es uno que prometí desde que implementé el nuevo motor de blog de eliax 2.0 (actualmente en versión beta) en Febrero de este año, y lo que les mostraré es una técnica que les ayudará a acelerar enormemente estructuras de datos jerárquicas, con un truco lineal de mi autoría. Este artículo de hoy es para ingenieros y científicos en computación, y es uno que prometí desde que implementé el nuevo motor de blog de eliax 2.0 (actualmente en versión beta) en Febrero de este año, y lo que les mostraré es una técnica que les ayudará a acelerar enormemente estructuras de datos jerárquicas, con un truco lineal de mi autoría.Pero primero, un poco de datos históricos de trasfondo para poner todo esto en contexto: Eliax anteriormente estaba alojado en un servidor dedicado (es decir, una sola máquina para el blog) y funcionaba bastante bien, pero habían muchas cosas que el motor de blog que utilizada en ese entonces (Serendipity) no hacía que no me gustaba, por lo que decidí tomarme un fin de semana y dedicárselo a escribir mi propio motor de blog, que es el que utilizan todos actualmente en eliax. Obviamente pude haber utilizado otro motor como Wordpress, pero ¿en dónde está la diversión en eso? Sí, soy un geek, lo admito... :) Sin embargo, quizás la razón principal de yo querer escribir mi propio motor de blog era ver qué tan rápido podía yo acelerar la parte de los comentarios (ya para inicios de este año algunos artículos de eliax contenían cientos de comentarios), y para eso decidí utilizar un truco que me inventé hace más de una década atrás, y que hoy comparto con ustedes. Para que tengan una idea de lo que hablamos, me refiero a una simple técnica de código que les acelerará este tipo de operaciones entre varias veces y miles de veces más rapido (dependiendo de la profundidad del árbol jerárquico y los números de nodos de este). Esta optimización, más otras tantas más, hicieron el nuevo motor de blog tan más rápido que el viejo, que pude dejar atrás el servidor dedicado y poner eliax en un simple servidor compartido (como con otras 50 páginas más). Eso por un lado me ofreció un par de ventajas: 1. Un costo muchísimo menor (bajé de US$220 dólares mensuales a apenas unos US$15 dólares mensuales). 2. Muchísima más fácil administración (la empresa que aloja a eliax se encarga de todos los temas de actualizaciones, seguridad, gestión de servicios web, bases de datos, etc). Sin embargo, obtuve una gran desventaja: Ahora cada vez que uno de esos otros 50 websites hace alguna operación extrema que hace que se caiga el servidor, eliax se cae también con esas páginas, razón por la cual a veces ven a eliax caído por unos segundos o incluso un par de minutos al día. Debido a eso estoy contemplando regresar a un entorno de servidor dedicado, pero antes de hacer eso quería sacar este artículo para que prueben lo rápido del código aun en un ambiente de servidores compartidos. Habiendo dicho todo eso, aquí vamos... ¿Cuál es el problema? El problema a resolver es el siguiente: En foros (y lo mismo aplica a un sinnúmero de otros ambientes), se necesita almacenar datos de forma jerárquica, lo que hace el modelo de datos super-sencillo, pues para un blog el modelo puede ser tan simple como el siguiente esquema SQL (noten que he simplificado la sintaxis por motivos didácticos, y obviando por ejemplo temas de índexes, autoinc, llaves primarias, etc): COMENTARIO_ID INT PADRE_ID INT FECHA_DE_ENTRADA TIMESTAMP AUTOR CHAR COMENTARIO TEXT Con tan solo esa simple estructura es posible modelar una tabla para almacenar comentarios de forma jerárquica en algo como este mismo blog de eliax. Noten que he obviado de este esquema un campo que se llame ENTRADA_DE_BLOG_ID que tendría el ID del artículo bajo el cual se está comentando. Lo he dejado fuera para simplificar el ejemplo, pero recuerden que obviamente se necesita un ID por artículo. Veamos ahora como se almacenarían estos 3 comentarios (Ejemplo 1): - Primer comentario por Jose Elias a las 10:00Estos los almacenaríamos de la siguiente manera (tomando en cuenta nuestro diseño de tablas de hace 3 párrafos atrás): 1, 0, 10:00, Jose Elias, Primer comentarioNoten ahora un par de cosas: 1. Cuando seteamos el valor de PADRE_ID a 0 queremos indicar que este comentario está en la raíz de los comentarios. 2. Cuando seteamos PADRE_ID a un valor igual o mayor a 1, queremos decir que este comentario es en respuesta al ID de ese otro comentario. Esto es bastante eficiente para almacenar, pero tiene un grave problema a la hora de uno leer esos datos de la base de datos y desplegarlos: No podemos obtener la estructura completa en un formato listo para desplegar con una sola operación. Es decir, tenemos que hacer una de estas dos operaciones: 1. Leer solo los nodos de la raiz (es decir, aquellos en donde PADRE_ID = 0), y después hacer más queries de SQL para saber cuáles son los comentarios hijos de esos, y repetir el proceso recursivamente hasta llegar a los últimos comentarios de cada rama del árbol. 2. Leerlo todo en memoria en una sola operación SQL, pero de todas maneras recorrer los datos de manera recursiva para "desenvolver" el árbol y poder desplegarlo. En ambos casos, mientras más comentarios y más profundo sea el árbol de comentarios, más lento es este proceso. Para que tengan una idea, leer tan solo 10 comentarios, en donde cada uno de ellos tenga 8 subcomentarios, y en donde cada uno de esos 8 subcomentarios tenga 5 sub-subcomentarios, requeriría de aproximadamente unas 400 operaciones distintas. Hoy les voy a enseñar como hacerlo con una sola operación, acelerando (en este ejemplo) el tiempo de respuesta a 400 veces más rápidamente... Leer el resto de este artículo... autor: josé elías |

|

|

|

|

|

martes, octubre 26, 2010

|

|

Continuando con un aparentemente-eterno Modo de Baja Productividadtm, hoy los dejo con varias noticias breves:

1. Sony PSP Go y PSP 2 1. Sony PSP Go y PSP 2Ayer reporté por Twitter que el nuevo precio oficial del Sony PSP Go será de US$199 dólares, pero otra noticia jugosa para los fans de esta consola de video-juegos es que algunos desarrolladores de video-juegos ya están poniendo sus manos en prototipos del PSP 2, que supuestamente viene con una pantalla más grande y de alta definición, así como una superficie multi-táctil. Supuestamente lo veremos en tiendas en las navidades del próximo año 2011. fuente 2. VLC en iPhone y iPod Touch El venerable reproductor universal de media VLC recientemente fue hecho disponible en el iPad, y ahora acaba de salir una versión para el iPhone y iPod Touch. Noten que solo funciona en el iPhone 3GS, el iPhone 4, y las últimas dos generaciones del iPod Touch. Disponible en el App Store ahora mismo. 3. SDK y Simulador para BlackBerry PlayBook Si planeas desarrollar aplicaciones para el RIM BlackBerry PlayBook, la empresa acaba de anunciar un entorno de desarrollo y simulador del hardware para que inicies a trabajar lo antes posible. fuente  4. El crecimiento de Netflix 4. El crecimiento de NetflixSegún estudios, Netflix, la empresa que se ha consagrado como la líder en rentar películas por Internet (en particular en los EEUU, y lean mi predicción #41 para este año),ya consume el 20% del tráfico de Internet en los EEUU en los horarios principales de teleaudiencia. fuente Así mismo el CEO de la empresa reveló que Netflix ya es primariamente una empresa de renta de películas por Internet, y no tanto de rentas de DVDs por correo (que fue como se inició). Incluso han anunciado que iniciarán a vender planes de rentas de películas que no incluyen DVDs (alrededor de US$7 a US$9 dólares por todas las películas que puedas descargar). En resumen, pongas las empresas de rentas de películas de la vuelta de la esquina en la lista en extinción junto con el kiosco que vende los libros impresos...  5. The Pirate Bay en órbita 5. The Pirate Bay en órbitaEl grupo The Pirate Bay, que promueve el libre intercambio de información (que lamentablemente se transforma también, en este caso, en piratería de películas, canciones, libros y programas) ha anunciado que debido a que ninguna nación es amigable a alojar sus servidores de bitTorrent, que lo que planean hacer en un futuro es lanzar un satélite en órbita y conectarlo a Internet, ya que no existen regulaciones que eviten que operen desde el espacio exterior... fuente 6. Almacenamiento casero de 70 TeraBytes Cuando necesitas más espacio para tus películas, canciones y fotos, ¿qué haces? Por lo general comprar más discos duros, pero este hacker decidió construir su propio sistema de almacenamiento de 70TB, lo que le permite almacenar unas 24 millones de canciones mp3 o 70,000 videos descargados por Internet. Lo construyó con 60 discos, 40 ventiladores y un poco de madera... fuente  7. Nokia en picada, despidos 7. Nokia en picada, despidosNo solo se rumorea que la Fundación Symbian (la misma que provee de sistemas operativos a Nokia) cerrará próximamente sus puertas, sino que además Nokia anunció (en medio de unos buenos resultados en Q3 2010) que despedirá 1,800 empleados para "eficientizar" sus operaciones. fuente  8. Windows 8 en el 2012 8. Windows 8 en el 2012Según la división de los Países Bajos de Microsoft (y como reporté por Twitter hace un par de días, así como reporté en eliax el año pasado), podemos esperar la próxima versión de Windows, llamada sin sorpresas "Windows 8" en Octubre del 2012, es decir, dentro de exactamente 2 años. No se ofrecen detalles de la nueva versión, pero si observamos las tendencias del mercado creo que podemos asumir que tendrá un fuerte componente de integración con la Nube de Internet. fuente 9. MakerLegoBot, de LEGOs e imprime LEGOs Este si que es un hack curioso: Un hacker ha publicado instrucciones que te muestran como construir, con bloques de LEGO, una impresora que imprime objetos en 3D utilizando bloques de LEGO. El proyecto utiliza los Lego Mindstorms NXT. fuente Video de la impresora de LEGOs a continuación, en cámara rápida (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, octubre 3, 2010

|

Una de las técnicas más promisorias en el campo de la Computación Cuántica es la de poder utilizar la propiedad de spin (giro) de los electrones para almacenar información, en donde en un solo electrón no solo se puede almacenar un bit, sino que incluso un qbit (el equivalente cuántico al bit tradicional), y hoy hemos dado otro gran paso en esa dirección. Una de las técnicas más promisorias en el campo de la Computación Cuántica es la de poder utilizar la propiedad de spin (giro) de los electrones para almacenar información, en donde en un solo electrón no solo se puede almacenar un bit, sino que incluso un qbit (el equivalente cuántico al bit tradicional), y hoy hemos dado otro gran paso en esa dirección.A la fecha ha sido posible teorizar sobre utilizar esta técnica (2006), lograrlo en la práctica a temperatura ambiental (2009), y ahora en el 2010 han logrado perfeccionar la técnica de lectura (hasta el momento las lecturas de bits/qbits habían sido imperfectas). En otras palabras, en el momento que podamos perfeccionar la técnica de escritura, y combinarla con esta de lectura, podremos iniciar el proceso de perfeccionar el proceso de fabricación para masificar esta tecnología. Lo más interesante de esta vez sin embargo es el hecho que no solo ya pueden leer eficazmente los datos almacenados en el spin/giro de electrones, sino que lo han logrado en base a componentes fabricados con silicio, lo que significa que esto es compatible con los sistemas tradicionales de fabricación de procesadores y memorias. En otras palabras, estamos relativamente cerca de un futuro en donde en un dispositivo del tamaño de un celular podremos almacenar miles de veces más información de lo posible hoy día. O en otras palabras, un componente más del IrixPhone está en vía a desarrollarse... :) Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, septiembre 24, 2010

|

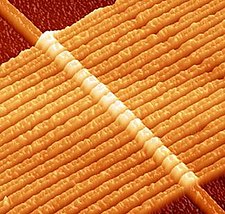

En los laboratorios Almaden Research Center de IBM acaban de revelar que han logrado un gran hito en el futuro de almacenamiento de datos a nivel atómico, al lograr demostrar un prototipo de una memoria DRAM utilizando tan solo un solo átomo (la memoria DRAM es el tipo generalmente utilizado en PCs y Laptops/Netbooks de la actualidad). En los laboratorios Almaden Research Center de IBM acaban de revelar que han logrado un gran hito en el futuro de almacenamiento de datos a nivel atómico, al lograr demostrar un prototipo de una memoria DRAM utilizando tan solo un solo átomo (la memoria DRAM es el tipo generalmente utilizado en PCs y Laptops/Netbooks de la actualidad).Es decir, IBM demostró que puede escribir y borrar un bit de información representado por un solo átomo, en este caso, un átomo de hierro. Esto es un tremendo adelanto con un potencial increíble, ya que trae un poco más cerca un futuro en donde podremos almacenar el equivalente a millones de discos duros en un dispositivo sumamente portátil. Esto permitiría por ejemplo que algo como el IrixPhone se convierta en realidad, en donde uno de los soportes de las gafas a ambos lados de la cara pueda servir de almacenamiento, con suficiente espacio incluso para grabar un video las 24 horas de todo lo que nos ocurre en varios años de nuestras vidas. Esta tecnología también promete eliminar el límite para "dibujar" los circuitos en los chips de hoy día, que ya están llegando a su límite con procesos litográficos. Es decir, que esto es un paso más también en la creación de procesadores ultra densos, tan densos que el equivalente a la super-computadora más potente del mundo hoy día cabría en un celular en nuestras manos. Y como si fuera poco, esto de paso es también es un avance que beneficiará la fabricación de las primeras computadoras cuánticas en los próximos años. Nota: En la imagen que acompaña el artículo, ven una imagen tomada con un microscopio especial (del tipo "escaneo por efecto túnel") en donde el "pico" mas alto que ven con la punta amarilla es el átomo siendo utilizado para almacenar el bit, en donde un bit puede ser interpretado como un cero (0) o un uno (1). Fuente de la noticia autor: josé elías |

|

|

|

|

|

viernes, septiembre 3, 2010

|

En el futuro próximo ciertamente no nos faltarán opciones a la hora de tener tecnologías de almacenamiento que darán un gran salto sobre cualquier cosa que tenemos hoy día, incluso haciéndonos reír de lo que hoy día es 1GB o incluso 1TB... En el futuro próximo ciertamente no nos faltarán opciones a la hora de tener tecnologías de almacenamiento que darán un gran salto sobre cualquier cosa que tenemos hoy día, incluso haciéndonos reír de lo que hoy día es 1GB o incluso 1TB...Esta noticia viene apenas días de HP haber anunciado que en poco tiempo comercializará los Memristors, en un momento en donde existe una fuera investigación en almacenamiento a nivel atómico, computación molecular, o incluso en expandir tecnologías tradicionales de discos duros mas allá de los 10TB. Esta vez sin embargo hablamos de algo que tendrá un gran impacto al corto plazo... Se trata de un adelanto creado en Rice University en donde científicos han podido utilizar Silicio por primera vez para crear memorias no-volátiles, sencillas, super-densas y extremadamente baratas. Por no-volátiles se quiere decir que el contenido no se borra en ausencia de electricidad, por lo que esto funcionaría no solo como memoria RAM, sino que además como memoria tipo Flash. Es sencilla porque a diferencia de otros tipos de memorias que requieren de tres terminales (es decir, de 3 "alambres" saliendo de cada célula de memoria) esta requiere solo dos, lo que nos lleva también al próximo punto. Es super-densa (es decir, que mas memoria se puede fabricar en el mismo espacio que ocupan otros tipos de memoria) no solo por su sencillez, pero sino además porque debido a que cada célula tiene solo dos terminales, se hace ahora mucho mas fácil crear memorias 3D (tridimensionales), en donde varias capas de memorias se ponen estilo sandwich una encima de la otra en el mismo chip. Y es muy barato ya que la materia prima para esta técnica es el Silicio, que es otra forma de decir simplemente "arena", en vez de materiales exóticos. El truco se ha podido gracias a la nanotecnología, en donde se ha podido fabricar unos circuitos super miniaturizados que pueden crear unos nano-cristales que cambian entre un estado y otro en el momento de aplicarles un voltaje. Y he aquí otra gran ventaja de este tipo de memorias: Solo se le tiene que aplicar un voltaje cuando es necesario cambiar un bit (de 0 a 1, o de 1 a 0), a diferencia de otras memorias dinámicas que requieren o de constante "refresco" energético, o de un refrescado cada tantos milisegundos. En otras palabras, este tipo de memoria de paso consume muchísimo menos energía que muchos otros tipos de memorias en el mercado. Según los investigadores que crearon esta maravilla moderna, con esta tecnología es posible hacer chips de memoria 5 veces mas densos que los chips de memorias mas densos con los cuales se están empezando a experimentar en el campo de memorias (cuyo límite actual llegan a los 20 nanómetros), y de paso es posible poner hasta 3 niveles de memorias en 3D en un solo chip (es decir, que hablamos de una densidad 15 veces mayor a lo mejor con lo que se está experimentando hoy día), y además agregan que la sencillez de la técnica permitirá hacer circuitos aun mas densos en el futuro. De paso agregan que ya están experimentando con un prototipo de memoria de 1,000 elementos, lo que nos indica que esta tecnología está ya en una fase bastante avanzada y que posiblemente la veremos en el mercado en dos o tres años. En otras palabras, en esta misma década que no les sorprenda cuando sus celulares inteligentes vengan con 1TB de memoria, cosa que era factible solo en las mas potentes super-computadoras de hace pocos años atrás... Nota de Prensa oficial de Rice University Fuente de la noticia Actualización: Según este enlace proveído por el lector Shagai en los comentarios, esta tecnología de Rice University es también una implementación de Memristors, y competirán contra la implementación de HP. ¡Gracias Shagai por el enlace! autor: josé elías |

|

|

|

|

|

jueves, septiembre 2, 2010

|

Por años les he hablado en eliax de los Memristors (¿"Memristores" en español?), un nuevo tipo de componente básico que promete revolucionar varias facetas de la computación, desde el almacenamiento hasta la Inteligencia Artificial y Cerebros Sintéticos. Por años les he hablado en eliax de los Memristors (¿"Memristores" en español?), un nuevo tipo de componente básico que promete revolucionar varias facetas de la computación, desde el almacenamiento hasta la Inteligencia Artificial y Cerebros Sintéticos.Pues hoy tengo el placer de decirles que el momento ha llegado, y que la empresa HP (que desarrolló la tecnología) se ha embarcado en una colaboración con la empresa Hynix (un líder mundial en fabricación de memorias) para iniciar la fabricación de componentes electrónicos basados en Memristors. Memristors prometen la creación de un nuevo tipo de "memoria universal" que reemplazaría los discos duros (tanto los clásicos como los del tipo SSD), las memorias básicas de las PCs (RAM, DRAM, etc), así como memorias removibles Flash del tipo USB. En otras palabras, estos Memristors simplificarían enormemente la arquitectura interna de dispositivos electrónicos de hoy día, ya que se podría utilizar un solo bloque de memoria para todo uso, lo que de paso abarataría los componentes a largo plazo. A la primera versión de este tipo de memoria la llamarán ReRAM (Resistive Random Access Memory). Otra ventaja del ReRAM es que es no-volátil, lo que significa que no pierde su información si no se le suministra electricidad, lo que significa que dispositivos como PCs, celulares inteligentes y demás, podrán ser apagados completamente, y cuando se enciendan una vez más estos resumirán trabajando como si nada hubiera sucedido. Además, como escribí en el 2008: "Otra propiedad sorprendente de estos memristors (y lo que me llama mas la atención) es que estos dispositivos no solo recuerdan corrientes en un estado binario (el equivalente al 0 o 1), sino que en un estado analógico, lo que en mi opinión significaría que este tipo de memorias sería ideal para dispositivos que manejen datos con lógica difusa, y por tanto para la creación de inteligencias artificiales." En otras palabras, acabamos de dar otro paso mas hacia La Singuralidad... Fuente de la noticia autor: josé elías |

|

|

|

|

|

miércoles, septiembre 1, 2010

|

|

Hoy les presento una pieza más del "Plan Maestro" de Google para hacerse una parte intrínseca de nuestras vidas, y algo a los que arquitectos de software y Gerentes de Tecnologías deberían prestar mucha atención...

Se trata de dos proyectos de Google vagamente relacionados entre sí llamados BigQuery y el Prediction API, que Google reveló hace pocos días en su Google IO 2010, y que en mi opinión no obtuvieron la cobertura de los medios que se merecían, quizás porque a simple vista el nombre de estas tecnologías sugieren cosas intimidantemente complejas. Sin embargo, hagamos un esfuerzo en entenderlas, pues como veremos, detrás de ellas existe extrema simpleza. BigQuery es algo que me recuerda a un proyecto experimental de Google llamado Fusion Tables del cual les hablé hace un año atrás acá mismo en eliax, pero que como verán, lleva el grado de simpleza al extremo. Como podrán notar por el nombre "BigQuery" (en español sería algo como "Gran Consulta"), esta tecnología apunta a ser utilizado en cosas "grandes", y por grandes hablamos de verdaderamente grandes. BigQuery es básicamente una base de datos en donde los datos los provees como tablas, pero en donde no tienes que especificar ni una sola regla de relación entre las tablas, o incluso si quieres indexar campos en esas tablas (es mas, ni siquiera tienes la opción de hacer estas cosas). En otras palabras, Google infiere las relacione según las consultas que hagas, y no necesita indexación explícita de los datos, ya que estos son almacenados de una manera inherentemente indexada globalmente (es decir, es como si tu le pusiera un índice a todos y cada uno de los campos de tu base de datos, pero sin incurrir en problemas de eficiencia por hacerlo). Uno se preguntaría, ¿pero cuál es el objetivo de esto? Y al ver el video que adjunto al final de este artículo comprenderán mejor: BigQuery fue diseñado para almacenar literalmente millones de millones de objetos, y (esta es la parte asombrosa) poder hacer consultas en tiempo casi real (entre 5 y 10 segundos para obtener una respuesta, aproximadamente). Como verán en el video, una base de datos de 60 Mil Millones de registros se maneja como una sencilla base de datos local, y lo mejor de todo, con simple SQL. El hecho que Google haya decidido adoptar a SQL como el lenguaje de consulta es importantísimo, porque hace esta herramienta instantáneamente útil para cientos de miles de programadores que ya saben manejar SQL en todo el mundo. Google además incluyó muchas funciones básicas de SQL (como por ejemplo, para manipular fechas y tiempos), así como otras bastante poderosas (como funciones de probabilidades y estadísticas), lo que hace de este sistema algo verdaderamente poderoso. Noten que por el momento la idea es que uno cargue todos los datos en crudo, y después utilizar los APIs para hacer queries en modo de lectura. Un ejemplo que verán en el video es como Google cargó toda la base de datos completa (es decir, incluyendo cambios históricos de artículos) de Wikipedia, y como es posible hacer queries en casi tiempo real (como por ejemplo, los artículos que mas cambios han recibido). En el otro extremo tenemos a los Prediction APIs. Estos son unos APIs que dan acceso a patrones de reconocimiento artificiales para detectar patrones en datos masivos (o no tan masivos) y uno poder hacer predicciones (de ahí su nombre). Un ejemplo que Google ofrece es utilizar el servicio para uno automáticamente predecir si un pedazo de texto está escrito en un lenguaje u otro. Para llevar esto a cabo, el proceso no podría ser mas sencillo: 1. Uno crea un archivo de texto plano para "entrenar" al sistema, en donde en cada linea uno escribe lo que sería el resultado esperado (output), y después de una coma uno escribe la entrada cruda (input). Algo como estas lineas: "Inglés","To err is human, to forgive divine"2. Uno llena el archivo con decenas, centenares, millares o millones de ejemplos que en este caso le dirán al Prediction API lo que es texto en inglés, y lo que es texto en español. Noten que el Prediction API no está limitado a simple texto, sino que también se pueden especificar valores numéricos y muchos otros patrones mas. 3. Uno sube ese archivo a Google, el cual es analizado y literalmente aprendido por el software de Inteligencia Artificial de Google, para aprender lo que es inglés y lo que es español. A los usuarios mas expertos les gustará saber que el Prediction API en realidad consiste de varios algoritmos tras bastidores, y que todos ellos son aplicados a los datos que subes, y el que se ajuste mejor a darte las respuestas correctas es el que se termina utilizando con tus datos, todo automáticamente. 4. Después de eso, el sistema está listo para hacer predicciones. Así que por ejemplo, si tu empresa recibe miles de emails de todas partes del mundo, y deseas automáticamente catalogar los emails por idioma (para por ejemplo, enviar una respuesta automatizada en el idioma de quien escribió el email), lo que puedes hacer es enviar el texto de cada email a tu Prediction API ya entrenado para que este prediga si el texto analizado es en inglés o español (o un sinnúmero de idiomas mas si así lo deseas). Pero noten que este es un ejemplo sencillo. Google propone una lista inmensa de posibles usos, que van desde poder predecir la mejor ruta para enviar un paquete, hasta predecir cuáles productos de tu empresa un determinado cliente estaría dispuesto a comprar cuando se combine con otro, y desde detectar SPAM (emails no deseados) hasta predecir cuáles empleados de tu empresa están en riesgo de renunciar. Y a propósito, ese último ejemplo Google nunca lo mencionó en el video que verán, pero es obvio que Google ya tiene un buen tiempo desarrollando y probando estas tecnologías, pues desde al menos el 2006 el Gerente General de la empresa ha dejado claro que la Inteligencia Artificial es el próximo gran reto de Google. Por el momento estas tecnologías son de acceso limitado (debes aplicar para que Google apruebe tu solicitud de trabajar con estas, gratuitamente), pues en estos momentos Google aun las está afinando para el consumo masivo del público y desea retroalimentación de los primeros adoptantes. Otros puntos a favor de estos emprendimientos de Google es que ha decidido proveer estos servicios como simples Servicios Web consumidos por HTTPS con un simple interfaz estilo REST, lo que hace la integración de estos servicios algo sumamente sencillo. Google además te permite gestionar a quien le quieres dar acceso a tus datos, utilizando técnicas de ACLs (Access Control Lists), y además te permite instalar aplicaciones que tomen ventajas de estos servicios directamente en el Google App Engine. Otra cosa interesante es que Google tiene muchos planes para expandir estas herramientas al usuario común. Por ejemplo, en el video que verán (y que dura cerca de una hora, pero que creo es un video obligatorio para todo técnico en computación) verán como pueden integrar los datos de BigQuery con la hoja de cálculos de Google Docs, permitiendo que un usuario que no sepa absolutamente nada de como funciona esto, pueda interactuar con modelos creados por usuarios mas técnicos. Entonces en resumen, BigQuery es una herramienta para el análisis masivo de datos pasados o presentes, mientras que el Prediction API es una herramienta para predecir tendencias y acciones futuras. Si seguimos por este camino, es posible que lleguemos a este escenario mucho antes de lo que muchos esperaban o siquiera creían iba a ser posible... Página oficial del proyecto BigQuery Página oficial del Prediction API Google Storage for Developers (en donde almacenas tus datos masivos en Google para ser analizados por BigQuery y el Prediction API) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, agosto 18, 2010

|

Hoy día los discos duros tradicionales de mayor capacidad en el mercado almacenan hasta 2TB de datos (aunque noten esto) típicamente, sin embargo, Toshiba estará anunciando hoy una nueva tecnología que almacenará 5 veces mas información en el mismo espacio. Hoy día los discos duros tradicionales de mayor capacidad en el mercado almacenan hasta 2TB de datos (aunque noten esto) típicamente, sin embargo, Toshiba estará anunciando hoy una nueva tecnología que almacenará 5 veces mas información en el mismo espacio.La tecnología, llamada Bit-Pattern Recording (BPR, o Grabación de Patrones de Bits), permitiría en principio la fabricación de discos duros de 10TB en el 2013, año cuando Toshiba planea lanzar los primeros productos con este adelanto. BPR funciona básicamente creando pequeños grupos ordenados de bits en lo que antes era un solo bit, y la dificultad de esta técnica estaba en que hasta el momento era bastante difícil ordenar estos grupos de bits en un patrón predicible y necesario para poder escribir y leer datos, reto que Toshiba dice creer haber vencido. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, junio 29, 2010

|

Seagate acaba de llegar a otro hito en la carrera incesante para proveernos cada vez mas con mas capacidad para nuestros datos, sacando el primer disco duro de 3.5" al mercado con la asombrosa capacidad (para estos días) de 3 TeraBytes (3TB). Seagate acaba de llegar a otro hito en la carrera incesante para proveernos cada vez mas con mas capacidad para nuestros datos, sacando el primer disco duro de 3.5" al mercado con la asombrosa capacidad (para estos días) de 3 TeraBytes (3TB).Extrañamente solo ofrece este disco en formato externo con conector USB 2.0/3.0 o FireWire 800, aunque ya me imagino algunos geeks comprando uno de estos, y sacando el disco del empaque para conectarlo directamente a la parte interna de sus PCs... :) Tan asombroso como el tamaño es el precio, pues se espera vender por aproximadamente US$250 dólares. Fuente oficial de la noticia autor: josé elías |

|

|

|

|

|

martes, junio 22, 2010

|

Hoy dìa si tienes una cámara digital y te gustaría enviar las fotos desde la misma cámara de manera inalámbrica a tu PC o incluso a un servidor o servicio remoto, tienes tres posibilidades: (1) Tener una cámara con este tipo de tecnología integrada, (2) construir tu propio sistema y adaptarlo (como en este hack), o (3) comprar una tarjeta Eye-Fi. Hoy dìa si tienes una cámara digital y te gustaría enviar las fotos desde la misma cámara de manera inalámbrica a tu PC o incluso a un servidor o servicio remoto, tienes tres posibilidades: (1) Tener una cámara con este tipo de tecnología integrada, (2) construir tu propio sistema y adaptarlo (como en este hack), o (3) comprar una tarjeta Eye-Fi.Las tarjetas Eye-Fi no son mas que una tarjeta de memoria SD (o variantes como la SDHC) que vienen con un minúsculo transmisor de WiFi integrador (por lo general de la variedad "B" o "G"), que permite que acorde se toman fotos por la cámara, que esta tarjeta las tome y las envíe a un lugar pre-determinado previamente cuando la programas. También existen cámaras directamente compatibles con Eye-Fi que permiten que la programes directamente desde la cámara. Sin embargo, el problema es que a la fecha Eye-Fi es una tecnología propietaria y no estandarizada, coda que Toshiba ahora quiere cambiar. Toshiba ahora está proponiendo a toda la industria estandarizar este tipo de tarjetas, y hacerlo un estándar abierto. Sin embargo, Toshiba está yendo mas allá de solo proponerlo, y planea fabricar su primera tarjeta con el nuevo estándar, una tarjeta en el formato SDHC de 8GB y con WiFi 802.11b/g. Una ventaja del nuevo estándar es que si es adoptado, reduciría considerablemente el uso energético de estas tarjetas, ya que uno podría ser muy selectivo con lo que envía (por ejemplo: "Solo enviar imágenes en formato JPG y reducidas en resolución"), así como el nuevo formato propone poder enviar imágenes entre una cámara y otra ("Mira que foto mas bella esta de tu bebé, la voy a transferir a tu cámara ahora mismo"). Finalmente, y como dicen en su Nota de Prensa oficial, por el momento este nuevo estándar no tiene nombre, y se refieren provisionalmente a este como "Standard Promotion Forum for Memory Cards Embedding Wireless LAN" ("El Foro de Promoción de Estandarización para Tarjetas de Memoria Incrustadas en Redes Inalámbricas"). Yo por mi parte, creo que aunque esto es genial, preferiría simplemente que los fabricantes de cámara hicieran un estándar para las cámaras mismas (así como otros dispositivos aparte de cámaras), de modo que no dependamos de las tarjetas (que las haría mas caras), sino que la tecnología de WiFi sea la del transmisor en la cámara misma. Eso ahorraría dinero en las tarjetas, y haría del estándar algo mas abierto y aplicable a mas dispositivos (como celulares inteligentes que no utilizan memoria SD, laptops, televisores, proyectores de video, etc). Fuente de la noticia autor: josé elías |

|

|

|

|

|

jueves, junio 17, 2010

|

Hoy día la manera de agregar mucha memoria a dispositivos móviles como celulares inteligentes o incluso tablets (como el iPad) es juntando varios chips de poca capacidad para entre todos obtener una alta capacidad. El problema es que este método ocupa mucho espacio precioso dentro de dispositivos compactos, aumenta la complejidad del sistema, y es costoso. Toshiba ahora ofrece una solución. Hoy día la manera de agregar mucha memoria a dispositivos móviles como celulares inteligentes o incluso tablets (como el iPad) es juntando varios chips de poca capacidad para entre todos obtener una alta capacidad. El problema es que este método ocupa mucho espacio precioso dentro de dispositivos compactos, aumenta la complejidad del sistema, y es costoso. Toshiba ahora ofrece una solución.Toshiba acaba de desarrollar un chip con memoria Flash tipo NAND que dentro de este contiene 16 bloques de 8GB cada uno, para un total de 128GB de memoria en un solo chip. Aparte de eso, el chip fue fabricado con tecnología de 32nm, lo que significa que es mas barato construir estos chips ya que ocupan menos espacio, lo que al final se traduce en que pronto tendremos celulares con 128GB de almacenamiento en nuestras manos, y para aquellos fabricantes que quieran empujas las fronteras, podrán hacer igual que antes y combinar 2 o 4 de estos chips para ofrecer dispositivos con 256GB o incluso 512GB (medio TeraByte) de información. Y para que tengan una idea, con 128GB sería posible almacenar el equivalente a 180 discos compactos de datos en tu celular. ¡Gracias al lector identificado como DannyR por el enlace! Fuente de la noticia autor: josé elías |

|

|

|

|

|

lunes, mayo 24, 2010

|

Científicos japoneses acaban de crear una novedosa técnica que podría crear DVDs con capacidad mas de 1,000 veces superior a los discos Blu-ray de hoy día. Científicos japoneses acaban de crear una novedosa técnica que podría crear DVDs con capacidad mas de 1,000 veces superior a los discos Blu-ray de hoy día.Noten que un disco Blu-ray almacena un máximo de 50GB, por lo que hablamos de almacenar alrededor de 50TB de información en un solo disco. El truco está en utilizar óxido de titanio, en vez de la combinación germanium-antimony-tellurium actualmente utilizada en DVDs y Blu-ray. Como si fuera poco, este material es muy común y cuesta 100 veces menos que los materiales actuales para fabricar discos DVD y Blu-ray, lo que significa que hablamos en realidad de 100,000 veces mas densidad de datos por dólar. Una observación que tengo es que dudo que esta tecnología se utilice para reemplazar DVD/Blu-ray, ya que el próximo formato de distribución de videos no será físico sino que virtual, recibiendo nosotros nuestros videos por Internet. Sin embargo, como un formato de hacer respaldos locales de archivos, o en ambientes empresariales, es posible que tenga un buen futuro (y ya me imagino los piratas vendiendo colecciones de miles de películas en uno solo de estos discos). Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, mayo 11, 2010

|

Pocos dudan que eventualmente, y conforme se reduzcan los precios, que los discos duros tradicionales con partes mecánicas será cosa del pasado, y que reinarán los SSDs (Discos Duros en Estado Sólido) basados en memoria Flash o similares. Sin embargo, los discos duros tradicionales parece que no se irán sin antes dar una buena batalla... Pocos dudan que eventualmente, y conforme se reduzcan los precios, que los discos duros tradicionales con partes mecánicas será cosa del pasado, y que reinarán los SSDs (Discos Duros en Estado Sólido) basados en memoria Flash o similares. Sin embargo, los discos duros tradicionales parece que no se irán sin antes dar una buena batalla...Científicos acaban de reportar en la publicación científica Nature Photonics que han experimentado exitosamente con una técnica que hará que los discos duros tradicionales se puedan fabricar para que estos almacenen entre 5 y 50 veces mas información en el mismo espacio que ocupan hoy día. El logro se utilizó combinando dos técnicas que antes por separado conducían a un callejón sin salida en experimentos que trataban de incrementar la densidad de datos, pero que cuando se combinaron, cada técnica resolvió el problema de la otra. Pero lo mejor de todo es que esta técnica se ha comprobado que funciona, incluso escribiendo datos a velocidades de hasta 250Mbps (unos 31 MegaBytes por segundo), por lo que a diferencia de otras tecnologías, esta parece que veremos en la práctica en muy corto tiempo. Esto significa que dentro de poco podremos comprar laptops con entre 2 y 5 TeraBytes de información, y en un futuro incluso con hasta 50 TeraBytes. Fuente de la noticia autor: josé elías |

|

|

|

|

|

martes, mayo 4, 2010

|

|

Científicos de la North Carolina State University en los EEUU acaban de crear una técnica de almacenamiento con nanotecnología que por fin promete traernos el inicio del fin de los discos duros tradicionales.

La tecnología se basa en nanodots ("nano-puntos"), unos minúsculos puntitos a escala nanométrica (cada uno mide apenas 6nm, o 6 mil-millonésimas de un metro) construídos con silicio pero que almacenan información de forma magnética. Según los científicos que están desarrollando esta tecnología, estos nanodots están compuestos de unos cristales libres de imperfecciones que crean unos sensores magnéticos directamente sobre el silicio, y están espaciados uniformemente con una precisión altamente exacta, lo que permite que estos puedan ser escritos y leídos de una manera predecible. Para que tengan una ides de lo que hablamos en cuanto a tamaño y capacidad, hablamos de que será posible fabricar un chip que mide apenas 4cm cuadrados, en el cual se podrá almacenar 4 Terabits, o 512 GB, lo que es el equivalente a almacenar en el espacio del tamaño de una uña de tus dedos el equivalente a unos 750 Discos Compactos de datos. Esto también significa que en pocos años tendremos dispositivos similares a un iPhone o iPad que almacenarán varios TeraBytes de información de forma barata. Fuente de la noticia autor: josé elías |

|

|

|

|

|

lunes, abril 26, 2010

|

Los discos floppy de 3.5", que una vez reinaron el mundo del almacenamiento en nuestras PCs y laptops, van a dar su último respiro próximamente, ya que Sony acaba de anunciar que en Marzo del próximo año 2011, venderá el último de ellos en Japón. Los discos floppy de 3.5", que una vez reinaron el mundo del almacenamiento en nuestras PCs y laptops, van a dar su último respiro próximamente, ya que Sony acaba de anunciar que en Marzo del próximo año 2011, venderá el último de ellos en Japón.El disco floppy fue introducido en 1981, y adoptado rápidamente por la industria, en particular por la primera generación de computadoras Mac de Apple, Commodore Amiga, Atari ST, y mas tarde las IBM PS/2. En cuanto a su capacidad, variaban entre alrededor de 800KB y 1.4MB por disco (con casos especiales de 2.8MB por disco). O en otras palabras, se necesitarían al menos 3 discos de 1.4MB para almacenar una sencilla canción de mp3 de hoy día. Sin duda alguna, el fin de una Era... Fuente de la noticia autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2025 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax