Tecnología Visual

|

martes, septiembre 20, 2011

|

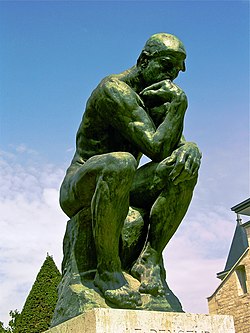

Hace un par de años les hablé de un programa llamado Google Goggles ("Gafas Google") que te permite tomar una fotografía con tu celular de cualquier objeto, y en ese momento la foto es enviada a Google quien la analiza y te deja saber si reconoce lo que ve y qué es. Hace un par de años les hablé de un programa llamado Google Goggles ("Gafas Google") que te permite tomar una fotografía con tu celular de cualquier objeto, y en ese momento la foto es enviada a Google quien la analiza y te deja saber si reconoce lo que ve y qué es.Así que por ejemplo, si estás en un supermercado y le tomas una foto a un producto, Goggles te puede devolver resultados sobre este. O si estás de viaje en otro país y te interesa saber más sobre un edificio o una escultura, Goggles te puede identificar lo que ves e incluso darte información de Wikipedia y otras fuentes. Goggles ha sido una herramienta tremendamente útil para muchos (y está disponible también en iPhone como parte de la aplicación "Google Mobile"), pero ahora Google acaba de agregar algo a su versión para Android que verdaderamente se pueda calificar como genial... La nueva versión 1.6 permite ahora olvidarte de Goggles por completo, y simplemente tomar fotografías normalmente como siempre lo has hecho, sin tu explícitamente decirle a Goggles que quieres que analices esta o aquella foto. Sucede que ahora (siempre y cuando le des permiso al programa) Goggles envía todas las imágenes que tomas con tu cámara a Google, en donde las imágenes son analizadas "en el fondo", es decir "tras bastidores" sin tú saber que está trabajando. Y en el momento que Goggles detecte algo que reconoce en alguna foto que tomes, este entonces te alerta automáticamente en tu celular. Esto lo encuentro genial ya que es bastante posible que recibas información sobre cosas que ni tenías idea que fotografiaste, o siquiera que eran importantes. Cuando vienes a ver estabas parado justo a un monumento importantísimo, o la lado de alguna pintura famosa, o debajo de algún lugar en donde se filmó alguna escena icónica del cine. Una cosa que me intriga es ¿qué sucedería si Google activara esto con reconocimiento de caras? Algo me dice que grupos de derechos sobre la privacidad no estarían muy felices con esto, pero algo me dice que si no lo hace Google, alguien más lo hará (similar a como Facebook ha planteado hacerlo ya). Solo imaginen las posibilidades cuando en un futuro no lejanos tengamos algo similar a un lente de contacto biónico, o una prótesis que grabe todo lo que veamos, o incluso un ojo artificial. Bajo cualquiera de esos tres escenarios podríamos tener información constantemente actualizada sobre todo lo que veamos, generándose en tiempo real una cantidad inimaginable de información sobre todo lo que experimentamos en la vida cotidiana. Incluso, podríamos elegir el nivel de información que veríamos y que sentiríamos "flotar" frente a nuestros ojos, desde información de transportación (nos marque por ejemplo por donde caminar para llegar a un determinado lugar), hasta burbujas flotando encima de las cabezas de las personas con las que interactuamos desplegando información sobre quienes son, a qué se dedican, e incluso sus gustos (información recogida de sus perfiles públicos en portales sociales). El futuro que tanto vemos en la ciencia ficción se nos acerca, y mucho más rápidamente de lo que muchos se imaginan... fuente oficial autor: josé elías |

|

|

|

|

|

lunes, septiembre 19, 2011

|

|

He aquí un avance de una curiosa aplicación que se llamará "Augmented Reality Cinema" (pagina oficial), creada específicamente para los fanáticos del cine que quiera revivir muchas escenas de sus películas favoritas.

La idea de la aplicación es bastante sencilla: La aplicación detecta en donde estás en el mundo y después (asumo) que te dirige hacia algún punto geográfico conocido en donde se filmó alguna escena en particular. Después, cuando llegas al lugar, apuntas tu iPhone, iPod Touch o iPad al lugar, y esta te reproduce el video en el mismo lugar en donde ocurrió la escena, pero en la pantalla de tu dispositivo móvil. Es algo que es muchísimo más fácil entender con solo ver el video que les adjunto a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, septiembre 18, 2011

|

Hola amig@s lectores, Hola amig@s lectores,¿Qué hacer cuando uno está en un aeropuerto, cansado y aburrido, a altas horas de la noche, y con solo un iPad entre las manos? Pues en mi caso, empezar a escribir mi próximo libro... :) ¡En serio!, después de varios meses pensando en la idea, decidí iniciar por fin lo que sería no tanto una continuación de Máquinas en el Paraíso, sino más bien un re-enfoque en un solo tema: La Singularidad Tecnológica. Aun no tengo ni la menor idea de cómo se llamará el libro (por el momento llamémoslo "Máquinas en el Paraíso 2.0"), pero lo que sí les puedo adelantar es que el enfoque que pienso darle irá un poco más allá de los pocos libros actuales del tema. Desde ahora les doy las gracias a todos ustedes, pues en muchos casos fueron inspiración para varios de los miles de artículos que he escrito acá en el blog, y en efecto, el libro en muchos sentidos será una extensión organizada de muchos de los artículos en eliax relacionados con La Singularidad. ¿Cuándo lo finalizaré? Pues el objetivo es "en algún momento en el 2012", preferiblemente en la primera mitad del año, pero ya veremos. Siento que si tuviera tiempo libre lo podría escribir en un par de meses, pero tiempo es lo que menos tengo dada todas mis otras responsabilidades. Sin embargo, ya he iniciado un proceso en donde planeo liberar un poco de mi tiempo en los próximos meses para dedicarle más tiempo al escribir (¡lo que significa un poco de menos tiempo al blog!) Por el momento, ya el Prólogo está escrito, ahora a estructurar el esqueleto del libro antes de sentarme a escribir el Capítulo 1... :) Así que atentos al blog, pues trataré de mantenerlos al tanto de mi progreso (al inicio será todo muy2 lento), y si alguien conoce contactos dentro de una editora de reputación internacional que le pueda interesar publicar la versión impresa del libro (yo posiblemente me reserve la distribución digital), favor de contactarse conmigo por las vías tradicionales. autor: josé elías |

|

|

|

|

|

sábado, septiembre 17, 2011

|

|

He aquí una de esas cosas curiosas que simplemente hay quer ver para entender, pero les adelanto que se trata de una "pantalla" hecho de chorros de agua que caen de una fila de tubos del techo, los cuales son abiertos y cerrados de manera tal que las gotas de agua puedan ser controladas y por tanto utilizarlas como "pixeles de agua viva" mientras caen al suelo.

Sencillamente genial, y noten que esto en realidad no es nuevo, pues ya les había mostrado algo bastante similar en el 2007... ¡Gracias al lector Irving Luna por el enlace! Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, septiembre 5, 2011

|

Esto sí que me dejó boquiabierto (en particular ya que soy un fan de este super influenciador director de cine): Alguien tomó varias de las escenas más memorables e icónicas del director Stanley Kubrick, y las convirtió en imágenes GIF animadas de 2 a 4 segundos de duración, y los resultados como verán son verdaderamente impresionantes... Esto sí que me dejó boquiabierto (en particular ya que soy un fan de este super influenciador director de cine): Alguien tomó varias de las escenas más memorables e icónicas del director Stanley Kubrick, y las convirtió en imágenes GIF animadas de 2 a 4 segundos de duración, y los resultados como verán son verdaderamente impresionantes...Y a propósito, si no han visto películas de este director, y si se consideran verdaderos amantes del cine, háganse un favor y renten sus películas, muchas son obras de arte que posteriormente influenciaron a miles de cineastas en todo el mundo, aunque ojo, recomiendo saber el trasfondo de sus películas antes de verla para apreciarlas mejor. Por ejemplo, 2001 Odisea del Espacio fue un avance casi sin precedentes en el cine, mostrando la visión de Arthur C. Clarke de una forma que pocos se habían imaginado en ese entonces, mostrándonos trajes espaciales, estaciones espaciales, y caminatas en la Luna años antes de siquiera la primera persona haberse puesto un traje espacial y mucho menos salir a órbita. El mismo George Lucas dijo que esta película tuvo una fuerte influencia en su vida y en la creación de Star Wars (La Guerra de las Galaxias). Una buena película para empezar de este director es Spartacus del 1960, ya que es mucho más accesible a los gustos generales que otros trabajos de su autoría, y después pueden ver The Shining en donde el director está plenamente en su elemento con un Jack Nicholson fenomenalmente asombroso. ¡Gracias al lector Juan Carlos Durán por el enlace! enlace a la página (sean pacientes y permitan que las imágenes carguen, cuando estas carguen verán las animaciones de forma fluida) autor: josé elías |

|

|

|

|

|

domingo, septiembre 4, 2011

|

Hoy quiero compartir con ustedes las fotografías de Hayashi Natsumi, una artista que se especializa en auto-retratos en donde ella aparenta desafiar la gravedad terrestre. Hoy quiero compartir con ustedes las fotografías de Hayashi Natsumi, una artista que se especializa en auto-retratos en donde ella aparenta desafiar la gravedad terrestre.Como mencionan en el artículo fuente, es posible que las imágenes lograda por esta talentosa artista les recuerden las de Li Wei, cuyas obras también he presentado en eliax anteriormente, pero lo que diferencia a Natsumi de Wei es que esta no utiliza todo el equipo profesional que su homólogo utiliza, sino que simplemente pone la cámara con un temporizador de 10 segundos, se pone frente a la cámara, salta en el momento apropiado, y listo. Lo único que puedo decir es que esto me ha animado a experimentar con esta técnica... :) fuente con más imágenes y más imágenes asombrosas en este enlace autor: josé elías |

|

|

|

|

|

martes, agosto 30, 2011

|

|

El futuro se nos acerca más rápidamente de lo que muchos se imaginan o quieran admitir, y evidencia de ello es el Proyecto Eyeborg, en donde un tal Rob Spence se convirtió en el primer ser humano en implantarse una cámara dentro del espacio que normalmente se reserva para el ojo biológico (en este caso, después de una pérdida de su ojo derecho).

Es importante destacar que a diferencia de otros adelantos como la retina artificial, que esta cámara por el momento no se utilizará para mejorar la visión de Rob, sino que para servir como una extensión de su cuerpo. La idea es que esta diminuta cámara envía señales a un receptor inalámbrico que Rob carga siempre consigo, grabando todo a su antojo, en esencia funcionando este ojo como un grabador de memorias que Rob puede buscar posteriormente en su vida. Este tipo de tecnología biónica apenas está dando sus primeros pasos, pero no duden por un momento que los próximos pasos serán grandes y vendrán cada vez más rápidamente. Como escribí en el artículo de ayer, la inevitabilidad de la Humanidad 2.0 está cerca de nosotros... No dejen de ver el video sobre el Eyeborg, pues en este verán no solo otros tipos de prótesis biónicas, sino que además videos conceptuales que bastante bien reflejan las capacidades físicas que tendremos en un futuro no tan lejano. ¡Gracias al lector LiteSoul por el enlace! página oficial del Proyecto Eyeborg Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

martes, agosto 16, 2011

|

|

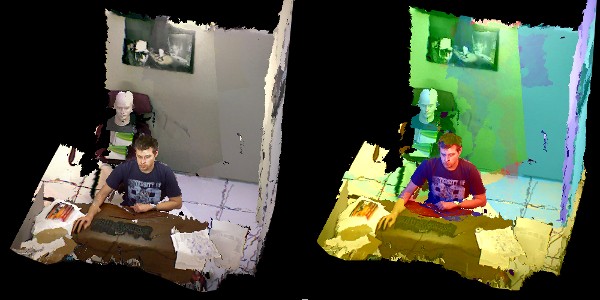

Esta creo es la primera vez en eliax que utilizo el término "GRAN HITO" para una tecnología de visualización gráfica, pero cuando vean el siguiente video (y en particular si son usuarios técnicos que conocen de estos temas) ya sabrán por qué.

Solo les diré que durante gran parte del video mi mandíbula estuvo abierta de asombro y mi mente vuelta loca con solo pensar en todas las posibilidades que esta técnica nos traerá en los próximos años. Se trata de un proyecto llamado KinectFusion, en donde toman el sensor Kinect del Xbox 360 y lo convierten literalmente en un "digitalizador/escáner del mundo físico" y en tiempo real, permitiendo hacer cosas que antes eran dificilísimas (cosas que antes requerían de mucho procesamiento computacional y/o intervención manual de artistas digitales), así como permitiendo hacer un par de trucos nuevos. En esencia lo que esto hace es que te permite mover en el aire el sensor del Kinect y utilizarlo como una cámara virtual que capta en 3D todo lo que pasa por su frente, mientras el software genera un modelo tridimensional de toda la escena paulatinamente. Pero tan asombroso como todo esto, es que todo ocurre en tiempo real, creándose los modelos que pueden ser entonces recubiertos y pintados con otros patrones (y una vez, en tiempo real), permitiendo además reemplazar objetos del mundo virtual generado, o interactuar con efectos físicos del mundo virtual con el mundo deducido del mundo real. Tienen que ver el video para entenderlo mejor (no dejen de verlo, de verdad es extraordinario, aunque un poco repetitivo, pero aguante hasta verlo todo). En cuanto a aplicaciones, ya me puedo imaginar esto en al menos los siguientes escenarios (y algo me dice que veremos muchas cosas más en los próximos años que hoy día ni nos podemos imaginar): - Efectos especiales para el cine - Video-juegos - Simulaciones y visualizaciones físicas - Pre-visualización arquitectónica - Diseño industrial - Probadores virtuales de ropa - Previsualización corporal en gimnasios - Entrenamiento de fuerzas de ventas - Demostración de productos - Diseño de interiores - Reconstrucción de escenas de crimen - Efectos televisivos en noticias - Proyectos de expresión artística - Videos musicales - Visión robótica - etc ¡Gracias al lector Luis Manuel Hernandez por el enlace! Nota: Y una vez más, parece que acerté con esta predicción del año pasado... :) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, julio 17, 2011

|

|

He aquí algo que no es nuevo, pero la manera en que lo implementaron hacer aparentar casi todo un nuevo invento, y cuando vean el video notarán por qué...

Se trata de Crowdflow ("Flujo de Multitudes"), un portal que lo único que hace es sencillamente graficar de forma animada todos los lugares en un mapa en donde grandes cantidades de multitudes han estado con sus celulares. En este caso y por el momento, esto solo funciona con iPhone, pero es obvio que esto se puede adaptar también a cualquier otra plataforma que utilice tecnología GPS. Lo interesante sin embargo, son las visualizaciones generadas, que como verán, son hipnotizantes... En el video notarán como fluyen las personas (en este caso, entre algunos lugares en Europa), y debo agregar que más allá de una simple curiosidad visual, esto en un futuro cercano tendrá muchos usos. Por ejemplo, con una aplicación como está será fácil ver cuáles son los lugares turísticos más populares en algún lugar (similar a esto), o los bares/discotecas nocturnos de más actividad (similar a esto), o las tiendas más concurridas, o los embotellamientos de tránsito más importantes, o los lugares de más concentración de personas en zonas de desastre, etc. página oficial de crowdflow Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

lunes, julio 11, 2011

|

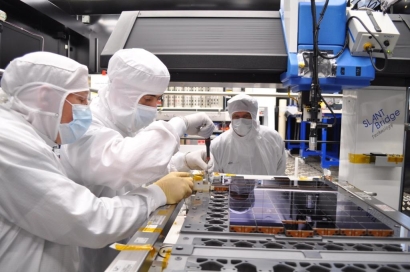

Hace apenas menos de un año que la empresa Canon anunció un sensor de 120 Megapixeles, y hoy la Agencia Espacial Europea ya tiene un sensor compuesto de 1,000 Megapixeles (en esencia, 1 Gigapixel). ¡Como cambian los tiempos en estos días! Hace apenas menos de un año que la empresa Canon anunció un sensor de 120 Megapixeles, y hoy la Agencia Espacial Europea ya tiene un sensor compuesto de 1,000 Megapixeles (en esencia, 1 Gigapixel). ¡Como cambian los tiempos en estos días!El meta-sensor, 5 años en desarrollo, está compuesto de 106 sub-sensores más pequeños (cada uno de aproximadamente 9 megapixeles), ha sido bautizado GAIA y será utilizado para observar estrellas a una velocidad antes inimaginable. El objetivo es captar detenidamente la luz de mil millones de estrellas durante un período de 5 años. Sin embargo, antes de ver los resultados tendremos que esperar a que el telescopio que albergará este sensor llegue a su destino final, en el Punto Lagrange L2 entre la Tierra y el Sol. Piensen de este punto en el espacio como un punto intermedio en donde se cancelan las fuerzas gravitacionales de la Tierra y la del Sol, en efecto poniendo al satélite "en balance", permitiendo una calibración muchísimo más sencilla de sus instrumentos en un ambiente más controlado. fuente autor: josé elías |

|

|

|

|

|

domingo, julio 10, 2011

|

|

He aquí una de esas ilusiones ópticas que sin duda nos demuestran que la forma en como percibimos el mundo es bastante diferente a como este es...

Se trata de un video en donde lo que deben hacer es simplemente fijar la vista en la cruz que aparece en el medio del video (en otras palabras, eviten mirar las dos caras que aparecen a los lados). Noten que recomiendo que esperen que el video se cargue por completo antes de verlo, así el video no se detiene a la mitad. El efecto que verán es... tenebroso en muchos sentidos... Después que vean el video, de esta manera, vuelvan a verlo pero esta vez viendo las caras, y verán que lo que percibieron la primera vez (al concentrarse en la cruz) es totalmente diferente a la realidad del video. Este video me recordó esta otra ilusión óptica en una fotografía. Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

miércoles, julio 6, 2011

|

página oficial para activar el servicio" align="left" class="img_post" alt="Facebook Video-Chat" />El rumor que les traje vía Twitter la semana pasada se hizo realidad, y hoy Facebook anunció Facebook Vide-Calling, que como indica el nombre, permite utilizar video-conferencia para hacer llamadas con audio y video a tus otros contactos en Facebook, utilizando tecnología de Skype. página oficial para activar el servicio" align="left" class="img_post" alt="Facebook Video-Chat" />El rumor que les traje vía Twitter la semana pasada se hizo realidad, y hoy Facebook anunció Facebook Vide-Calling, que como indica el nombre, permite utilizar video-conferencia para hacer llamadas con audio y video a tus otros contactos en Facebook, utilizando tecnología de Skype.La manera en que Facebook integró a Skype en su portal es magistralmente simple: Una icono con una cámara está ahora disponible en la página de tus contactos (al lado del botón con el cual le envías una mensaje a ese contacto), y con solo hacer un solo clic sobre ese icono, la llamada se establece. La primerísima vez que le des uso al servicio tendrás que configurar la extensión que permitirá que tu navegador web ejecute el módulo de Skype, pero después que haces esto una primera vez, no es necesario repetir los pasos. Así mismo, si tratas de llamar a alguien y esa persona no tiene la extensión instalada, Facebook los guiará a una página en donde pueden instalar la extensión. Noten que la extensión por el momento está disponible solo para Windows y en versión preliminar, pendiente unas cuantas pruebas para que esté disponible a todo el mundo (incluyendo usuarios de Mac OS X, aunque no se qué sucederá con usuarios de Linux por el momento). Otra cosa interesante es que Skype también integró esto en su programa aparte, por lo que los usuarios de Skype podrán desde el mismo programa de Skype llamar por video-conferencia a sus contactos de Facebook, lo que está genial, aunque ojo, al integrar a Facebook dentro de Skype de esta manera todos tus contactos de Facebook se agregarán a tu lista de contactos de Skype, lo que quizás algunos no querrán hacer (en mi caso, con alrededor de 5,000 contactos de Facebook, no es algo práctico que digamos). Y a propósito, esto me recuerda mi editorial sobre la compra de Skype por parte de Microsoft por US$8,500 millones de dólares, una suma que me encontré innecesariamente alta. Fíjense ahora por ejemplo como Facebook integra íntimamente a Skype en su plataforma, y posiblemente no le costó más que un par de millones de dólares en costos de desarrollo, y sin embargo gozará de casi todas las ventajas que Microsoft obtuvo por esa otra ridícula cifra. Aun así, ya veremos... Mi esperanza es que Facebook de alguna manera cree algún modelo de negocio con Microsoft para cobrar por Skype vía Facebook, lo que aliviaría el alto costo pagado por Microsoft por Skype. Mientras tanto, creo que esta medida de Facebook es de celebrar, pues acercará mucho más a las personas, en particular familias (aunque ya me imagino otras formas "creativas" de uso que surgirán). Esto sin duda que pondrá un poco de freno a la inercia que ganó el servicio de Google+ en estos días (servicio que coincidentemente también ofrece una funcionalidad de video-chat). Finalmente, y en nota relacionada, noten que Facebook ya tiene 750 millones de usuarios activos (lo que es un buen momento para re-leer este artículo previo en eliax) página oficial para activar el servicio autor: josé elías |

|

|

|

|

|

jueves, junio 23, 2011

|

El año pasado les hablé de una revolucionaria tecnología desarrollada por Adobe que por medio de lo que llamaban un lente tipo plenoptic podía hacer un milagro: Era posible enfocar una fotografía en cualquier punto, después de la foto haberse tomado. El año pasado les hablé de una revolucionaria tecnología desarrollada por Adobe que por medio de lo que llamaban un lente tipo plenoptic podía hacer un milagro: Era posible enfocar una fotografía en cualquier punto, después de la foto haberse tomado.La tecnología es tan fascinante que les imploro lean ese artículo anterior que les ofrece más detalles, así como les muestra un video de la tecnología en funcionamiento. Pues ahora, Adobe tiene competencia, y con una tecnología que llega incluso más lejos, y viene de parte de la empresa Lytro y su ultra-revolucionaria cámara de tipo "Light Field" ("Campo de Luz"). Las tecnologías de Adobe y Lytro aparentan funcionar de forma similar, pero en realidad son un poco diferentes, siendo esta de Lytro una mejor implementación en mi opinión. La tecnología de Adobe funciona con un lente especial que se coloca entre un sensor de alta resolución, y el lente normal de la cámara, en donde ese lente especial está compuesto de miles de lentes (como los ojos de algunos insectos) que tienen como efecto el dividir la imagen en miles o miles de pequeñas imágenes que son grabadas por el sensor, en donde cada pequeña imagen (de unos cuantos pixeles) contiene información adicional de los ángulos en que la luz llegó a la cámara, y después con unos sofisticados algoritmos Adobe combina todas esas imágenes y entre todas obtiene una imagen de mayor tamaño y resolución, y con la capacidad de poder enfocar en cualquier punto de ella. Mientras tanto, la tecnología de Lytro va más allá. Esta tecnología en realidad lo que hace es que reemplaza por completo el sensor tradicional que por años hemos tenido en cámaras digitales, y lo reemplaza por un novedoso nuevo diseño que capta no solo la intensidad de la luz en un fotosensor, sino que tiene la capacidad de capturar otros parámetros de la luz, como la dirección en que se dirigía al llegar a la cámara, intensidad, y el color. En otras palabras, en sensores tradicionales lo que sucede es que un solo fotosensor concentra varios rayos de luz en sí mismo, pero en este nuevo tipo de sensor se capturan todos los rayos de luz de forma independiente, y parte del truco es que el sensor tiene (similar a la técnica de Adobe) una matriz de micro-lentes en cada punto receptor del sensor - información que obtuve al leer la tesis de doctorado de su inventor en este enlace (archivo PDF). Con esta información adicional, Lytro puede hacer cosas que parecerían magia o trucos de efectos especiales. Ahora por ejemplo se puede enfocar en cualquier punto de la imagen (similar a la tecnología de Adobe), o incluso poner todos los planos de la fotografía enfocados, o incluso solo algunos planos enfocados y otros no (lo que abrirá todo un nuevo tipo de fotografía que hasta el momento eran imposibles de capturar). Pero tan asombroso como todo esto, debido a que ese sensor captura toda la información de la luz que le llega, esa extra información también contiene información espacial, lo que permite que con ese solo sensor se puedan reconstruir imágenes tridimensionales que pueden verse en 3D con tecnologías estereoscópicas (como la nueva generación de televisores 3D). Y esta tecnología, una vez más, traerá el debate a la mesa sobre lo que es "arte" o "fotografía pura". Yo personalmente soy de los que opina que lo que importa es el producto final y no el medio utilizado. Hubo un tiempo en donde miles de fotógrafos se negaban a utilizar cámaras digitales ya que según ellos estas nunca capturarían "el sentimiento" de películas y procesos químicos (cuánto se equivocaron), y además existía otro grupo que pensaban que los procesos digitales hacían "extremadamente fácil" el poder sacar buenas fotos (un argumento que nunca he entendido, pues más bien parece que lo que sucede es que sienten su profesión amenazada por la gente común). Para mí, si una imagen me impactó, pues me impactó y ya, no es verdad que me va a impactar menos por el hecho de saber que fue una foto manipulada en Photoshop o tomada con una cámara digital. La Mona Lisa de Leonardo DaVinci después de todo nos impacta al verla, pero nadie se pone a pensar que para su tiempo era en realidad una obra que utilizaba las más avanzadas tecnologías del momento (como expliqué aquí). La tecnología entonces debe ser tomada como un aliado al arte, y no una amenaza. Un aliado que abre puertas a posibilidades jamás antes posibles. En cuanto a esta cámara de Lytro, ya posee prototipos internos, pero promete tener la primera cámara con esta tecnología disponible para el mercado de consumidores para finales de este año, y a un precio "competitivo" con cámaras actuales (es decir, no esperen una cámara muy barata en esta primera generación). Lo que sí se, es que esta tecnología revolucionará el mundo de la fotografía de forma tan radical como lo permitió el mundo de la fotografía digital misma. Finalmente, hay otras tecnologías tan asombrosas como esta a las cuales le falta aun más para llegar a consumidores, como esta otra de la cual les hablé hace 3 años y que permite (por imposible o asombroso que aparente) el iluminar una fotografía con cualquier tipo de luz posterior a haberse tomado la foto. página oficial de Lytro (con galería de ejemplos) Tésis de Doctorado del inventor y fundador de Lytro Ren Ng (en formato PDF) Video promocional de la tecnología a continuación (enlace YouTube)... A continuación, una muestra interactiva que te permite enfocar en varios puntos en la imagen (require Adobe Flash para funcionar en tu navegador) autor: josé elías |

|

|

|

|

|

martes, junio 21, 2011

|

Como reportado hace unos meses atrás, Apple acaba de hacer realidad la promesa de sacar la totalmente nueva versión de Final Cut Pro X en su tienda de aplicaciones para Mac OS X (la Mac App Store), y al increíble precio de US$299 dólares. Como reportado hace unos meses atrás, Apple acaba de hacer realidad la promesa de sacar la totalmente nueva versión de Final Cut Pro X en su tienda de aplicaciones para Mac OS X (la Mac App Store), y al increíble precio de US$299 dólares.De paso la empresa sacó los módulos Motion 5 y Compressor 4 por tan solo US$49 dólares cada uno. Para el que no sepa, Final Cut Pro X es un editor de video, de los que permiten que editores de películas/cine/videos/documentales "corten" sus obras maestras. Final Cut Pro por años ha sido uno de los 3 grandes líderes del mercado, y ahora con esta versión se posiciona fuertemente para robar los corazones de editores en todo el mundo, y con una potente arma: Precio. Para que tengan una idea, este tipo de software por lo general cuesta miles de dólares, por lo que ver algo de esta potencia, y a este precio, es un hito en la industria, una movida que sin duda será acogida con ambos brazos por la nueva generación de cineastas de cine independiente (e incluso, a este precio hasta muchos aficionados que antes tenían que conformarse con soluciones muchísimo más limitadas). Entre las mejoras se encuentran un interfaz totalmente rediseñado, y capacidad de editar video 4K (es decir, video con más de 4,000 lineas horizontales, como el formato utilizado en los proyectores de video profesionales) en tiempo real (siempre y cuando tengas un hardware moderno), lo que también es otro gran logro. Noten que con esta versión Apple se pone a la par con Adobe Premiere con un motor que edita todo tipo de video en tiempo real gracias al poder del GPU. Final Cut Pro X necesita como mínimo una Mac con un procesador Core 2 Duo, 2GB de memoria (4GB recomendado), y una tarjeta de video capaz de manejar la arquitectura Open-CL (casi todas las Macs/MacBooks recientes lo soportan). página oficial de Final Cut Pro X (incluye videos de todo lo nuevo) Actualización: He aquí un vistazo a lo nuevo. autor: josé elías |

|

|

|

|

|

lunes, junio 13, 2011

|

Hoy día, como todos saben o suponen, un rayo láser solo puede ser generado utilizando componentes electrónicos de avanzada, pero ahora un grupo de investigadores del Massachusetts General Hospital, en Boston, EEUU, han creado un láser a partir de material biológico. Hoy día, como todos saben o suponen, un rayo láser solo puede ser generado utilizando componentes electrónicos de avanzada, pero ahora un grupo de investigadores del Massachusetts General Hospital, en Boston, EEUU, han creado un láser a partir de material biológico.La hazaña utilizó dos componentes básicos. El primero es una proteína llamada GFP ("Proteína Verde Fluorescente, por sus siglas en inglés), y el segundo fue una célula de riñón humano la cual fue genéticamente modificada para que fabricara la proteína GFP. Noten que GFP es la proteína causante de que algunas medusas brillen con luz bajo el agua. Es decir, es una fuente generadora de luz. Después que se obtuvo la célula de riñón capaz de generar luz a través de la producción de GFP, el próximo paso era amplificar y modular la luz, de modo que esta se convirtiera en un láser. Para eso crearon una estructura cilíndrica de apenas 25 milímetros (1 pulgada) de largo en donde colocaron dos micro-espejos uno opuesto al otro a una distancia de 20 micrómetros, y en el medio de tales espejos colocaron la célula genéticamente modificada. El paso final fue simplemente estimular la célula modificada de riñón con una particular luz azul, lo que hizo que esta respondiera activando la molécula GFP para producir luz modulada por los espejos, produciendo un láser. Esto, más allá de una simple curiosidad, podría tener unos usos bastante prácticos en el área de la salud, ya que sería en principio posible crear terapias en base a rayos láser que sean generados dentro del mismo cuerpo del paciente, haciendo de este un procedimiento algo muchísimo menos invasivo y mucho más preciso. Así mismo esto también nos habla de la gran posible variedad de vida y cosas maravillosas que podrían habitar nuestro universo. Incluso, esto me dice que sería posible que existiera vida en algún lugar en donde la forma de comunicación sería fotónica (basada en luz), similar a como algunas especies marinas (como algunos pulpos) lo hacen, pero a un nivel tan sofisticado como nuestros más avanzados y rápidos protocolos de comunicación creados por humanos acá en la Tierra... ¡Gracias a todos los lectores que enviaron esta noticia! fuente original autor: josé elías |

|

|

|

|

|

viernes, junio 3, 2011

|

El Kinect del Xbox ha sido hackeado en incontables formas, pero esta es quizás la mejor de todas. El Kinect del Xbox ha sido hackeado en incontables formas, pero esta es quizás la mejor de todas.Un grupo de estudiantes de UNC-Chapel Hill han combinado varios Kinects para lograr lo que efectivamente es un sistema de video-conferencia volumétrico en 3D (y para entender todos estos términos técnicos lo mejor es ver el video para que aprecien el producto final). Lo que han logrado es combinar varios hacks del Kinect y del Nintendo Wii, en uno solo. Primero, capturan video en tiempo real desde varios Kinects, y después reconstruyen una versión volumétrica (en 3D) de la escena que se capta con las cámaras. Después esta información es enviada remotamente a un software que no solo despliega el video desde cualquier ángulo, sino que lo hace tomando en consideración la posición de los ojos de la persona que ve el video, de modo que si la persona se mueve de derecha a izquierda, o de arriba hacia abajo o de delante hacia atrás, el video en 3D se auto-ajusta para mostrar una nueva perspectiva. Esto después se repite simultáneamente con las personas en el otro extremo, de modo que ambos extremos puedan tener la misma experiencia. Esto tiene como resultado que uno sienta que la imagen que ve en el monitor tenga "profundidad" o "volumen" (aunque quizás el próximo paso sería combinar esto con una pantalla de 3D estereoscópica para lograr el mejor efecto posible), dando una impresión bastante fuera de la realidad dentro del monitor. Noten que esto tiene implicaciones y usos que van más allá de ofrecer un ambiente natural de video-conferencia, pues como explican en el video estas técnicas se pueden combinar con realidad aumentada y realidad virtual para combinar imágenes sintéticas con la vida real de forma bastante natural. página oficial del proyecto Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

"Si la teoría es correcta, en un universo paralelo, estoy efectuando un comentario inteligente."

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax