Hardware

|

jueves, noviembre 24, 2011

|

hace horas el MIT (Instituto de Tecnología de Massachussetts) acaba de anunciar públicamente (después de una publicación científica en Nature Photonics el pasado día 13) un monumental avance en el desarrollo de Computación Óptica. hace horas el MIT (Instituto de Tecnología de Massachussetts) acaba de anunciar públicamente (después de una publicación científica en Nature Photonics el pasado día 13) un monumental avance en el desarrollo de Computación Óptica.Hoy día, como muchos ya sabrán, la computación en casi todos nuestros dispositivos electrónicos funcionan a base de electrones (de ahí la palabra "electrónica"), o en términos más familiares, a base de flujo de electricidad de un punto a otro, sea dentro de los componentes de un chip, o entre un chip y otro. Sin embargo, por décadas hemos tratado de mudarnos a computación óptica, la cual promete máquinas varios órdenes de magnitud más potentes que las más potentes supercomputadoras que poseemos hoy día. Esta potencia sería posible gracias a dos propiedades de la computación óptica: (1) Los fotones de luz se mueven muchísimo más rápidamente que electrones en una linea eléctrica y (2) a diferencia de circuitos eléctricos en donde cada "linea" puede contener un solo "canal" de información, en circuitos ópticos se pueden "multiplexar" varios canales a la vez (propiedad que resulta bastante útil en telecomunicaciones con fibras ópticas). Y hablando de fibras ópticas, esta tiene la gran restricción hoy día de que cuando los datos llegan de un extremo a otro, los fotones deben convertirse en señales eléctricas (electrones) para después ser procesados, y cuando se procesan después esos datos deben volver a reconvertirse de electrones a fotones por medio de rayos láser. Ese proceso de transformación entre fotones y electrones es bastante costoso en términos de tiempo de computación, y si se pudiera también evitar esa conversión, y hacer todas las computaciones directamente sobre fotones, todo el proceso sería sustancialmente más rápido. Pues en MIT lograron crear un "Diodo Óptico" que permitirá precisamente esto. Un diodo tradicional es un componente electrónico que permite el flujo de electricidad (electrones) de una dirección a otra, pero no de regreso. Es como una puerta que permite que personas solo pasen en una dirección, y nunca puedan regresar (como esos pasaderos en algunas estaciones de trenes de algunas ciudades del mundo). Lo importante es que lograr un diodo en el campo óptico había sido un sueño muy esperado, pues ese componente, aun no entiendan cómo funciona o exactamente para qué sirve, es un componente clave en la construcción de máquinas que funcionen al 100% con luz, en vez de electricidad. Noten sin embargo que ya existían componentes que permitían emular el comportamiento de un diodo óptico, pero el problema era que estos componentes son fabricados con procesos exóticos, ajenos a los procesos ya conocidos para fabricar chips de silicio en todas las fábricas de chips del mundo. La gran noticia entonces es, que en MIT lograron crear este componente a partir de silicio, permitiendo ahora la creación de chips ópticos utilizando exactamente las mismas fábricas, equipos y técnicas de fabricación actuales. Eso significa que en pocos años veremos frutos de este monumental avance del MIT, y cuando eso suceda, las super-computadoras que hoy cuestan cientos de millones de dólares, cabrán en un celular y costarán un par de cientos de dólares,,, fuente oficial en MIT publicación científica oficial autor: josé elías |

|

|

|

|

|

jueves, noviembre 17, 2011

|

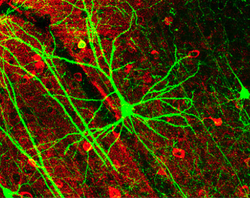

Investigadores del MIT (Instituto de Tecnología de Massachusetts) acaban de lograr uno de los grandes hitos de la Inteligencia Artificial de todos los tiempos, al poder modelar por primera vez de una forma altamente precisa, el funcionamiento de las interacciones de neuronas y sinapsis del cerebro humano, en un chip. Investigadores del MIT (Instituto de Tecnología de Massachusetts) acaban de lograr uno de los grandes hitos de la Inteligencia Artificial de todos los tiempos, al poder modelar por primera vez de una forma altamente precisa, el funcionamiento de las interacciones de neuronas y sinapsis del cerebro humano, en un chip.Para los que no sepan, las neuronas (tenemos unas 100 mil millones de ellas) son la células especializadas que junto con las sinapsis componen lo que es nuestro cerebro, y por ende, nuestra mente. Las sinapsis son las entidades que interconectan a las neuronas, y por cada neurona por lo general existen varias sinapsis conectándose a varias neuronas más. Sucede que existe toda una coreografía entre neuronas, sinapsis y efectos eléctricos, y son los patrones de toda esa actividad eléctrica lo que produce las sensaciones de pensar, memorizar, razonar, intuir, amar, odiar, desear, y de proveernos de esa extraña sensación reflexiva de un "yo" asociado a una identidad psicológica. Es por eso que es imperativo entender cómo funciona nuestro cerebro, pues al entender su funcionamiento nos estaremos entendiendo nosotros, literalmente. A la fecha, la mayoría de los intentos de imitar al cerebro se han basado en Redes Neuronales, una técnica que ha sido bastante efectiva en detectar y hasta aprender patrones, pero una se sus grandes limitantes ha sido que se basa por lo general en circuitos tradicionales digitales, en donde al final de cuentas todo se reduce a un 0 (cero) o 1 (uno), es decir, a un componente binario, pero siempre hemos sabido que nuestro cerebro es inherentemente analógico, es decir, que funciona en áreas grises de lógica en donde no todo es tan determinista. Y eso, es lo que este chip de MIT ha logrado imitar: Circuitos que no son digitales, sino que analógicos, comportándose según los primeros experimentos de una manera asombrosamente similar a la realidad. Estos son circuitos que imitan la plasticidad del cerebro de aprender y adaptarse a cosas nuevas que nunca había había sabido de antemano. El chip tiene apenas 400 componentes (a diferencia de por ejemplo los mil millones de componentes de un chip potente digital de hoy día), pero aun así, debido a su similitud con la naturaleza, un puñado de estos nuevos chips pueden ejecutar simulaciones a una velocidad en tiempo real que le tomaría a computadoras tradicionales varios días en replicar, y sin la misma precisión. Pero más asombroso, es el hecho de que este chip puede funcionar más rápido que el mismo cerebro humano, lo que indica que ya poseemos un ejemplo tangible de que el cerebro definitivamente puede ser emulado a una velocidad mayor que a la que funciona biológicamente. Este chip de incio ya está siendo útil, pues debido a su gran similitud con neuronas y sinapsis biólogas, se pudo similar un sistema que probó una teoría hasta ahora abierta sobre el funcionamiento del cerebro mismo. Así mismo, esto abrirá un nuevo capítulo en el diseño de componentes sintéticos externos que se comuniquen directamente con partes de nuestro ser biónico, así como permitirá la creación de mejores prótesis sintéticas (como retinas artificiales, hipocampos, etc), y al lado plazo, entidades sintéticas pensantes como nosotros... ¡Gracias al lector Kelvin Galvan por el enlace a la noticia! fuente autor: josé elías |

|

|

|

|

|

|

¿Recuerdan la noticia de Intel haber desarrollado un chip con 80 núcleos, hace 4 años?, pues he aquí por fin la primera aplicación comercial de lo que en ese entonces era un simple proyecto de investigación en los laboratorios de Intel. ¿Recuerdan la noticia de Intel haber desarrollado un chip con 80 núcleos, hace 4 años?, pues he aquí por fin la primera aplicación comercial de lo que en ese entonces era un simple proyecto de investigación en los laboratorios de Intel.La empresa reveló esta semana el primer procesador capaz de ejecutar instrucciones a un ritmo sostenido de 1 TeraFLOP (1 TFLOP), gracias a la ayuda de 50 núcleos trabajando en paralelo. Al chip lo llaman el "Knights Corner". Para que entiendan el significado de esto, primero notemos que 1 TeraFLOP significa que este chip puede ejecutar en tan solo un segundo la asombrosa cantidad de 1 millón de millones de instrucciones. Si ponemos esto en contexto, y como expliqué hace un par de años, obtener 1 TeraFLOP de poder en apenas el año 1984 requeriría de una inversión de US$15 Mil Millones de dólares. Pero fue apenas en el 1997 cuando por fin se pudo construir una supercomputadora con ese poder, y era tan grande que ocupada 72 grandes gabinetes. Este nuevo chip ofrece el mismo poder, en la palma de la mano, y a un precio asequible a prácticamente cualquier persona de clase media. Según Intel, esto permitirá que esta misma década, hacia el 2018, se cree la primera super-computadora capaz de 1 ExaFLOP de potencia. Para que tengan una idea, 1024 TeraFLOPS producen 1 PetaFLOP, y 1024 PetaFLOPS producen 1 ExaFLOP, o más de 10,000,000,000,000,000 cálculos por segundo. En otras palabras, nos acercamos rápidamente a un escenario con máquinas que tendrán el poder computacional bruto del cerebro humano. fuente autor: josé elías |

|

|

|

|

|

domingo, noviembre 6, 2011

|

En febrero de este año les informé que IBM planeaba tener lista para el 2012 una supercomputadora con una potencia de 10 PetaFLOPS, o el equivalente a 10 mil millones de millones (10,000,000,000,000,000) de cálculos cada segundo. En febrero de este año les informé que IBM planeaba tener lista para el 2012 una supercomputadora con una potencia de 10 PetaFLOPS, o el equivalente a 10 mil millones de millones (10,000,000,000,000,000) de cálculos cada segundo.Pues parece que la empresa japonesa Fujitsu decidió no esperar a IBM y acaba de hacer oficial que su Supercomputadora "K" es la primera en el mundo en sobrepasar la cifra de 10PF de potencia... Como explican en la fuente, este coloso requirió de 864 gabinetes, uniendo 88,128 procesadores, cada uno con 16GB de memoria para un total de 1,377 TeraBytes de memoria RAM. De paso la K consume 9.89 MegaVatios de energía (lo que consumen unos 10,000 hogares promedios) y mantenerla funcionando cuesta 10 Millones de dólares al año. Sus primeras tareas a gran escala en el 2012 serán la de predecir catástrofes naturales, y la de ayudar a científicos a crear nuevos tipos de medicinas. fuente autor: josé elías |

|

|

|

|

|

domingo, octubre 2, 2011

|

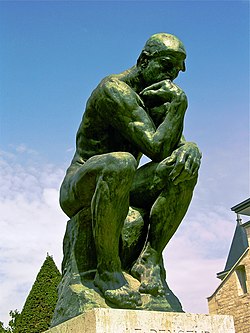

En años recientes se han dado importantes avances en tecnologías que permiten interactuar con cerebros biológicos desde el mundo sintético, y esta noticia de hoy es un paso importantísimo en esta área. En años recientes se han dado importantes avances en tecnologías que permiten interactuar con cerebros biológicos desde el mundo sintético, y esta noticia de hoy es un paso importantísimo en esta área.Científicos de la Universidad de Tel Aviv en Israel lograron crear un cerebelo digital externo que restauró funciones perdidas del cerebro biológico de una rata, demostrando de paso comunicación bi-direccional entre ambos cerebros en el proceso de una forma bastante transparente. El experimento en sí es bastante sencillo, y específicamente lo que se hizo fue tomar una rata que había perdido la capacidad del reflejo de cerrar los ojos ante un evento sorpresivo, y se le restauró esa función con el implante digital. Más detalladamente, de la manera que esto funcionó es que el cerebelo digital "escucha" al cerebro biológico por patrones que podrían generar el tener que cerrar el ojo (en el caso de la rata, por la generación de un sonido en particular), procesa la información, y en tiempo real se comunica en la otra dirección comandando al cerebro biológico que guiñe el ojo. Notemos que la rata sin el implante no podía guiñar el ojo. En otras palabras, el cerebelo digital externo funcionó como una reemplazo de la parte del cerebro biológico encargada de esa función. Este tipo de experimentos tienen profundas implicaciones en el área de salud, ya que significa que al menos en forma teórica sería posible reemplazar áreas dañadas del cerebro por equivalentes sintéticos. Sin embargo, tan interesante como eso, y especulando un poco más sobre el futuro, esto también significa que con esta comunicación bi-direccional podríamos proveer al cerebro biológico de otras funciones que nunca tuvo en primer lugar, como podrían ser una brújula digital, o calculadora de aritmética de cifras grandes, o amplificación de sonido, o incluso cosas que hoy día ni nos imaginamos. Notemos que hoy día ya existen prótesis sintéticas en forma de un Neurochip que pueden reemplazar áreas dañadas en el hipocampo, en esencia recreando un hipocampo artificial (para pacientes de Alzheimer's), y así mismo en un futuro podríamos quizás reemplazar otras funciones de alto nivel como la memoria o incluso la estimulación de sentimientos. ¡Gracias Manuel Grullón por el enlace! fuente autor: josé elías |

|

|

|

|

|

lunes, septiembre 19, 2011

|

Recientemente el Libro Guinness de los Récords otorgó a la empresa AMD el título del CPU (procesador central de una PC) más rápido del mundo, con técnicas de overclocking. Recientemente el Libro Guinness de los Récords otorgó a la empresa AMD el título del CPU (procesador central de una PC) más rápido del mundo, con técnicas de overclocking.Para los que no sepan, overclocking es un hobby similar al hobby de tomar automóviles comunes y corrientes y modificarlos para que den un rendimiento bastante superior al que salen de fábrica. En el caso de los CPUs, el truco está en enfriarlos lo mayor posible mientras simultáneamente se incrementa el ritmo del reloj que los maneja (los famosos "GHz" o GigaHertz en este caso). Según Guinness, se logró tomar un CPU Bulldozer de 8 núcleos de AMD, y hacer que funcionara a la asombrosa velocidad de 8.429GHz. Y si se preguntan, ¿cómo logran enfriar estos chips a bajas temperaturas? Pues una técnica es nitrógeno líquido, la misma sustancia que en la película Terminator 2 congeló al robot líquido T-1000 :) ACLARACIÓN: En algunos países se utiliza el punto en vez de la coma para separar cifras por lo que por 8.429GHz hablamos de "poco más de 8 GigaHertz" y no de "8429 GigaHertz". Gracias al lector feDe por notar esto :) Nota de Prensa oficial Video de la hazaña a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, septiembre 18, 2011

|

Hola amig@s lectores, Hola amig@s lectores,¿Qué hacer cuando uno está en un aeropuerto, cansado y aburrido, a altas horas de la noche, y con solo un iPad entre las manos? Pues en mi caso, empezar a escribir mi próximo libro... :) ¡En serio!, después de varios meses pensando en la idea, decidí iniciar por fin lo que sería no tanto una continuación de Máquinas en el Paraíso, sino más bien un re-enfoque en un solo tema: La Singularidad Tecnológica. Aun no tengo ni la menor idea de cómo se llamará el libro (por el momento llamémoslo "Máquinas en el Paraíso 2.0"), pero lo que sí les puedo adelantar es que el enfoque que pienso darle irá un poco más allá de los pocos libros actuales del tema. Desde ahora les doy las gracias a todos ustedes, pues en muchos casos fueron inspiración para varios de los miles de artículos que he escrito acá en el blog, y en efecto, el libro en muchos sentidos será una extensión organizada de muchos de los artículos en eliax relacionados con La Singularidad. ¿Cuándo lo finalizaré? Pues el objetivo es "en algún momento en el 2012", preferiblemente en la primera mitad del año, pero ya veremos. Siento que si tuviera tiempo libre lo podría escribir en un par de meses, pero tiempo es lo que menos tengo dada todas mis otras responsabilidades. Sin embargo, ya he iniciado un proceso en donde planeo liberar un poco de mi tiempo en los próximos meses para dedicarle más tiempo al escribir (¡lo que significa un poco de menos tiempo al blog!) Por el momento, ya el Prólogo está escrito, ahora a estructurar el esqueleto del libro antes de sentarme a escribir el Capítulo 1... :) Así que atentos al blog, pues trataré de mantenerlos al tanto de mi progreso (al inicio será todo muy2 lento), y si alguien conoce contactos dentro de una editora de reputación internacional que le pueda interesar publicar la versión impresa del libro (yo posiblemente me reserve la distribución digital), favor de contactarse conmigo por las vías tradicionales. autor: josé elías |

|

|

|

|

|

viernes, septiembre 16, 2011

|

Parece ayer que empezamos a tener laptops con hasta 8 horas de batería, o un iPad con 10 horas de uso continuo, y ahora Intel nos promete tener laptops (o para ese entonces, más bien dicho, Ultrabooks) que consumirán tan poca energía que sus batería nos darán hasta 24 horas de uso continuo. Parece ayer que empezamos a tener laptops con hasta 8 horas de batería, o un iPad con 10 horas de uso continuo, y ahora Intel nos promete tener laptops (o para ese entonces, más bien dicho, Ultrabooks) que consumirán tan poca energía que sus batería nos darán hasta 24 horas de uso continuo.Eso se traduce a 3 días laborales de 8 horas cada uno, lo que para muchos hoy dia sería un sueño hecho realidad. Lo que permitirá ese milagro es una nueva generación de procesadores de Intel llamados internamente "Haswell", fabricados bajo un proceso de 22nm. De paso, estos chips nos proveerán hasta 10 días de "connected standby" (que hasta donde tengo entendido, significa en estado "dormido" pero en alerta para satisfacer en cualquier momento requerimientos de pedidos de datos por redes). Predicción: Llegará un momento en el futuro en donde para todos los fines prácticos nuestros dispositivos tendrán "batería de duración infinita", gracias a tecnologías como las que expliqué en mi artículo sobre Predicciones para los próximos 100 años (y si no, al menos tendremos esto). fuente autor: josé elías |

|

|

|

|

|

jueves, septiembre 8, 2011

|

Chips (es decir, los circuitos electrónicos empacados que proveen de poder a nuestros dispositivos como celulares, televisores y computadoras personales, y que vemos en formas de procesadores y memorias), tienen años que se fabrican con técnicas de 3D (desde el 2005 vengo hablando de ellos en eliax), sin embargo hasta el momento estos chips solo se podían fabrican con unos cantos niveles de altura. Chips (es decir, los circuitos electrónicos empacados que proveen de poder a nuestros dispositivos como celulares, televisores y computadoras personales, y que vemos en formas de procesadores y memorias), tienen años que se fabrican con técnicas de 3D (desde el 2005 vengo hablando de ellos en eliax), sin embargo hasta el momento estos chips solo se podían fabrican con unos cantos niveles de altura.Para imaginar un chip en 2D simplemente piensen en una casa tradicional de un solo piso. Un chip 3D tradicional sería una casa de unos 3 pisos de altura. Sin embargo, ahora las empresas IBM y 3M acaban de crear una alianza en donde crearán chips 3D que poseerán el equivalente a 100 niveles de profundidad, que en nuestro ejemplo sería el equivalente a un rascacielos de 100 pisos de altura. Esto se traduce a que según las empresas, pronto tendremos chips en forma de procesadores y memorias unas 1,000 veces más potentes que los chips tradicionales de hoy día. Lo que ha hecho posible esta proeza es el desarrollo de una "pega" especial que se pone entre un nivel y otro del chip, que actúa tanto como un aislante eléctrico, como un conductor de calor y como sustancia adhesiva. Noten que esto permitirá no solo aumentar la complejidad y eficiencia de los procesadores tradicionales, sino que además empacar de forma más eficiente varias funcionalidades en un solo paquete (lo llamado SoC "Sistema-en-un-Chip"). Así que por ejemplo, entre los pisos 1 al 25 se podría implementar un CPU (procesador), entre los 26 al 50 un chip de gráficos, y así sucesivamente, combinando todos los elementos computacionales y de memoria de un sistema completo, en un chip cúbico. En otras palabras, antes de que temine esta década un celular común y corriente tendrá un poder similar a las super-computadoras que cuestan millones de dólares en los laboratorios más avanzados del mundo hoy día... Sin embargo, no crean que vamos a tener que esperar para finales de la década para ver el fruto de esta alianza. Los primeros chips fabricados con esta nueva tecnología saldrán al mercado en un par de años, en el 2013. ¡Gracias al lector Ulises Smts por compartir la noticia en el nuevo club oficial de eliax en Facebook! fuente Video a continuación que explica cómo se fabricarán estos Chips 3D (enlace YouTube)... autor: josé elías |

|

|

|

|

|

domingo, agosto 28, 2011

|

Hoy día se está haciendo común tener discos duros en PCs de escritorio de 1TB (1 TeraByte), o incluso 2TB, y discos de 3TB ya están disponibles a precios asequibles. Pero IBM está yendo más allá. Mucho más allá... Hoy día se está haciendo común tener discos duros en PCs de escritorio de 1TB (1 TeraByte), o incluso 2TB, y discos de 3TB ya están disponibles a precios asequibles. Pero IBM está yendo más allá. Mucho más allá...No hablamos de 10, 100 o incluso 1PT (1 PetaByte, o 1024 TeraBytes), sino que de unos asombrosos (para el día de hoy) 120 PetaBytes en un solo contenedor. Hoy día los equipos monolíticos de mayor almacenamiento apenas alcanzan los 15PB. Para que tengan una idea de lo que hablamos, esto podría almacenar más de 24 mil millones de canciones mp3 (asumiendo 5MB por canción). El objetivo de este sistema (el cual aun no está finalizado) será el de ser utilizado por un cliente no identificado para el procesamiento de grandes cantidades de datos en una mega-simulación de fenómenos físicos (que no fueron especificados, pero candidatos que vienen a la mente son la predicción del clima, simulación nuclear, simulaciones químicas, etc). Otro dato curioso es que este sistema estará compuesto de unas 200,000 unidades de almacenamiento, las cuales son naturalmente redundantes, reemplazándose estas por otras según vayan fallando, de modo que el sistema siempre se mantenga funcionando incluso con fallas. IBM espera que esto sirva como modelo para futuros centro de datos, en particular para aplicaciones de alta dependencia bajo el esquema de Computación en la Nube. Como cambian los tiempos... fuente autor: josé elías |

|

|

|

|

|

sábado, agosto 20, 2011

|

Hace un par de años les hablé acá en eliax de un proyecto llamado SyNAPSE (Systems of Neuromorphic Adaptive Plastic Scalable Electronics) fundado por DARPA (la Agencia de Proyectos de Investigaciones Avanzadas de la Defensa de los EEUU - los mismos que inventaron el Internet), en donde el objetivo era crear Inteligencias Artificiales. Hace un par de años les hablé acá en eliax de un proyecto llamado SyNAPSE (Systems of Neuromorphic Adaptive Plastic Scalable Electronics) fundado por DARPA (la Agencia de Proyectos de Investigaciones Avanzadas de la Defensa de los EEUU - los mismos que inventaron el Internet), en donde el objetivo era crear Inteligencias Artificiales.Pues ese proyecto acaba de dar un gran paso gracias a un aporte de IBM que ha llevado el proyecto a su segunda fase, y de paso le ganó a IBM un premio de US$21 Millones de dólares por parte de DARPA para continuar con su investigación. Lo que IBM ha logrado es un sistema bajo el programa SyNAPSE compuesto de dos prototipos, un par de chips que a diferencia de los procesadores tradicionales no se programa con instrucciones específicas, sino que son chips que literalmente aprenden patrones de su entorno y utilizan experiencias pasadas para mejorar su rendimiento futuro, incluyendo cálculos y predicciones. El primero de tales chips tiene el equivalente a 65,536 synapsis artificiales, mientras que el segundo tiene 262,144, implementados en ambos casos en un chip con el equivalente a 256 núcleos (o sub-procesadores). Es importante notar que este proyecto tuvo dos faces previas llamadas "Fase 0" y "Fase 1", en donde sus objetivo (logrados) fueron el de simular el nivel de complejidad de la corteza cerebral de un gato (como reportado también en eliax hace un par de años), en ese momento con una máquina de IBM con 144TB (144 TeraBytes) de memoria. La idea en esta fase era demostrar la factibilidad de demostrar no solo que se puede crear algo de ese nivel de complejidad, sino que ahora que esta estructura se auto-programe y cambie dinámicamente. En futuras etapas la idea ahora es combinar todo en super-máquinas programables que vayan subiendo en complejidad, incrementando desde la complejidad de un gato hasta mamíferos de más alto nivel, hasta llegar (y seguro sobrepasar) el nivel de complejidad humano. En noticia relacionada, los refiero a que lean este documento que explica nuevos avances y caminos siendo explorados para lograr Inteligencias Artificiales por medio de la combinación de la neurociencia, supercomputación y nanotecnología (gracias al lector Abraham Jiménez por es enlace). fuente fuente secundaria autor: josé elías |

|

|

|

|

|

martes, agosto 16, 2011

|

|

Esta creo es la primera vez en eliax que utilizo el término "GRAN HITO" para una tecnología de visualización gráfica, pero cuando vean el siguiente video (y en particular si son usuarios técnicos que conocen de estos temas) ya sabrán por qué.

Solo les diré que durante gran parte del video mi mandíbula estuvo abierta de asombro y mi mente vuelta loca con solo pensar en todas las posibilidades que esta técnica nos traerá en los próximos años. Se trata de un proyecto llamado KinectFusion, en donde toman el sensor Kinect del Xbox 360 y lo convierten literalmente en un "digitalizador/escáner del mundo físico" y en tiempo real, permitiendo hacer cosas que antes eran dificilísimas (cosas que antes requerían de mucho procesamiento computacional y/o intervención manual de artistas digitales), así como permitiendo hacer un par de trucos nuevos. En esencia lo que esto hace es que te permite mover en el aire el sensor del Kinect y utilizarlo como una cámara virtual que capta en 3D todo lo que pasa por su frente, mientras el software genera un modelo tridimensional de toda la escena paulatinamente. Pero tan asombroso como todo esto, es que todo ocurre en tiempo real, creándose los modelos que pueden ser entonces recubiertos y pintados con otros patrones (y una vez, en tiempo real), permitiendo además reemplazar objetos del mundo virtual generado, o interactuar con efectos físicos del mundo virtual con el mundo deducido del mundo real. Tienen que ver el video para entenderlo mejor (no dejen de verlo, de verdad es extraordinario, aunque un poco repetitivo, pero aguante hasta verlo todo). En cuanto a aplicaciones, ya me puedo imaginar esto en al menos los siguientes escenarios (y algo me dice que veremos muchas cosas más en los próximos años que hoy día ni nos podemos imaginar): - Efectos especiales para el cine - Video-juegos - Simulaciones y visualizaciones físicas - Pre-visualización arquitectónica - Diseño industrial - Probadores virtuales de ropa - Previsualización corporal en gimnasios - Entrenamiento de fuerzas de ventas - Demostración de productos - Diseño de interiores - Reconstrucción de escenas de crimen - Efectos televisivos en noticias - Proyectos de expresión artística - Videos musicales - Visión robótica - etc ¡Gracias al lector Luis Manuel Hernandez por el enlace! Nota: Y una vez más, parece que acerté con esta predicción del año pasado... :) Video a continuación (enlace YouTube)... autor: josé elías |

|

|

|

|

|

sábado, agosto 13, 2011

|

Hace 30 años (en 1981) que IBM lanzó al mercado la IBM Personal Computer (o IBM PC), y su impacto fue tal que aun hoy, 3 décadas después, todo el mundo entiende perfectamente a lo que nos referimos cuando decimos "una PC" (similar a como hoy día se está popularizando el término "iPad", que como expliqué el día que salió a la venta es quizás la verdadera primera PC de la historia). Hace 30 años (en 1981) que IBM lanzó al mercado la IBM Personal Computer (o IBM PC), y su impacto fue tal que aun hoy, 3 décadas después, todo el mundo entiende perfectamente a lo que nos referimos cuando decimos "una PC" (similar a como hoy día se está popularizando el término "iPad", que como expliqué el día que salió a la venta es quizás la verdadera primera PC de la historia).Pero, ¿qué fue lo que hizo esa PC tan popular? Pues creo que al menos un par de cosas, de las cuales podemos aprender hoy día, en particular aquellos alineados en el mundo del mercadeo y los negocios... Lo primero es que es bueno ver el contexto bajo la cual salió la IBM PC al mundo. En ese entonces la Apple II ya era una computadora bastante popular, e incluso un año después saldría al mercado la que se convertiría en la computadora personal de mayor venta de todos los tiempos (la Commodore 64), y en 1985 saldría al mercado la que sería la computadora personal más avanzada a su tiempo (la Commodore Amiga), pero aun así, la "PC" sobrevivió a todos sus competidores y se convirtió en el estándar mundial. Y fueron varias las razones... Lo primero es que IBM hizo algo que nadie había hecho antes: Demarcó exactamente lo que era una PC y para quien era, que en ese entonces IBM describió como "una herramienta utilitaria" y creada específicamente "para el mundo de los negocios". Esto a diferencia de casi todas las otras PCs de la época que se les vendían "a quienes las compraran", y en mucho casos eran vendidas más como objetos de curiosidad o diversión que de productividad. En otras palabras, IBM creó el concepto de un nicho en computación. Otra razón de la PC convertirse en una herramienta indispensable fue el software disponible para esta. Herramientas como Lotus 1-2-3 (el Microsoft Excel de esos días) y Word Perfect (el Microsoft Word de esos días) hicieron de estas máquinas una necesidad para millones de usuarios. Si no tenías una PC, no podías utilizar estos y otros miles de útiles programas. En otras palabras, la PC se convirtió en una plataforma para aplicaciones de terceros. Otra razón adicional es que quizás inadvertidamente, IBM creó además el concepto de estandarización en PCs (digo inadvertidamente porque IBM planeaba controlar el mercado por sí sola, y nunca contó con los clones que posterior salieron de parte de empresas como Compaq y otros). A diferencia de casi todas las otras computadoras de la época, la PC tenía puertos de expansión para los cuales terceros podía construir periféricos, lo que de paso aumentaba el apetito por estas máquinas ya que estos periféricos aumentaban su flexibilidad (con impresoras, memorias, capturadores de audio, escáneres, lectores de código de barra, etc). Y posteriormente, la PC subió a todo un nuevo nivel gracias a Microsoft Windows, un sistema operativo que por primera vez ofreció al mercado masivo (pues ya existía el concepto en otras plataformas menos masivas) un conjunto de interfaces de programación abiertos (pero propieatarios) los cuales podían ser utilizados por terceros para construir aplicaciones de una forma más rápida y estandarizada, lo que tuvo como resultado un ecosistema de decenas de miles de programadores creando cientos de miles de programas. Al final Windows tuvo un impacto tan grande que la consciencia colectiva global empezó a substituir la frase "es compatible con la PC" por "es compatible con Windows", arrebatando Microsoft completamente desde entonces el control de "la PC" a IBM. Otra cosa que debe sorprender son las especificaciones técnicas con las cuales la IBM PC debutó: - 16KB de memoria RAM (eventualmente expandible a 256KB). Para que tengan una idea, se necesitarían 256 de estas máquinas para almacenar en toda su memoria tan solo una sola canción mp3 de 4MB. - Un procesador Intel 8088 a 4.77 MHz. Hoy día es rutinario tener procesadores a más de 3,000 MHz (3GHz). - Almacenaba información en discos "floppy" que contenían hasta 360KB de información (se necesitarían 12 de estos discos para almacenar nuestra sola canción mp3). - Un sistema "completo" compuesto de un solo disco floppy, un monitor, y las especificaciones anteriores costaba US$3,005 dólares (más de US$7,000 dólares en dinero de hoy día, y con decenas de miles de veces menos potencia). Debo confesar que me encuentro asombroso que hubo un tiempo en donde la IBM PC (y sus descendientes) eran quizás las máquinas más débiles del mercado, con gráficos por lo general monocromáticos, sin un chip de generación de sonido (salvo un pequeño parlante programable que podía generar más o menos sonido), y a una velocidad relativamente pobre, pero aun así se defendió bastante bien contra computadoras como la Amiga, Atari ST, o las Macintosh de Apple de la época, que entre todas ofrecían gráficos con miles de colores, sonido estereofónica, sistemas operativos gráficos y de multi-tarea, sintetizadores de voz, etc. Pero al final, la capacidad de crear un ecosistema abierto a su alrededor (que benefició no solo a los fabricantes de PCs, sino que a los fabricantes de periféricos, los fabricantes de software, y los usuarios finales), fue su As bajo la manga para contrarrestar competidores aparentemente superiores. Y noten que esa estrategia fue copiada magistralmente por dos empresas hoy muy conocidas: Apple y Google, ambas con sus respectivas plataformas (Apple iOS y Google Android OS), en donde han logrado específicamente esto mismo: Un ecosistema de periféricos para terceros, y unos interfaces de programación abiertos y expuestos en sus respectivas Tiendas de Aplicaciones, lo que ha permitido hacer bastante difícil que otros competidores en este nuevo espacio entren y/o compitan efectivamente (solo noten los casos de Nokia, RIM/Blackberry, HP/Palm y el mismo Microsoft en estos días). Así que como pueden ver, a veces lo nuevo no es más que lo viejo con un poco de maquillaje. Existen algunos patrones universales a tomar en cuenta a la hora de crear un nuevo producto y servicio, y si conocemos estos patrones, existen entonces mejores probabilidades de sacar tal producto/servicio de forma exitosa en el mercado... Mientras tanto, me quito el sombrero en señal de respeto y agradecimiento a las centenares de personas que de una forma u otra contribuyeron a ese gran hito de la computación, la IBM PC. autor: josé elías |

|

|

|

|

|

jueves, julio 28, 2011

|

Científicos del Instituto Tecnológico de California (CalTech) acaban de dar un paso impresionante tanto en el campo de la computación, como en el de la Inteligencia Artificial, ejecutando un pionero experimento que crea redes neuronales con moléculas de ADN. Científicos del Instituto Tecnológico de California (CalTech) acaban de dar un paso impresionante tanto en el campo de la computación, como en el de la Inteligencia Artificial, ejecutando un pionero experimento que crea redes neuronales con moléculas de ADN.¿Qué es una red neuronal? Pues es una estructura inventada hace décadas que implementa las interconexiones que existen en el cerebro humano, pero con elementos sintéticos, sea en hardware, software o combinación de ambos. En esencia, una red neuronal es un sistema que aprende a reconocer patrones y a actuar sobre ellos. Esto es algo que está tan avanzado que incluso ya existen programas comerciales desde hace años utilizados en nichos especializados. Por ejemplo, existen redes neuronales creadas para clientes específicos en el sector financiero entrenadas para notar patrones en la bolsa de valores y sugerir (y en muchos casos, tomar decisiones) sobre cuáles acciones comprar o vender. Así mismo en la mayoría de los grandes hoteles de Las Vegas, los equipos que reconocen caras por medio de cámaras, son en realidad redes neuronales que reconocen caras de tramposos, aun estos entren disfrazados con pelucas y otros accesorios para esconder su identidad. Sin embargo, a la fecha estas redes neuronales siempre han sido sistemas estáticos en el sentido de que aunque pueden crear enlaces dinámicos entre unos y otros nodos (o neuronas artificiales), estas neuronas son fijas en un solo lugar y solo interactúan con células adyacentes en lugares específicos. Así que el equipo de CalTech ponderó: ¿Qué sucedería si simplemente creamos una "sopa" al azar de moléculas que actúen como neuronas artificiales? ¿Cómo se comportarían? ¿Podrán crear asociaciones como una red neuronal tradicional, o incluso como el cerebro humano? La respuesta de seguro que los dejó atónitos... Para empezar, empezaron con un sistema sumamente sencillo, compuesto de apenas 4 neuronas, pero cada una construída de 112 cadenas de ADN (que asumo podemos asumir se comportan como las sinapsis del cerebro humano). Cuando todas estas moléculas son mezcladas como si de una sopa se tratara (en vez de ponerlas ordenadamente sobre la superficie de un chip), es posible ofrecer estímulos a estas neuronas, y hacer que estas aprendan y deduzcan información en base a experiencias previas. Específicamente, se les enseñó a estas neuronas de ADN a jugar el juego de "adivina en lo que estoy pensando". En ese juego, quien tiene que adivinar puede hacer preguntas cuya respuestas pueden ser "Sí" y "No", y después de hacer varias preguntas debe deducir una respuesta. Pues para sorpresa de los investigadores, esta red neuronal de ADN pudo adivinar en lo que estaban pensando los científicos en el 100% de los casos en base a algunas preguntas previas (preguntas como "¿Estás pensando en una persona?", "¿Es un científico?", etc). Noten que como indican en el artículo fuente, que esto no significa necesariamente que esta red neuronal esté "pensando", pero sí significa que es un gran paso para entender los procesos que nos permiten a nosotros los humanos pensar. Incluso, el solo hecho de que se obtuvieran estos resultados nos indica que es ciertamente es posible que emerja algo como una mente pensante, de elementos muchísimos más simples cuando todos ellos son mezclados caóticamente. Este avance, que lamentablemente pasará desapercibido en muchos medios, pueden estar seguros que es será recordado como uno de los grandes hitos en computación que nos llevaron un poco más cerca a la creación de las llamadas Inteligencias Artificiales... ¡Gracias a Marco García Baturán y los demás lectores que enviaron esta noticia! fuente autor: josé elías |

|

|

|

|

|

martes, julio 12, 2011

|

Hoy día toda la industria de microprocesadores (es decir, los "chips" que le dan inteligencia a nuestras máquinas) funciona en su modo más fundamental, de exactamente la misma forma, independientemente de cual sea el fabricante, o la potencia del chip: Todos funcionan moviendo electrones de un lugar a otro. Hoy día toda la industria de microprocesadores (es decir, los "chips" que le dan inteligencia a nuestras máquinas) funciona en su modo más fundamental, de exactamente la misma forma, independientemente de cual sea el fabricante, o la potencia del chip: Todos funcionan moviendo electrones de un lugar a otro.El problema es, que en términos de eficiencia energética, esta es una operación bastante costosa (y la razón principal por la cual la batería de tu laptop o celular se descarga tan rápidamente), pero ahora una investigación de punta realizada en la Universidad de California, Berkeley, promete hacer que en un futuro los microprocesadores (y transistores) de hoy día aparenten dinosaurios... La investigación se centra en una novedosa técnica que no utiliza electrones para mover información en un chip, sino que utiliza magnetos/imanes, en efecto creando una nueva forma de computación que podríamos llamar "Procesadores Magnéticos". Es decir, en vez de transferir o almacenar información por medio de transferencia de electrones, la idea es trasferir/almacenar por medio de los efectos magnéticos que un imán tiene sobre otro. La importancia de esta investigación es que según estudios teóricos, y posteriormente experimentales, una procesador que funcione a base de magnetos en vez de electrones sería 1 millón de veces más eficiente en términos energéticos que uno tradicional de hoy día. En otras palabras, en un futuro podríamos tener dispositivos de computación móvil que durarían años y no solo horas, antes de tener que ser recargados una vez más. Según los estudios, circuitos creados con esta técnica funcionarían en lo que se llama el Límite de Landauer. Rolf Landauer fue un científico que hace 50 años calculó la mínima cantidad de energía necesaria para hacer un operación lógica en un circuito. Específicamente, un circuito con esta nueva técnica disiparía apenas 18 milielectrón-voltios a temperatura ambiente, o 6 órdenes de magnitud inferior a un circuito de hoy día. Noten que esta es una investigación que apenas se inicia, por lo que tardarán años para que veamos los frutos de esta investigación, sin embargo lo interesante de esto es que nos habla sobre lo que veremos en un futuro no lejano, con dispositivos equivalentes a las supercomputadoras de hoy día, en la palma de la mano. Así que si combinamos esta noticia de hoy, con esta de hace un par de años, solo podemos llegar a la conclusión de que cerebros sintéticos no están tan lejos en el futuro como muchos se imaginaban... fuente autor: josé elías |

|

|

|

|

|

lunes, julio 11, 2011

|

Hace apenas menos de un año que la empresa Canon anunció un sensor de 120 Megapixeles, y hoy la Agencia Espacial Europea ya tiene un sensor compuesto de 1,000 Megapixeles (en esencia, 1 Gigapixel). ¡Como cambian los tiempos en estos días! Hace apenas menos de un año que la empresa Canon anunció un sensor de 120 Megapixeles, y hoy la Agencia Espacial Europea ya tiene un sensor compuesto de 1,000 Megapixeles (en esencia, 1 Gigapixel). ¡Como cambian los tiempos en estos días!El meta-sensor, 5 años en desarrollo, está compuesto de 106 sub-sensores más pequeños (cada uno de aproximadamente 9 megapixeles), ha sido bautizado GAIA y será utilizado para observar estrellas a una velocidad antes inimaginable. El objetivo es captar detenidamente la luz de mil millones de estrellas durante un período de 5 años. Sin embargo, antes de ver los resultados tendremos que esperar a que el telescopio que albergará este sensor llegue a su destino final, en el Punto Lagrange L2 entre la Tierra y el Sol. Piensen de este punto en el espacio como un punto intermedio en donde se cancelan las fuerzas gravitacionales de la Tierra y la del Sol, en efecto poniendo al satélite "en balance", permitiendo una calibración muchísimo más sencilla de sus instrumentos en un ambiente más controlado. fuente autor: josé elías |

|

|

|

|

en camino a la singularidad...

©2005-2024 josé c. elías

todos los derechos reservados

como compartir los artículos de eliax

Seguir a @eliax